Unternehmen in den USA treiben die Einführung von KI-Systemen voran und erhöhen ihre Budgets drastisch. Die zentrale Herausforderung bleibt jedoch, den Return on Investment zuverlässig zu quantifizieren.

Generative Künstliche Intelligenz hat bei führenden US-Unternehmen einen Investitionsboom ausgelöst. Wie eine Umfrage von Andreessen Horowitz unter 70 Führungskräften von Fortune-500-Unternehmen zeigt, wollen fast alle befragten Unternehmen ihre Ausgaben für Large Language Models (LLMs) und andere KI-Systeme bis 2024 um das Zwei- bis Fünffache erhöhen.

2023 beliefen sich die Investitionen in Foundation Model APIs, internes Hosting und Modelloptimierung noch auf durchschnittlich sieben Millionen Dollar pro Unternehmen. Aber schon jetzt werden die Budgets in große, permanente Software-Budgetpositionen umgeschichtet. Nur noch ein Viertel der Mittel stammt aus zeitlich begrenzten Innovationsbudgets.

Große Herausforderung bleibt die Erfolgsmessung

Erste Unternehmen finanzieren ihre KI-Ausgaben bereits durch Einsparungen bei den Kosten für Kundendienstmitarbeiter. Ein Unternehmen gab an, 90 Prozent der Kosten (6 US-Dollar pro Anruf) bei Anrufen mit LLM-Unterstützung eingespart zu haben und hat deshalb sein KI-Budget verachtfacht.

Trotz der hohen Investitionen herrscht nach wie vor Unsicherheit bei der Beurteilung der Rentabilität. "Viele Manager glauben einfach den Aussagen ihrer Mitarbeiter, dass sie dank KI effizienter arbeiten", berichten die Analysten von Andreessen Horowitz.

Selbst wenn die Mitarbeitenden effizienter und qualitativ besser arbeiten können, wie unter anderem eine Studie von Ethan Mollick nahelegt, bleibt die Frage, ob sie diesen Zugewinn im Arbeitsalltag auch tatsächlich weitergeben. Für eine belastbare Erfolgsmessung fehlen den Unternehmen oft aussagekräftige Kennzahlen.

Produktivitätssteigerungen werden als positiver Indikator gewertet, berichtet a16z, doch suchen die Verantwortlichen nach konkreteren Metriken wie Umsatzsteigerungen, Kosteneinsparungen, Effizienzgewinnen und Genauigkeitswerten - je nach KI-Anwendungsfall.

Trotz intensiver Bemühungen um aussagekräftige Metriken dürfte die Erfolgsmessung in den nächsten zwei bis drei Jahren eine Herausforderung bleiben. Bis dahin werden weiterhin Gelder in die Einführung generativer KI fließen, ohne dass der geschäftliche Nutzen in allen Fällen klar beziffert werden kann.

Modellübergreifende KI-Lösungen auf dem Vormarsch

Die Nutzung von Cloud-Diensten spielt weiterhin eine wichtige Rolle bei der Auswahl von KI-Modellen. Mehr als die Hälfte der befragten Unternehmen nutzt Modelle, die von ihrem Cloud-Anbieter gehostet werden.

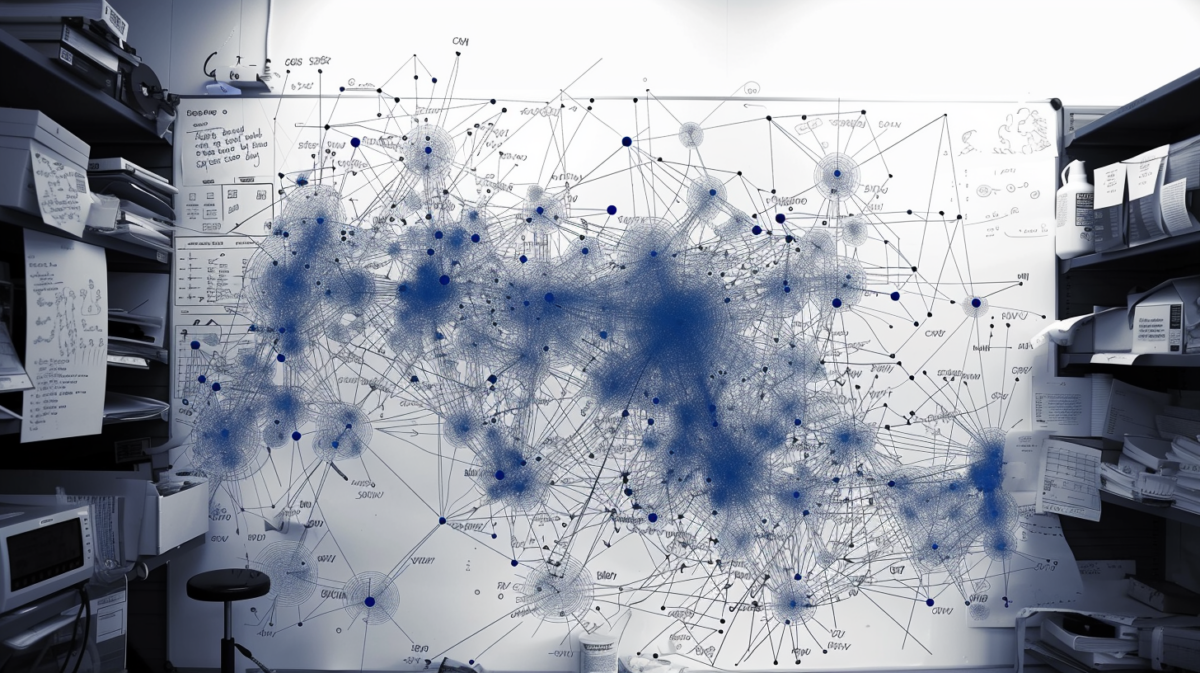

Ebenso setzen Unternehmen zunehmend auf den Einsatz mehrerer KI-Modelle, um ihre Anwendungen zu optimieren und die Abhängigkeit von einzelnen Anbietern zu verringern. Dabei gewinnen Open-Source-Modelle an Bedeutung, da die Unternehmen hier mehr Kontrolle und Anpassungsmöglichkeiten sehen.

Dennoch spielen die Modelle der großen Anbieter wie OpenAI weiterhin eine zentrale Rolle. OpenAI führt hier mit großem Abstand (ca. 40 %) vor Google, Llama, Anthropic, Mistral und Cohere. Bei der Anpassung von KI-Modellen führt derzeit Fine-Tuning (72 Prozent) vor Datenbank-Chats (RAG, 22 Prozent). Nur 6 Prozent der Unternehmen erstellen ihre eigenen Modelle von Grund auf neu.

Dem Bericht zufolge konzentrieren sich die Unternehmen darauf, beliebte KI-Anwendungen wie Chatbots intern zu entwickeln, anstatt Lösungen auf dem Markt einzukaufen. Die beliebtesten Anwendungen sind nach wie vor auf die interne Produktivität ausgerichtet.

KI-Inhalte, die Kunden erreichen, werden in der Regel von Menschen überprüft. Unternehmen sollten auch mit spezifischeren Schnittstellen experimentieren, die auf ihre Bedürfnisse zugeschnitten sind.