Künstliche Intelligenz, was ist das genau? Wie menschlich ist diese Art der Intelligenz wirklich, welches Potenzial und welche Gefahren birgt sie? In welche Richtung wird sie sich in Zukunft entwickeln?

Wer über die Zukunft der Computer nachdenkt, kommt an Künstlicher Intelligenz nicht vorbei. Und wer an die Vergangenheit der Computer denkt, auch nicht - der Traum von der denkenden Maschine reicht bis in die Antike zurück.

Heute spielt Künstliche Intelligenz in vielen Bereichen eine entscheidende Rolle. Doch was ist das eigentlich, was wir heute KI nennen? Und wie funktioniert sie? Hier geben wir einen Überblick über die zukunftsweisende IT-Technologie mit Definitionen ihrer wichtigsten Fachbegriffe.

Was ist Künstliche Intelligenz?

Der Begriff „Künstliche Intelligenz“ kann sehr unterschiedlich interpretiert werden. Einer der Gründerväter der Künstlichen Intelligenz, John McCarthy, definierte KI im Jahr 1956 als „die Wissenschaft und Technik der Herstellung intelligenter Maschinen“, also als Betätigungsfeld für Forscher:innen und Ingenieur:innen.

Entsprechend diesem Ansatz wird KI heute allgemein als ein Teilgebiet der Informatik angesehen, das sich vor allem mit der Nachbildung menschlicher Intelligenz durch Maschinen befasst. Das englische Oxford Dictionary definiert KI als „die Theorie und Entwicklung von Computersystemen zur Ausführung von Aufgaben, die üblicherweise menschliche Intelligenz erfordern, etwa Bild- und Spracherkennung, Entscheidungsfindung und Übersetzung zwischen Sprachen“.

Wann spricht man von Künstlicher Intelligenz und welche Merkmale hat KI?

Wer heute mit KI-Technologien arbeitet, definiert deren Einsatzbereich gerne über die zu lösenden Aufgaben oder den gesellschaftlichen Nutzen. Es geht also in der Regel nicht darum, die Intelligenz des menschlichen Gehirns so genau wie möglich nachzubilden, sondern darum, Formen der Intelligenz in logisch-technologischer Weise in den verschiedensten Fachgebieten einzusetzen.

Zentrale Bereiche der KI sind Systeme, die symbolische Regeln verwenden, und Systeme des maschinellen Lernens (engl.: machine learning, kurz: ML). ML ist auf die Erkennung von Mustern in unstrukturierten und großen Datenmengen spezialisiert. Der Fokus liegt dabei auf der Aufbereitung von Informationen für spezifische Lernprozesse und die Lösung konkreter Aufgaben.

Der Begriff "maschinelles Lernen" und insbesondere dessen Spezialgebiet "Deep Learning" wird heute oft mit KI gleichgesetzt - vor allem außerhalb der Wissenschaft, wo die Unterscheidung zwischen dem Handlungsfeld KI, Methoden wie maschinellem Lernen, Spezialgebieten wie Deep Learning und konkreten Techniken wie Reinforcement Learning noch häufiger vorgenommen wird. Darüber hinaus gibt es zahlreiche Überschneidungen mit anderen Bereichen, z.B. zwischen KI und Robotik.

Was ist ein KI-System?

Verfügt eine technische Soft- oder Hardware über eine KI-basierte Funktionalität, spricht man von einem KI-System. KI-Systeme können eigenständige Computerprogramme sein, aber auch als Komponenten in größere Systeme integriert werden. Ein Beispiel für ein solches eingebettetes KI-System wäre eine KI-Spracherkennungssoftware in einem Roboterkörper, die externe Daten verarbeitet und daraus mittels KI-Algorithmen bestimmte Reaktionen im Roboter hervorruft.

Laut einer von der EU-Kommission im Jahr 2018 eingesetzten Expert:innengruppe sind KI-Systeme „vom Menschen entwickelte Software- (und möglicherweise auch Hardware-) Systeme, die in Bezug auf ein komplexes Ziel auf physischer oder digitaler Ebene agieren, indem sie ihre Umgebung durch Datenerfassung wahrnehmen, die gesammelten strukturierten oder unstrukturierten Daten interpretieren, Schlussfolgerungen daraus ziehen oder die aus diesen Daten abgeleiteten Informationen verarbeiten und über die geeignete(n) Maßnahme(n) zur Erreichung des vorgegebenen Ziels entscheiden. KI-Systeme können entweder symbolische Regeln verwenden oder ein numerisches Modell erlernen, und sind auch in der Lage, die Auswirkungen ihrer früheren Handlungen auf die Umgebung zu analysieren und ihr Verhalten entsprechend anzupassen.“

Was kann KI und was nicht?

Anders als Menschen lernen und erledigen KIs meist nur eine Aufgabe auf hohem Niveau. Eine solche KI wird als schwache - seltener als enge - KI bezeichnet. In ihrem Spezialgebiet ist sie dem Menschen inzwischen oft überlegen. Alle heutigen KI-Systeme sind schwache KI.

Eine KI mit allgemeiner oder menschenähnlicher Intelligenz, die ihre Intelligenz auf viele verschiedene Aufgaben anwenden kann, gibt es noch nicht. Sie ist aber das große Ziel der KI-Forschung. Eine solche KI wird als allgemeine, generelle oder menschenähnliche Künstliche Intelligenz (engl.: Artifcial General Intelligence, AGI oder human-level AI) bezeichnet. Gängig, aber aufgrund ihrer philosophischen Herkunft weniger eindeutig sind die Bezeichnungen starke oder echte KI (engl.: strong or true AI). Nach Einschätzung der Expert:innen sind wir von der Entwicklung einer tatsächlichen AGI zwischen mal nur wenigen und mal Dutzenden von Jahrzehnten entfernt.

Entwickelt sich die allgemeine Künstliche Intelligenz so weit, dass sie den Menschen in allen Belangen übertrifft, entsteht eine Künstliche Superintelligenz (engl.: Artificial Superintelligence). Für viele KI-Skeptiker:innen markiert die Entstehung einer solchen KSI – Singularität genannt – ein mögliches Ende der Menschheit.

Ist Künstliche Intelligenz wirklich intelligent?

Der Begriff KI führt häufig zu Vergleichen mit biologischer Intelligenz und so schnell zur Frage: Ist Künstliche Intelligenz „wirklich“ intelligent?

Der Begriff der Intelligenz umfasst jedoch viele Formen von Intelligenz, wird sehr unterschiedlich definiert und ist zudem mit dem Begriff der Kognition verknüpft. Mal geht es um konkret messbare Fähigkeiten, mal um „intelligentes“ Verhalten, mal um konkrete Substrate wie Hirnareale oder Metaprozessoren. Zudem ist umstritten, ob der Begriff nur handelnden Akteuren oder auch einem isolierten Algorithmus zugeschrieben werden soll.

Historisch betrachtet steigt zudem die Messlatte für als „intelligent“ bezeichnete Technologien mit zunehmendem technischen Fortschritt stetig an. Mit anderen Worten: Sobald sich eine Errungenschaft etabliert hat, wird sie nicht mehr als bahnbrechend angesehen, und die Aufmerksamkeit richtet sich auf vermeintlich „intelligentere“ technologische Meilensteine, die es noch zu meistern gilt. Nach dieser Vorstellung, auch Teslers Theorem genannt, ist Intelligenz immer etwas, das Maschinen noch nicht erreicht haben. Ein Beispiel dafür ist der Sieg von AlphaGo gegen den Go-Weltmeister Lee Sedol.

Kurz: Die Antwort hängt ganz vom verwendeten Intelligenz-Begriff ab – und dieser entwickelt sich stetig auch durch Erkenntnisse der KI-Forschung weiter.

Einige Forschende umgehen dieses Spannungsfeld, indem sie den Begriff KI vermeiden, andere verwenden ihn als Bezeichnung für ihre Disziplin, wieder andere unterscheiden zwischen heutigen, schwachen KI-Systemen und solchen, die eines Tages kommen werden.

Wer eine konkrete Definition möchte, kann sich am KI-Forscher François Chollet orientieren: Intelligenz ist die Kapazität, effizient neue Fähigkeiten zu lernen. Er vermutet, dass dies die Fähigkeit zur Abstraktion und logischem Denken benötigt. Ein KI-System, das diese Bedingung erfüllt, wäre demnach intelligent.

Beispiele Künstlicher Intelligenz: Welche Anwendungsbereiche hat KI?

Schon seit Jahren finden sich KI-Anwendungen sowohl in der Industrie als auch für Endverbraucher, angetrieben von den bereits verfügbaren Fähigkeiten Künstlicher Intelligenz. Laut der Unternehmensberatung McKinsey steht uns der Großteil der wirtschaftlichen Auswirkungen der KI-Revolution aber noch bevor.

Aktuelle KI-Technologie kann grob in vier Felder eingeteilt werden: Grundlagentechnologie, Anwendungen in der Industrie, für Endverbraucher – hier steht die Assistenz im Vordergrund – sowie im Entertainment-Sektor und in der Kunst.

Zu den grundlegenden Technologien gehören maschinelles Sehen und die Verarbeitung natürlicher Sprache, digitale Assistenten, robotergesteuerte Prozessautomatisierung und fortgeschrittenes maschinelles Lernen. Die akademische und industrielle Forschung gibt in diesem Bereich den Ton an und entwickelt die künstliche Intelligenz weiter.

In der Industrie unterstützt KI-Software das Lieferkettenmanagement, die Instandhaltung, Forschung und Entwicklung sowie Vertrieb und Marketing. High-Tech-Branchen wie der Online-Handel oder Suchmaschinen nutzen KI-Algorithmen, um die Interessen ihrer Kunden besser zu verstehen und ihnen passende Produkte und Suchergebnisse anzuzeigen. Und Amazon nutzt KI, um Lebensmittelgeschäfte ohne Kassen und Kassierer zu betreiben.

Endverbraucher:innen nutzen täglich digitale Assistenten wie Googles Assistant oder Amazons Alexa und entsperren ihr Smartphone per Gesichtserkennung. Künstliche Intelligenz verbessert auch bestehende Services wie beispielsweise die Grafikberechnung bei Videospielen oder die Hochskalierung von Videos und alter Fotos. Künstler:innen haben derweil die kreativen Kapazitäten Künstlicher Intelligenz entdeckt und arbeiten mit generativen KIs, etwa GANs oder Systemen wie OpenAIs DALL-E 2.

Deep Learning treibt aktuelle KI-System an

Seit 2015 - und damit früher als die meisten Unternehmen - setzt Google KI-Technologien in seinem Suchalgorithmus RankBrain ein. Neuste Versionen setzten auf Googles Sprachmodell BERT und generative KI-Modelle wie OpenAIs GPT-4 werden in der Internetsuche in Zukunft eine zentrale Rolle spielen. Auch Empfehlungsalgorithmen, wie sie etwa Netflix, Spotify oder Amazon für Serien, Musik, Filme oder Kaufempfehlungen verwenden, nutzen Varianten des Deep Learning.

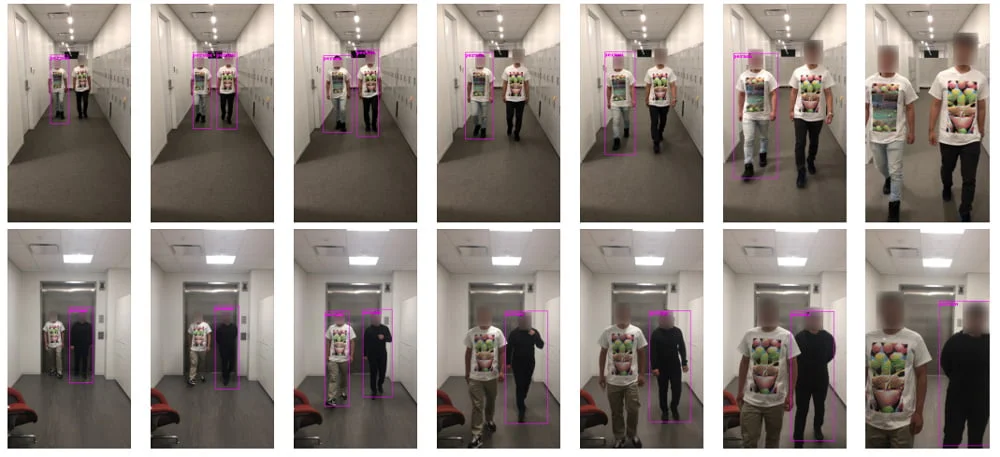

Mittlerweile nutzen auch Filter im Internet, beispielsweise Spamfilter im E-Mail-Verkehr oder filterbasierte Kontroll- und Prüfalgorithmen zur Verhinderung von Hatespeech, extremistischen oder anderen unerwünschten Inhalten in sozialen Netzwerken, Deep Learning. Die Entscheidungsgrundlagen und die Zuverlässigkeit der Algorithmen sind jedoch umstritten. Nicht weniger kritisch werden in den Medien Gesichtserkennungsalgorithmen diskutiert, die nach einigem Training Gesichter nicht nur in sozialen Netzwerken, sondern auch auf Smartphones und als Technik in Überwachungskameras erkennen können.

Mehr über die verbreitetsten KI-Anwendungen gibt es zu lesen im Artikel KI im Alltag: 10 Beispiele, in denen KI steckt.

Künstliche Intelligenz, täuschend echt: Deepfakes in Bild, Video und Sprache

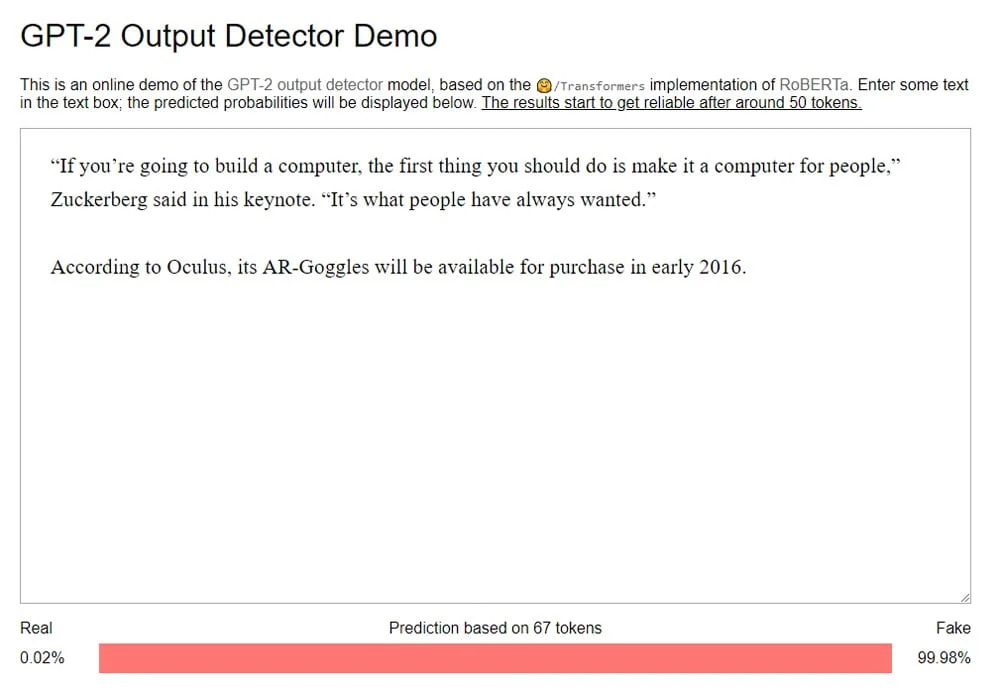

Waren sie noch vor einigen Jahren ein weitestgehend unbekanntes Phänomen, sind Deepfakes – also realistisches, aber gefälschtes Audio-, Bild- oder Videomaterial – heute weit verbreitet. Der nicht-kommerzielle Einsatz nahm in den letzten Jahren rasant zu.

Im Mainstream tauchten Deepfakes erstmals 2017 auf, als ein Reddit-Nutzer namens „deepfakes“ die Gesichter berühmter Frauen in pornografische Videos montierte. Im Jahr 2018 wurden KI-gefälschte Videos bereits in großem Umfang in Fake-Pornos eingesetzt, wobei in den allermeisten Fällen weibliche Personen geschädigt wurden.

Gleichzeitig begann die Verbreitung der Technologie auf YouTube, wo kreative Menschen beispielsweise Schauspieler:innen in Filmen austauschten. In den letzten Jahren hat sich die Qualität der Deepfakes so weit verbessert, dass viele Menschen auf TikTok von einem Fake Tom Cruise getäuscht wurden und ein erfolgreicher Deepfake-YouTuber von Disney angeheuert wurde.

Fake-Medien – eine reale Gefahr?

Mit der Verbreitung von Deepfakes wuchs die Befürchtung, dass sie die Glaubwürdigkeit öffentlich zugänglicher Informationen untergraben könnten - direkt durch Fakes oder indirekt durch einen Vertrauensverlust in die Authentizität digitaler Inhalte.

Insbesondere im Vorfeld der US-Präsidentschaftswahlen 2020 warnten verschiedene politische Akteure vor Fake-Videos, die den Wahlausgang verzerren könnten.

Als Reaktion darauf wurde beispielsweise in Kalifornien ein Gesetz erlassen, das die Verbreitung von Deepfakes im Wahlkampf unter Strafe stellt. Gleichzeitig zeigten sich auch große Social-Media-Plattformen bemüht, Deepfakes zu kennzeichnen oder ganz zu entfernen. So reagierte Facebook vor den US-Wahlen 2020 ebenfalls mit einem Deepfake-Verbot. Wenig später zog YouTube mit ähnlichen Regeln nach und auch Twitter und TikTok setzen mittlerweile Anti-Deepfake-Richtlinien um.

Die erwartete Fake-Flut blieb jedoch aus, die Technologie setzte sich eher im Unterhaltungssektor durch. Ausnahmen gibt es dennoch, etwa Deepfakes des ukrainischen Präsidenten, in denen dieser eine vermeintliche Kapitulation verkündetet.

Eine im November 2021 von MIT-Forschenden veröffentlichte Studie zeigte zudem, dass Deepfake-Videos zumindest im Vergleich zu Fake-Texten nur eine minimal höhere Wahrscheinlichkeit haben, menschliches Verhalten und politische Ansichten zu beeinflussen. Das Ergebnis widerlegt bisherige Annahmen, Videos seien als Informationsquelle weitaus überzeugender als Text.

Mehr über die Technologie, ihre Geschichte und Risiken gibt es nachzulesen im Artikel Deepfakes: Wie alles begann – und wohin es führen könnte. Wer Deepfakes selbst erstellen will, kann mit unserer Deepfake-Anleitung starten.

KI und Automatisierung: Chance oder Dystopie für den Arbeitsmarkt?

Der breite Einsatz von KI zur Bewältigung repetitiver, aber komplexer Aufgaben hätte tiefgreifende Auswirkungen auf den Arbeitsmarkt und damit auf unsere Gesellschaft. So könnten datenbasierte Algorithmen in Form von hochsensiblen Statistiksystemen dank steigender Rechenleistung Spezialaufgaben effizienter, kostengünstiger und mit hoher Zuverlässigkeit erledigen und damit an vielen Stellen den Bedarf an menschlicher Arbeitskraft ersetzen.

Unter „repetitiver Arbeit“ verstehen Spezialist:innen wie der deutsch-amerikanische IT-Unternehmer Sebastian Thrun mitunter sogar hochbezahlte Berufe wie Ärzt:in oder Rechtsanwält:in. Obgleich die zunehmende Automatisierung für viele Arbeitsplätze zunächst als Bedrohung erscheinen mag, sehen viele darin auch langfristig eine Chance für die Menschheit, ihr kreatives und intellektuelles Potenzial zu entfalten.

Als besonders herausfordernd könnte sich die Übergangsphase der Automatisierung erweisen, in der besondere soziale Vorsicht geboten ist. In diesem Zusammenhang stellt sich die Frage, ob der Arbeitsmarkt mit dem rasanten Innovationstempo der technologischen Entwicklung Schritt halten kann und ob Unternehmen und Politik rechtzeitig und adäquat auf automatisierungsbedingte Arbeitsplatzverluste reagieren.

Wie realistisch diese Befürchtungen sind, wie weitreichend und akut ein solcher Wandel ist, wird derzeit unterschiedlich diskutiert. Der heutige technische Stand kann jedoch als zukunftsweisendes Frühstadium bezeichnet werden. Noch scheinen wir weit davon entfernt zu sein, dass KI ganze Arbeitsplätze, geschweige denn Arbeitsfelder, autonom übernehmen kann.

Doch mit generativen KI-Modellen wie DALL-E 2, Midjourney oder Stable Diffusion von OpenAI könnten gerade in kreativen Bereichen, die bisher als am sichersten vor der Übernahme durch Maschinen galten, Menschen ihre Arbeit verlieren.

Zudem hat GPT-4 kürzlich in zahlreichen Benchmarks gegen Menschen beeindruckende Leistungen gezeigt und verändert zusammen mit ChatGPT bereits die Art und Weise, wie viele Menschen mit Texten arbeiten oder programmieren. Tools wie AutoGPT, die Verwendung von Plugins in ChatGPT und generative KI-Modelle in Microsoft Office 365, Google Docs und anderen Anwendungen werden die Technologie in fast alle Arbeitsbereiche bringen und dort viele Arbeitsabläufe drastisch verändern.

KI in der Unterhaltung: Künstliche Intelligenz in Filmen und Büchern

Die Möglichkeit, Aufgaben durch eine externe, automatisierte Intelligenz ausführen zu lassen, hat die Menschheit schon immer fasziniert. Bereits in der Antike finden sich Beschreibungen von automatischen Apparaten und humanoiden Maschinenwesen - den ersten mechanischen Abbildern des Menschen, deren technologisierte Form mehr als 2000 Jahre später als „Roboter“ bezeichnet werden sollte.

Dabei ist die Kunst durch ihr imaginatives Vermögen, das noch nicht Existierende, aber denkbar Mögliche zu erforschen, ein ständiger Motor und Impulsgeber für Weiterentwicklung und Innovation in der KI.

Gleichzeitig übt sie vorausschauende Kritik und weist auf mögliche Risiken hin. Denn in ihren Zukunftsfiktionen steckt oft ein Körnchen Wahrheit: So thematisieren zahlreiche Comics, Romane und Filme seit mehr als einem Jahrhundert die Möglichkeiten und Gefahren einer Künstlichen Intelligenz - lange bevor es sie auch nur ansatzweise gab.

In der Filmgeschichte ist Fritz Langs monumentales Meisterwerk „Metropolis“ von 1927 bis heute als kühner Pionier des politisch-utopischen Science-Fiction-Kinos in Erinnerung geblieben, und Stanley Kubricks „2001: A Space Odyssey“ erfand 1968 den Supercomputer HAL-9000, der eine Weltraummission zum Jupiter begleitet und dabei die beteiligten Raumfahrer zu entmündigen versucht.

Während „Blade Runner“ 1982 die Grenzen zwischen künstlichem und biologischem Leben aufzuzeigen versucht, treibt in „Terminator“ (1984) eine bösartige Super-KI ihr Unwesen. In die Filmgeschichte eingegangen ist auch der legendäre Science-Fiction-Klassiker „The Matrix“ (1999), der die Frage nach der Vielschichtigkeit von Realität und Simulation und damit nach den Metaebenen des Bewusstseins stellt.

Einen eher sozialen Aspekt der künstlichen Intelligenz zeigt das Sci-Fi-Drama „Her“ (2013), das die Mensch-Maschine-Beziehung auf emotionaler Ebene thematisiert. Und auch in „Ex Machina“ (2015) werden die Grenzen des Menschlichen vor dem Hintergrund einer KI ausgelotet.

Natürlich finden sich in den verschiedenen Kulturen und Filmgenres weitaus mehr filmische Beiträge zur Künstlichen Intelligenz. Eine ausführlichere Zusammenfassung der wichtigsten Meilensteine und kreativsten Ansätze in der Filmkunst finden Sie hier.

Auch die Literatur spielt in zahlreichen Narrativen, Motiven und Symbolen mit den Möglichkeiten Künstlicher Intelligenz. Die ersten literarischen Werke über KI wurden lange vor ihren filmischen Pendants verfasst und beschreiben tiefgründig die immer wiederkehrenden Motive Mensch vs. Maschine, Simulation und Bewusstsein in dystopischen und utopischen Zukunftswelten.

So stammt der Begriff Roboter aus dem Theaterstück „R.U.R. - Rossum’s Universal Robots“ von 1920, in dem der tschechische Dramatiker Karel Čapek das Phänomen künstlicher Menschen beschreibt, die zur Steigerung der Produktivität menschliche Aufgaben übernehmen, um sich schließlich durch eine Revolution aus ihrer Sklaverei zu befreien und die Herrschaft über die Menschheit zu erlangen.

Fritz Langs Stummfilmepos „Metropolis“ basierte ursprünglich auf einem gleichnamigen Science-Fiction-Roman der Schriftstellerin Thea Gabriele von Harbou aus dem Jahr 1925. Und der Roman „2001: A Space Odyssey“ des Autors Arthur C. Clarke, der sich von seinen früheren Kurzgeschichten inspirieren ließ, entstand parallel zum gleichnamigen Film. Auch „Blade Runner“ basiert auf der Vorlage „Do Androids Dream of Electric Sheep?“ von Philip K. Dick.

In den 1920er bis 1950er Jahren wurden Science-Fiction- und KI-Themen vor allem durch englischsprachige Pulp-Magazine populär - Beispiele für diese erschwingliche, grafisch illustrierte Kultliteratur sind etwa Argosy, Fantastic Adventures oder Amazing Stories.

Den wohl bekanntesten Beitrag zu Robotik und KI in der Literatur leistete der russisch-amerikanische Science-Fiction-Autor Isaac Asimov (1920-1992), dessen Werke bereits zu Lebzeiten zu Bestsellern wurden. Asimov, Professor für Biochemie an der Boston University, prägte mit seinen drei Grundgesetzen der Robotik den Diskurs über Sicherheits- und ethische Fragen im Zusammenhang mit neuen Technologien und Künstlicher Intelligenz.

Ein Überblick zu den Klassikern der KI-Literatur ist hier zum Nachlesen zusammengestellt.

Künstliche Intelligenz: Welche Vor- und Nachteile hat KI und warum brauchen wir sie?

Welche Vorteile hat KI?

Heutige KI-Anwendungen sind im Kern statistische Verfahren und können überall dort eingesetzt werden, wo große Datenmengen vorliegen und eine gewisse Ungenauigkeit keine fatalen Folgen hat. In diesen Fällen kann KI einen großen Mehrwert bieten: Für Unternehmen wie Google, Baidu oder Facebook, die KI nutzen, um ihre Suchergebnisse oder Newsfeeds zu organisieren, oder für Endverbraucher, die KI nutzen, um ihr Smartphone zu entsperren, Fotos zu sortieren oder Texte zu übersetzen.

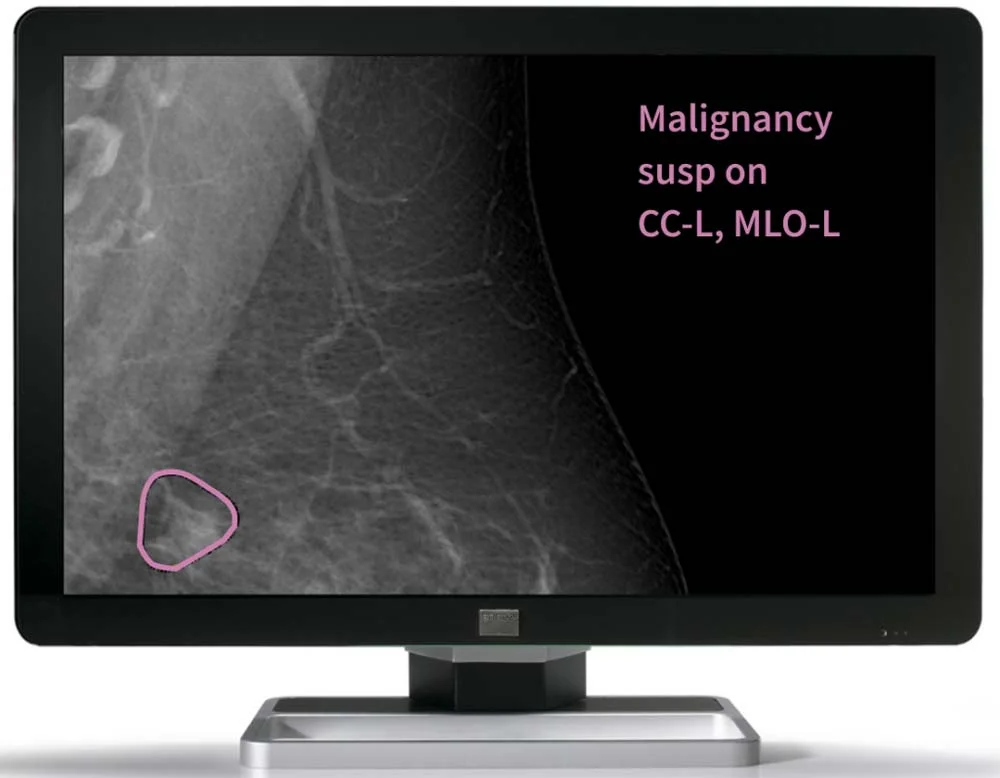

KI-Technologien finden sich mittlerweile in so vielen Bereichen, die für Kultur, Gesellschaft, Wissenschaft und Wirtschaft relevant sind, dass sich ihr nahezu unermessliches Potenzial anhand einzelner Beispiele kaum erfassen lässt. Denn KI steigert nicht nur den Profit von Unternehmen, sondern kann auch in ethisch und gesellschaftlich wertvoller Weise eingesetzt werden - etwa im Umweltschutz zur Früherkennung von Waldbränden, im Gesundheitswesen zur Bekämpfung von Pandemien oder bei der Entwicklung von Medikamenten zur Krebstherapie. Und nicht zuletzt kann KI als zeitsparende Technologie Routineaufgaben im Alltag übernehmen - mit dem Versprechen, menschliche Fehler zu minimieren oder gar zu eliminieren.

KI: So gerecht, wie wir sie machen

In Fällen, in denen eine sehr hohe Genauigkeit erforderlich ist, stößt die derzeitige KI-Technologie häufig an ihre Grenzen: Ein Beispiel ist die Revolution der Mobilität durch autonome Fahrzeuge, die trotz zahlreicher Investitionen noch nicht erreicht wurde.

Im schlimmsten Fall werden solche Ungenauigkeiten schlicht ignoriert: KI-Überwachung ist weltweit auf dem Vormarsch, ungenaue Gesichtserkennungs-KIs werden von Staaten für die Kriminalitätsbekämpfung oder zur Überwachung von Demonstrationen eingesetzt. KI-Systeme, die mit rassistisch vorbelasteten Datensätzen trainiert wurden, geben Empfehlungen ab, ob Menschen Kaution gewährt werden sollte. Ähnliche Systeme entscheiden in Banken, wem ein Kredit zusteht oder in Ausländerbehörden, wessen Asylantrag bewilligt wird.

Werden Ungenauigkeiten und Vorurteile KI-gestützter Algorithmen bei Entscheidungen nicht berücksichtigt, verfestigt sich der Eindruck einer maschinenbasierten Unfehlbarkeit der Technologie. Dies kann es Betroffenen erschweren, Entscheidungen anzufechten. KI-Expert:innen wie Kate Crawford sprechen in diesem Zusammenhang vom sogenannten Black-Box-Problem der KI-Systeme: Zwar lässt sich im Voraus festlegen, wie und mit welchen Daten ein Algorithmus trainiert wird. Wir können auch nach unseren Maßstäben beurteilen, wie plausibel das Ergebnis erscheint. Was aber genau zwischen dem Input und dem beobachteten Output passiert ist, wie also der algorithmische Entscheidungsprozess abgelaufen ist, entzieht sich erst einmal unserem Wissen.

Solche unausgewogenen Ergebnisse bergen die Gefahr, bestehende soziale Ungleichheiten zu verstärken. Um dies zu verhindern, besteht ein erster wichtiger Ansatzpunkt darin, Algorithmen nicht mit einseitigen Daten zu füttern - etwa wenn ein Gesichtserkennungsalgorithmus nur mit Daten weißer Menschen trainiert wird oder wenn der besagte Amazon-Recruiting-Algorithmus die Eignung künftiger Bewerber:innen anhand der bisherigen Bewerbungen männlicher Kandidaten beurteilt. Die KI-Expertin Crawford plädiert zudem dafür, in gesellschaftlich besonders relevanten Bereichen wie Bildung, Justiz und Gesundheit nur Algorithmen einzusetzen, die ihre Ergebnisse ohne die genannte Black-Box-Problematik erzielen.

Auf politischer Ebene gibt es vielerorts Bestrebungen, die Risiken von KI-basierten Algorithmen zu minimieren. So hat die chinesische Regierung am 1. März 2022 mit der von der chinesischen Cyberspace Administration entworfenen Regelung "Internet Information Service Algorithmic Recommendation Management Provisions" erstmals einen weitreichenden Vorstoß zur Kontrolle diskriminierender KI-Algorithmen unternommen. Auch die Europäische Kommission entwarf ein umfassendes Regelwerk zur Eindämmung gefährlicher KI-Systeme, das richtungsweisend für die Entwicklung sicherer, vertrauenswürdiger und ethischer KI-Technologien sein will.

Militär und Waffentechnologien als treibende Kraft der KI-Forschung

Künstliche Intelligenz ist in den letzten Jahren zunehmend zu einem Bestandteil des internationalen Wettrüstens, der Kriegsführung und des politischen Machtkampfes geworden. Bereits in den 1960er Jahren wurde die frühe KI-Forschung in den USA vor allem von der DARPA (Defense Advanced Research Projects Agency), einer Forschungsbehörde des US-Verteidigungsministeriums, vorangetrieben. Auch in jüngster Zeit investiert die DARPA mehrere Milliarden Dollar in die Entwicklung einer neuen Generation künstlich intelligenter Maschinen mit menschenähnlichen Kommunikations- und Denkfähigkeiten.

Die Entwicklung autonomer Waffensysteme ist inzwischen für viele Länder, die ihre strategische Machtposition in der Welt erhalten oder ausbauen wollen, von großem Interesse. Vor allem China, Russland und die USA investieren massiv in diese Technologie. Gleichzeitig warnen zahlreiche KI-Forscher:innen und Wissenschaftler:innen vor den Risiken KI-gestützter Waffensysteme - insbesondere dann, wenn sie ohne ernstzunehmende menschliche Kontrolle eingesetzt werden. Viele Menschenrechtsaktivist:innen und kleinere Nationen mit beschränkten militärischen Mitteln fordern daher ein Verbot tödlicher vollautonomer Waffentechnik.

Unser Artikel über KI im Krieg gibt einen Überblick über das Thema.

KI als Ersatz für menschliche Arbeitskräfte?

Ein weiteres Schreckgespenst der KI ist die weitreichende Automatisierung und der damit verbundene massive Verlust von Arbeitsplätzen, der vor allem die Automobilindustrie, Montagedienstleistungen und den Telekommunikationssektor treffen würde: Der ehemalige US-Präsidentschaftskandidat Andrew Yang forderte sogar ein Grundeinkommen, um die amerikanische Gesellschaft gegen die von ihm befürchtete KI-bedingte Massenarbeitslosigkeit zu wappnen.

Es ist jedoch wahrscheinlich, dass die Einführung von KI-Technologien eher polarisierende Auswirkungen auf die Arbeitswelt haben wird: In einigen Bereichen wird KI menschliche Arbeitskräfte weitgehend ersetzen, indem sie Arbeitsprozesse beschleunigt und die Fehleranfälligkeit stark reduziert. In anderen Bereichen schafft KI neue hybride Rollen, in denen Mensch und Maschine Seite an Seite arbeiten und KI indirekt den Wert und die Bedeutung unverzichtbarer menschlicher Fähigkeiten steigert.

In einigen Bereichen könnten durch die Einführung von KI-Technologien sogar zusätzliche Arbeitsplätze geschaffen werden, z. B. in der Infrastruktur, im Dienstleistungssektor und in der Hightech-Industrie.

Doch KI-Technologien wie DALL-E oder GPT-4 haben das Potenzial, auch solche Arbeitsplätze zu ersetzen, die bisher von der Automatisierung verschont geblieben sind. Dazu gehören Arbeitsplätze in der Verwaltung, in Anwaltskanzleien, in den Medien und auch im kreativen Bereich, insbesondere im Design.

KI: Wirtschaftswunder oder unser Ende?

Eine allgemeine Künstliche Intelligenz verschiebt die Chancen und Risiken der KI ins Existenzielle: Sie wäre ein massiver Eingriff in nahezu alle Lebensbereiche und eine Revolution für Gesellschaft, Wirtschaft, Bildung, Medizin und Forschung.

Am Ende könnte eine künstliche Superintelligenz stehen, die uns jede Arbeit abnimmt, jedes Problem löst und die Demokratie revolutioniert. Diese zugrundeliegenden Potenziale werden KI-Forscher:innen wohl so lange antreiben, bis die Vision einer Superintelligenz verwirklicht ist - oder der Beweis vorliegt, dass ihr Unterfangen unmöglich ist. KI-Labore wie Deepmind oder OpenAI suchen über den Umweg vieler spezialisierter KI-Einzelprojekte den Weg zur Super-KI, die sich eines Tages aus vielen Einzelkomponenten zu einem großen neuronalen Netz zusammensetzen könnte.

Diese Versuche beunruhigen diejenigen, die eine allgemeine Künstliche Intelligenz – und erst recht eine Superintelligenz – für eine existenzielle Bedrohung halten. Der Philosoph Nick Bostrom oder der KI-Forscher Stuart Russel warnen etwa vor der Auslöschung der Menschheit durch eine zu intelligente KI. Wer Bostroms Argumentation spielerisch nachvollziehen möchte, sollte sich diesen Büroklammer-Simulator anschauen.

Gelassener sehen das KI-Pionier Yann LeCun und Neurobiologe Anthony Zader: Die beiden Experten meinen, KI fehle es am notwendigen Instinkt, um Menschen zu töten – die übermächtige Maschine hätte schlicht kein Interesse am Ende der Menschheit. Verstärkung bekommen die beiden vom Kognitionsforscher Steven Pinker, der Bostroms Befürchtungen für dystopischen Schwachsinn hält.

KI & Digitale Transformation: Wie hilft Künstliche Intelligenz bei der Digitalisierung?

Um die Rolle der Künstlichen Intelligenz in der Digitalisierung zu verstehen, muss zunächst der Begriff der Digitalisierung geklärt werden. Im Deutschen hat er eine doppelte Bedeutung, die im Englischen durch die Begriffe „Digitization“ und „Digitalization“ klarer getrennt wird.

Die „Digitization“ ist die (automatische) Übertragung von analogen Werten und Daten wie etwa Papierdokumenten, Microfilm, Fotos oder Tonaufnahmen in entsprechende digitale Formate.

Damit sind die Daten den Prozessen der „Digitalization“ zugänglich: Der Ermöglichung, Verbesserung oder Umwandlung von Geschäftsmodellen und -prozessen durch die Nutzung digitaler Technologien und digitalisierter Daten, die mit Methoden der Datenverarbeitung in verwertbare Kenntnisse umgesetzt werden. Wer heute im Deutschen von Digitalisierung spricht, meint meist diesen Prozess.

Was ist Digitale Transformation?

Die Digitalisierung in diesem Sinne führt zu einer digitalen Transformation: die tiefgreifende Umgestaltung von Geschäfts- oder anderen Organisationsprozessen, Kompetenzen und Modellen, um die Vorteile der neuen digitalen Technologien voll auszuschöpfen.

KI-Technologie spielt in diesem Prozess eine dreifache Rolle: Sie hilft heute beispielsweise bei der Digitalisierung analoger Daten durch Bild- und Sprachanalyse. Darüber hinaus kann sie große Datenmengen - also „Big Data“ - analysieren und darin Muster erkennen. Dazu wird sie häufig mit den digitalisierten Daten trainiert, erkennt Bilder, verarbeitet natürliche Sprache, trifft Vorhersagen im Bereich Predictive Analytics, interagiert mit Kunden und Mitarbeitern über Chatbots oder schafft intelligente Maschinen am Rand (Edge) der Cloud.

KI trägt damit wesentlich zur digitalen Transformation bei: Neue Märkte werden erschlossen, alte Prozesse verschwinden oder werden grundlegend verändert, etablierte Marktstrukturen brechen auf. Ohne KI-Algorithmen gäbe es kein Google, kein Facebook, kein Netflix, kein Uber und kein Amazon - jedenfalls nicht in der Form, wie wir diese Konzerne kennen.

Was ist Industrie 4.0?

Der Begriff „Industrie 4.0“ ist eine Wortschöpfung aus dem deutschsprachigen Raum, deren Ursprung meist im Zusammenhang mit der Forschungsunion Wirtschaft-Wissenschaft gesehen wird, die als Beratungsgremium der Bundesregierung deren Hightech-Strategie von 2006 bis 2013 begleitete. Im Jahr 2011 wurde eine gleichnamige Plattform für Verbände aus den Bereichen IT, Maschinenbau und Elektrotechnik gegründet.

Das Buzzword bezeichnet das Ziel einer vierten industriellen Revolution in der Entwicklungsgeschichte der Menschheit: Die erste und bekannteste industrielle Revolution begann mit der Erfindung der Dampfmaschine im 18. Die zweite bezeichnet die Massenproduktion am Fließband mit Hilfe von Elektromotoren, deren prominentestes Beispiel die Ford-Werke in den USA zu Beginn des 20. Die dritte industrielle Revolution ging Mitte des 20. Jahrhunderts mit der Automatisierung der Produktion durch erste elektronische, computergestützte Steuerungen einher. Bei den Anlagen der Industrie 3.0 handelte es sich um einzelne, isolierte Systeme: Sie waren noch nicht umfassend vernetzt, weder innerhalb des Produktionssystems noch mit der kaufmännischen Software.

„Industrie 4.0“ steht für die fortschreitende Digitalisierung der Produktion, der Fabriken und der angrenzenden Prozesse. Mit dem Einzug der Digitalisierung in die Produktionsstätten werden einzelne Geräte und Fabrikelemente durch Internettechnologien stärker miteinander vernetzt. Ursprünglich voneinander getrennte Systeme wie Sensoren und Software werden so in Kommunikation gebracht, können Daten austauschen und auf dieser Basis sogar eigenständig Entscheidungen treffen.

Viele Expert:innen bezweifeln die Angemessenheit des Begriffs „Industrie 4.0“, vor allem weil noch nicht erkennbar ist, ob es zwischen den ersten Digitalisierungstendenzen der 3. industriellen Revolution und der heutigen stärkeren Vernetzung elektronischer Geräte tatsächlich eine so klare Trennlinie mit erneut revolutionärem Charakter für Gesellschaft und Technik gibt.

Die Rolle von KI in der Industrie 4.0

In der Fertigungsindustrie ermöglicht die KI-Technologie die beiden Grundlagen der sogenannten Industrie 4.0: das industrielle Internet der Dinge und die Robotik.

Das Internet der Dinge (Internet of Things, IoT) gilt als wesentlicher Treiber und Bestandteil der Digitalisierung von Wirtschaft und Gesellschaft. Das IoT erweitert das klassische globale Kommunikationsnetz des Internets beispielsweise um intelligente Geräte für Endverbraucher oder intelligente Sensoren für Industriegeräte, die als „Kommunikationspartner“ in das globale Netz integriert werden. Sie liefern große, bisher ungenutzte Datenmengen und stellen sie KI-Software zur Auswertung und Steuerung zur Verfügung.

Auf der gleichen Basis ermöglicht das Industrial Internet of Things (IIoT) die Vernetzung aller Maschinen, Produkte und Prozesse: Fehlendes Material wird automatisch nachbestellt, Werkstücke fließen reibungslos zur nächsten Maschine, Fehler werden im besten Fall erkannt, bevor sie auftreten - die Prozesssteuerung wird transparenter, besser kontrollierbar und durch die weitgehende Automatisierung gleichzeitig effizienter. Das soll Kosten senken und schnelle Prozesse mit hoher Flexibilität ermöglichen.

Neben dem IIoT ist hier vor allem die Robotik in der Produktion gefragt: Zwar funktioniert die Automatisierung mit viel Aufwand bei der Spezifikation und Installation der Roboter in einer Fertigungslinie. Jeder Roboter ist jedoch ein Spezialist mit stark eingeschränkten Wahrnehmungs-, Bewegungs- und Manipulationsfähigkeiten. Automatisierung ist daher unflexibel, teuer, muss genau kalibriert werden und lohnt sich nur für große Unternehmen, die große Mengen standardisierter Produkte herstellen.

Künstliche Intelligenz kann schon heute Roboter zum Laufen bringen, die flexibler sind und ihre Umgebung besser wahrnehmen. Ein Beispiel dafür sind sogenannte kollaborative Roboter, kurz Cobots - kleine und kostengünstige Roboterarme, die programmierbar sind und mit Menschen zusammenarbeiten können. Diese Entwicklung ermöglicht mehr Flexibilität in der Produktion: Die Cobots können temporär an einem Arbeitsplatz eingesetzt werden, um dann umprogrammiert an einem anderen weiter zu arbeiten. Das macht die Technologie auch für Unternehmen interessant, die sich klassische Automatisierung bisher nicht leisten konnten.

Das große Ziel von Industrie 4.0 sind jedoch Roboter, die noch intelligenter, noch flexibler und noch aufmerksamer sind. Sie sollen Objekte so einfach erkennen und handhaben können wie Menschen - und so alle Schritte eines Fertigungsprozesses automatisieren.

Dies soll für viele Produkte die „Lights-Out-Factory“ ermöglichen, eine vollständig autonome Fabrik, die ohne menschliches Zutun funktioniert - und daher auch keine Beleuchtung benötigt. Für diese Roboter sind Fortschritte in der KI-Forschung erforderlich, insbesondere bei der Objekterkennung und dem bestärkenden Lernen, mit dem Roboter schnell neue Aufgaben erlernen können.

Künstliche Intelligenz im Unternehmen: Wie verändert KI die Arbeitswelt?

Der Einzug der Digitalisierung und Automatisierung in die meisten Arbeitsbereiche wird die Arbeitswelt zweifellos verändern. Im Büro beispielsweise bietet KI ein großes Potenzial für Zeiteinsparungen bei Arbeitsprozessen. Hier kann maschinelles Lernen die Mitarbeiter bei der Sortierung und Bearbeitung von Akten unterstützen. Papierdokumente können von lernender Software selbstständig gescannt, gespeichert und abgelegt werden. Generative KI-Systeme wie ChatGPT können Texte verfassen, den E-Mail-Verkehr regeln oder Tabellen und Präsentationen erstellen. Repetitive Verwaltungsaufgaben, die für Menschen oft sehr zeitaufwändig sind, können so schneller erledigt werden.

In Bereichen wie Architektur, Bauwesen und Design könnte KI zukünftig eine unterstützende Funktion einnehmen und als Impulsgeber für Inspiration und neue Innovationen dienen. Denkbar ist auch, dass typisch menschliche, durch Maschinen nicht ersetzbare Soft Skills auf dem Arbeitsmarkt an Bedeutung gewinnen. So könnte die Rolle des Menschen vor allem bei körpernahen Dienstleistungen und in handwerklichen Berufen eher komplementär zu KI-Systemen gesehen werden, mit einem stärkeren Fokus auf empathisches Verhalten, emotionale Intelligenz sowie kritisch-komplexes Denken.

Mit dem Wandel hin zu mehr Automatisierung werden Expert:innen in Datenanalyse und -wissenschaft, KI oder Machine Learning zunehmend nachgefragt und Fachkräfte in den verschiedensten Bereichen müssen sich entsprechend neu orientieren. Auch Arbeitnehmer:innen, die nicht akut von der Automatisierung bedroht sind, müssen sich daher auf Weiterbildungsmaßnahmen einstellen und das Motto „lebenslanges Lernen“ beherzigen, um auf dem Arbeitsmarkt gefragt und am Puls der Zeit zu bleiben.

Einen Grund, sich zurückzulehnen und die Arbeit von Maschinen erledigen zu lassen, sehen hingegen nur wenige. Zumal die Entscheidung über Arbeitszeitverkürzungen, z.B. durch einen 6-Stunden-Arbeitstag oder eine 4-Tage-Woche, nicht auf technischer, sondern auf politischer Ebene getroffen werden müsste. Zudem hat der technische Fortschritt historisch gesehen eher zu Beschleunigung und Produktivitätssteigerung geführt.

Wie funktioniert Künstliche Intelligenz?

Angesichts der vielfältigen Anwendungsfelder und Methodiken der Künstlichen Intelligenz ist es nicht möglich, von „der einen KI“ zu sprechen - ebenso wenig wie von einer einzigen, sie charakterisierenden Funktionsweise. Im Kern beinhaltet KI immer ein sehr umfassendes System von Methoden, Prozessen und Technologien, die dazu dienen, eine spezifische, vorgegebene Aufgabe zu lösen. Das so entstandene Modell kann z.B. die Erstellung von Prognosen oder die Unterstützung von Entscheidungsprozessen zum Ziel haben.

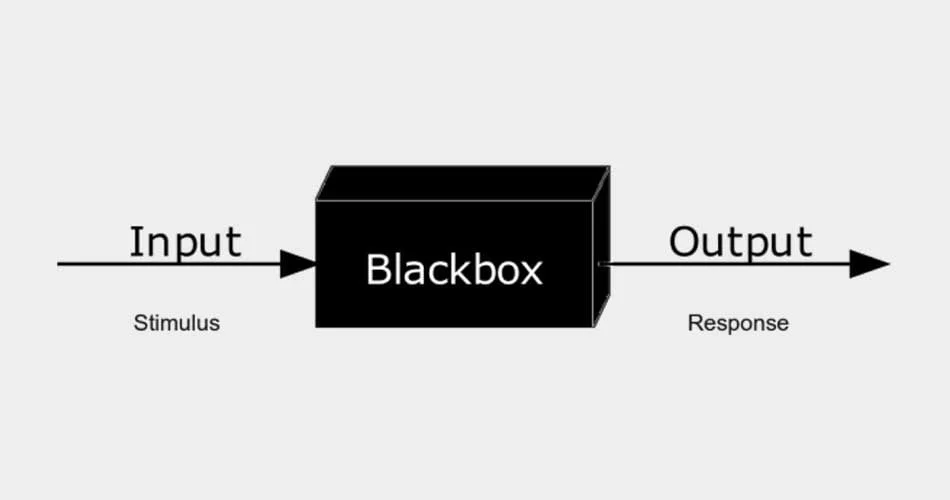

Je nachdem, ob das im KI-System gespeicherte Wissen so strukturiert ist, dass seine Berechnungen für Menschen leicht nachvollziehbar sind, oder ob es sich um das bereits erwähnte Black-Box-Modell handelt, dessen innere Wirkmechanismen für Menschen zunächst unzugänglich bleiben, spricht man von symbolischer oder subsymbolischer Künstlicher Intelligenz.

Symbolische KI bezeichnet die klassische Methodik, bei der das KI-System eine spezifische Aufgabe auf der Grundlage logischer Schlussfolgerungen und abstrakter Konzepte löst. Die Idee folgt einem Top-Down-Ansatz in dem Sinne, dass das menschliche Gehirn auf einer übergeordneten logisch-begrifflichen Ebene symbolisch nachgeahmt wird. Diese Art der Künstlichen Intelligenz bedient sich z.B. Werkzeugen wie logischer Programmierung, Produktionsregeln, semantischer Netze und Frames zur Wissensrepräsentation.

Logische Symbole stehen hierarchisch über der Datenmanipulation und Informationsverarbeitung. Voraussetzungen für die Methodik der symbolischen KI können z.B. eine spärliche Datenlage oder auch die Tatsache sein, dass sich die Aufgabenstellung überhaupt in einfachen, logischen Zusammenhängen ausdrücken lässt. Die technische Beschränkung lässt bereits erahnen, dass es sich um eine ältere Methodik handelt: Als Paradigma bestimmte sie die KI-Forschung von Mitte der 50er bis Mitte der 90er Jahre. Bereits 1985 wurde sie als GOFAI („Good Old-Fashioned Artificial Intelligence“) bezeichnet.

Als flexibleres und präziseres KI-Paradigma im Vergleich zur symbolischen KI begann die subsymbolische KI in den 1980er Jahren ihren Siegeszug. Unter dieser Methode der Wissensrepräsentation werden Ansätze zusammengefasst, die ohne abstrakte Symbole auskommen, wie z.B. mathematische Optimierung, Klassifikationsverfahren, Regressionsmodelle und neuronale Netze. Diese Methodik geht den Lösungsprozess nach dem Bottom-up-Ansatz, also „von unten“, an: Das Wissen ist hier in Form großer Datenmengen strukturiert, in denen die KI bestimmte Muster erkennt. Die Daten können beispielsweise als künstliche Neuronen angeordnet sein, die in einem komplexen System größerer Gruppen parallel miteinander zu einem Gesamtsystem, dem künstlichen neuronalen Netz, verknüpft werden.

Die Neuronen, die sich zwischen Input und Output befinden, lernen dann implizit aus Erfahrungsdaten, ohne vorher mit entsprechenden symbolischen Werten wie Regeln, Relationen oder Eigenschaften programmiert worden zu sein.

Sie agieren sozusagen „im Verborgenen“; die nur eingeschränkte Nachvollziehbarkeit des Entscheidungsprozesses ist jedoch mitunter ein großer Nachteil. Insbesondere in sensiblen Anwendungsfällen wie Gerichtsurteilen, militärischen Verfahren oder Kreditanträgen erfordert die Situation oft absolute Transparenz und Nachvollziehbarkeit der Entscheidungen. In diesen Fällen können subsymbolische KI-Algorithmen nur mit äußerster Vorsicht eingesetzt werden.

Welche Arten von künstlicher Intelligenz gibt es?

Je nach ihren Fähigkeiten wird KI derzeit in die drei bereits erwähnten Typen schwache KI, starke KI und Super-KI unterteilt.

Die schwache oder enge KI ist auf eine konkrete Aufgabe spezialisiert, die sie immer präziser zu lösen versucht. Beispiele sind KI-Systeme für die Objekterkennung, Übersetzung, Text- und Bildgenerierung.

Die starke, allgemeine oder menschengleiche KI soll wie ein Mensch intellektuelle Aufgaben unterschiedlicher Art verstehen und erlernen. Diese Form der künstlichen Intelligenz ist in der Praxis jedoch noch nicht erreicht, da sie voraussetzt, dass eine Maschine mit der vollen Bandbreite kognitiver Fähigkeiten ausgestattet ist.

Die am weitesten fortgeschrittene Form der Künstlichen Intelligenz, die so genannte Super-KI, würde den Menschen in jeder Hinsicht übertreffen und in der Lage sein, jede Aufgabe besser zu lösen als der Mensch.

Was die Funktionalität betrifft, werden in der Regel vier unterschiedliche Kategorien unterschieden: reaktive Maschinen, Limited Memory, Theory of Mind und Self-awareness.

Reaktive Maschinen arbeiten auf der Grundlage aktueller Daten und nicht auf der Grundlage von Erfahrungen in Form gespeicherter historischer Informationen. Sie reagieren im wahrsten Sinne des Wortes unmittelbar auf ihre Umwelt. Dabei sind sie auf die Lösung einer konkreten, vorgegebenen Aufgabe spezialisiert. Ein Beispiel hierfür ist der 1996 von IBM entwickelte Schachcomputer Deep Blue, der seine Spielfähigkeiten nicht auf der Grundlage früherer Züge trainiert, sondern lediglich das aktuelle Brett analysiert, mögliche zukünftige Züge prognostiziert und entsprechend reagiert.

Kontrastierend zu reaktiven Maschinen greift eine nach Limited Memory funktionierende KI auf historische Daten zurück, um anhand dieser Entscheidungen zu treffen. Die Trainingsdaten sind nur für einen bestimmten Zeitraum und in beschränkter Menge verfügbar und werden nicht vollumfänglich als permanenter Wissensschatz gespeichert. Ein Beispiel hierfür sind selbstfahrende Autos, die den aktuellen Verkehrsfluss im Zeitverlauf registrieren, entsprechende Daten sammeln und einige daraus – wie Informationen zu Straßenschildern, Fahrspuren oder Ampeln – dem statischen Datensatz hinzufügen.

Im Gegensatz zu reaktiven Maschinen greift eine KI mit Limited Memory auf historische Daten zurück, um Entscheidungen zu treffen. Die Trainingsdaten stehen nur für einen bestimmten Zeitraum und in begrenzter Menge zur Verfügung und werden nicht vollständig als permanenter Wissensbestand gespeichert. Ein Beispiel hierfür sind selbstfahrende Autos, die den aktuellen Verkehrsfluss im Zeitverlauf erfassen, entsprechende Daten sammeln und einige davon - wie Informationen über Verkehrsschilder, Fahrspuren oder Ampelschaltungen - dem statischen Datensatz hinzufügen.

Theory of Mind drückt die Fähigkeit der KI aus, ihre jeweilige Umgebung aus Menschen und Objekten auch in ihrer Veränderung tiefgehend zu verstehen und entsprechend flexibel darauf zu reagieren. Das bedeutet, dass die KI auch menschliche Emotionen, Gedanken und Motivationen verstehen können muss. Trotz großer Fortschritte ist es bisher nicht gelungen, eine KI zu entwickeln, die entsprechend dieser Funktionalität agiert. Ein Versuch in diese Richtung wurde Ende der 90er Jahre am Massachusetts Institute of Technology (MIT) mit dem Roboterkopf Kismet unternommen, der menschliche Emotionen nachahmen und erkennen konnte.

Self-awareness ist eine sehr fortgeschrittene und daher bisher unerreichte Form der Künstlichen Intelligenz. Sie zeichnet sich durch ein tiefes Verständnis menschlicher Emotionen aus und verfügt selbst über solche, einschließlich eigener Wünsche und Meinungen. Es handelt sich um eine hochbegabte Intelligenz, die den Menschen in seinen Fähigkeiten gleicht oder übertrifft und im authentischen Austausch mit Menschen sensibel und autonom agiert.

Wie man eine Künstliche Intelligenz erschafft

Es existieren verschiedene Methoden, um Künstliche Intelligenz zu schaffen. Grundsätzlich können zwei unterschiedliche Ansätze unterschieden werden:

Die sogenannte „Good, Old-Fashioned AI“ (GOFAI) bestimmte die KI-Forschung bis in die späten 1980er und strebte nach einer starken KI. Die Idee: Menschliches Denken besteht aus dem logischen Kombinieren einzelner Begriffe, die unser Wissen über die Welt enthalten.

SHRDLU war eines der ersten KI-Programme, das versuchte, natürliche Sprache zu verstehen. Die zwischen 1968 und 1970 entstandene KI kann nach Aufforderung geometrische Objekte bewegen und Auskünfte über sie geben.

Aus dieser Vorstellung entstanden sogenannte Expertensysteme, die einfache Informationen über die Welt in symbolische Kategorien verpacken und mit diesen in logischen Schlussfolgerungen operieren.

Die GOFAI konnte die großen Erwartungen an KI nicht erfüllen - es brach der erste KI-Winter ein. Forschungsgelder wurden gestrichen und Projekte eingestampft. Heute werden solche KIs etwa in der Prozessautomatisierung eingesetzt.

Maschinelles Lernen / Machine Learning / Deep Learning

Der aktuelle Liebling der KI-Forschung ist das Maschinelle Lernen (Machine Learning), hier insbesondere das Deep Learning.

Maschinelles Lernen schafft Computersysteme, die mit Hilfe von Daten lernen, Aufgaben zu erfüllen. Anstatt eines Entwicklers, der Zeile für Zeile Anweisungen in Form von Programmiercode vorgibt, schreibt die Software nach dem ersten Anstoß ihren Code eigenständig fort und optimiert ihn für ein besseres Ergebnis.

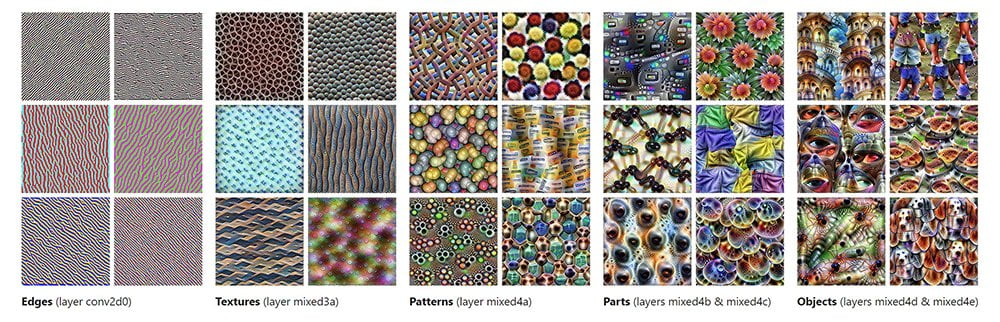

Aktueller Favorit der Forschungsdisziplin ist das sogenannte Deep Learning: Maschinelles Lernen mit mehrschichtigen neuronalen Netzen, die mit immer höherer Genauigkeit Muster in Daten erkennen und so menschliche Vorlieben lernen, Gegenstände erkennen oder Sprache verstehen.

Maschinelles Lernen treibt eine große Anzahl aktueller KI-Dienste an. Egal ob Google, Netflix oder Facebook: Lernende Algorithmen sprechen Empfehlungen aus, verbessern Suchmaschinen und lassen Sprachassistenten Antworten geben.

(Künstliche) Neuronale Netze / (Artificial) Neural Networks

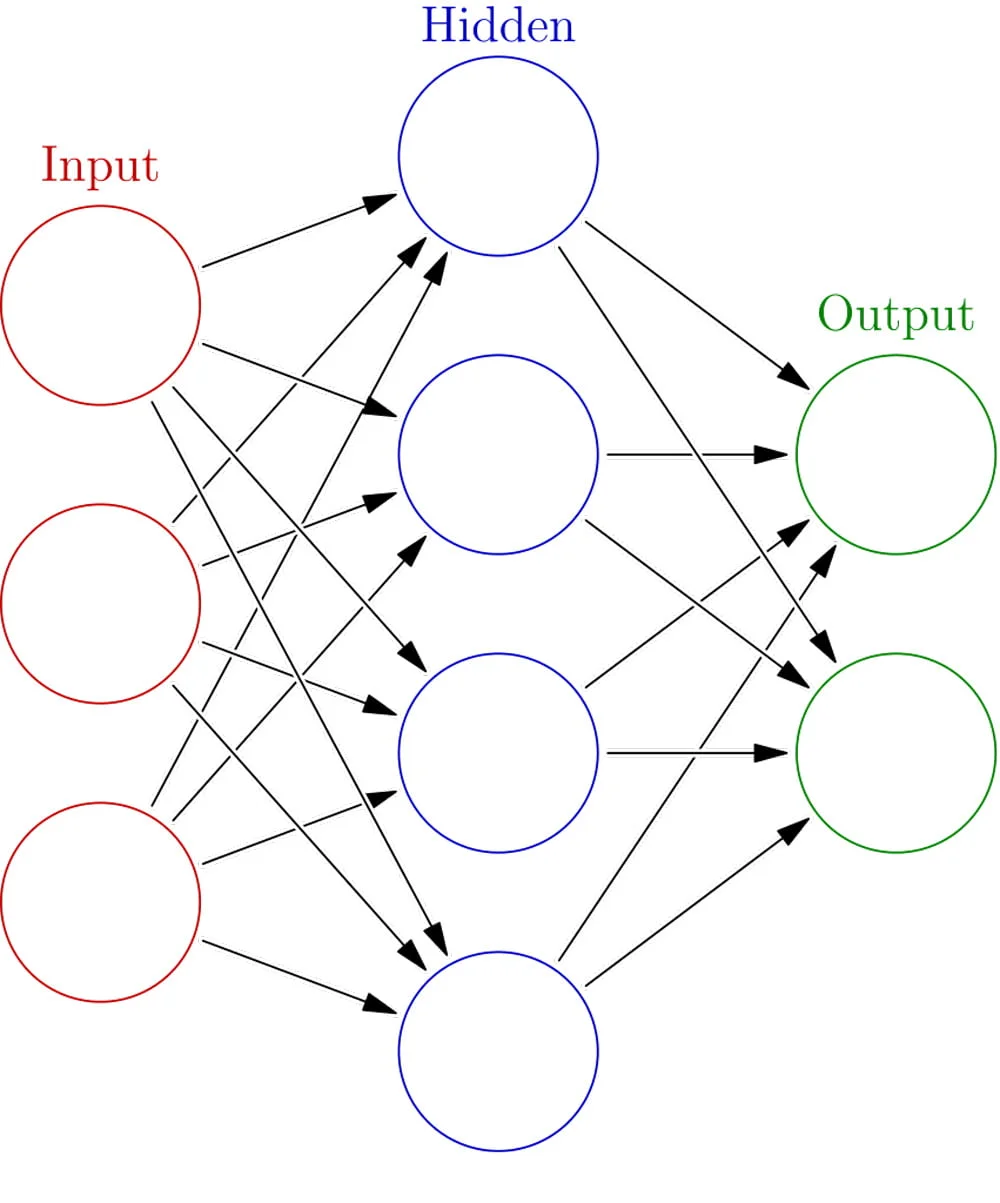

Künstliche neuronale Netze sind von einem rudimentären Bild des menschlichen Gehirns inspiriert: Ein Algorithmus schafft verschiedene Schichten verbundener Neuronen oder Knotenpunkte, die Informationen untereinander austauschen. Ihre mathematischen Anfänge haben die neuronalen Netze im Jahr 1943.

Die Architektur besteht im einfachsten Fall aus einer Input-Schicht, einer mittleren, versteckten Schicht (Hidden Layer) und einer Output-Schicht. Das Input-Signal wird durch die anfangs zufällig generierten Werte der mittleren Neuronen modifiziert und an die Output-Schicht weitergegeben.

Der Output kann nun mit dem Input verglichen werden – war die Vorhersage richtig oder nicht? Anhand des Ergebnisses werden die Werte der mittleren Neuronen modifiziert und der Vorgang wird mit einem neuen Input wiederholt. Durch viele Wiederholungen wird die Vorhersage immer präziser.

Kurz gesagt: Neuronale Netze sind Algorithmen, die sich selbst optimieren.

Mehr Details gibt es in unserer Erklärung, wie künstliche neuronale Netze funktionieren.

Tiefes Lernen / Deep Learning

Tiefes Lernen oder Deep Learning ist Maschinelles Lernen mit Neuronalen Netzen mit mehr als einer versteckten Schicht (Hidden Layer).

Diese komplexen neuronalen Netze traten ihren Siegeszug spätestens 2012 an, als ein solches Netzwerk den ImageNet-Wettbewerb für Bildanalyse haushoch gewann.

Tiefes Lernen ist verantwortlich für den KI-Boom der letzten Jahre, insbesondere bei der Bilderkennung, dem autonomen Fahren oder für Deepfakes.

Der Durchbruch von Deep Learning wird möglich durch immer schnellere Prozessoren und dedizierte KI-Chips wie Googles TPU sowie riesige Datenmengen, die für das Training der Maschine eingesetzt werden.

Generative Adversarial Network (GAN)

GANs bestehen aus zwei neuronalen Netzen (Agenten), die sich gegenseitig verbessern. Beide werden mit einem gemeinsamen Datensatz, etwa Fotos, trainiert.

Ein Agent erstellt dem Datensatz ähnliche Inhalte, der andere gleicht diese mit dem ursprünglichen Datensatz ab. Erkennt er sie als Fälschung, zwingt das den Fälscher-Agenten, seinen Inhalt zu verbessern - bis er so aussieht als gehöre er zum Trainingsdatensatz.

4.5 years of GAN progress on face generation. https://t.co/kiQkuYULMC https://t.co/S4aBsU536b https://t.co/8di6K6BxVC https://t.co/UEFhewds2M https://t.co/s6hKQz9gLz pic.twitter.com/F9Dkcfrq8l

— Ian Goodfellow (@goodfellow_ian) 15. Januar 2019

In 4,5 Jahren sind die GAN-KIs immer besser darin geworden, menschliche Porträts zu generieren.

Mit genug Wiederholungen entsteht ein Meisterfälscher: GANs erzeugen täuschend echte Menschen, Deepfakes, Straßenzüge oder Fake-Models. Sie dichten, musizieren und erschaffen teure Kunstwerke, machen aus Retro-Games HD-Versionen. Seit ihrer Einführung 2014 sind sie stetig besser geworden.

Blackbox & Erklärbare Künstliche Intelligenz

Maschinelles Lernen hat einen zentralen Nachteil: Wie genau die KI zu ihrem Ergebnis gelangt, ist häufig nicht nachvollziehbar. Die tiefen neuronalen Netze sind so komplex, dass unklar ist, welche Rolle einzelne Schichten und Neuronen im Verarbeitungsprozess der KI spielen.

KI-Systeme werden daher häufig als Blackbox bezeichnet: Ein schwarzer, undurchsichtiger Kasten, der zwischen Ein- und Ausgabe liegt.

Forscher im Forschungszweig "Erklärbare KI" versuchen, in diese Blackbox hineinzuschauen. Sie wollen komplette KI-Systeme, oder zumindest einzelne Ergebnisse, für Menschen nachvollziehbar machen.

Tech-Unternehmen wie Microsoft, IBM, Google oder Facebook entwickeln ebenfalls Software-Werkzeuge, die Licht bringen sollen in die Komplexität künstlicher neuronaler Netze. Der KI-Forscher Iyad Rawhan fordert gleich eine neue Disziplin, die das Verhalten intelligenter Maschinen erforscht.

KI-Training: So wird Künstliche Intelligenz trainiert

Das Training gehört zu Künstlicher Intelligenz wie Platzhalter in mathematische Formeln. Doch wie gelernt und trainiert wird, hängt ganz von der KI ab. Ich stelle euch einige Lernmethoden vor, die im KI-Training eingesetzt werden.

Überwachtes Lernen / Supervised Learning

Beim überwachten Lernen wird die KI in dem Sinne überwacht, dass ihre Trainingsdaten vorbereitet werden. Ein Beispiel: Soll eine KI Objekte auf Fotos erkennen, werden vor dem Training alle Katzen, Autos, Bäume usw. auf den Trainingsfotos markiert.

Dieser Markierungsprozess ("labeln") ist zeitaufwendig, aber die Grundlage für erfolgreiches überwachtes Training – die KI weiß dank der intensiven menschlichen Vorarbeit, nach welchen Mustern sie suchen soll.

Überwachtes Lernen steckt hinter einem Großteil aktuell breit eingesetzter KIs, zum Beispiel für das autonome Fahren, die Gesichtserkennung oder die Online-Suche. Die Labels werden oft von Niedriglohnarbeitern gesetzt, in den letzten Jahren ist daraus eine weltweite Industrie geworden.

Unüberwachtes oder selbstüberwachtes Lernen / Unsupervised Learning

Unüberwachtes Lernen ist der Hoffnungsträger der KI-Forschung. Denn im Gegensatz zum überwachten Lernen werden Daten nicht aufwendig vorbereitet: Die KI bekommt große Datenmengen ohne Labels und sucht eigenständig nach Mustern in den Daten.

Die Methode hat zwei Vorteile: Erstens sind gut aufbereitete, umfangreiche Datensätze selten. Zweitens kann eine KI so Zusammenhänge in Daten aufdecken, die Menschen verborgen bleiben.

In den Worten des KI-Forschers Yann LeCun klingt das so: "Wenn Intelligenz ein Kuchen ist, ist der Großteil des Kuchens unüberwachtes Lernen, das Sahnehäubchen ist überwachtes Lernen und die Kirsche ist bestärkendes Lernen."

Mittlerweile hat sich auch der Begriff des selbstüberwachten Lernens (Self-Supervised Learning) verbreitet. Je nach Auffassung ist das eine besondere Variante des unüberwachten Lernens oder ein Synonym. LeCun hat bereits verkündet, er würde fortan nur noch vom selbst- statt vom unüberwachten Lernen sprechen.

Beim selbstüberwachten Lernen wird häufig ein Teil der Trainingsdaten zurückgehalten und die KI muss diese vorhersagen, etwa das nächste Wort in einem Satz. Dadurch wird sie gezwungen, wichtige Details über die Daten zu lernen wie semantische Repräsentationen.

Selbstüberwachtes Lernen wird beispielsweise für KI-Skalierung benutzt und ermöglichte die großen Fortschritte von Sprach-KIs in den letzten 1,5 Jahre. OpenAI setzt die Lernmethode für den mächtigen GPT-2-Algorithmus ein. Und Microsoft hat damit die bisher größte Sprach-KI Turing-NLG trainiert.

Bestärkendes Lernen / Reinforcement Learning

Bestärkendes Lernen setzt auf Zuckerbrot und Peitsche: Immer, wenn die KI ihre Aufgabe erfolgreich ausführt, wird sie belohnt. Verfehlt sie ihr Ziel, bekommt sie entweder nichts oder wird bestraft.

OpenAI bringt mit bestärkendem Lernen KIs Verstecken spielen bei. | BILD: OpenAI

Mit dieser Versuch-und-Irrtum-Methode entwickelt sich die KI in vielen Bereichen durch Ausprobieren vom Anfänger zum Profi, etwa in Go und Schach, Dota 2, Starcraft 2 oder Poker. Alle jüngsten Erfolge setzen auf sogenanntes tiefes bestärkendes Lernen (Deep Reinforcement Learning), einer Kombination aus bestärkendem und tiefem Lernen.

Transferlernen / Transfer Learning

Als Transferlernen werden Trainingsmethoden bezeichnet, bei denen gelernte Fähigkeiten einer KI auf ein neues, aber verwandtes Problem angewandt werden. Ein Beispiel ist Googles Bilderkennungs-KI Inception, die von Forschern zur Erkennung von Lungenkrebs eingesetzt wird.

Auf lange Sicht könnte Transferlernen KIs weg von Inselbegabungen hin zu mehr Flexibilität führen. Die Erforschung des Transferlernens ist daher ein wichtiger Beitrag zu einer generellen Künstlichen Intelligenz.

Imitierendes Lernen / Imitation Learning

Imitierendes Lernen nutzt Demonstrationen als Trainingsmaterial für KIs. Das können etwa in Videospielen Aufzeichnungen menschlicher Spieler sein, die sich durch ein Game kämpfen, oder ein Roboter lernt, indem er menschliche Bewegungen beobachtet.

Ein Vorteil des imitierenden Lernens gegenüber bestärkendem Lernen ist die höhere Flexibilität: In manchen Umgebungen sind Belohnungen schwer zu definieren oder zu erreichen. Eine reine Versuch-und-Irrtum-Methode bringt die KI dann nicht weiter. Hier hilft die menschliche Demonstration, von der die KI den Weg lernen kann.

Few-Shot-Lernen / Few Shot Learning

Oft werden unzählige Beispiele benötigt, bis eine KI erfolgreich Muster in Daten erkennt. Sogenannte One-Shot- und Few-Shot-Lernmethoden helfen KIs, ähnlich wie der Mensch anhand weniger Beispiele oder sogar mit nur einem Beispiel eine neue Fähigkeit zu lernen.

Nvidias KI kann tanzen lassen, Mimik übertragen und Straßenaufnahmen generieren. Dafür braucht das Multitalent nur wenige Beispiele, etwa einige Fotos eines Nachrichtensprechers. | Video: Nvidia

In der Praxis könnten KIs so neue Aufgaben ohne umfangreiches Training lernen. Beispielsweise gelang es Samsung-Forschern mit wenigen Beispielen die Gesichter von Personen auszutauschen. Eine israelische Forschergruppe ging sogar noch einen Schritt weiter und entwickelte eine Methode für Echtzeit-Deepfakes ohne vorheriges Gesichtertraining.

Gegnerisches Lernen / Adversarial Learning

KI-Systeme sind häufig anfällig für Angriffe mit sogenannten „gegnerischen Beispielen“. Auf Bildanalyse spezialisierte KIs können etwa mit minimal manipulierten Bildern getäuscht werden. Häufig reicht dafür eine für das menschliche Auge unsichtbare geringe Pixelverschiebung oder eine Art Wasserzeichen. Visueller Schadcode, wenn man so will.

Eine KI erkennt dann statt einer Schildkröte ein Gewehr, ein T-Shirt mit speziellem Aufdruck schützt vor Gesichtserkennung oder ein autonomes Auto rast plötzlich los, weil es einen gefährlichen Sticker auf einem Straßenschild gescannt hat.

Das Forschungsfeld des gegnerischen Lernens versucht, KI-Systeme robuster gegenüber Pixel-Angriffen zu machen. Häufig werden die Systeme dafür mit den zuvor erwähnten schädlichen gegnerischen Beispielen trainiert. So lernen sie, nicht auf sie hereinzufallen.

Natürlich stellt sich hier wie in vielen anderen Szenarien der Cybersecurity das bekannte Katz-und-Maus-Spiel ein: Ist eine Sicherheitslücke gestopft, wird eine neue aufgerissen.

Was ist der Turing-Test und welche Rolle spielt er in der KI-Forschung?

Um die oft vage Definition von Intelligenz und maschinellem Denken greifbarer zu machen, entwickelte der britische Mathematiker Alan Turing 1950 die Idee eines Tests, den er ursprünglich "imitation game" nannte. Der Test sollte Aufschluss darüber geben, ob ein Computer, also eine Maschine, menschenähnliche Intelligenz besitzt. Durch ein Frage- und Antwortspiel zwischen Mensch und Computer sollte also deutlich werden, ob sich der Computer von einem menschlichen Gesprächspartner unterscheidet.

Das Gespräch wurde in Textform geführt; die Aussprache spielte keine Rolle. Im Rahmen des Testablaufs sollte eine Person, die zuvor darüber informiert worden war, dass es sich bei einem der Teilnehmer:innen um eine Maschine handelte, diese unter den beiden Gesprächspartner:innen identifizieren. War diese Unterscheidung nicht möglich, konnte der Maschine bzw. dem Computer „künstliche Intelligenz“ attestiert werden.

Innerhalb der KI-Forschung spielt das Testen kaum eine Rolle, da KI in der Regel weniger auf menschliche Kommunikation als auf die effiziente Lösung hochspezialisierter technischer Aufgaben abzielt.

Der Gedanke des Tests lebt jedoch weiter und spielt beispielsweise gerade bei der öffentlichen Bewertung von generativen KI-Systemen wie ChatGPT eine große Rolle - in vielen Fällen könnten die meisten Menschen den Chatbot von OpenAI bereits für einen menschlichen Gesprächspartner halten.

Dies zeigt im Umkehrschluss auch, warum der Test umstritten ist: Viele sehen ihn eher als Test der Täuschungsfähigkeit und nicht als Indikator für echte Intelligenz.

KI-Geschichte: Wie hat sich künstliche Intelligenz entwickelt?

Schon in der Antike rankten sich Geschichten, Mythen und Gerüchte um künstliche Lebewesen, die von Handwerksmeistern mit Intelligenz und Bewusstsein ausgestattet wurden. Auch später, in der Renaissance und hierzulande vor allem in Goethes Faust II, findet sich die Vorstellung von alchemistisch hergestellten künstlichen Menschen. Ab dem 19. Jahrhundert wurden die Vorstellungen von solchen Menschen in der Literatur ausführlicher behandelt, zum Beispiel in Mary Shelleys Roman Frankenstein von 1818.

Angetrieben durch die industrielle Revolution, die damit verbundenen Ohnmachtsängste und das wirtschaftliche Tief der Großen Depression zwischen 1873 und 1896 erlangte die Idee künstlich intelligenter Roboter durch zahlreiche literarische und filmische Science-Fiction-Schöpfungen um die Jahrhundertwende weite Verbreitung. Den Anfang machte 1900 der herzlose Tin Woodman im Zauberer von Oz, der sinnbildlich für den durch die Industrialisierung in Maschinen verwandelten Menschen steht. Auch die Figur des humanoiden Roboters Maria im Science-Fiction-Drama Metropolis (1927) verkörperte die Idee der Mensch-Maschine, eines „mechanischen Sklaven“ ohne Bewusstsein.

In der ersten Hälfte des 20. Jahrhunderts verfestigte sich das Verständnis von KI als kulturelle Idee in den Köpfen von Wissenschaftler:innen, Mathematiker:innen und Philosoph:innen. Die moderne KI hat ihren Ursprung in den klassischen kulturphilosophischen Ansätzen, die versuchten, den menschlichen Denkprozess als mechanische Manipulation von Symbolen zu beschreiben. Dies führte in den 1940er Jahren zur Erfindung der ersten programmierbaren digitalen Computer, die nach mathematisch-abstrakten Methoden schlussfolgern und rechnen konnten. Von hier aus war es nicht mehr weit bis zur Idee eines autonomen elektronischen Gehirns.

Wann wurde Künstliche Intelligenz erfunden?

Im Jahr 1950 veröffentlichte der britische Mathematiker Alan Turing in der philosophischen Zeitschrift Mind ein bahnbrechendes Grundlagenpapier mit dem Titel Computing Machinery and Intelligence. In diesem viel beachteten Aufsatz wagte Turing die philosophische Spekulation, ob Maschinen denken können, und warf damit die Frage nach der mathematischen Programmierbarkeit künstlicher Intelligenz auf. Wenn Menschen mit Hilfe kognitiver Fähigkeiten auf der Basis verfügbarer Informationen Aufgaben lösen und vernunftgeleitete Entscheidungen treffen können, müssten dann nicht eines Tages auch Maschinen dazu in der Lage sein?

Bis zur Umsetzung von Turings Ideen sollten jedoch noch einige Jahre vergehen – und unter Expert:innen ist umstritten, inwieweit Turing-Maschinen und Turing-Tests wirklich für die historische Entwicklung von KI relevant sind.

So oder so: Die technischen Grenzen der damaligen Computer, die bis 1949 nur Befehle ausführen, aber keine Daten langfristig speichern konnten, standen weiteren Fortschritten im Weg. Zudem war die neue Computertechnologie ein sehr kostspieliges Geschäft: Anfang der 50er Jahre kostete ein Rechner bis zu 200.000 Dollar im Monat - ein Luxus, den sich nur wenige florierende Universitäten und Großunternehmen mit hohen Ansprüchen leisten konnten.

Als eigentliche Geburtsstunde des Forschungsgebietes Künstliche Intelligenz gilt allgemein der Workshop Dartmouth Summer Research Project on Artificial Intelligence, der 1956 am Dartmouth College in Hanover, New Hampshire, stattfand. Hier kamen führende Forscher:innen und Expert:innen über mehrere Wochen vor allem zum Zweck des Brainstormings über KI-bezogene Themen zusammen. Im Rahmen des Workshops wurde auch zum ersten Mal ein umfangreiches Programm namens Logic Theorist vorgestellt, das die menschliche Herangehensweise an Problemlösungen nachahmen sollte.

John McCarthy, einer der Hauptinitiatoren des Workshops und Professor in Dartmouth, prägte den Namen für die neue akademische Disziplin der „denkenden Maschinen“: Artificial Intelligence. Mit dieser historischen Konferenz war der Weg für die KI-Mission geebnet und ein erster erfolgreicher Schritt mit den bedeutsamsten Forscher:innen auf diesem Gebiet getan.

Zwei Jahre nach dem Workshop, 1958, realisierte Frank Rosenblatt die erste maschinelle Umsetzung des 1943 von McCulloch und Pitts erfundenen Perceptrons, das erste – wenn auch einschichtige – neuronale Netzwerk für überwachtes Lernen.

Optimismus und erster KI-Winter

In den folgenden zwei Jahrzehnten folgten bahnbrechende Innovationen, die zuvor kaum jemand für möglich gehalten hätte. Computer wurden schneller, erschwinglicher und konnten mehr Informationen speichern. Auch die verwendeten Algorithmen wurden effizienter und konnten professioneller an die jeweilige Aufgabe angepasst werden.

Erste vielversprechende Projekte wie der General Problem Solver - eine universelle Problemlösungsmaschine - und ELIZA - ein Computerprogramm zur Spracherkennung - führten dazu, dass amerikanische Regierungsinstitutionen wie die DARPA (Defense Advanced Research Projects Agency) ab 1963 ihre Mittel für die KI-Forschung deutlich aufstockten. So konnte bereits 1969 der erste mobile Mehrzweckroboter namens Shakey the Robot das Licht der Welt erblicken.

Mit der Unterstützung führender Forscher:innen, von denen viele bereits am Gründungsworkshop in Dartmouth teilgenommen hatten, gingen optimistische Prognosen einher, dass Maschinen bald jede menschliche Arbeit übernehmen würden, dass das Problem der künstlichen Intelligenz in naher Zukunft vollständig gelöst und eine KI mit der Intelligenz eines durchschnittlichen Menschen geschaffen sein würde.

Doch der tatsächliche Fortschritt blieb hinter diesen Versprechungen zurück. Die vielversprechende Zukunftstechnologie entpuppte sich als heiße Luft - zu starr und undynamisch waren ihre Möglichkeiten, zu gering die Rechenleistung und Speicherkapazität.

1969 bewiesen die KI-Pioniere Marvin Minsky und Seymour Papert, dass einschichtige Perceptrons keine XOR-Funktionen lernen können. Obwohl beide wussten, dass mehrschichtige neuronale Netze diese wichtige Funktion lernen können, führte ihr einflussreiches Buch dazu, dass das Interesse an neuronalen Netzen und deren Förderung stark nachließ.

Die kritischen Stimmen wurden lauter, die finanzielle Unterstützung schwand. So kam es Mitte der 70er Jahre zum ersten KI-Winter, der bis in die 80er Jahre andauern sollte.

Erneuter Aufschwung und zweiter KI-Winter

Die Wiederbelebung der KI-Forschung setzte ab 1980 mit der Erweiterung der algorithmischen Möglichkeiten und einer revolutionären Neuorientierung der Technologie ein, die zu einer erneuten umfangreichen Förderung praxisnaher Projekte führte. Sogenannte Expertensysteme, die den Entscheidungsprozess menschlicher Expert:innen simulieren sollten, fanden weltweit Einsatz in der Industrie und brachten der Künstlichen Intelligenz erstmals den Ruf tatsächlicher Nützlichkeit ein. Selbstlernende Systeme auf der Basis künstlicher neuronaler Netze wurden immer populärer und legten den Grundstein für das heute weit verbreitete Deep Learning.

Von 1982 bis 1990 wurden Expertensysteme und andere KI-Projekte im Rahmen der Initiative "Fifth Generation Computer Systems" auch in Japan stark gefördert, mit dem Ziel, die Rechenleistung, die logische Programmierung und die künstliche Intelligenz zu revolutionieren. Angeregt durch die ehrgeizigen Ziele zogen viele Länder mit ähnlichen Projekten nach. Obwohl die meisten ehrgeizigen Ziele nicht erreicht wurden, erregte das Gebiet breite Aufmerksamkeit und trug sicherlich zur Popularität von IT- und Ingenieurstudiengängen bei der jüngeren Generation bei.

Unter dem Eis des zweiten, kürzeren KI-Winters von 1987 bis 1993 keimte jenseits von politischen Interessen und Hype-Schlagzeilen eine KI-Generation, die in den 1990er und 2000er Jahren - vor allem dank steigender Rechenleistung - viele der zuvor zu hoch gesteckten Ziele still und leise erreichte. Möglich wurde dies auch durch die präzise Fokussierung auf einzelne, konkrete Aufgaben anstelle der umfassenden Erwartungen an KI aus den 1960er Jahren.

Einige Beispiele sind etwa der Sieg von IBMs Expertensystem Deep Blue in 1997 über den bis dahin amtierenden Schachweltmeister Garry Kasparov mit Hilfe symbolischer KI. Deep Blue berechnete 200 Millionen mögliche Spielpositionen pro Sekunde. Zur gleichen Zeit entstanden die ersten professionellen Spracherkennungstechnologien für Windows, und der humanoide Roboter Kismet, der mit Menschen interagieren und Gefühle zeigen konnte, war ein wichtiges Experiment im Bereich der affektiven Datenverarbeitung. Im Jahr 2001 wurde der erste autonome Staubsaugerroboter, Trilobite von Electrolux, mit kommerziellem Erfolg produziert.

Bezeichnend für die kommende zentrale Rolle, die maschinelles Lernen in der kommenden Dekade einnehmen sollte, ist die von der DARPA veranstaltete Grand Challenge.

Der Wettbewerb für autonome Landfahrzeuge fand zwischen 2004 und 2007 dreimal statt. In der ersten Runde 2004 setzten die Teilnehmer auf die regelbasierten Systeme der ersten KI-Welle. Das Ergebnis: Kein Fahrzeug schaffte es weiter als zwölf Kilometer durch die Wüste.

Der Misserfolg führte zu einem Umdenken: Ein Jahr später fand der Wettbewerb erneut statt. Fünf Fahrzeuge fuhren die Strecke von 213 Kilometern durch – alle Gewinner setzten auf die zweite Welle KI-Technik: maschinelles Lernen.

"ImageNet-Moment" und eine Dekade Künstlicher Intelligenz

Die Anwendung fortgeschrittener mathematischer Methoden in Verbindung mit Erkenntnissen aus anderen Bereichen wie der Elektrotechnik, den Wirtschaftswissenschaften oder dem Operations Research verschaffte der KI Anfang der Neunzigerjahre erstmals den Ruf einer wissenschaftlich fundierten akademischen Disziplin. Als kurz darauf das maschinelle Lernen dank neuer Methoden, leistungsfähiger Computerhardware und Big Data in zahlreichen Anwendungen breite Anwendung fand, nahmen die Förderung und das Interesse an der künstlichen Intelligenz erneut zu. Die Erforschung von Deep-Learning-Verfahren trug schließlich ab 2010 zu einem anhaltenden Boom bei.

Es folgte ein Jahrzehnt, das zunehmend von Künstlicher Intelligenz - genauer: Deep Learning - geprägt war. Als zentral für diesen Siegeszug gilt der „ImageNet-Moment“: 2012 zeigten Forschende, dass neuronale Netze dank Deep Learning ältere Ansätze im Objekterkennungs-Benchmark ImageNet deutlich abhängen. Unternehmen wie Google investieren in den 2010er Jahren Milliarden US-Dollar in die Technologie und notwendige Hardware. 2014 kauft Google das britische KI-Unternehmen DeepMind.

Bis 2015 ist der Markt für KI-basierte Produkte, Hardware und Software auf acht Milliarden US-Dollar angewachsen. Big-Data-Anwendungen haben sich auf andere Bereiche ausgeweitet, z. B. auf Trainingsmodelle in der Ökologie und in der Wirtschaft. Die Forschung in den Bereichen Bild- und Videoverarbeitung, Textanalyse und Spracherkennung wurde stark durch Fortschritte im Bereich des tiefen Lernens vorangetrieben. Mit Hilfe von Deep Learning schlug Deepminds AlphaGo den amtierenden Go-Weltmeister Lee Sedol mit großem Vorsprung. Vor diesem sensationellen Sieg im Jahr 2016 galt das strategische Brettspiel aufgrund der Vielzahl möglicher Kombinationen lange Zeit als zu komplex für die Computerprogrammierung.

Einen umfassenden Überblick über den Aufstieg der KI bietet unser Rückblick auf die KI-Dekade 2010-2020.

KI-Zukunft: Wohin entwickelt sich Künstliche Intelligenz?

Die jüngsten Entwicklungen zeigen: Der Siegeszug der Künstlichen Intelligenz von einer unterfinanzierten akademischen Nischendisziplin, die weit hinter den anfänglichen Erwartungen zurückblieb, hin zu einem wichtigen Werkzeug sowohl für Unternehmen als auch für Politik und Gesellschaft ist längst vollzogen. Mit jeder Nachricht über neue technologische Durchbrüche und Errungenschaften, mit jeder Entdeckung neuer Anwendungsfelder und Methoden stellt sich jedoch immer auch die Frage nach dem Zukunftspotenzial einerseits und den Risiken und notwendigen ethischen Regulierungen von KI-Verfahren andererseits.

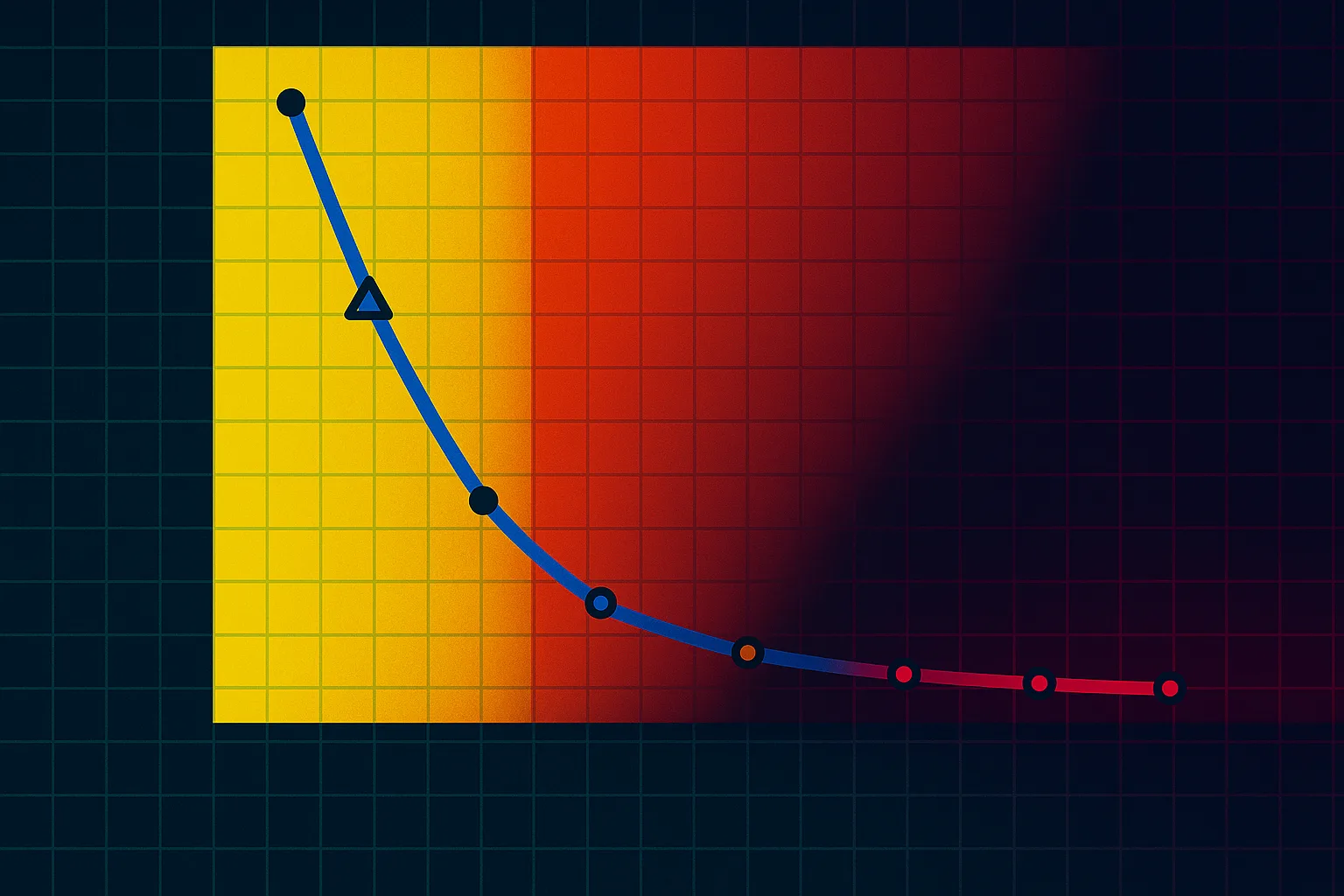

Die erfolgreiche Verbreitung und Etablierung von KI als Schlüsseltechnologie der Zukunft hängt im Wesentlichen von drei Faktoren ab: Von Art und Umfang der verwendeten Daten, vom Preis der Speicherkapazitäten sowie von der Rechenleistung. Je nach Geschwindigkeit und Zusammenspiel des Fortschritts in diesen Bereichen werden KI-Verfahren in immer komplexeren Prozessen und Systemen Anwendung finden. Bei optimaler gleichzeitiger Entwicklung in allen drei Bereichen kann sich dann das enorme Potenzial von KI-Systemen auf vielleicht unvorhergesehene Weise entfalten.

KI: Bereicherung für die Gesellschaft?

Eine wichtige Frage, die sich in diesem Zusammenhang stellt, ist die nach der Informationssicherheit: Inwieweit wird die Gesetzgebung auf die rasante Entwicklung mit adäquaten Richtlinien und Standards reagieren und in förderlicher Weise Schritt halten können? Hier gilt es, den rechtlich-technischen Rahmen so auszuloten, dass er einerseits einen ausreichenden Daten- und Personenschutz bietet, andererseits aber nicht zu eng gefasst ist, um positive Entwicklungen zu verhindern.

Ein wesentlicher Dreh- und Angelpunkt ist zudem ein ethischer und diversitysensibler KI-Rahmen - in Europa insbesondere durch EU-Regulierungen -, der wesentlich dazu beitragen kann, Vorurteile, Bias-Effekte und Risiken durch diskriminierende Algorithmen zu vermeiden und die Auswirkungen von KI-Technologien auf die Gesellschaft und insbesondere auf marginalisierte Gruppen möglichst gerecht und positiv zu gestalten. Denn nur wenn KI offen programmiert und verantwortungsvoll eingesetzt wird, kann sie im gesamtgesellschaftlichen Kontext tatsächlich dem Gemeinwohl dienen.

Ein sicherer Gebrauch von menschenzentrierten KI-Anwendungen ist zusätzlich gewährleistet, wenn deren Funktionsweisen nicht nur für Expert:innen, sondern auch für Nutzer:innen transparent gestaltet und nachvollziehbar sind. Denn die Entscheidungshoheit über die Anwendungen muss immer beim Menschen liegen und darf nicht einem vermeintlich autonomen System überlassen werden. Nur wenn der Gesamtprozess aus Datenerhebung, maschinellem Lernen und Arbeitspraxis vollständig in den Blick genommen wird, können Fehler zurückverfolgt und behoben werden.

Gleiczeitig muss der Missbrauch der lukrativen Technologie durch Cyber-Kriminelle verhindert und mögliche Überwachungs- und Manipulationsmechanismen intelligenter Systeme - insbesondere in totalitär regierten Staaten, bei Wahlkämpfen oder anderen politischen Konkurrenztaktiken - durch weitreichende internationale Vereinbarungen unterbunden werden. Bei entsprechender Förderung können Forschungsvorhaben mit sozialethischem Ansatz unterstützt werden, die der Gesellschaft insgesamt zugutekommen. Beispielsweise könnte maschinelles Lernen auf diese Weise strategisch für Klimaschutzmaßnahmen eingesetzt werden.

Welches Potenzial hat KI?

Eine positive Sicht auf die Zukunft der Künstlichen Intelligenz beleuchtet ihre Möglichkeiten vor allem in der industriellen Produktion, die neben mehr Effizienz in der Arbeitswelt auch Wachstum und neue Einkommensquellen mit sich bringen. So könnte laut einer im März 2022 veröffentlichten Statista-Studie allein der Markt für KI-Software bis 2025 im Vergleich zu 2019 jährlich um 54 % wachsen. Und laut einem Bericht des Unternehmensnetzwerks PwC könnten KI-Systeme bis 2030 einen Beitrag von rund 15,7 Billionen US-Dollar zur Weltwirtschaft leisten, wobei vor allem Nordamerika und China mit einem Anteil von zusammen fast 70 Prozent von diesem prognostizierten Entwicklungsboom profitieren würden.

Pessimistische Stimmen warnen vor bestehenden und zukünftigen Gefahren der KI-Technologie. Zu ersteren gehört die Reproduktion und Verstärkung bestehender oder neuer Ungerechtigkeiten, zu letzteren Szenarien existenzieller Bedrohung: Stephen Hawking etwa sieht die größte Gefahr darin, dass eine fortgeschrittene KI eines Tages die Menschheit wie einen Ameisenhaufen vernichten könnte. Da KI das Potenzial habe, sowohl zum Guten als auch zum Schlechten eingesetzt zu werden, sei es umso wichtiger, richtig mit ihr umzugehen, so Hawking. Auch Elon Musk sieht KI als fundamentale Bedrohung und warnt davor, dass KI die Menschheit vernichten könnte, wenn sie nicht proaktiv reguliert werde; ihre Kontrolle dürfe daher keinesfalls einigen wenigen Großkonzernen wie Facebook, Google oder Amazon überlassen werden.

Eines ist sicher: Wohin sich die Künstliche Intelligenz entwickeln wird, hängt entscheidend davon ab, was wir daraus machen. Ex-Google-Chef Eric Schmidt sieht sowohl positive als auch negative Auswirkungen von KI auf die Menschheit. Laut Schmidt ist KI in der Lage, das Verhalten und die Glaubenssysteme von Menschen zu verstehen und gezielt zu verändern. Daher sei es wichtig, sich so früh wie möglich mit den unbeabsichtigten Folgen von KI auseinanderzusetzen und stets die Interessen des Menschen in den Mittelpunkt der KI-Forschung zu stellen, damit KI ihr volles Potenzial zum Wohle der Menschheit entfalten könne.

Eine wesentliche Frage, die durch die Fortschritte im Bereich der Künstlichen Intelligenz aufgeworfen wird, betrifft den Menschen selbst: Wie wird sich der Mensch durch die immer intelligenter werdende Technik verändern? Denn wenn KI als unterstützende Assistentin des Menschen immer mehr von dessen Aufgaben übernimmt, verändern die vielfältigen Einsatzmöglichkeiten von KI nicht nur unseren Alltag, unsere Umwelt und unser Verhalten, sondern auch unser Selbstverständnis davon, was es bedeutet, Mensch zu sein.