- Die wichtigsten Entwicklungen zu synthetischen Medien und Deepfakes aus 2021 und 2022 ergänzt.

KI-gefälschte Bilder und Videos - sogenannte Deepfakes - haben sich in den letzten Jahren rasant entwickelt. Wir zeichnen die Historie nach und beschreiben die wichtigsten Meilensteine.

Was haben alle Personen im Titelbild gemeinsam? Sie existieren nicht. Eine KI hat sie sich ausgedacht. Genauer: Sie hat sie generiert am Beispiel Millionen ähnlicher Pixelstrukturen.

Erstellt habe ich die Bilder auf der Website thispersondoesnotexist.com. Das schafft jeder, der mit einer Maus klicken kann. Klappt auch für Katzen.

Möglich werden solche realistischen Fake-Porträts durch die Erfindung sogenannter "Generative Adversarial Networks" (GAN). Diese Netzwerke bestehen aus zwei KI-Agenten: Einer fälscht ein Bild, der andere versucht, die Fälschung zu erkennen. Fliegt die Fälschung auf, passt sich die Fälscher-KI an und wird besser.

So werden beide Agenten im Laufe des Trainings in ihrer jeweiligen Disziplin immer effizienter - und die generierten Bilder glaubwürdiger.

GAN ist nicht gleich GAN

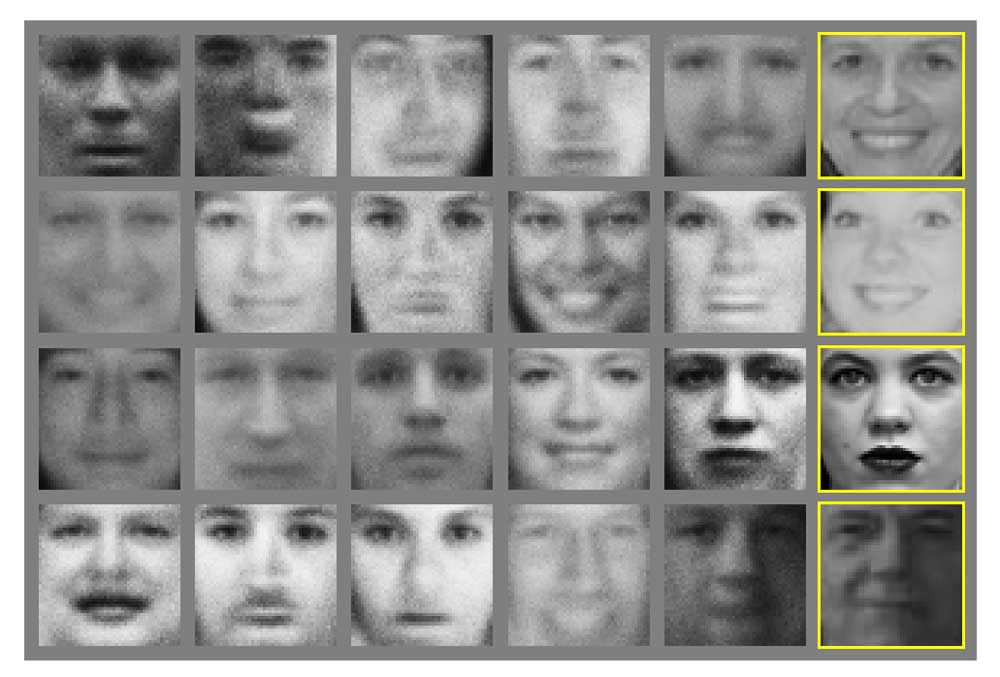

In der Praxis gibt es einen großen Unterschied zwischen den Ergebnissen des Ur-GANs und jenen aktueller GAN-Varianten.

Ein Twitter-Beitrag von Ian Goodfellow, seit kurzem KI-Chef bei Apple, zeigt die Entwicklung der letzten Jahre. Goodfellow gilt als Erfinder des ersten GAN-Verfahrens.

4.5 years of GAN progress on face generation. https://t.co/kiQkuYULMC https://t.co/S4aBsU536b https://t.co/8di6K6BxVC https://t.co/UEFhewds2M https://t.co/s6hKQz9gLz pic.twitter.com/F9Dkcfrq8l

— Ian Goodfellow (@goodfellow_ian) 15. Januar 2019

Eine kurze GAN-Geschichte

Ein Blick auf die von Goodfellow verlinkten wissenschaftlichen Arbeiten macht deutlich, wie neue KI-Architekturen in Kombination mit größeren Datenmengen und schnelleren Rechnern zur rasanten Entwicklung sogenannter Deepfakes führten.

2014: Die Geburtsstunde der Deepfake-Technologie

Goodfellow veröffentlicht mit Kollegen eine wissenschaftliche Arbeit, in der erstmals ein GAN vorgestellt wird. Es ist die Geburtsstunde der GAN-KIs und die technische Grundlage der Deepfakes, über die wir heute intensiv diskutieren.

2015: GANs werden besser

Forscher kombinieren GANs mit den für Bilderkennung optimierten, mehrschichtigen Konvolutionalen Neuronalen Netzwerken (CNN), die viele Daten parallel verarbeiten können und besonders gut auf Grafikkarten laufen. Sie ersetzen einfachere Netzwerke, die zuvor die GAN-Agenten antrieben. Die Ergebnisse werden glaubwürdiger.

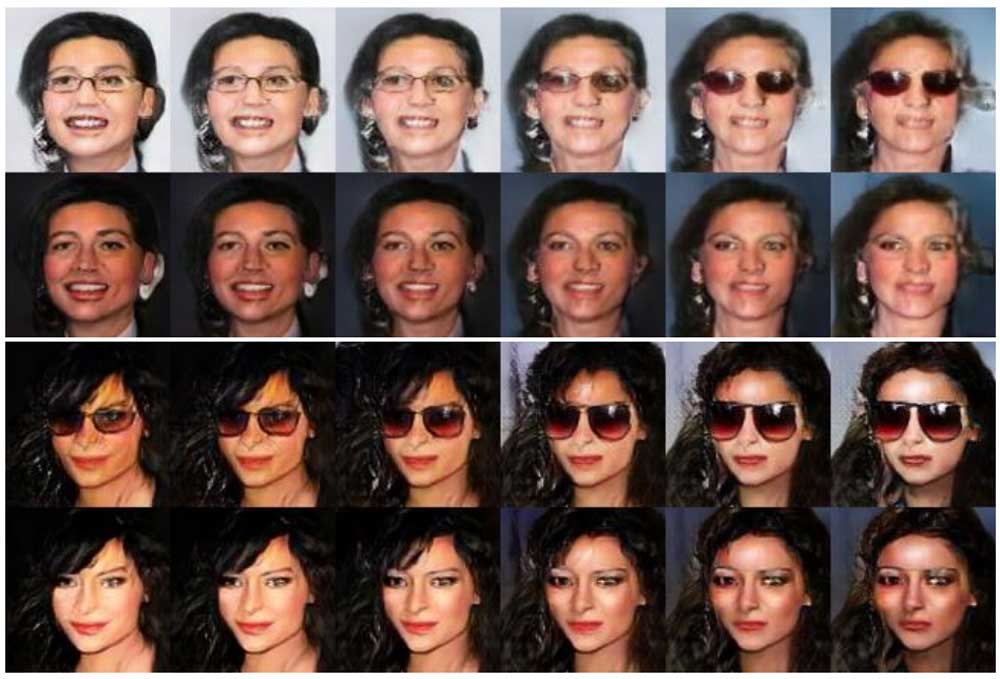

2016: Deepfake-Brille & Gesichtermanipulation

Forscher kombinieren zwei GANs: Die Agenten der verschiedenen Netzwerke teilen untereinander Informationen. So lernen sie parallel.

Die gelernten Daten werden von jedem Agenten leicht modifiziert. So ist es etwa möglich, eine Person mit und ohne Sonnenbrille zu generieren. Die Fake-Porträts werden erneut glaubwürdiger, aber sind noch immer eindeutig als Fälschung zu erkennen.

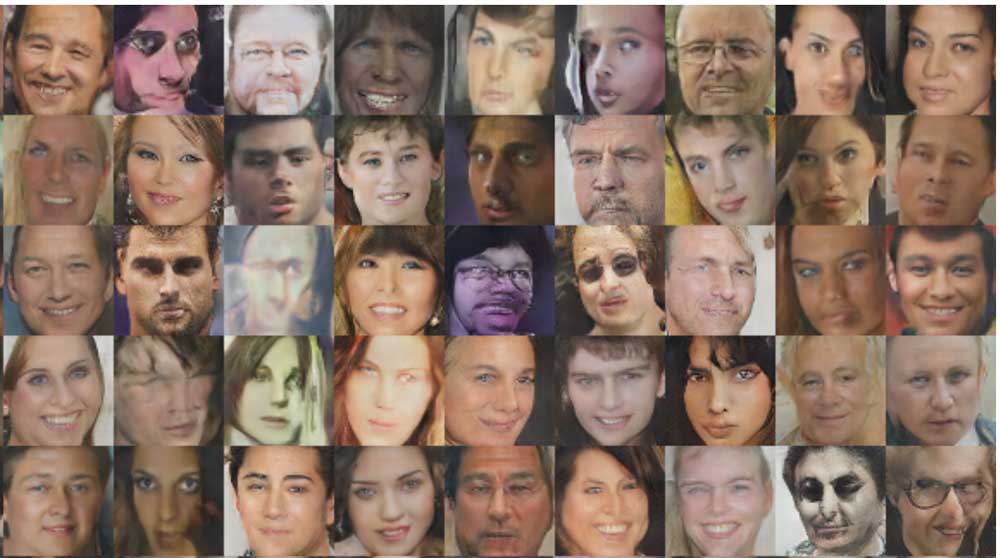

2017: Nvidias Qualitätssprung & die ersten Deepfake-Videos

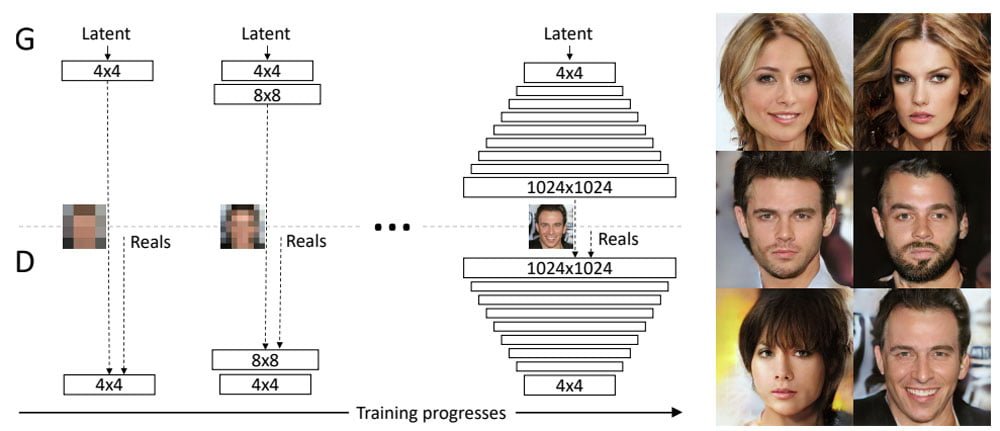

Nvidia-Forschern gelingt ein großer Qualitätssprung, indem sie ein wesentliches Problem bisheriger GANs lösen:

Die Generator-Agenten produzierten häufig Bilder mit geringer Auflösung, da diese vom Prüfer-Agenten schwerer als Fälschung zu entlarven sind - mehr Pixel bedeuten potenziell mehr Fehlerquellen. Es ergibt also Sinn für die Fälscher-KI, hohe Auflösungen zu vermeiden, um am Prüfer-Agenten vorbeizukommen.

Nvidias Lösung: Das Netzwerk wird stufenweise trainiert. Zunächst lernt die Fälscher-KI, niedrigauflösende Bilder zu erstellen. Dann wird die Auflösung schrittweise erhöht.

Das so stufenweise wachsende GAN produziert Fake-Porträts in bisher unbekannter Qualität: Die Bilder haben zwar noch Fehler, können aber Menschen, die nicht ganz genau hinschauen, durchaus übertölpeln.

Während Nvidia die eigenen GANs noch verbessert, bringt der Reddit-Nutzer "deepfakes" die Technologie in den Mainstream: Im Herbst 2017 tauchen die ersten nach ihm benannten Deepfake-Pornos auf, in denen die Gesichter von Pornodarstellerinnen mit denen prominenter Frauen ausgetauscht werden.

Die Bezeichnung Deepfake gilt seitdem synonym für KI-generierte Bilder und Videos. Das "Deep" bezieht sich auf die in vielen Schichten aufgebauten neuronalen Netze (Deep Learning), die bei der Bildgenerierung mitarbeiten.

Deepfake-Pornos sind zwar noch leicht als Fälschung zu erkennen, doch der Herstellungsaufwand ist so gering, dass sich bei Reddit und anderen Online-Plattformen innerhalb kurzer Zeit tausende Nutzer zusammenrotten, um explizite Videos zu erstellen.

Die bekannte US-Schauspielerin Scarlett Johansson, deren Gesicht besonders häufig für KI-Pornos missbraucht wurde, bezeichnete das Internet in diesem Kontext später als "dunkles Wurmloch".

2018: Mehr GAN-Kontrolle und Deepfake YouTube-Kanäle

Erneut Nvidia-Forschern gelingt es, ihr GAN besser zu steuern: Sie können einzelne Bildmerkmale gezielt vorgeben, bei Porträts zum Beispiel "dunkle Haare" und "Lächeln".

So lassen sich die Eigenschaften von Trainingsbildern gezielt auf KI-generierte Bilder übertragen. Der sogenannte Style-Transfer (siehe Video unten) wird ein wichtiger Bestandteil vieler folgender KI-Projekte.

Das GAN-Prinzip funktioniert natürlich nicht nur für Porträts: Der KI ist es völlig egal, welche Art von Pixelstruktur sie ausgibt. Sie benötigt nur entsprechende Trainingsdaten.

Ende 2018 zeigt Googles KI-Schwester Deepmind zum Beispiel KI-generierte Lebensmittel, Landschaften und Tiere, die beeindruckend glaubhaft aussehen.

Die Software Deep Video Portrait verbessert die Video-Manipulation mittels GANs und erste auf Deepfakes spezialisierte YouTube-Kanäle entstehen: Gefälscht werden längst nicht mehr nur Pornos, sondern alle Arten von Videos, zum Beispiel von Politikern oder großen Hollywood-Streifen. Erstmals wird diskutiert, dass KI-Verfahren schon verstorbene Schauspieler digital wiederbeleben könnten.

Und Deepfake-Pornos geht es an den Kragen: Im ersten Quartal 2018 bannen Pornhub, Twitter, Gfycat und Reddit die Fake-Pornos von ihren Plattformen. Die Webseite der vielgenutzten Deepfake-App geht offline.

2019: Deepfake kommt im Mainstream an

Samsung-Forscher stellen eine GAN-KI vor, die Mensch und Kunstwerk deepfaken kann. So zaubern die Forscher etwa Mona Lisa ein animiertes Lächeln ins Gesicht. Samsungs Deepfake-KI braucht nur eine Handvoll Fotos für ansehnliche Ergebnisse.

Einige Monate später stellen israelische Forscher Face Swapping GAN (FSGAN) vor, eine KI, die Gesichter in Live-Videos glaubhaft in Echtzeit austauscht. Die neue KI hat gelernt, jedes Gesicht direkt auszutauschen ohne vorheriges Einzeltraining. Sie erreicht jedoch noch nicht die Qualität aufwendig trainierter Deepfakes.

Abseits technischer Fortschritte ist 2019 das Jahr, in dem Deepfakes endgültig im Mainstream ankommen. Deepfake-Werkzeuge wie das erstmals 2018 erschienene DeepFaceLab beschleunigen die Deepfake-Produktion. Auf Deepfakes spezialisierte YouTube-Kanäle erreichen Millionen Zuschauer und die Anzahl an Deepfakes im Netz verdoppelt sich in den ersten neuen Monaten. Deepfakes entwickeln sich schneller als gedacht, sagt der Deepfake-Experte Hao Li und sagt voraus: „Deepfakes werden in zwei bis drei Jahren perfekt sein.“

Die rasante Ausbreitung der Fake-Videos beunruhigt angesichts der bevorstehenden US-Wahl 2020 die US-Politik. Mitglieder des US-Kongresses, des US-Geheimdienstausschusses sowie KI- und Rechtsexperten warnen vor einer Deepfake-Schwemme und fordern Regulierungen. Twitter ist die erste soziale Plattform, die neue Maßnahmen gegen Deepfakes vorstellt: Twitter will verdächtige Tweets markieren und Nutzern Warnhinweise anzeigen.

Auch außerhalb der USA nimmt die Politik Stellung: China stellt KI-Fakes unter Strafe und die Bundesregierung gibt eine Erklärung zur Technologie ab.

In der heißt es: "Deepfakes können das gesellschaftliche Vertrauen in die grundsätzliche Echtheit von Audio- und Videoaufnahmen und damit die Glaubwürdigkeit öffentlich verfügbarer Informationen schwächen." Sie könnten daher eine "große Gefahr für Gesellschaft und Politik darstellen." Allerdings dürfe das Risiko auch nicht überbewertet werden.

2020: Deepfake-Regulierung & Disneys Megapixel-Deepfakes

Facebook verkündet zum Beginn des US-Wahlkampfjahrs 2020, Deepfakes auf der eigenen Plattform zu verbieten – satirische oder parodistische Deepfakes ausgenommen. YouTube zieht mit vergleichbaren Richtlinien nach und Twitter beginnt, seine im Vorjahr vorgestellten Anti-Deepfake-Regeln durchzusetzen. Im August verbannt auch TikTok Deepfakes von der eigenen Video-Plattform.

Die Google-Schwester Jigsaw veröffentlicht mit „Assembler“ ein KI-gestütztes Werkzeug für Journalisten, das diese bei der Deepfake-Erkennung unterstützten soll. Qualcomm unterstützt ein Start-up, das Originalfotos und -videos schon bei der Erstellung unwiderruflich als Original markieren und so später die Deepfake-Identifikation vereinfachen soll.

Derweil geht die Entwicklung zu immer besseren Deepfakes weiter: Microsoft stellt FaceShifter vor, eine KI, die selbst aus unscharfen Originalgesichtern glaubwürdige Deepfakes generiert. FaceShifter setzt auf zwei Netzwerke.

Eines erstellt das gefälschte Gesicht und übernimmt für die Fälschung Kopfhaltung, Gesichtsausdruck, Beleuchtung, Farbe, Hintergrund und andere Attribute des Originalfotos. Das zweite Netzwerk HEAR-Net vergleicht das vom ersten Netzwerk generierte Foto mit dem Originalfoto.

Findet HEAR-Net etwa durch Haare, Sonnenbrille oder einen Schriftzug verdeckte Gesichtspartien, verbessert sie mögliche Fehler des ersten Netzwerks. Gesichter verschwinden wieder hinter Haaren, ein Schriftzug lässt sich entziffern und Make-up sitzt, wo es hingehört.

Der Unterhaltungsriese Disney beginnt mit der Entwicklung von Deepfakes für den großen Bildschirm und stellt den ersten Megapixel-Deepfake vor: Ganze 1.024 mal 1.024 Bildpunkte groß sind die Aufnahmen, die Disneys Deepfake-KI produziert.

Zum Veröffentlichungszeitpunkt des Disney-Patents schaffen Alternativen wie DeepFaceLab gerade mal 256 mal 256 Bildpunkte und selbst Anfang 2021 liegt die maximale Auflösung von DeepFaceLab 2.0 bei 448 mal 448 Pixeln.

Disneys Deepfake-Technik könnte langfristig traditionell verwendete Spezialeffektmethoden ersetzen, die oft Monate Arbeit für wenige Sekunden Filmmaterial benötigen.

Auf einen ersten Einsatz des Megapixel-Deepfakes warten Disney-Fans noch – der jüngste Auftritt eines legendären Star-Wars-Charakters in The Mandalorian musste noch ohne die Technologie auskommen. Eine verpasste Chance: Spätere YouTube-Deepfakes derselben Szene machten es besser als Disneys CGI-Künstler.

2021: Deepfake-Cruise, Live-Streams & Gesichtsverleih

Das Jahr beginnt mit einem besonders glaubwürdigen Tom-Cruise-Deepfake. Der Deepfaker "Deeptomcruise" lädt auf Tik-Tok Videos hoch, die nur noch bei genauem Hinschauen als Fakes erkennbar sind. Die viralen Videos bringen dem Kanal hunderttausende Follower und die Aufmerksamkeit des echten Tom Cruise - der legt einen verifizierten Kanal auf Tik-Tok an. Hinter Deeptomcruise verbirgt sich Visual-Effects-Spezialist Chris Umé, der an jedem Video laut eigener Aussage mehrere Wochen arbeitete.

Kurz nach den Cruise-Fakes erobert die App Wombo AI das Netz: Mit wenigen Klicks kann das Foto jeder Person in einen kurzen Videoclip verwandelt werden, in dem diese einen von zahlreichen bekannten Songs performt.

Als Grundlage für die Künstliche Intelligenz von Wombo AI dienen Videoaufnahmen realer Darsteller:innen, die mit passender Mimik einen der Songs einsingen. Die mit den Videodaten trainierte Wombo-KI überträgt diese Animationen dann auf jedes Foto, auf dem sie ein Gesicht erkennt.

This WOMBO AI is crazy lol pic.twitter.com/A7aVT4ISBN

— heyben10 (@HeyBen10_) March 10, 2021

Disney heuert einen bekannten Deepfake-YouTuber an und heizt so Gerüchte an, es könne in Zukunft mehr Deepfake-Charaktere etwa in Star Wars geben. Tatsächlich bestätigten sich diese Spekulationen mit der Ende 2021 veröffentlichten Serie Boba Fett.

Abseits von Disney schafft es Bruce Willis Gesicht in einen russischen Werbespot und ein Start-up kauft Lizenzrechte an realen Gesichtern, um diese dann per Deepfake-Technik in Marketing-Videos zu nutzen.

Nvidia veröffentlicht 2021 mit Alias-Free GAN eine verbesserte Version von StlyeGAN2, die konsistentere Ergebnisse bei Perspektivänderungen ermöglicht. Wenige Monate später wird eine optimierte Version unter dem Namen StyleGAN3 veröffentlicht.

Der Macher von DeepFaceLab zeigt 2021 außerdem das erste Mal DeepFaceLive: Das Programm kann nach einem entsprechenden Training oder mit mitgelieferten, vortrainierten KI-Modellen, Gesichter in Live-Videos austauschen. Für den Live-Austausch braucht es eine schnelle Grafikkarte, wie sie in aktuellen Gaming-PCs zu finden ist.

Ein junger Mann wird per Live-Deepfake zu einem Abbild von Margot Robbie. | Video: Github

2021 erreichen zudem sogenannte Diffusion Models das erste Mal die Bildqualität der bis dahin ungeschlagenen GANs. Die Technologie wird bisher nicht für Deepfakes verwendet, bildet aber die Grundlage für das Ende 2021 vorgestellte Bildgenerierungswerkzeug GLIDE von OpenAI.

2022: 3D-GANs, DALL-E 2 und ein Selenskyj-Deepfake

Direkt der Januar bringt gleich zwei beeindruckende GAN-Verbesserungen: KI-Forschende der Tel Aviv University zeigen eine Variante von StyleGAN2, die ohne zusätzliches Videotraining Gesichter in kurzen Videoclips manipulieren kann, etwa ein Lächeln hinzufügen oder einen Charakter verjüngen.

Video: Tzaban et al

Forschende von Nvidia und Stanford zeigen die Methode "Efficient Geometry-aware 3D Generative Adversarial Networks" (EG3D), die konsistent Bilder einer Person (oder Katze) aus verschiedenen Blickwinkeln und eine passende 3D-Rekonstruktion erzeugen kann.

Umgekehrt kann das 3D-GAN auch eine 3D-Rekonstruktion aus einem einzigen Bild einer echten Person generieren. EG3D kann so deutlich glaubwürdigere Fakes erzeugen, da die generierten Personen auch aus unterschiedlichen Blickwinkeln konsistent aussehen.

2022 finden Forschende des Stanford Internet Observatory in einer zweiwöchigen Studie mehr als 1000 mutmaßliche Fake-Profile im Karrierenetzwerk Linkedin. Mehr als 70 Unternehmen sollen die Fake-Profile als Angestellte gelistet und primär für den Erstkontakt potenzieller Neukunden genutzt haben. Bei gelungenem Erstkontakt wird die Person an einen echten Menschen weitergeleitet, der im Gesprächsverlauf auf das Fake-Profil referenziert.

Im Angriffskrieg gegen die Ukraine taucht ein womöglich historischer Deepfake auf: Eine Fake-Variante des ukrainischen Präsidenten Wolodymyr Selenskyj fordert sein Volk auf, die Waffen niederzulegen. Der Fake ist jedoch trotz niedriger Videoauflösung leicht zu erkennen und zeigt keine Wirkung. Ob es sich tatsächlich um einen Deepfake handelt, also um ein mit KI-Technik gefälschtes Video, ist nicht endgültig bewiesen. Viele Medien und zahlreiche Expert*innen gehen davon aus.

Im April 2022 zeigt OpenAI DALL-E 2. Das KI-System generiert aus Textbeschreibungen Bilder, soll im Sommer 2022 verfügbar sein und die Kunstszene ordentlich aufwirbeln.

Auch wenn DALL-E 2 und die zugrundeliegenden Diffusion Models nicht für Deepfakes genutzt werden und seitens OpenAI die Generierung von menschlichen Gesichtern vorerst verboten ist, wird die Technologie in Zukunft noch bessere synthetische Bilder ermöglichen.

Die KI-Fake-Dekade und der Umgang mit Deepfakes

Als der GAN-Erfinder Goodfellow 2014 seine Arbeit vorstellte, hat er die rasante Entwicklung KI-gefälschter Bilder wohl nicht vorhergesehen. Heute jedenfalls warnt er: Menschen dürften Bildern und Videos im Netz zukünftig nicht mehr wie selbstverständlich Glauben schenken.

Endgültig die Spielregeln ändern - gesellschaftlich und in der Unterhaltung - könnten Deepfakes, die als solche selbst für Anti-Deepfake-Algorithmen nicht mehr erkennbar sind. Deepfake-Experte Hao Li hält diese Entwicklung für möglich, da Bilder letztlich nichts anderes seien als passend eingefärbte Pixel - eine perfekte Kopie sei nur eine Frage der Zeit. Hinzu kommt, dass Deepfakes durch ihre rasante Verbreitung auf YouTube und durch Apps wie Reface oder Impressions alltäglich werden.

Die Menschheit sei in der Vergangenheit ohne Videos und Fotos ausgekommen, um sich zu informieren und sich eine Meinung zu bilden, so Goodfellow: "In diesem Fall verschließt Künstliche Intelligenz einige Türen, die unserer Generation für gewöhnlich offenstanden."