Möglicher Selenskyj-Deepfake: Miserabel und dennoch historisch

Update –

- Deepfake von Putin ergänzt

Update:

Der Twitter-Nutzer Serhii Sternenko hat ein Deepfake-Video des russischen Präsidenten Vladimir Putin veröffentlicht, in dem dieser die Kapitulation Russlands verkündet sowie eine Friedensvereinbarung mit der Ukraine. Russische Soldaten sollen nach Hause zurückkehren und ihre Waffen niederlegen.

Im Unterschied zum Selenskyj-Video handelt es sich hier eher um Satire als um einen gezielten Manipulationsversuch, da Sternenko den Deepfake in einem Anschluss-Tweet unmittelbar als Fälschung auflöst.

Президент РФ обьявил о капитуляции россии. Русский солдат, бросай оружие и иди домой, пока жив! pic.twitter.com/5wWC3UlpYr

— Serhii Sternenko (@sternenko) March 16, 2022

Das Fake-Video greift auf Originalmaterial einer Rede Putins vom 21. Februar 2022 zurück, in dem er vor seiner Invasion über die Situation in der Ukraine sprach. Für das Video wurde die Tonspur ausgetauscht und die Gesichtsanimationen angepasst.

Im Vergleich zum Selenskyj-Video ist es deutlich schwieriger als Fake zu entlarven, insbesondere aufgrund der geringen, aber für Social Media authentischen Videoauflösung.

Via: Reuters

Ursprünglicher Artikel vom 17. März 2022:

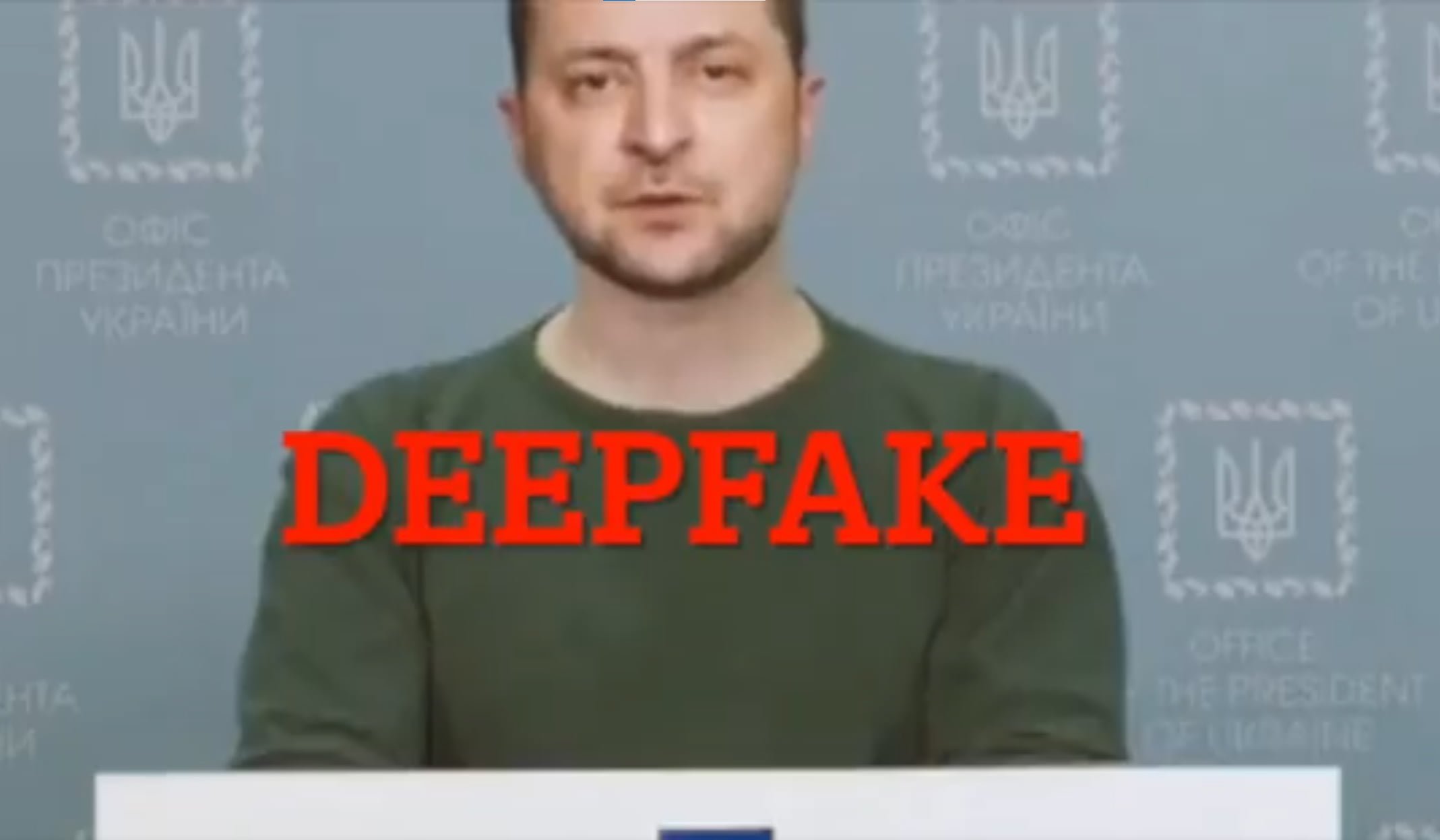

Möglicher Selenskyj-Deepfake: Miserabel und dennoch historisch

In einem Video fordert der ukrainische Präsident Wolodymyr Selenskyj sein Volk auf, die Waffen niederzulegen. Es könnte der erste Versuch sein, mittels Deepfake eine große politische Manipulation vorzunehmen.

Er müsse schwierige Entscheidungen treffen, sagt Fake-Selenskyj, aber das ukrainische Volk solle der Wahrheit ins Auge blicken: Die Verteidigung sei gescheitert, ein Morgen existiere nicht. Er trete von seinem Amt zurück und rate der Ukraine, die Waffen niederzulegen und zu ihren Familien zurückzukehren. "Ihr solltet in diesem Krieg nicht sterben", sagt Fake-Selenskyj.

Parallele Attacke über Nachrichtenseite und Social Media

Die Ersteller:innen des Fake-Videos hackten zunächst die Webseite des TV-Senders Ukraine24 und verbreiteten das Video über dessen Kanäle. Anschließend landete es in sozialen Netzwerken wie Twitter, Facebook und Instagram.

Eine ernsthafte Chance auf eine virale Verbreitung hatte es nicht: Der Fake ist schlecht gemacht. Selenskyj Kopf sieht aus wie am Hals angeklebt, die Beleuchtung von Gesicht und Körper ist auffällig unterschiedlich. Selbst Laien merken, dass hier etwas nicht stimmt.

Fake-Selenskyj soll zudem mit russischem Akzent sprechen, seine Stimme hat auch den typischen leicht halligen und abgehackten Klang einer maschinell generierten Stimme. Die Mimik hingegen überzeugt.

Video: via Mikael Thalen / Twitter

Der ukrainische Präsident reagierte prompt auf den plumpen Fake-Versuch und veröffentlichte ein kurzes Smartphone-Video mit einer Gegendarstellung über seine offiziellen Kanäle. Zudem bereitete die ukrainische Regierung Bürger:innen schon Anfang März auf mögliche Deepfake-Video-Attacken vor, in denen Selenskyj die Kapitulation vor dem russischen Militär verkünden könnte.

"Dies wird kein echtes Video sein, sondern durch maschinelle Lernalgorithmen erstellt. Videos, die mit solchen Technologien erstellt werden, sind kaum von echten Videos zu unterscheiden", warnte das ukrainische "Centre for Strategic Communications and Information Security" am 2. März bei Facebook.

Selenskyj-Video: Deepfake oder nicht?

Das Center for Security and Emerging Technology und Nathaniel Gleicher, verantwortlich für Sicherheitsrichtlinien bei Meta, bezeichnen Selenskyjs Video als Deepfake. Meta entfernte das Video von den eigenen Plattformen.

Mounir Ibrahim von der Videoauthentizitätsprüfungsfirma Truepic lässt vor einer eingehenden Prüfung offen, ob es sich bei dem Video um einen Deepfake, also ein mit KI-Technik gefälschtes Video handelt, oder um ein mit anderen Mitteln erstelltes Fake-Video. Sobald es hierzu einen Konsens gibt, aktualisiere ich den Artikel.

Sollte sich der Deepfake-Verdacht als korrekt erweisen, wäre das Selenskyj-Fake-Video trotz der schlechten Qualität historisch: Es wäre der erste dokumentierte Versuch, mittels Deepfake eine tiefgreifende politische Manipulation vorzunehmen. Forschende und Politiker:innen warnen seit Jahren vor diesem Gefahrenpotenzial.

Dass der Selenskyj-Fake ob seiner stümperhaften Umsetzung schnell entdeckt und gelöscht wurde und in Folge keinen Schaden anrichten konnte, sollte nicht als Entwarnung oder als Zeichen für die Resilienz sozialer Medien gegenüber Fake-Videos gewertet werden.

Demonstrationen von Technologieanbietern wie Nvidia zeigen, dass qualitativ hochwertige und kaum mehr als Fälschung erkennbare Deepfakes möglich sind, die eine gänzlich andere Wirkung entfalten dürten. Auch der Selenskyj-Fake ist nur einige Arbeitsstunden von einer deutlich besseren Qualität entfernt.

Aktuelle Studien kommen zu dem Ergebnis, dass sich Menschen von qualitativ besseren Deepfakes täuschen lassen, selbst wenn sie gezielt nach ihnen Ausschau halten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.