Deepfake-Test: Könnt ihr KI-Fakes erkennen?

Eine Deepfake-Studie untersucht, wie zuverlässig Menschen Fakes erkennen. So könnt ihr euch selbst testen.

Künstliche Intelligenz automatisiert und vereinfacht die Generierung von Fake-Texten, Fake-Audio und manipulierten Videos. Die dafür notwendigen Werkzeuge und Methoden sind leicht verfügbar und werden immer besser. Expert:innen warnen daher schon lange vor einem möglichen Missbrauch der Technologien auch für politische Beeinflussung.

Ob und wie eine solche Beeinflussung wirken könnte, hängt vorwiegend davon ab, ob Menschen in der Lage sind, KI-Fakes zu erkennen. Eine neue Studie untersucht nun, wie leicht unterschiedliche Modalitäten wie Video, Audio und Text Menschen täuschen können.

Fälschungs-Benchmark mit politischen Deepfakes

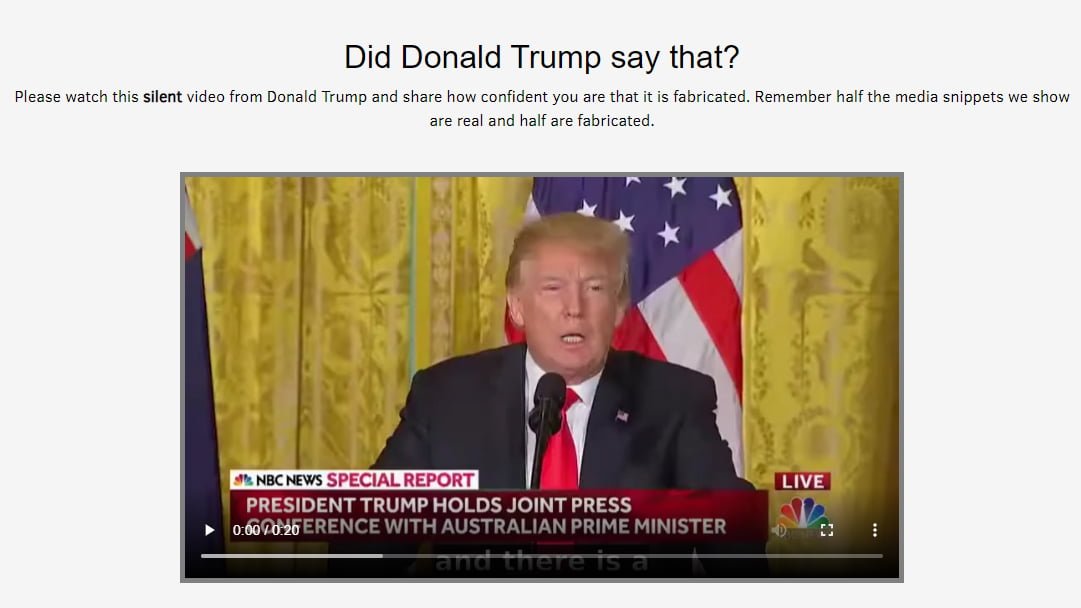

Für ihre Studie rekrutierten die KI-Forschenden des MIT knapp 500 Teilnehmer:innen, die auf einer Webseite die Authentizität von Video-, Audio- und Textauszügen von Donald Trump und Joe Biden bewerten sollten.

Zusätzlich besuchten mehr als 5000 Menschen die entsprechende Webseite und nahmen ebenfalls am Deepfake-Test teil. Alle Teilnehmenden wussten, dass die Hälfte der gezeigten Medien manipuliert wurde.

Die Inhalte stammen aus dem Presidential Deepfake Dataset und umfassen 32 Videos von Reden der beiden Politiker - eine Hälfte echt, die andere gefälscht. Die MIT-Forschenden modifizierten die Videos außerdem zusätzlich, reduzierten die Auflösung, tauschten Tonspuren oder Text aus.

Die rund 5700 Teilnehmenden gaben insgesamt 61792 Bewertungen über die Authentizität der Medien ab. Dabei verließen sie sich laut den Forschenden mehr darauf, wie etwas gesagt wurde, also die audiovisuellen Hinweise, als auf die Inhalte der Rede.

In Fällen, in denen die Inhalte jedoch deutlich der öffentlichen Wahrnehmung der Überzeugungen der Politiker widersprachen, sei das Vertrauen der Teilnehmenden in visuelle Hinweise gesunken.

Weniger komplexe Fakes sind die besseren Fakes

In der Studie zeigen sich zwei Trends: Erstens, je mehr Modalitäten (Audio, Video, Text) eine Fälschung hat, desto leichter erkennen Menschen sie als Fake. Und zweitens, die Technologie für Audio-Fakes reicht noch nicht an die für visuelle Deepfakes heran.

So erkannten die Teilnehmenden Fake-Texte schlechter als Fake-Videos mit Transkript oder Fake-Videos mit Audiospur. Fake-Audiospuren wurden zudem häufiger als Fälschung erkannt als Fake-Videos.

Ein kurzes Intro-Video bereitet Teilnehmende der Studie auf die Möglichkeiten der Deepfake-Technologie vor. | Video: MIT

Menschen könnten visuelle Unstimmigkeiten erkennen, die durch die Lippensynchronisation der Deepfake-Manipulationen entstehen, heißt es in der Arbeit. Allerdings liege die Genauigkeit bei solchen Videos ohne Audiospur nur bei 64 Prozent. Die Genauigkeit erhöhe sich bei Zugabe von Untertiteln auf 66 Prozent. Die Genauigkeit für Videos mit Text und Audio liege dagegen bei durchschnittlich 82 Prozent.

Laut der Forschenden umfasst die Bewertung generell Wahrnehmungshinweise aus Video und Audio sowie Überlegungen zum Inhalt, geprägt durch die Erwartungen, die die Teilnehmenden an den Sprecher haben. Bei der Bewertung des Inhalts allein - also bei reinem Text - liegt die Genauigkeit allerdings mit durchschnittlich 57 Prozent nur knapp über Zufall.

Deepfake-Detektion: Medienkompetenz als Lösung?

Ein Deepfake mit Audio wird also von einem großen Teil der Teilnehmenden erkannt - allerdings suchen diese im Rahmen des Experiments gezielt nach Fakes und wissen, dass die Hälfte aller Inhalte gefälscht sind.

Die Qualität der beim Experiment eingesetzten Audio- und Videofakes erreicht außerdem nicht die Qualität der aktuell besten Deepfakes. Die Zahlen könnten also in einem anderen Kontext - etwa auf einer Social-Media-Plattform und mit qualitativ hochwertigeren Videos - deutlich anders aussehen.

Die Forschenden schlagen daher Medienkompetenzprogramme vor, die reflektierendes Denken fördern sollen und Inhaltsmoderationssysteme, die Erklärungen bieten, um Menschen auf fragwürdige Inhalte und Hinweise wie Bildartefakte, semantische Fehler oder biometrische Merkmale aufmerksam zu machen.

Den Deepfake-Test könnt ihr auf der Detect-Fakes-Webseite des MIT ausprobieren.

Eine aktuelle Studie zur Glaubhaftigkeit von Deepfake-Porträts zeigt, dass Menschen KI-gefälschte Fotos und Originalfotos kaum auseinanderhalten können - selbst wenn sie wissen, dass sie nach Fälschungen suchen. Mehr noch: Sie schreiben den KI-generierten Gesichtern eine höhere Vertrauenswürdigkeit zu.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.