Update vom 10. Juli 2019:

Auch die Code-Plattform Github verbannt Deepnude aus dem eigenen Netzwerk. Diverse Versionen des Quellcodes wurden dort verbreitet. Deepnude verstoße gegen die eigene Regel, keine obszönen, sexuell konnotierten Inhalte zuzulassen, heißt es in der offiziellen Begründung.

Es wurden mehrere Deepnude-Seiten geschlossen, darunter eine der Deepnude-Entwickler selbst. Die luden den Code mit der Begründung hoch, dass der Code ein typisches KI-Problem auf interessante Weise löse und daher nützlich sei für Forscher und Entwickler in Bereichen wie Mode, Film und visuelle Effekte.

Via: Motherboard

Update vom 4. Juli 2019:

Die Entwickler mögen die Entwicklung und den Vertrieb der Deepnude-App eingestellt haben, aus dem Internet ist sie aber nicht mehr zu löschen:

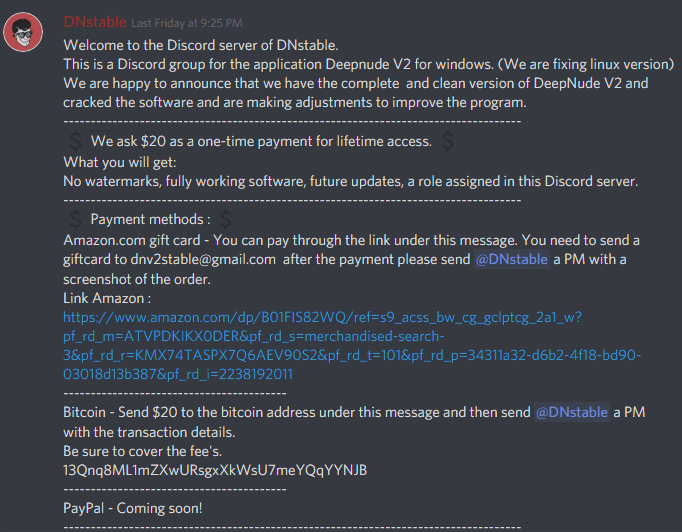

So hat der Gaming-Chat-Anbieter "Discord" kürzlich einen Chatraum geschlossen, in dem eine angeblich fortentwickelte und gecrackte Version der App für 20 US-Dollar verkauft wurde. In dieser Version soll auch das Wasserzeichen entfernt worden sein, das die Bilder als Deepfake-Fälschung markiert (via Motherboard).

Neben Discord soll die App auch in diversen Messengern, Foren und bei Github aufgetaucht sein (via The Verge).

Ursprünglicher Artikel vom 27. Juni 2019:

Körper satt Köpfe: Die KI-App DeepNude ersetzt angezogene Frauenkörper durch nackte. Die Entwickler stellen die App nach einem Medienbericht ein: Die Welt sei noch nicht reif für ihre Software.

Die Webseite Motherboard war es, die Ende 2017 erstmals auf Deepfakes aufmerksam machte: KI-gefälschte Pornovideos, in denen Köpfe der Pornodarstellerinnen durch jene von berühmten Frauen ersetzt wurden.

Zwar wurden einschlägige Communities bei Reddit und Co. schnell geschlossen, doch die Büchse der Pandora ist seitdem geöffnet - und das längst nicht mehr nur für Pornos.

Jetzt ist es erneut die Webseite Motherboard, die auf eine KI-App aufmerksam macht, die Bilder von Frauen gegen ihren Willen verändert: Sie heißt DeepNude und ersetzt auf einem Foto einen angezogenen Frauenkörper durch einen nackten.

Die Entwickler stellten die KI-Auszieh-App am 23. Juni für 100 US-Dollar ins Netz. Von Künstlicher Intelligenz muss man nichts verstehen, um sie zu verwenden: Die Benutzerobfläche ist so einfach zu handhaben wie bei anderen Smartphone-Apps. Rund 30 Sekunden dauert es, und hat man aus einer angezogenen Frau eine nackte gemacht. Für Männer funktioniert die App nicht: Das neuronale Netz ist auf Frauen trainiert.

Großes Interesse an KI-Nackt-Fakes

Kurz nach der Veröffentlichung des Motherboard-Berichts bricht der Server der DeepNude-Entwickler zusammen aufgrund des hohen Ansturms von Interessenten. Die Macher entschuldigen sich zu diesem Zeitpunkt noch und versprechen, zeitnah wieder online zu gehen mit einer stabilen Version der App.

Hi! DeepNude is offline. Why? Because we did not expect these visits and our servers need reinforcement. We are a small team. We need to fix some bugs and catch our breath. We are working to make DeepNude stable and working. We will be back online soon in a few days.

— deepnudeapp (@deepnudeapp) 27. Juni 2019

Wenige Stunden später folgt dann die Kehrtwende. Bei Twitter veröffentlichen die Entwickler einen Brief an die Welt: Geplant seien "ein paar Verkäufe im Monat" gewesen. Mit einem viralen Erfolg habe man nicht gerechnet. Durch die höheren Nutzerzahlen wachse allerdings auch das Risiko von Missbrauch.

Für eben diesen wollen die Entwickler allerdings keine Verantwortung übernehmen: Den Verkauf der App stellen sie daher mit sofortiger Wirkung wieder ein - wenige Tage nach dem Marktstart.

Zwar sei die Software bereits im Netz und würde sicher weiterverbreitet, schreiben die Entwickler. Aber "wir wollen nicht diejenigen sein, die sie verkaufen." Und weiter: "Die Welt ist noch nicht reif für DeepNude."

— deepnudeapp (@deepnudeapp) 27. Juni 2019