Nvidia veröffentlicht neue Generation Deepfake-Technologie

Nvidia veröffentlicht mit StyleGAN3 die neueste Generation des KI-Gesichtsgenerators. Sie vermeidet typische Artefakte bisheriger Deepfakes und sorgt so für noch glaubhaftere Gesichtsfälschungen – auch in Videos. Die Anwendungsszenarien gehen über generierte Gesichter hinaus.

Deepfake-Technologie hat in den sechs Jahren seit der ersten Veröffentlichung eines Gesichter generierenden Generative Adversarial Networks (GAN) rasante Fortschritte gemacht. So gelang es 2017 Nvidia-Forschern erstmals, hochauflösende Porträts von realistisch wirkenden Menschen zu erzeugen.

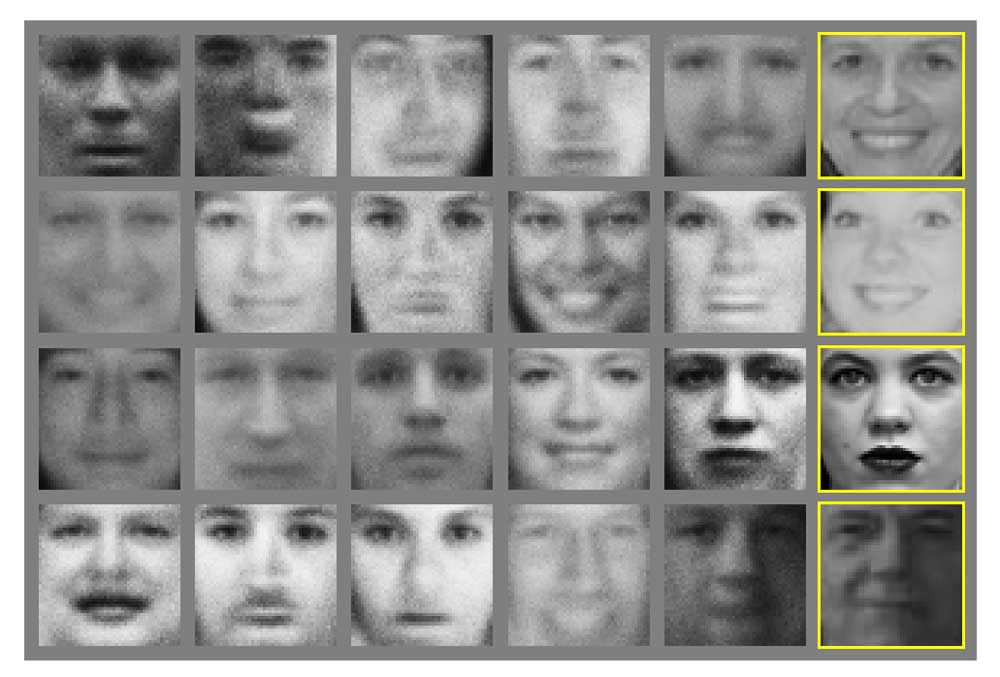

2018 veröffentlichte das Unternehmen basierend auf dieser Forschung dann StyleGAN als frei verfügbaren Open Source-Generator. 2019 folgte bereits die zweite Generation StyleGAN, die viele Bildfehler beseitigte und die Qualität der KI-generierten Bilder noch einmal signifikant erhöhte.

StyleGAN2 ist seitdem die Grundlage von zahlreichen Bildgenerierungsprojekten wie der Webseite thispersondoesnotexist.com, die täuschend echte Porträts erzeugt oder Systemen wie StyleGAN-NADA, die Bilder nach Texteingabe generieren. Wenn es so etwas wie eine Deepfake-Standard-Lösung für Gesichter gibt, dann ist es StyleGAN.

Nvidias Alias-Free GAN macht Fake-Bilder noch glaubwürdiger

Wie sieht die Zukunft von StyleGAN aus? Wenn es nach Nvidia geht, sollen GAN-basierte Systeme ihre Kreationen nachträglich weiter bearbeiten können. Ein künstlicher Kopf lässt sich nach der Generierung noch drehen, Frisuren werden ebenso angepasst wie der Gesichtsausdruck.

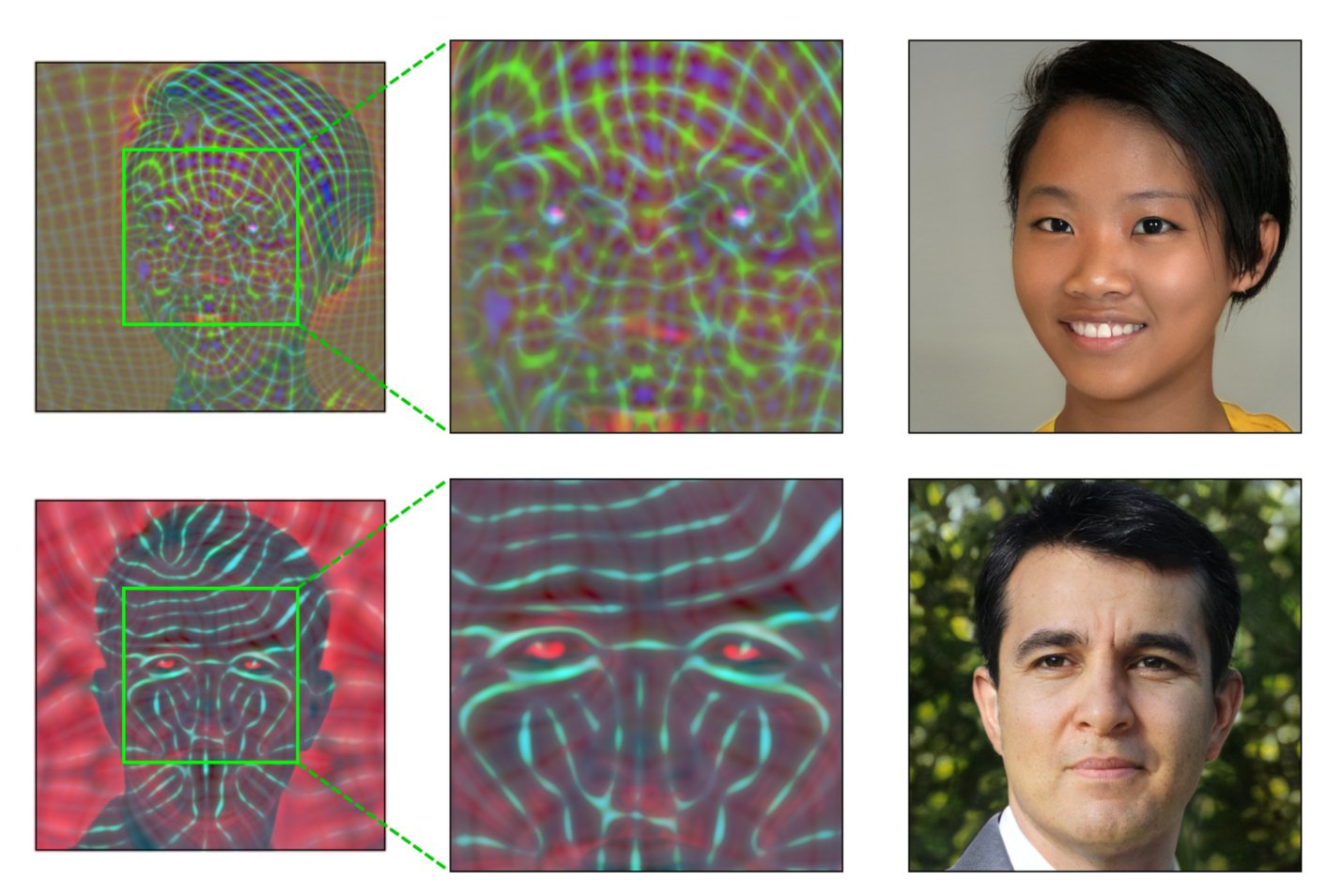

In StyleGAN2 orientieren sich feine Details wie Barthaare noch an Pixelkoordinaten statt an der Position des Gesichts. Das führt zu seltsamen Artefakten, die Nvidia mit Alias-Free GAN auflöst. | Video: Nvidia | Video: Nvidia

Die aktuelle Version von StyleGAN bietet solche Funktionen bereits in der Theorie, doch in der Praxis tauchen oft deutliche Artefakte auf. Im Juni 2021 zeigte Nvidia daher eine verbesserte Version von StyleGAN2: Alias-Free GAN beseitigt die Bildfehler und macht damit auch glaubwürdige KI-generierte Videoclips möglich. Die Fotoqualität steigt ebenfalls.

Aus Alias-Free wird StyleGAN3

Jetzt veröffentlicht Nvidia die optimierte Alias-Free-Variante unter dem Namen StyleGAN3. Als wesentliche Verbesserungen führt Nvidia die Alias-free Generator-Architektur und Trainingskonfiguration auf sowie Werkzeuge für die interaktive Visualisierung, Spektralanalyse und Videogenerierung. Nvidia will den Diskriminator des GANs weiter optimieren. Das könne womöglich verbleibende Artefakte wie Fehler an den Zähnen reduzieren.

Neben Gesichtern hat StyleGAN3 gelernt, etwa klassische Kamerafahrten am Strand zu generieren. In diesem Demo-Video laufen allerdings noch verschiedene Strandbilder in einer Kamerafahrt zusammen. | Video: Nvidia

StyleGAN3 reduziert außerdem den Speicherbedarf und erhöht die Geschwindigkeit beim KI-Training. Sieht man vom geringeren Speicherbedarf ab, ist StyleGAN3 jedoch rechenintensiver als das Vorgänger-Netz.

Die deutlich glaubwürdigeren Fotos und die Möglichkeit, mit StyleGAN3 Videos zu generieren, wird die Qualität von Deepfakes weiter verbessern und die Anwendungsszenarien erweitern. Nvidia schlägt daher ein von KI-Modellen eingefügtes Wasserzeichen sowie Authentizitätsprüfungen auf Social Media-Plattformen vor, um die zunehmende Verbreitung von Deepfakes transparenter und nachvollziehbarer zu gestalten.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.