Studie: Anzahl Deepfakes verdoppelt sich in neun Monaten

Mit KI-Technologie gefälschte Fake Videos, sogenannte Deepfakes, verbreiten sich zunehmend im Internet. Fast immer enthalten sie pornografische Inhalte, zeigt eine aktuelle Untersuchung.

Das auf Deepfakes-Erkennung spezialisierte Unternehmen Deeptrace hat die Verbreitung und den Inhalt von Deepfake-Videos untersucht: Gezählt wurden fast 15.000 im Internet öffentlich verfügbare Deepfakes. Im Dezember 2018 sollen es knapp 8.000 gewesen sein. Die Anzahl der Deepfakes hätte sich demnach in neun Monaten fast verdoppelt.

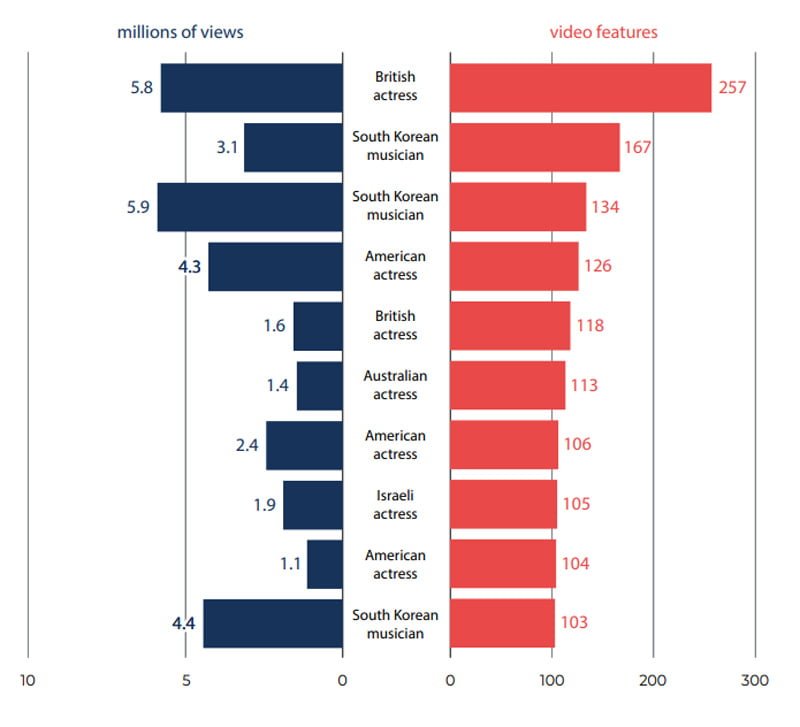

Rund 96 Prozent der entdeckten Deepfake-Videos zeigen pornografische Inhalte. Meist sind Schauspielerinnen aus England und den USA sowie K-Pop-Sängerinnen aus Südkorea Opfer der Fake-Pornos. Einschlägige Webseiten verzeichnen deutlich mehr als hundert Millionen Aufrufe. Acht der zehn populärsten Porno-Webseiten streamen Deepfake-Videos. Die Opfer sind in 100 Prozent aller Fälle Frauen.

Für die Analyse nutzte Deeptrace einen Mix aus manueller Suche und Web-Crawlern. Das Unternehmen verfolgte außerdem die Verbreitung bekannter Deepfakes bei Plattformen wie Reddit, 4chan, YouTube und auf bekannten Pornoseiten.

Deepfakes: Eine Gefahr besonders für Frauen

Pornos sind der Ursprung der Deepfake-Methode, die erstmals Ende 2017 bei Reddit auftauchte. Der namensgebende Reddit-Nutzer Deepfake tauschte die Köpfe berühmter Frauen mit denen von Pornodarstellerinnen aus, indem er ein auf Gesichtertausch spezialisiertes neuronales Netz mit Fotos der Prominenten trainierte.

Henry Ajder von Deeptrace findet, dass sich die Debatte über Deepfakes zu stark auf Manipulationen im Wahlkampf oder Cyber-Betrug fokussiere. Deepfake-Pornografie sei ein echtes, aktuelles Problem, das vielen Frauen Schaden zufüge.

Zu den ersten Deepfakes-Opfern gehörte die US-Schauspielerin Scarlett Johansson. Sie äußerte sich Anfang des Jahres zu den gefälschten Pornos: Sie fühle sich nicht direkt betroffen, da Zuschauer ohnehin von einer Fälschung ausgingen, sobald ihr Gesicht in einem Porno auftauche.

Sich rechtlich zu schützen, sei "eine verlorene Sache" aufgrund der komplexen internationalen Gesetzeslage zum Recht am eigenen Bild. Ihr Fazit: Das Internet sei "ein riesiges Wurmloch der Dunkelheit, das sich selbst frisst", und noch weitaus verstörendere Inhalte biete als Deepfake-Pornografie.

Klar ist, dass die Untersuchung nicht alle Deepfakes erfassen kann, allein schon deshalb, da hervorragende Deepfakes kaum als solche zu identifzieren sind. Aber als statistische Grundlage für weitere Forschung leistet sie einen Beitrag zur Untersuchung des Phänomens.

Quelle: Deeptrace: The State of Deepfakes; Titelbild: Facebook

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.