Was ist KI-Hardware? Ansätze, Vorteile und Beispiele der neuen Technologie

Wer KI-Algorithmen verwendet, ist dabei oftmals mit Beschränkungen bei der Rechenleistung gängiger CPUs konfrontiert. Neue KI-Hardwareoptionen können hier bessere Ergebnisse ermöglichen. Wir stellen einige der wichtigsten Methoden vor.

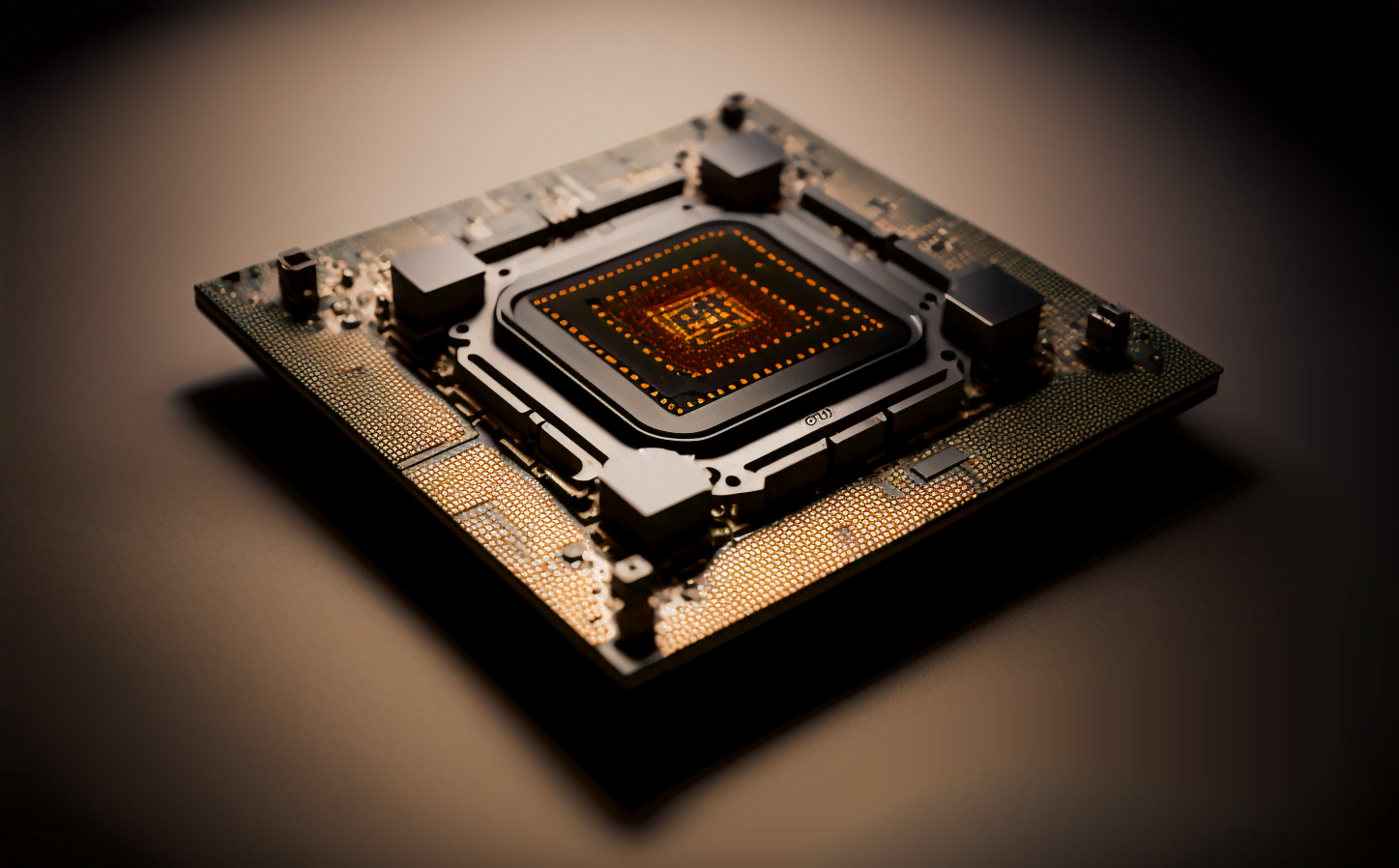

KI-Algorithmen werden immer häufiger in Alltagsanwendungen, in Unternehmen und in der kritischen Infrastruktur eingesetzt. Ihre Performance im Trainings- oder Inferenzstadium eines Algorithmus wird durch die Rechenleistung der zentralen Rechen- und Steuereinheit (engl.: central processing unit, kurz: CPU) vorgegeben, wo die mathematischen Berechnungen stattfinden.

Mit der Entwicklung und Verbreitung von KI-Algorithmen geht auch die Zunahme an Möglichkeiten einher, die datenintensiven Berechnungen effizienter durchzuführen. Insbesondere neue Grafikprozessoren (engl.: graphics processing unit, GPU) und KI-Beschleuniger wie Googles TPUs können KI-Algorithmen einen Speed-Boost geben.

Alternativen zum Standard-CPU

Eine gewöhnliche Prozessoreinheit, das Herzstück jedes Computers, erhält Befehle in Kombinationen aus 0 und 1, die sie sodann intern berechnet und zur Ausführung an die jeweiligen angeschlossenen Rechenwerke und Peripheriegeräte weitergibt. Die sogenannte Taktung der Prozessoreinheit gibt dabei die Geschwindigkeit vor, in der die Rechenvorgänge verarbeitet werden können.

Werden bestimmte Rechenvorgänge häufiger ausgeführt, lohnt es sich, speziell darauf ausgelegte Prozessoren zu verwenden, um die Berechnungen effizienter auszuführen. Das ist vorrangig bei KI-Algorithmen der Fall, in denen meist sehr große Datenmengen über längere Zeiträume in die Berechnungen einfließen. Die spezialisierte Hardware setzt in der Regel weder zusätzliche Algorithmen ein, noch verwendet sie einen anderen Recheneinsatz – der Unterschied liegt lediglich in der verbesserten Rechenleistung.

Viele der für KI-Algorithmen eingesetzten Prozessoren ermöglichen beispielsweise, neue KI-Modelle schneller zu erstellen, indem sie Rechenprozesse auf mehrere Prozessoreinheiten gleichzeitig – also parallel – verteilen. Das ist auch der Vorteil der GPUs, die ursprünglich für Grafikberechnungen ausgelegt sind.

Da die Rechenoperationen der Bildverarbeitung jedoch denen von neuronalen Netzen ähneln, eignen sich GPUs auch für viele KI-Berechnungen. Oftmals wird dabei insbesondere die Art und Weise, wie große Datenmengen im Chip ankommen und diesen wieder verlassen, den spezifischen Anforderungen entsprechend angepasst.

KI-Hardware für unterschiedliche Anforderungen

Die Hardwareanforderungen für Training und Inferenz sind unterschiedlich hoch – vorwiegend das Training, bei dem Algorithmen in Millionen und Milliarden von Datenpunkten Muster erkennen, profitiert von der Parallelisierung. Wurde das Modell einmal erstellt, sinken die Rechenanforderungen.

Einige CPU-Hersteller entwickeln daher sogenannte KI-Inferenzchips, die ausschließlich für das Ausführen der Modelle gedacht sind. Grundsätzlich profitieren jedoch auch fertig trainierte Modelle von parallelen Architekturen.

Während traditionelle PCs in ihrer Anordnung eine Trennung zwischen Speicher und CPU vorsehen, verbauen GPU-Hersteller Speicher mit hohen Zugriffsgeschwindigkeiten direkt auf die Platine. So lassen sich rechenintensive KI-Modelle direkt auf dem Grafikkarten-Speicher laden und ausführen. Durch die Einsparung der sonst benötigten Zeit für die Anordnung und den Transfer der Daten können die arithmetischen Berechnungen wesentlich schneller vonstattengehen.

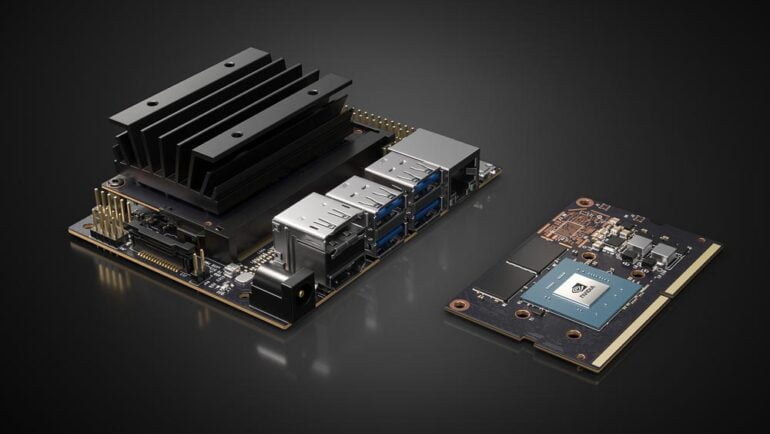

Abseits der weit verbreiteten GPUs und CPUs gibt es mittlerweile auch kompakte KI-Chips, die etwa in der Edge in Smartphones oder Automatisierungssystemen verbaut sind und häufig vorkommende Aufgaben wie Spracherkennung effizienter und mit weniger Stromverbrauch erledigen können.

Außerdem experimentieren einige Forschende mit analogen elektrischen Schaltkreisen, die sich in ihrer Methodik jedoch stark von den Schaltkreisen in herkömmlichen CPUs unterscheiden. Hier schafft die besondere Bauweise einen großen Vorteil, Aufgaben schneller, genauer, strom- sowie platzsparend berechnen lassen.

Beispiele für KI-Hardware

Grafikprozessoren oder GPUs sind noch immer die verbreitetste KI-Hardware, die für die Verarbeitung insbesondere von Aufgaben des Maschinellen Lernens umgenutzt werden. Durch den bereits erwähnten Vorteil der umfangreichen Parallelisierung bieten GPUs häufig mehrere hundertfach schnellere Rechenzeiten als CPUs.

Auf das maschinelle Lernen angepasste Architekturen vernachlässigen die Displayfähigkeit, der die Grafik beim Gaming ursprünglich dient, zugunsten der Beschleunigung von KI-Lernalgorithmen. Zu ihnen zählen etwa Angebote von Nvidia wie die A100- oder H100-Systeme oder Produkte von AMD. Nvidia bestimmt dabei den Markt und die Produkte des Techkonzerns sind in Supercomputern überall auf der Welt verbaut.

Einige Unternehmen wie Google entwickeln zusätzlich eigene Hardware, die auf KI-Anwendungen spezialisiert sind. Googles TPUs (engl: tensor processing unit) gibt es mittlerweile in der vierten Generation.

Überdies gibt es KI-Chips, die genau auf unterschiedliche Teile des ML-Prozesses zugeschnitten sind – etwa auf die Handhabung großer Datenmengen, die Bearbeitung neuer Dateninputs, oder auf einen effizienten Einsatz in Geräten mit begrenzten Platz- oder Batterie-Ressourcen wie Smartphones.

Aber auch herkömmliche CPUs werden vermehrt den Anforderungen von ML-Aufgaben angepasst, indem ihre internen Berechnungen mit weniger Genauigkeit, dafür aber weitaus schneller durchgeführt werden

Außerdem ermöglichen viele Cloud-Serviceprovider, rechenintensive Vorgänge parallel über dutzende oder hunderte Prozessoren auf mehreren Maschinen durchzuführen.

Die wichtigsten Herstellerfirmen für KI-Hardware

Einen Großteil der GPUs für Maschinelles Lernen produzieren die Firmen Nvidia und AMD. Nvidia ermöglicht etwa durch den Einsatz sogenannter „Tensor Cores“ präzisere Rechenoperationen beim Training von ML-Modellen.

Die H100-Karten unterstützen zudem mit der Transformer Engine die Mischung verschiedener Genauigkeiten. AMD bietet mit der CDNA-2- und den 2023 erscheinenden CDNA-3-Architektur einen eigenen Ansatz, um GPUs den Anforderungen des Maschinellen Lernens anzupassen.

Google stellt mit den bereits erwähnten TPUs eine eigene Hardware zur Beschleunigung von ML-Berechnungen her. Sie können hauptsächlich über Googles Cloud-Plattform gemietet werden, wobei eine Reihe zugehöriger Tools und Bibliotheken den Gebrauch erleichtern soll.

Alle Google Services, die maschinelles Lernen verwenden, basieren auf TPUs. Das TPU-Design findet sich auch in einigen Smartphones der Google-Pixel-Produktlinie wieder. Hier werden die Berechnungen für ML-Aufgaben wie Spracherkennung, Live-Übersetzungen oder Bildbearbeitung meist lokal ausgeführt.

Alle großen Cloud-Unternehmen wie Amazon, Oracle, IBM und Microsoft haben GPUs oder andere KI-Hardware installiert. Amazon hat mit Graviton zusätzlich eine eigene Chipserie entwickelt, die auf der ARM-Architektur beruht und Berechnungen unter Einbüßen von Genauigkeit, jedoch zugunsten von Schnelligkeit ausführt.

Amazons SageMaker zählt mit Google’s CoLab oder AutoML, Microsofts Machine Learning Studio sowie IBMs Watson Studio zudem zu einer neuen Kategorie Frontend-Anwendungen, bei denen sich spezielle Hardware ohne das Wissen der Kund:innen hinter einem Interface verbergen kann.

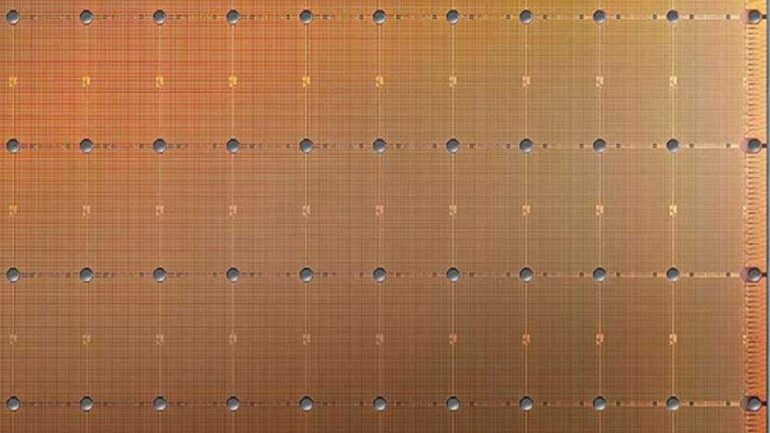

KI-Chips werden inzwischen auch von zahlreichen Start-ups produziert: Zu ihnen zählen etwa D-Matrix, ein kalifornisches Unternehmen, das die arithmetischen Berechnungen näher an den im Arbeitsspeicher befindlichen Daten vornehmen lässt; eine Technologie, die man „in-memory computing“ (IMC) nennt.

Einen ähnlichen Ansatz, bei dem die Berechnungen sogar direkt in den RAM-Zellen stattfinden – sogenanntes „at memory computing“ – entwickelt derzeit das Start-up Untether. Mit dieser Methodik wird in nur einer Chipkarte eine erheblich hohe Rechenleistung von zwei Petaops erzielt.

Weitere Start-ups wie Graphcore, Cerebras oder Celestial entwickeln ebenfalls in-memory computing, Chips mit unterschiedlichen Bauweisen oder sogar lichtbasierte Logiksysteme, mit denen sich KI-Berechnungen weitaus schneller ausführen lassen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.