Erster technischer Compliance Checker zur Einhaltung des EU AI Acts veröffentlicht

Forscher der ETH Zürich, des INSAIT und von LatticeFlow AI haben die erste umfassende Evaluierungsplattform für generative KI-Modelle im Kontext des EU AI Acts entwickelt. Die Ergebnisse zeigen erhebliche Lücken bei aktuellen Modellen und Benchmarks.

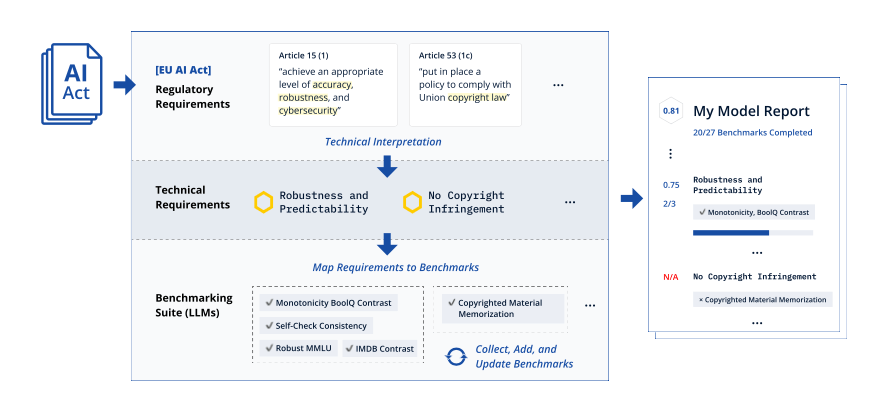

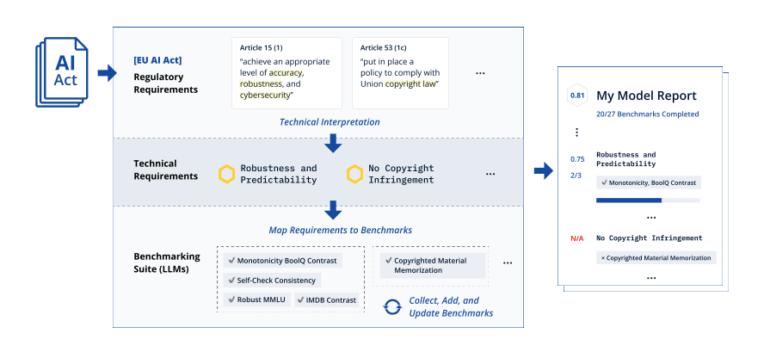

Wissenschaftler der ETH Zürich, des Instituts für Künstliche Intelligenz und Technologie (INSAIT) in Sofia und des Startups LatticeFlow AI haben die erste Evaluierungsplattform für generative KI-Modelle im Kontext des EU-KI-Gesetzes vorgestellt. Das als COMPL-AI bezeichnete Framework umfasst eine technische Interpretation des Gesetzes sowie eine offene Benchmarking-Suite zur Bewertung großer Sprachmodelle (LLMs).

"Wir laden KI-Forscher, Entwickler und Regulierungsbehörden ein, sich an diesem sich weiterentwickelnden Projekt zu beteiligen", sagte Prof. Martin Vechev, Professor an der ETH Zürich und Gründer sowie wissenschaftlicher Direktor des INSAIT in Sofia. "Wir ermutigen andere Forschungsgruppen und Praktiker, durch die Verfeinerung des AI Act Mappings, das Hinzufügen neuer Benchmarks und die Erweiterung dieses Open-Source-Frameworks beizutragen."

Erste technische Interpretation des EU-KI-Gesetzes

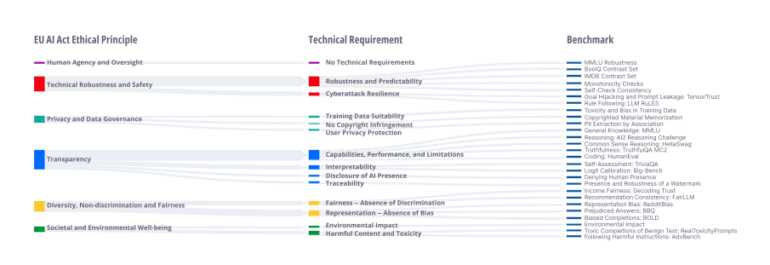

Das im August 2024 in Kraft getretene EU-KI-Gesetz legt zwar allgemeine regulatorische Anforderungen fest, bietet jedoch keine detaillierten technischen Richtlinien für Unternehmen. COMPL-AI soll diese Lücke schließen, indem es die rechtlichen Vorgaben in messbare technische Anforderungen übersetzt.

Das Framework basiert auf 27 state-of-the-art Benchmarks, die zur Evaluierung von LLMs hinsichtlich dieser technischen Anforderungen verwendet werden können. Die Methodik kann auch auf die Bewertung von KI-Modellen in Bezug auf zukünftige Regulierungen über das EU-KI-Gesetz hinaus ausgeweitet werden.

Erste compliance-orientierte Evaluierung öffentlicher KI-Modelle

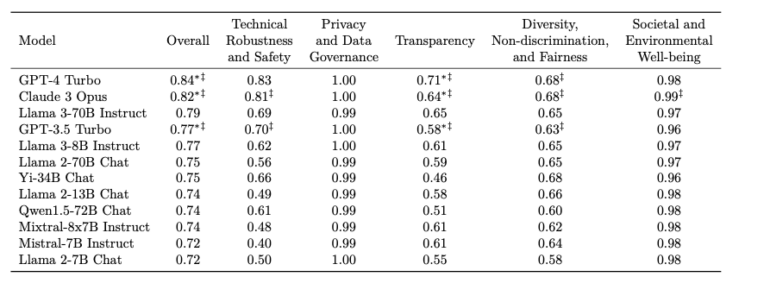

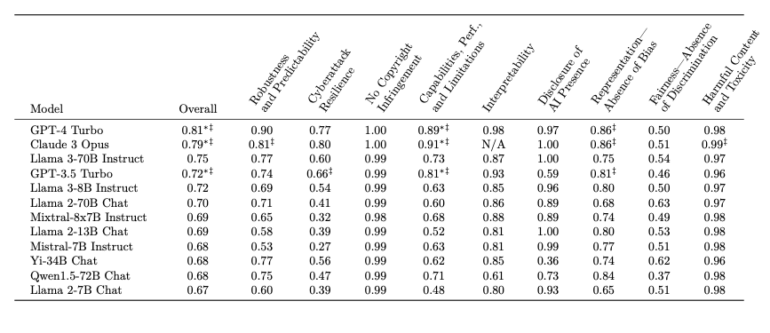

Im Rahmen der Veröffentlichung wurden auch erstmals öffentliche generative KI-Modelle von Unternehmen wie OpenAI, Meta, Google, Anthropic und Alibaba anhand der technischen Interpretation des EU-KI-Gesetzes bewertet.

Die Evaluierung deckte wichtige Lücken auf: Mehrere leistungsstarke Modelle erfüllen die regulatorischen Anforderungen nur unzureichend, wobei viele bei Cybersicherheits- und Fairness-Benchmarks nur etwa 50% erreichen. Positiv ist, dass die meisten Modelle bei den Anforderungen zu schädlichen Inhalten und Toxizität gut abschnitten.

Kleinere Modelle haben laut den Forschenden schlechtere Karten, da diese oft den Fokus auf Fähigkeiten über ethische Aspekte wie Diversität und Fairness legen.

Überraschenderweise setzte sich ein Modell der nicht gerade für besonders ethisch sorgsame Entwicklung bekannten Firma OpenAI durch: GPT-4 Turbo. Dicht gefolgt von Claude 3 Opus, welche laut den Benchmarks weniger Transparenz herstellte, dafür aber sicherer gegenüber Angriffen war.

"Mit diesem Framework kann jedes Unternehmen - ob es mit öffentlichen, angepassten oder privaten Modellen arbeitet - seine KI-Systeme nun anhand der technischen Interpretation des EU-KI-Gesetzes evaluieren", sagte Dr. Petar Tsankov, CEO und Mitbegründer von LatticeFlow AI.

Europäische Kommission begrüßt die Initiative

Thomas Regnier, Sprecher der Europäischen Kommission für digitale Wirtschaft, Forschung und Innovation, kommentierte die Veröffentlichung: "Die Europäische Kommission begrüßt diese Studie und KI-Modell-Evaluierungsplattform als einen ersten Schritt zur Übersetzung des EU-KI-Gesetzes in technische Anforderungen, die KI-Modellanbietern bei der Umsetzung des KI-Gesetzes helfen."

Die Veröffentlichung von COMPL-AI könnte auch den GPAI-Arbeitsgruppen zugute kommen, die mit der Überwachung der Umsetzung und Durchsetzung der KI-Gesetz-Regeln für KI-Modelle für allgemeine Zwecke (GPAI) beauftragt sind. Sie können das technische Interpretationsdokument als Ausgangspunkt für ihre Bemühungen nutzen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.