KI-Modellkunde - Fundierte Entscheidungshilfe für Bildmodelle im Unternehmen

Von verpixelten Anfängen zur visuellen Kreativität auf Knopfdruck

Die Bilderzeugung mit KI hat sich innerhalb von nur rund zehn Jahren aus der akademischen Welt zu einem Werkzeug mit enormer praktischer Relevanz entwickelt. Sie eröffnet Unternehmen vielfältige Möglichkeiten, von automatisierter Content-Produktion über Produktvisualisierungen bis zu personalisierter Werbung. Dies gilt besonders für Mitarbeitende, die nicht spezialisiert in Fotografie und Bildbearbeitung sind und nun mit KI eigene Kreationen umsetzen können.

KI-Funktionen sind bereits in Bildbearbeitungstools wie Photoshop oder Canva integriert. Der Fokus liegt hier jedoch auf der Kooperation von KI und Mensch. Wer jedoch automatisiert nur auf der Basis einer Textanweisung Werke erzeugen möchte, der ist besser damit bedient, eine gezielte Auswahl für ein Bildmodell zu treffen. Genau dabei unterstützt Sie dieser Deep Dive. Wir zeigen Ihnen, welche Modelle bei welchen Bildtypen besonders stark sind und wie Sie zielgerichtet für gute Ergebnisse prompten können. Da die verschiedenen Modelle derzeit noch sehr unterschiedliche Stärken und Schwächen haben, kann das über Erfolg und Misserfolg entscheiden.

Zur Abrundung finden Sie Tipps zu rechtlichen Aspekten und Best Practices für den professionellen Einsatz im Unternehmen.

So funktioniert generative Bilderzeugung

Die generative Bilderzeugung wird von spezialisierten KI-Modellen übernommen. In ChatGPT etwa wurde für die Bilderzeugung noch bis ins Frühjahr 2025 für die Nutzer sichtbar, das Modell Dall-E aufgerufen. Das war nötig, da ein konventionelles großes Sprachmodell (Large Language Model) rein textbasiert arbeitet und Bilder weder als Input verarbeiten noch erzeugen kann. Um diese Einschränkung zu überwinden, geht der Trend mittlerweile zu sogenannten multimodalen Modellen, die sowohl Text als auch Bilder verarbeiten können. Mittlerweile geht der Trend jedoch zu sogenannten multimodalen Modellen.

Was sind generative Bildmodelle?

Generative Bildmodelle zielen darauf ab, neue Werke auf Basis einer textlichen Beschreibung oder eines Beispielbildes zu erschaffen.

Sie wurden auf großen Mengen existierender Bilder und dazugehöriger Beschreibungen trainiert und in der Regel außerdem noch durch menschliches Feedback. Sehr vereinfacht kann man sich das vorstellen, wie einen Künstler, der Millionen Bilder studiert hat und daraus ein Gespür dafür entwickelt, wie ein „typisches“ Katzenfoto, ein impressionistisches Gemälde oder ein Firmenlogo aussieht – und dann selbst eines anfertigt. Als weiterer Schritt kommt dann noch dazu, dass diese Bilder auf Basis eines textlichen Prompts erstellt werden. Dadurch müssen beim Training auch „Konzepte“ gelernt werden, die Text und Bild miteinander verknüpfen. Mit welchen Zusatzmethoden es dennoch funktioniert, erklären wir später.

Frühzeit: Lernen mit Einschränkungen

Schon in den 1980er- und 1990er-Jahren forschte man an dem Thema und konnte einfache Muster erzeugen – etwa Linien oder geometrische Formen. Von kreativer Bildsynthese waren sie jedoch weit entfernt. Später gelang es vorwiegend durch die Arbeiten unter anderem des einflussreichen KI-Pioniers Geoffrey Hinton, einfache Bilder wie handgeschriebene Ziffern zu generieren. Die Qualität war immer noch bescheiden, aber der Grundstein war gelegt.

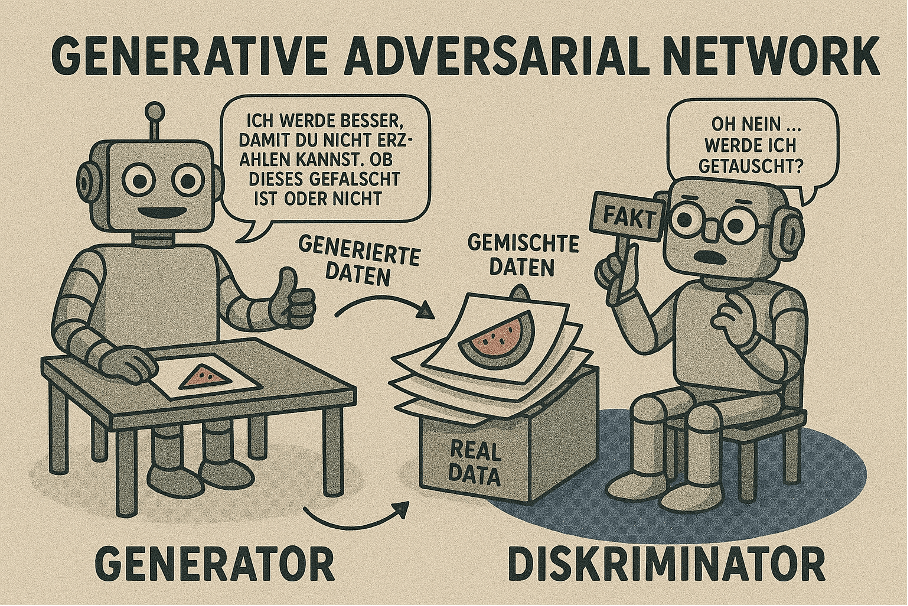

GANs: Das kreative Duell der neuronalen Netzwerke

Den eigentlichen Durchbruch brachte 2014 das Konzept der Generative Adversarial Networks (GANs), vorgestellt vom Informatiker Ian Goodfellow. Das Grundprinzip ist so einfach wie genial: Zwei neuronale Netzwerke, ein Generator und ein Diskriminator, werden in einem Wettbewerb gegeneinander trainiert.

Der Generator versucht, Bilder zu erzeugen, die von echten nicht zu unterscheiden sind, während sein „Gegenspieler“, der Diskriminator, weitestgehend als „Kunstkritiker“ fungiert und versucht, echte von generierten Bildern zu unterscheiden. Durch dieses Feedback-System verbessern sich beide Komponenten kontinuierlich – der Generator erzeugt immer realistischere Bilder, während der Diskriminator immer kritischer wird. Und schon zu Zeiten dieser Erfindung sagte Goodfellow 2017 vorher: Menschen dürften Bildern und Videos im Netz nicht mehr automatisch Glauben schenken.

Die Stärke dieses Ansatzes liegt in seiner Fähigkeit, sehr realistische Bilder zu erzeugen.

Dadurch wurden GANs zum Meilenstein: Erstmals konnten KI-Systeme fotorealistische Gesichter, Tiere oder Objekte erzeugen, wenn auch zunächst mit Einschränkungen. StyleGAN, eine fortschrittliche GAN-Variante, erregte 2019 Aufsehen mit fotorealistischen Porträts von nicht existierenden Menschen. Die immer noch im Web verfügbare Site „This Person Does Not Exist“ demonstriert dies eindrucksvoll.

Allerdings hatten diese GANs auch Schwächen: Die Trainingsprozesse waren oft instabil, das Modell brauchte viele Feineinstellungen, und eine Steuerung der Ausgabe war nur bedingt möglich. Zudem neigten sie zum „Mode Collapse“, bei dem der Generator nur eine begrenzte Vielfalt an Bildern erzeugt, statt die volle Bandbreite der Trainingsdaten zu repräsentieren.

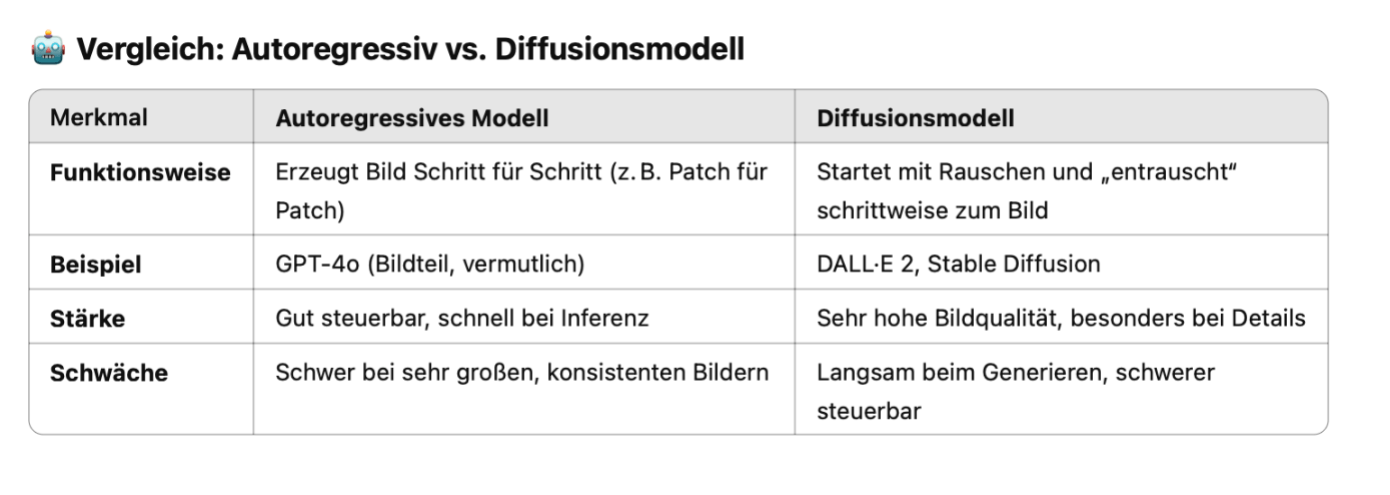

Die Ära der Diffusionsmodelle: Bilder aus Rauschen

Ein Paradigmenwechsel kam um 2020 mit dem beginnenden Aufstieg der Diffusionsmodelle. Im Gegensatz zu GANs arbeiten diese nach einem vollkommen anderen Prinzip: Ein Bild wird zunächst Schritt für Schritt in Rauschen überführt – und dann in umgekehrter Richtung wiederhergestellt. Wird dieser Prozess oft genug trainiert, kann das Modell lernen, aus reinem Rauschen neue Bilder zu „entrauschen“ – also zu generieren.

Einflussreiche Beispiele dieser Technik sind DALL·E 2 von OpenAI, Stable Diffusion von Stability AI oder Midjourney. Diffusionsmodelle überzeugen durch eine hohe Bildqualität und speziell durch ihre Flexibilität. Selbst in der Realität unsinnige Texteingaben wie „ein Astronaut reitet auf einem Pferd im Stil von Picasso“ führen zu verblüffend kreativen, konsistenten Bildern. Die recht gute Steuerbarkeit durch Prompt Engineering ist einer der Hauptgründe für ihren Erfolg.

Allerdings haben auch Diffusionsmodelle Schwächen: Vor allem Texte zu erzeugen, fällt den Modellen schwer. Auch beim Zählen und korrekten Darstellen der richtigen Menge an gewünschten Objekten sind sie ähnlich schwach wie Modelle, die primär der Texterzeugung dienen.

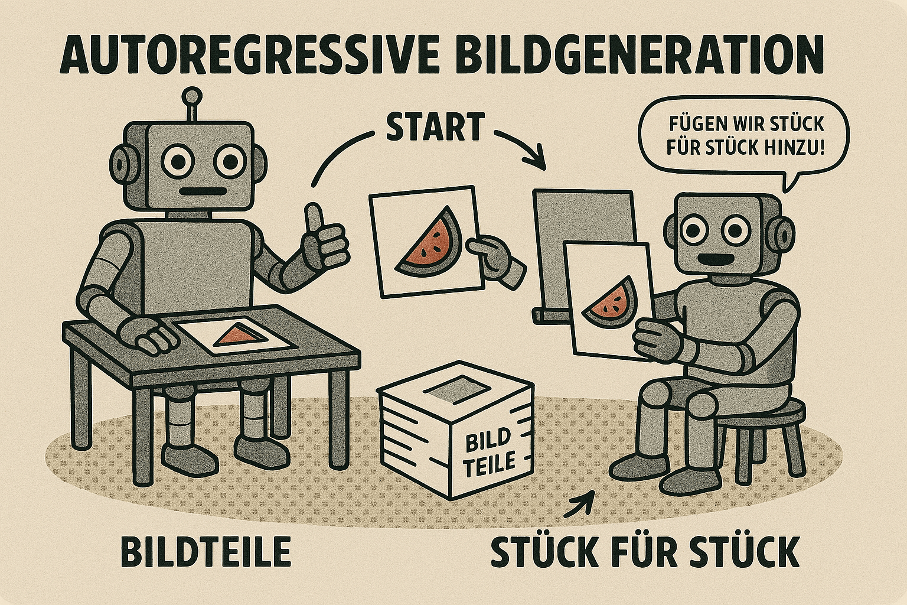

Autoregressive Modelle

Ein weiterer Ansatz für die Bilderzeugung sind sogenannte autoregressive Modelle. Im Gegensatz zu GANs oder Diffusionsmodellen bauen sie Bilder nicht in einem Schritt oder rückwärts aus Rauschen auf, sondern generieren das Bild Stück für Stück – ähnlich wie bei einem Puzzle.

Das Prinzip stammt ursprünglich aus der Textgenerierung: Dort errechnet das Sprachmodell jedes Wort einzeln. Jedes folgende Wort bezieht sich auf den Kontext der schon generierten Worte. Übertragen auf Bilder bedeutet das: Das Modell beginnt mit einem kleinen Bildbereich – etwa einem Farbfleck oder einem Teilobjekt – und ergänzt diesen dann Schritt für Schritt. Jeder neue Teil des Bildes orientiert sich dabei an dem, was schon vorhanden ist. Das können einzelne Pixel sein, größere Bildbereiche oder abstrakte Bildbausteine.

Autoregressive Modelle bieten dadurch eine hohe Kontrolle über den Bildaufbau und können konsistente und logisch aufgebaute Inhalte erzeugen – insbesondere bei klar strukturierten Motiven. Allerdings ist dieses Verfahren oft rechenintensiv und vergleichsweise langsam, wenn man riesige oder detailreiche Bilder erstellen möchte.

Bekannte Beispiele für autoregressive Modelle in der Bildgenerierung sind DALL·E 1 von OpenAI oder das Parti-Modell von Google. Auch in aktuellen multimodalen Systemen wird das Verfahren oft eingesetzt – meist in Kombination mit anderen Methoden.

Aktueller Stand: Multimodale und hybride Modelle

Der aktuelle, nächste Evolutionsschritt sind multimodale Modelle – also Systeme, die gleichzeitig Text, Bild, Audio und Video verstehen und erzeugen können. Erste Ansätze wie GPT-4o ImageGen (heute eingebaut in GPT-5) oder Google Gemini zeigen bereits, wie dies aussehen kann.

Im Gegensatz zu früheren Ansätzen, die separate Modelle für verschiedene Datentypen nutzen, werden diese Architekturen von Grund auf darauf trainiert, auch die Beziehungen über Text/Bild/Video – also die verschiedenen Modalitäten – hinweg zu erfassen.

Der technische Durchbruch liegt in der Schaffung eines gemeinsamen Repräsentationsraums für unterschiedliche Datentypen. Der entscheidende Fortschritt besteht darin, dass diese KI-Modelle Text und Bilder auf die gleiche Weise verstehen können. Sie erkennen zum Beispiel, dass ein Bild von einer Katze und das Wort ‚Katze‘ dasselbe bedeuten – auch wenn es einmal ein Bild und einmal Text ist.

Der Vorteil dieses integrierten Ansatzes liegt in seiner Flexibilität und Robustheit. Vor allem Text in Kombination mit Bildern – was ja eine häufig benötigte Anforderung im Business-Kontext ist – kann nun in bisher ungewohnter Qualität erzeugt werden.

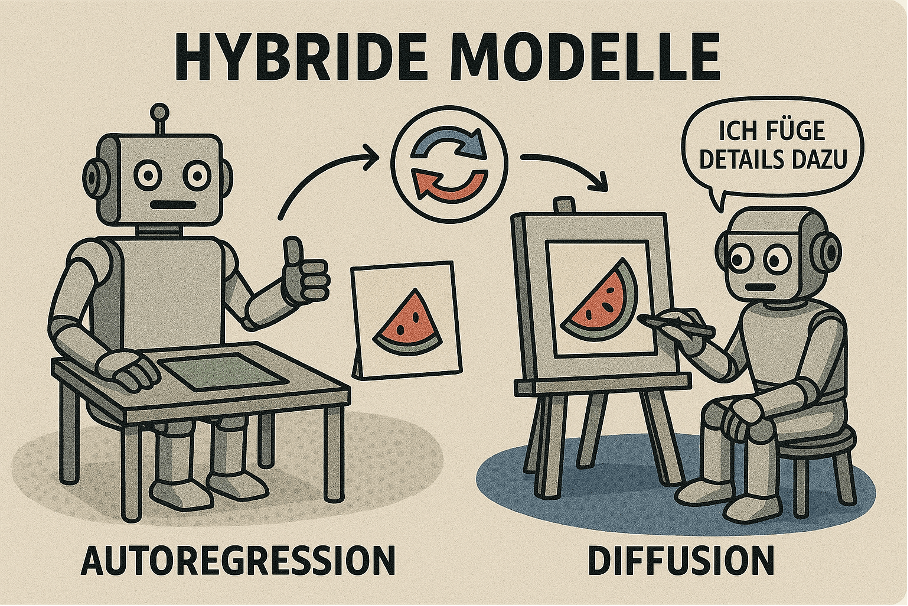

Hybride Modelle

Aktuell geht der Trend dahin, autoregressive und Diffusionsverfahren zu kombinieren, z. B. bei dem Standard-Bildmodell von OpenAI GPT-4o ImageGen oder auch bei Googles Gemini nativer Bildgenerierung. Dabei wird typischerweise zuerst ein Bild in einem abstrakten Format (Latenzraum) autoregressiv erzeugt – also eine Art grobes „Bildkonzept“ –, und dieses wird dann mit einer Diffusionstechnik in ein hochqualitatives Bild umgerechnet.

Das kombiniert die verschiedenen Vorteile: Der autoregressive Teil ist steuerbar und schnell bei der Grobstruktur, die Diffusion bringt visuelle Feinheiten (z. B. Texturen, Licht, Details).

Schon jetzt zeigt OpenAI mit GPT 4o ImageGen einen weiteren Vorteil dieser Kombination: Erstellte Bilder können im Dialog mit den Nutzern einfach verändert und editiert werden und bleiben bis auf die Änderungen weitgehend erhalten.

Methodik

Die KI-Community hat einige technische Tests entwickelt, welche die Fähigkeiten von Bildmodellen prüfen.

Dazu gehören z. B.:

- EvalGIM von Meta: Eine Library, die mehrere Testverfahren kombiniert. Sie eignet sich für das Testen von Open-Source/HuggingFace-Modellen.

- ImageReward: Ein Open-Source-Projekt, das die Präferenzen von Menschen imitiert und so fast identische Bewertungen wie Menschen abgibt.

Diese und ähnliche Testverfahren versuchen auf die eine oder andere Weise, menschliche Bewertungen zu simulieren. Dennoch gibt es aktuell keine bessere, verlässlichere und günstigere Methode zur Bewertung von Bildern als das menschliche Auge.

Egal, wie technisch ausgefeilt unser Testdesign sein könnte, es würde nie einer einfachen Straßenbefragung standhalten. Diese Einsicht spiegelt sich auch in den aktuellen Benchmarks von Vergleichswebsites wie Artificial Analysis wider. Deren Methodik ist denkbar einfach: Wähle zwischen zwei Bildern. Welches gefällt dir besser?

Frei nach Ockhams Rasiermesser ist hier also die einfachste Methode die beste: Welches Bild schlägt sich in Blindtests am besten?

Auswahl der Bildmodelle

Wir haben Bildmodelle ausgewählt, die hervorragende Ergebnisse in Benchmarks erzielen und auch in einem professionellen Kontext häufig verwendet werden:

| Modell | Hersteller |

| flux-1.1-pro | Black Forest Labs |

| Recraft v3 | RecraftAI |

| Imagen 3 | Google DeepMind |

| GPT-4o | OpenAI |

| Firefly v2 | Adobe |

| Stable Diffusion 3.5 Large | Stability AI |

| Midjourney v7 | Midjourney |

| Ideogram 3 | Ideogram |

Hinweis: Zeitpunkt des Tests war April 2025. Mittlerweile gibt es neuere Versionen von Imagen (v4) und Firefly (v4).

Das Modell Flux etwa wird von der Deutschen Telekom eingesetzt, um Pressefotos zu generieren. Auch der Burda-Verlag setzt das Modell dank Finetuning erfolgreich für die Kindermarke Lissy PONY ein. Adobe Firefly ist als Teil des bezahlten Abonnements (Creative Suite) weitverbreitet. Wichtig ist noch anzumerken, dass wir in diesem Test die Leistung eigenständiger Basismodelle testen, keine Tools.

Testdesign

Anhand von vier typischen Einsatzszenarien im Unternehmensalltag haben wir Prompts entworfen, die komplexe Anforderungen an Bildmodelle darstellen:

- Portraitfoto eines Modells – stellvertretend für die Generierung von Fotos von Menschen

- Infografik zu einem Prozess

- Grafische Illustration im Zeitschriften-Stil

- Produktfoto – stellvertretend für die Generierung von Fotos von Dingen

In einem ersten Schritt testeten wir das Promptdesign, also die genaue Architektur der Arbeitsanweisungen an die Modelle. Um vergleichbare Bedingungen für unseren Test zu schaffen, haben wir uns entschieden, keine speziellen Anpassungen der Prompts an die jeweiligen Modelle vorzunehmen. Jedes Modell soll mit den gleichen Arbeitsaufträgen gut umgehen können.

In einem zweiten Schritt richteten wir alle Zugänge für den Test ein: Midjourney, Firefly, GPT-4o und Imagen 3 waren alle über eine Weboberfläche zu erreichen. Stable Diffusion, Recraft, Flux und DALL-3 boten auch Schnittstellen (APIs) an. Für diese Modelle schrieben wir kleine Python-Skripte (siehe Anhang) und führten unsere Tests mit dem Anbieter AI/ML durch.

Wie richte ich einen Zugang zu Bildmodellen mit API-Schnittstelle ein?

Nach der Einrichtung eines Benutzerkontos (z. B. bei AI/ML) steht ein Schlüssel für die Verwendung aller Modelle auf der Plattform zur Verfügung (API-Key). Für die Auswahl des Modells und das eigentliche Ausführen der Prompts benötigen wir kleine Hilfsprogramme in der Programmiersprache Python. Je nach Betriebssystem müssen Sie Python zunächst installieren und einrichten. Im nächsten Schritt richten Sie dafür das Hilfsprogramm UV ein, das für eine saubere Installation sorgt. Erstellen Sie nun einen neuen Ordner, in dem Sie Bilder ablegen wollen. Navigieren Sie in Ihrem Terminal zu diesem Ordner (mit den Befehlen cd [Ihr Ordner]). Mit uv init erstellen Sie ein neues Python-Projekt, mit source .venv/bin/activate aktivieren Sie die virtuelle Umgebung, in welcher Sie sicher arbeiten können. Jetzt installieren Sie das Paket OpenAI mit uv pip install openai. Zuletzt richten Sie das Python-Skript korrekt ein: Hierfür speichern Sie sich den Text der Vorlage in einer Textdatei und fügen folgende Informationen ein:

- Ihren Zugangsschlüssel (API-Key) unter „Authorization“: „Bearer <YOUR_AIMLAPI_KEY>“ (Der API-Key ersetzt den Part <YOUR_AIMLAPI_KEY> vollständig)

- Ihr gewähltes Modell nach model=„flux-pro“ (achten Sie auf die genaue Schreibweise in der Dokumentation)

- Ihren Prompt nach prompt=""“

import os

from openai import OpenAI

import requests

url = "https://api.aimlapi.com/v1/images/generations/"

model="flux-pro"

prompt="""

Create a classroom of young robots.

The chalkboard in the classroom has 'AI Is Your Friend' written on it.

"""

payload = {

"prompt": prompt,

"model": model,

}

headers = {

#put your AIML API Key instead of <YOUR_AIMLAPI_KEY>:

"Authorization": "Bearer <YOUR_AIMLAPI_KEY>",

"content-type": "application/json"

}

response = requests.post(url, json=payload, headers=headers)Speichern Sie die Datei unter modellnamen.py und führen Sie die Datei im Terminal mit uv run modellnamen.py aus. Um das Abspeichern der Bilder etwas zu erleichtern, haben wir das Skript etwas angepasst. Verwenden Sie es gerne, allerdings ist es nur eine schnelle Lösung, kein Code für produktive Software-Instanzen.

Drittens generierten wir pro Modell und Prompt drei Bilder. Für unsere sieben Modelle generierten wir also pro Modell vier Bilder und führten diesen Prozess insgesamt dreimal durch. So kommen wir am Ende auf 84 Bilder (7 × 4 × 3) für unsere Vergleichstests. Midjourney generiert als einziger Anbieter pro Prompt vier Varianten; hier wählten wir das entsprechend beste Bild für den Vergleich mit den anderen Modellanbietern.

Viertens analysierten wir die Ergebnisse anhand mehrerer Kriterien:

| Kriterium | Beschreibung |

| Prompttreue | Wie genau entspricht das generierte Bild der textuellen Eingabebeschreibung? Wurden alle wichtigen Elemente des Prompts umgesetzt? Stimmen Farben, Perspektive und spezifische Anforderungen überein? |

| Typografie | Qualität und Lesbarkeit von Text im Bild. Sind Schriften korrekt dargestellt? Gibt es Verzerrungen oder „KI-typische“ Schreibfehler? Konsistenz der Schriftarten und -größen? |

| Fotorealismus | Wie natürlich und realistisch wirkt das Bild? Sind Licht, Schatten und Texturen überzeugend? Entsprechen Proportionen und Perspektiven der Realität? Gibt es unrealistische Artefakte? |

| Bildlogik/Fehler | Anatomische/technische Korrektheit, physikalische Plausibilität? Gibt es offensichtliche Fehler wie zusätzliche Finger, verschmolzene Objekte oder unmögliche Konstruktionen? Stimmen räumliche Beziehungen? |

| Ästhetik | Gesamteindruck der Bildkomposition: Ist das Bild visuell ansprechend? Stimmen Farbharmonie und Balance? Wirkt die Bildaufteilung professionell und durchdacht? |

Einsatzszenarien

Wir können heute drei Arbeitsweisen mit KI-Bildmodellen erkennen, die in ihrer Komplexität aufeinander aufbauen: kreatives Experimentieren, professionelles Prompting und Finetuning. Wer die erste Methode beherrscht, kann sich an die Fortgeschrittenen wagen. Nachfolgend beschreiben wir einige Anwendungsszenarien aus der Praxis und die dahinterliegenden Techniken.

Level 1: Kreatives Experimentieren

| Anwendungsszenario | Beschreibung |

| Brainstorming & Ideenfindung | Schnelle Visualisierung erster Ideen für Marketing, Produkte, Layouts. |

| Einfache Social-Media-Posts | Generierung schneller Grafiken für Social Media. |

| Interne Kommunikation | Einfache Bilder zur Veranschaulichung interner Nachrichten. |

| Spielerische Content-Erstellung | Humorvolle Bilder für Teambuilding oder Auflockerung. |

| Visuelle Inspiration & Moodboards | Schnelle Erzeugung visueller Stile zur Inspiration. |

Hierunter verstehen wir das freie Chatten mit den KI-Bildmodellen – ohne komplizierte Prompts, Muster oder Parameter. Wie im Kapitel „Prompting-Methoden“ beschrieben, steht die Arbeit mit KI-Bildmodellen ganz im Lichte des Pragmatismus: Wenn Sie eine Methode gefunden haben, die für Sie funktioniert, ist es vermutlich die richtige.

Das freie Chatten mit Bildmodellen kann Sie auf neue Ideen bringen und Ihnen sofort das gewünschte Bild erzeugen. Es kann aber auch zu endlosen Schleifen an Korrekturen und unnötigen Generierungen führen. Falls Sie Anweisungen oft wiederholen oder das Modell häufig korrigieren müssen, ist es ein sicheres Zeichen, dass Sie bereit für Level 2 sind.

Level 2: Professionelles Prompting

| Anwendungsszenario | Beschreibung |

| Hochwertige Marketingmaterialien | Detaillierte Bilder für Anzeigen, Broschüren, Websites durch präzise Prompts. |

| Produktvisualisierung & Mockups | Realistische Produktbilder für Präsentationen und Kundenkommunikation. |

| Fachpublikationen & Blogs | Thematisch relevante Illustrationen für Fachartikel. |

| Visuelle Konzepte für Design | Detaillierte visuelle Konzepte für Web/App-Design. |

| Stockfoto-Alternativen | Maßgeschneiderte Bilder statt generischer Stockfotos. |

Es gibt noch keine Lingua franca für das Prompten von KI-Bildmodellen. Bisher hat sich kein eindeutiges Schema oder Muster durchgesetzt. Das erlaubt Ihnen ein größeres Maß an kreativem Experimentieren.

Auch wenn zahlreiche Modellhersteller und Expertinnen und Experten aus dem Internet ihnen die perfekte Prompting-Technik versprechen (oder verkaufen wollen) – es gibt sie nicht. Die Forschung in diesem Bereich steht noch eher am Anfang.

Ein größerer Fokus liegt aktuell aus unserer Sicht auf der Verbesserung der Modelle selbst. Selbst technischer Jargon wie Midjourneys überkomplexe Parameter kann nicht verschleiern, was Anwenderinnen und Anwendern von aktuellen Bildmodellen schnell klar wird: Die Kontrollierbarkeit und Reproduzierbarkeit von Ergebnissen mit KI-Bildmodellen ist heute noch schwach. Sie ist nicht vergleichbar mit dem Maß an Steuerung, wie es bei textgenerierenden Modellen möglich ist.

Es gibt dennoch ein paar bewährte Techniken und Standards, die sich als effektiv erwiesen haben.

Prinzip des Minimalismus

Reduzieren Sie Ihren Prompt so weit wie möglich auf die Kernessenz. Stellen Sie sich die Frage: Wenn ich meinem Freund kurz und bündig erklären müsste, wie ich mir das Bild vorstelle – welche Worte würde ich wählen? Warum das technisch sinnvoll ist, erfahren Sie gleich.

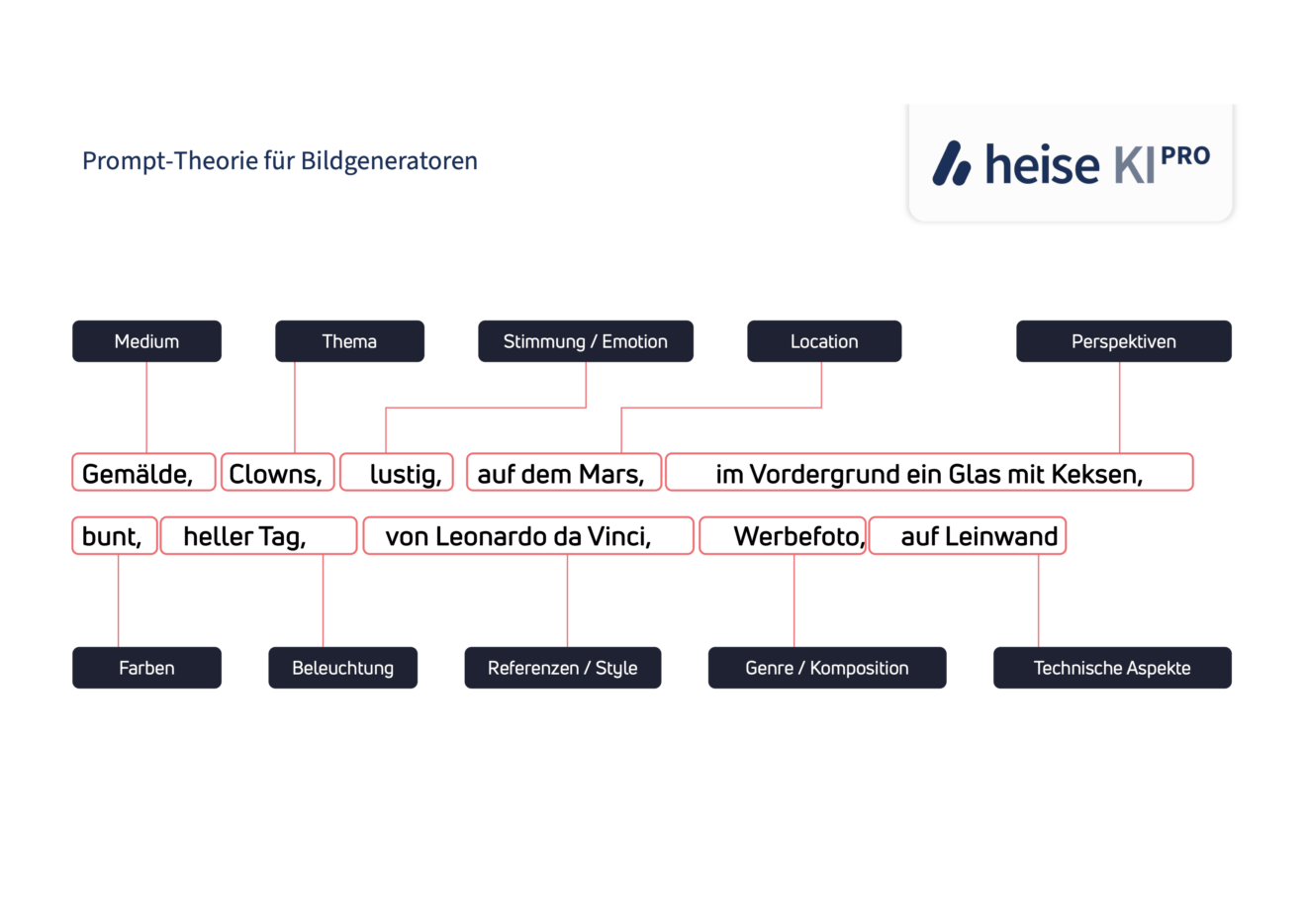

Struktur eines Bild-Prompts

Wir schlagen folgende grundlegende Struktur für Prompts an Bildmodelle vor:

Die Struktur orientiert sich an den Empfehlungen von etablierten Modellherstellern wie Midjourney, in der KI-Community oft besprochenen Methoden und unserer eigenen Erfahrung. Wie Sie sehen, ist das Formulieren in ganzen und vollständigen Sätzen nicht zwingend notwendig. Wir raten aber auch nicht davon ab, wenn es Ihnen hilft, das Wunschmotiv besser zu beschreiben. Die meisten Modelle können natürliche Sprache genauso gut verstehen wie Schlagwörter.

Wichtig ist nur, dass Sie die Stellschrauben der Modelle kennen. Falls ein Bild partout nicht die Schärfe erreicht, die Sie haben wollen, lohnt sich vielleicht ein technischer Zusatz wie „4K“.

In seiner einfachsten Form lautet die Formel für einen guten Prompt an Bildmodelle: Inhalt + Stil.

Die Reihenfolge und die Kombination von Schlüsselwörtern können das Ergebnis verbessern. Unserer Erfahrung nach setzen die Modelle Konzepte am Anfang besser um als am Ende des Prompts.

Den größten Effekt in der Verbesserung konnten wir bei der Sprache feststellen: Da die Bildmodelle in englischer Sprache trainiert wurden, funktionieren Prompts auf Englisch wesentlich besser. Es sei denn, sie legen Wert auf mit der Sprache verbundene kulturelle Elemente. Dann könnte es Sinn ergeben, in ihrer Zielsprache zu prompten. Einige Modelle wie GPT-4o funktionieren z. B. auch gut mit Deutsch, generell empfiehlt sich aber Englisch.

Wie Sie Ihre Prompts verbessern können

- Auf Englisch prompten: Übersetzen Sie Ihren Prompt ins Englische für bessere Resultate (kann helfen, ist aber immer weniger wichtig geworden).

- Prompts als Balance zwischen Präzision und Abstraktion: Geben Sie gezielt an, was für Ihr Vorhaben wichtig ist, aber vermeiden Sie übermäßige Details. Eine vollständige Beschreibung jedes Aspekts eines fotorealistischen Bildes würde theoretisch seitenlange Prompts erfordern (z. B. für jeden Schattenwurf oder Lichtreflex). Stattdessen ist es oft effektiver, die grundlegende Idee klar zu vermitteln und dem KI-System Raum für die Interpretation zu lassen. Die Detailtiefe sollte sich nach Ihrem Ziel richten – bei konzeptionellen Darstellungen können wenige prägnante Angaben ausreichen, während für spezifische Elemente in realistischen Bildern gezielte Detailanweisungen nötig sind.

- Stilistische Elemente hinzufügen: Ergänzen Sie Ihre Grundidee mit Stilangaben wie z. B.:

- „photorealistic“, „cinematic“, „high definition“

- „studio lighting“, „professional photography“, „sharp focus“

- „dramatic shadows“, „soft lighting“, „golden hour“

- „minimalist“, „vibrant colors“, „muted tones“

- „stylized“, „painterly effect“, „impressionist“

- „surreal“, „dreamlike“, „ethereal“

- „high contrast“, „moody atmosphere“, „lens flare“

- „depth of field“, „bokeh effect“, „macro shot“

- „aerial view“, „isometric“, „top-down perspective“

- „product photography“, „corporate style“, „editorial“

- Kunststile referenzieren: Fügen Sie Stilreferenzen zu Epochen oder Kunstrichtungen (z. B. „Renaissance“, „Impressionismus“) hinzu.

- Technische Qualitätsangaben: Begriffe wie „8k“, „HDR“, „sharp focus“ verbessern die Detailgenauigkeit

- Prompt-Variation: Experimentieren Sie mit verschiedenen Versionen Ihres Grundprompts

- Domänenspezifische Begriffe: Verwenden Sie Fachbegriffe aus dem jeweiligen Bildbereich

Beispiele für verbesserte Prompts

| Ursprünglicher Prompt | Optimierter Prompt |

| „Ein Kaninchen trägt einen Raumanzug“ | „Ein Kaninchen trägt einen Raumanzug, Digital Art, Greg Rutkowski, Trending cinematographic artstation“ |

| „Mehrere Eisenbahngleise mit einem vorbeifahrenden Zug“ | „Mehrere Eisenbahngleise mit einem vorbeifahrenden Zug, hyperdetailed, artstation, cgsociety, 8k“ |

| „Ein vom Regen nasses Dach“ | „Ein vom Regen nasses Dach, intricate, elegant, highly detailed, digital painting, artstation, Concept Art, smooth, sharp focus, illustration.“ |

Technische Zusätze

Für die besonders Experimentierfreudigen können wir folgende Inspirationen geben:

| Prompt Zusatz | Effekt |

| Leica-Style | Einen bestimmten Stil von Kameraherstellern treffen |

| 150-mm-Sigma-Lens | Eine bestimmte Brennweite von einem speziellen Objektiv-Hersteller verwenden |

| UHD/8K/4K | Eine höhere Schärfentiefe erzeugen (erhöht nicht die Auflösung) |

| HEX #3396ff | Eine bestimmte Farbe erzeugen anhand von Farbcodes |

| 2:6 width-to-height ratio | Ein bestimmtes Bildverhältnis erzwingen |

Allerdings ist den Fotografen unter Ihnen zu sagen, dass man bei den allermeisten Modellen nicht erwarten darf, dass hier wirklich die Charakteristika bestimmter Linsen oder Kameramodelle korrekt umgesetzt werden. Überhaupt ist zu fotorealistischen Bildern anzumerken, dass sie meist an einer oder mehreren Stellen nicht den Gesetzen der Physik folgen, denen echte analoge oder digitale Kameras zwangsläufig unterworfen sind. Das führt teilweise zu unrealistischen Schärfeverläufen oder Lichteffekten.

Zusammenfassend ist die Generierung von Bildern mit KI heute noch wie ein Hüpfen von Stein zu Stein über einen Bach: Wir können Ihnen grundlegend sagen, wie ein guter Sprung aussieht, aber gelegentlich werden Sie nass werden.

Level 3: Finetuning

| Anwendungsszenario | Beschreibung |

| Markenkonsistente Bildgenerierung | Bilder mit Firmenlogo und CI für hohe Wiedererkennung. |

| Spezifische Produktabbildungen | Detaillierte Produktbilder |

| Bilder im firmeneigenen Stil | Konsistente Bilder im visuellen Stil des Unternehmens. |

| Personalisierte Marketinginhalte | Bilder mit spezifischen Elementen für gezielte Kampagnen. |

| Einzigartige visuelle Assets | Eigene Avatare, Icons und andere spezielle Grafiken. |

Was genau ist Finetuning?

KI-Bildmodelle bestehen aus mehreren Milliarden künstlicher Neuronen (Parametern). Nach dem Training haben diese Modelle die verschiedensten Konzepte (z. B. Auto, Sonnenlicht …) verstanden und Beziehungen zwischen Text und Bild hergestellt. Die zentrale Idee hinter Finetuning ist das ressourcenschonende Lernen eines neuen Konzepts. Eine mögliche Methode dafür ist LoRa. Die Abkürzung steht für Low-Rank-Adaption. Statt das gesamte künstliche neuronale Netz zu aktualisieren, wird nur ein spezialisierter Teilbereich (Adapter) mit neuen Konzepten trainiert. Das ermöglicht es, Bildmodelle auch auf weniger leistungsfähiger Hardware mit einer begrenzten Anzahl an neuen Konzepten zu trainieren. In der Praxis bedeutet das: Große Bildmodelle können einfach und günstig mit unter anderem den eigenen Firmenlogos trainiert werden (finetuning).

Wie kann ich mein eigenes Modell feinabstimmen (DIY-Finetuning)?

Für die Feinabstimmung von KI-Bildmodellen sind drei Hauptkomponenten notwendig:

- Ein Trainingsdatensatz mit eigenen Bildern

- Ein offenes KI-Bildmodell, das Fine-Tuning unterstützt

- Ein leistungsstarker Rechner oder Server

Wir verwenden in dieser DIY-Anleitung den Anbieter Replicate. Er stellt leistungsstarke Server zur Verfügung und nimmt uns einige technische Schritte ab. Es gibt einige fortgeschrittenere Ansätze wie z. B. das Projekt ComfyUI, die aber den Rahmen dieses Deep Dives sprengen würden.

In einem ersten Schritt bauen wir ein Trainingsset an Bildern zu einem Konzept auf, was wir dem Modell beibringen wollen. Insbesondere das eigene Firmenlogo oder eine spezielle Person wie der Firmengründer sein. Hierfür stellen wir eine ZIP-Datei mit 1 bis 20 Varianten an Motiven, die das gewünschte Konzept enthalten, zusammen (beim Firmenlogo z. B. Icons, Logo in Schwarz und Weiß, Fotos des Firmenlogos auf der Firmenzentrale etc.; bei Personen mehrere verschiedene Ansichten, z. B. Kopf, Gesamtperson, Seitenansicht …).

Falls Sie nur eine Variante Ihres Wunschkonzepts haben, ist das auch in Ordnung. Es kann aber zu schlechteren Resultaten führen, da das Modell „nur“ ein Beispiel zum Lernen hat. Idealerweise erstellen Sie noch Varianten in anderen Perspektiven, Farbhintergründen und Texturen für optimale Ergebnisse. Beschriften Sie die Dateinamen der Bilder sorgfältig. Im folgenden Beispiel verwenden wir Fotos des geschäftsführenden Gesellschafters der heise group, Ansgar Heise:

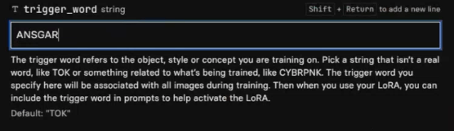

In einem zweiten Schritt definieren wir ein Trigger-Wort, welches das Modell mit dem neu beizubringenden Konzept verbindet. Wollen wir dem Modell z. B. unser heise group Firmenlogo antrainieren, lautet unser Trigger-Wort: heise_group_logo. Alternativ können Sie auch Kunstwörter wählen, wie z. B. hlogo. Wichtig ist: Das Wort sollte nicht schon im Trainingsdatensatz des Modells existieren und mit eigenen Konzepten verknüpft sein. „Hund“ oder „Apfel“ sind in den meisten Modellen schon als Konzepte besetzt und können nicht neu trainiert werden. In unserem Beispiel wählen wir „ANSGAR“:

Der letzte Schritt besteht aus einer Tasse ☕️, denn nun müssen Sie zwischen 10 und 20 Minuten warten, bis das Training abgeschlossen ist.

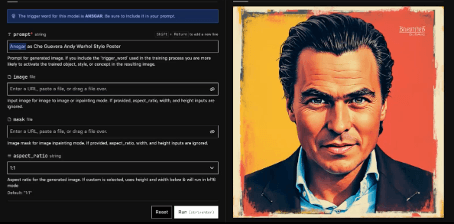

Jetzt können Sie das Konzept in Ihre Prompts einbauen. Wenn wir nun also „ANSGAR“ in unsere Prompts integrieren, hat das Modell das Konzept gelernt und kann damit Bilder generieren:

Testergebnisse: Welches Modell eignet sich für welche Anwendung?

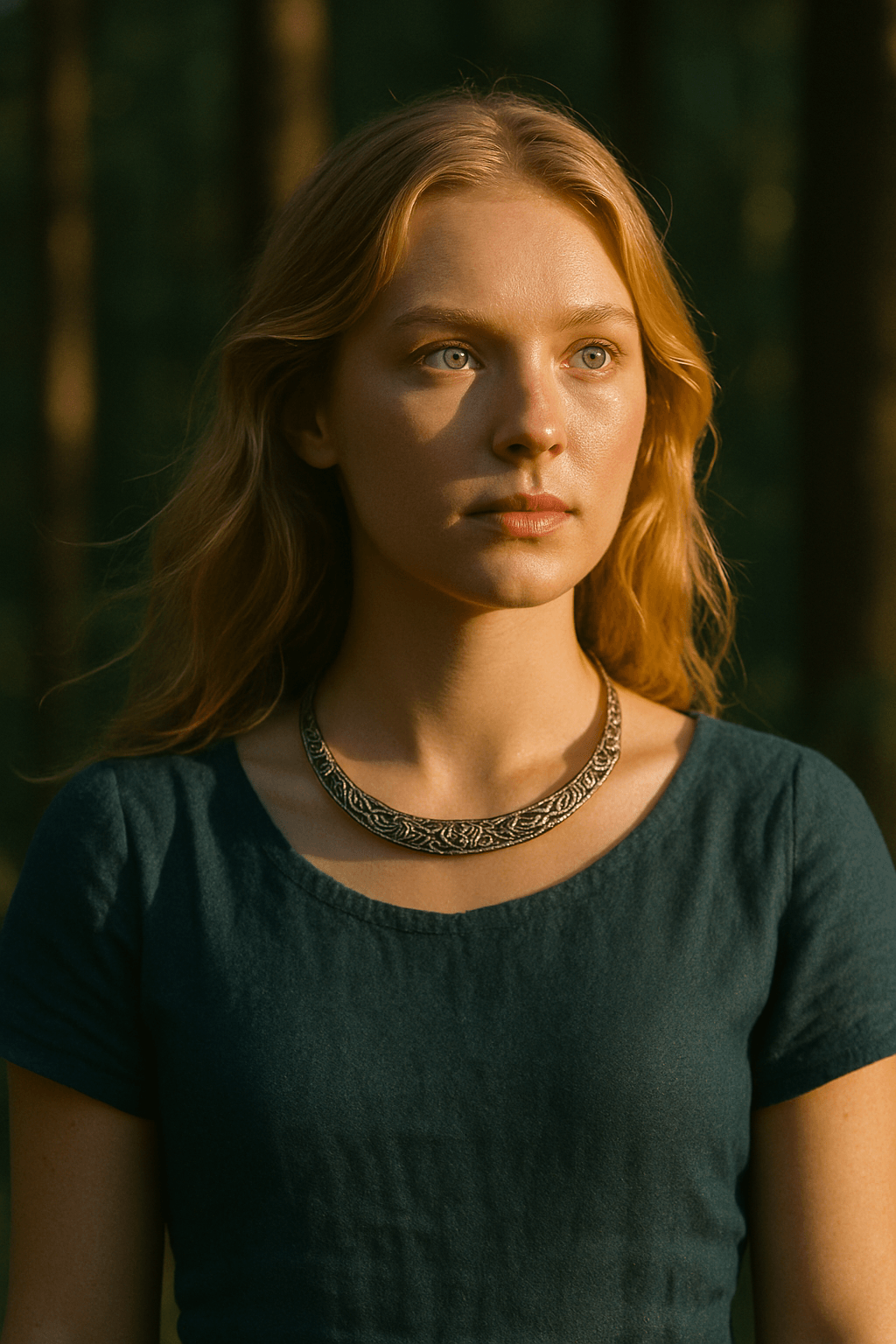

Anwendungsszenario: Portraitfoto

Promptdesign

Das häufigste Motiv der meisten Fotografinnen und Fotografen bleibt der Mensch. Das Porträt ist in jedem Unternehmen relevant und der Klassiker unter den Tests von KI-Bildmodellen. Für unseren Prompt war uns wichtig, die Modelle in drei Bereichen besonders herauszufordern: Licht, Schärfeverlauf und Texturen. Wir haben dafür folgenden Prompt angelegt:

A portrait photo of a young woman with blonde hair, blue eyes and a traditional celtic bracelet around her neck. She is standing in a forest. She is lit from the right side by the bright sun, creating realistic shadows and warm light accents on her face. Kodak film style, 85 mm lens.Aus Erfahrung wissen wir, dass die Anweisung an eine bestimmte Lichtquelle (hier die Richtung) viele Modelle vor Herausforderungen stellt. Die Wahl des Objektivtyps oder der Brennweite ist in manchen Trainingsdaten hinterlegt und kann durch gezieltes Prompting künstlich erzeugt werden – genauso wie der Film-Stil (hier: Kodak, also etwas in rötlich-orange verschobene Farben). Das Halsband („traditional celtic bracelet“) korrekt zu generieren, ist für die meisten Modelle schwer. Komplizierte, ineinander verschlungene Muster sind ein typischer Fallstrick heutiger KI-Bildmodelle, da sie oft verschwommen oder unnatürlich generiert werden.

Testergebnisse

Die Generierung von realistischen Menschen ist die älteste Disziplin von KI-Bildmodellen (neben Katzen, natürlich 😉). Das zeigt sich auch klar an den Ergebnissen: In keinem anderen unserer Tests schneiden so viele Modelle gut bis sehr gut ab. Das liegt vermutlich an der Flut an Bildern von Menschen in den Trainingsdatensätzen. Es gibt wohl kaum ein Motiv, das so häufig und gut fotografiert wurde. Dementsprechend wenig überraschend sind die einwandfreien Bilder der meisten Modelle (flux-1.1-pro, Recraft v3, Imagen 3, Midjourney v7). Positiv lässt sich Ideogram v3 hervorheben, das besonders realistische Lichteffekte zaubern kann.

Unser Testsieger ist das herausragende GPT-4o (heute GPT-5): Die neue technische Architektur des Modells ist leistungsstärker als die Konkurrenz in allen getesteten Dimensionen. Die Porträts sind fast nicht von echten Fotos zu unterscheiden und gestochen scharf. Die Prompts werden zuverlässig ausgeführt und haben selten deutliche Bildfehler. Sogar die Brennweite und der Kodak-Look werden imitiert. Allerdings kann primär die Brennweite in unserem Test nicht mit dem realen Schärfeverlauf eines physischen Objektivs mithalten. Da ist dann etwa das Gesicht in ganzer Fläche scharf, obwohl die Bluse auf gleicher Ebene schon unscharf gezeigt wird. Aber da auch manuell aufgenommene Kamerabilder immer stärker durch KI beeinflusst werden – vorrangig bei Mobilaufnahmen –, wird dies immer weniger deutlich als KI identifizierbar.

Enttäuschend schnitt dagegen das technisch veraltete Stable Diffusion 3.5 Large ab. Adobes Firefly v2 überrascht ebenfalls mit schlechten Ergebnissen. Hier hätten wir vom Platzhirsch in der Bildbearbeitung mehr erwartet. Das Modell hält sich jedoch kaum an Prompts und Fotos sehen eher weichgezeichnet als realistisch aus.

Empfehlung: GPT-4o, Midjourney v7 oder Ideogram 3.

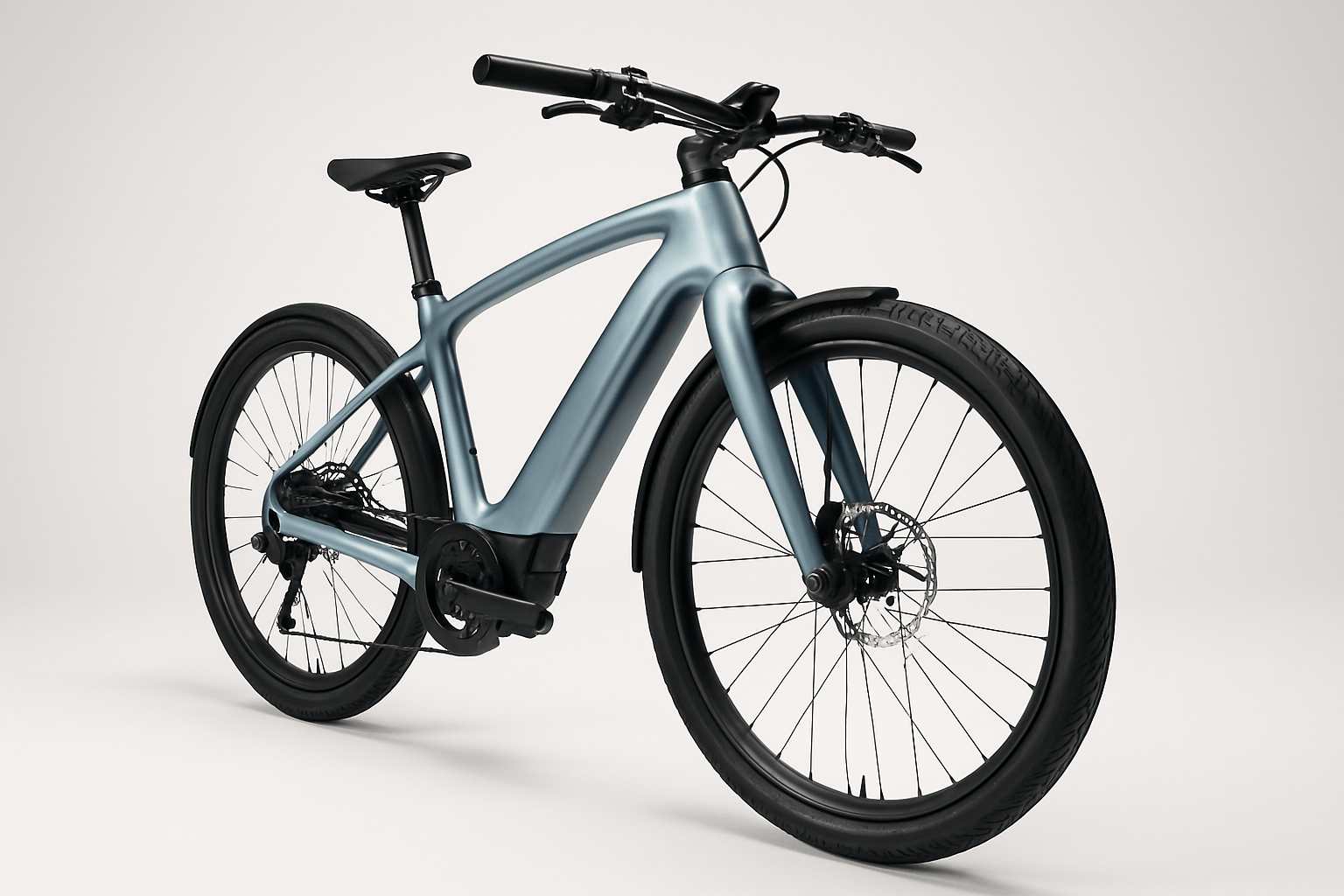

Anwendungsszenario: Product Shot

Promptdesign

Die zweite typische fotografische Kategorie, die sowohl im Unternehmens- als auch im journalistischen Alltag häufig benötigt wird, sind Aufnahmen von Gegenständen im weitesten Sinne – sei es eine Produktaufnahme oder ein Gegenstand wie ein Telefon oder ein Koffer, der zur Illustration von Konzepten wie „Kontakt“ oder „Urlaub“ eingesetzt werden soll. Das Anforderungsprofil für das Bildmodell ist hier deutlich anders als beim Porträt: Zum einen weisen viele Gegenstände gerade Linien (z. B. Speichen beim Fahrrad) und manchmal komplexe Details (z. B. Hinterrad-Schaltung beim Fahrrad) auf, die korrekt wiedergegeben werden müssen. Zum anderen ist auch die Lichtsituation eine gänzlich andere. In der Regel wird sehr weiches (Studio-)Licht eingesetzt, das aber dennoch die Konturen des Gegenstandes gut herausarbeitet. Wir haben ein Fahrrad als komplexes und für die Modelle schwieriges Motiv ausgewählt:

Create a high-quality, wide-angle product shot of a metallic light blue eBike. The image is taken in a controlled studio environment with a clean white background. Use soft yet sculpting studio lighting that emphasizes the curves and aerodynamic silhouette of the bike. The bike is positioned at a 3/4 front angle to showcase both front and side design lines. Reflections are minimal and controlled to highlight the surface quality.The image is captured through the visual characteristics of a Canon 18mm wide-angle lens – subtle barrel distortion, dynamic perspective, and slight foreground emphasis. Final style: ultra-realistic, crisp, and suitable for a premium catalog or marketing campaign.

Testergebnisse

Auf den ersten Blick sehen die meisten Fahrradabbildungen brauchbar aus. Allerdings gelingt es nur den Modellen Midjourney v7, Imagen 3 und GPT-4o, die im Prompt geforderte Ansicht von schräg vorn zu erzeugen. flux-1.1-pro und Stable Diffusion 3.5 Large erzeugen zwar ein recht realistisches Bild, aber nur von der Seite. Firefly v2 gelingt es gar, ein Bild von hinten zu erzeugen, und weist starke Mängel beim Realismus auf. Ideogram 3 und Recraft v3 kennen offenbar den Fachbegriff „Product Shot“ nicht und zeigen auch noch das ganze Studio drumherum. Bei Ideogram 3 stimmt auch die geforderte Lichtsituation nicht. Ebenso bei Firefly v2. Abwertungen gab es auch für mangelnde Prompttreue und fehlerhafte Details. Speichen biegen sich oder Zahnkränze sind nicht richtig rund. Fast alle – sogar das sonst so hervorragende GPT‑4o – haben Schwierigkeiten mit Text (z. B. als Marke auf den Reifen). Generell kann festgehalten werden: Gerade für Produktbilder kann das Feinabstimmen der Modelle ein echter Gewinn sein, da hier echte Produktbilder die Ergebnisse verbessern.

Empfehlung: Imagen 3 und flux-1.1-pro

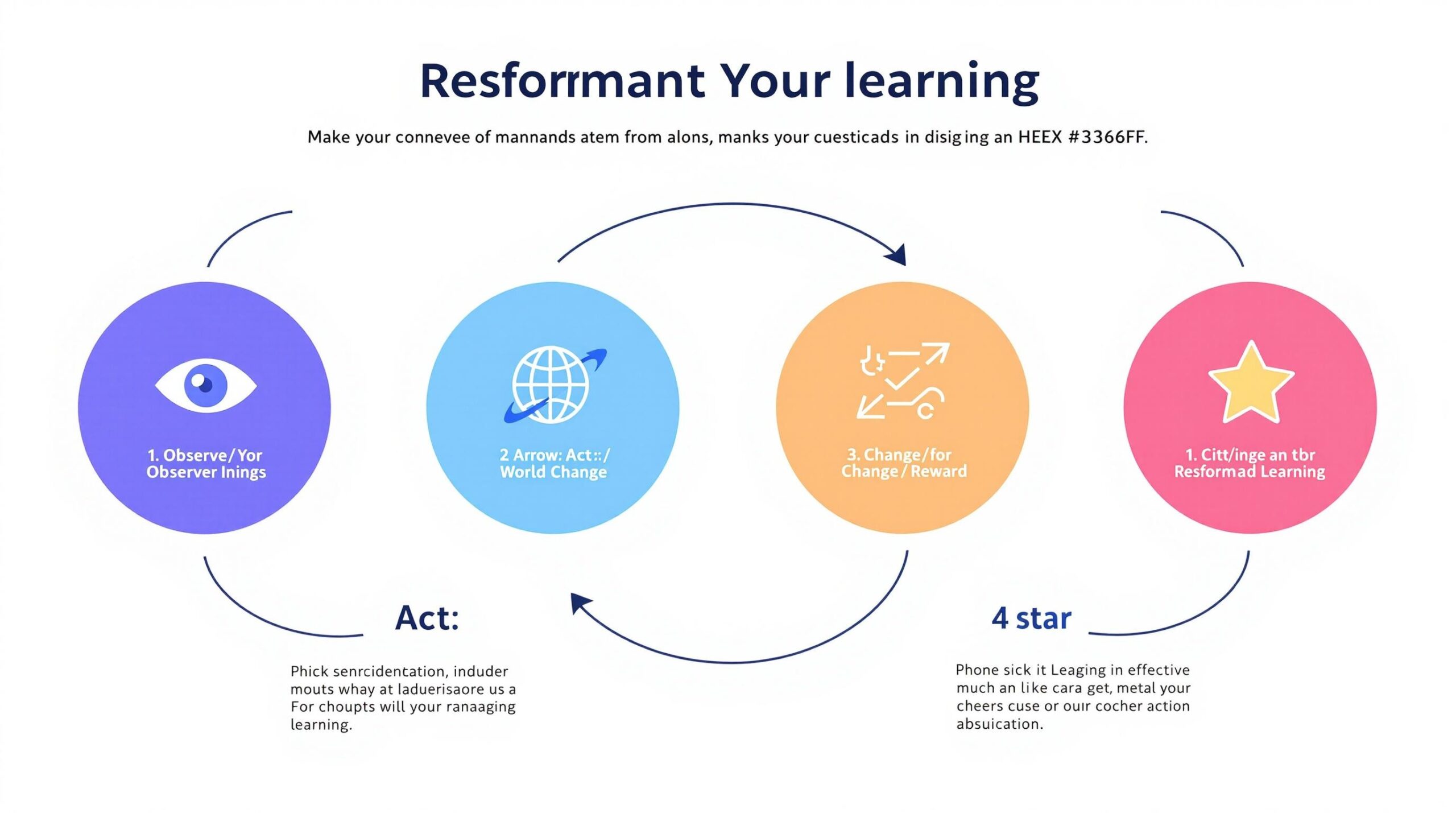

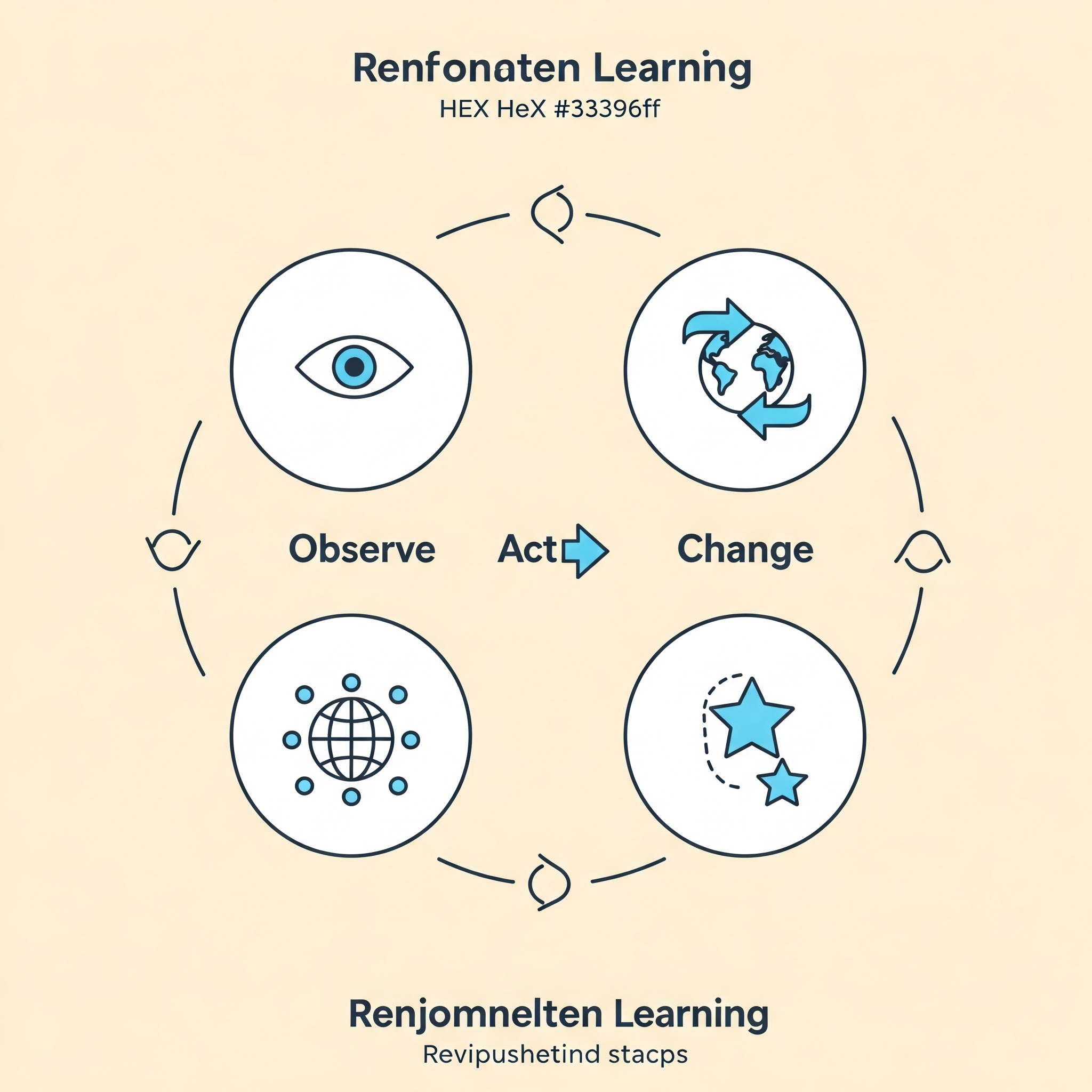

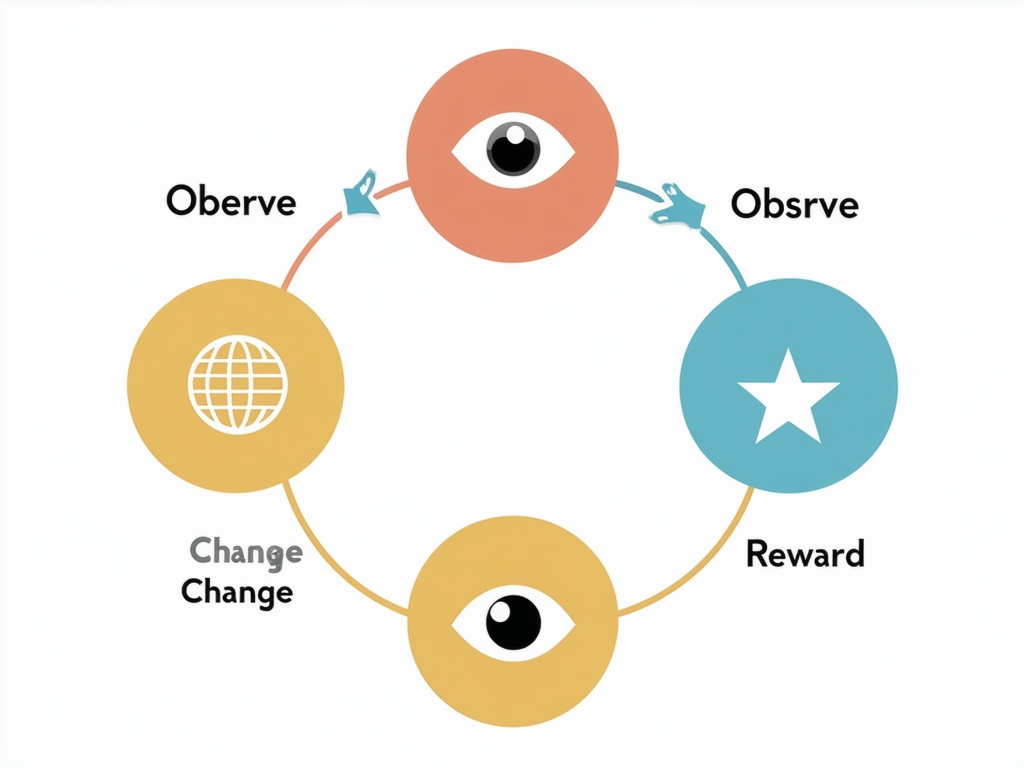

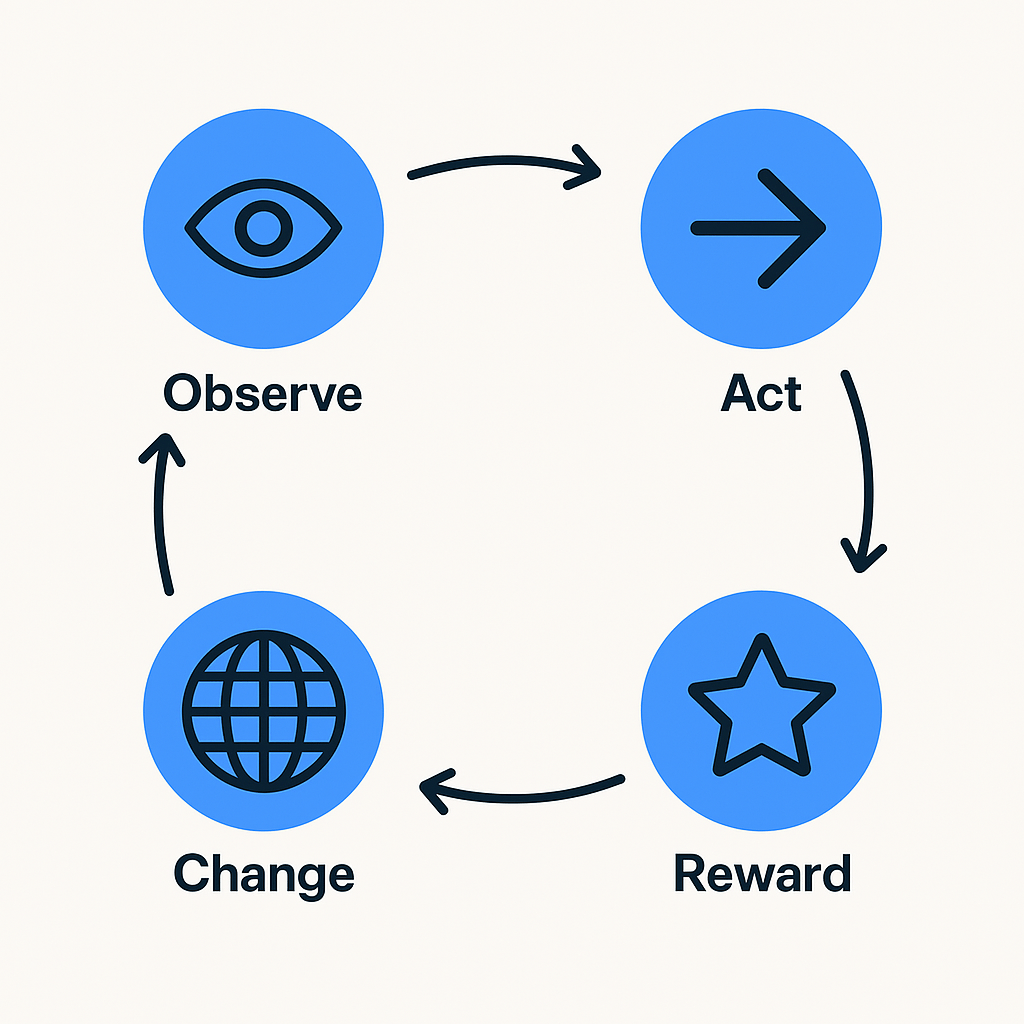

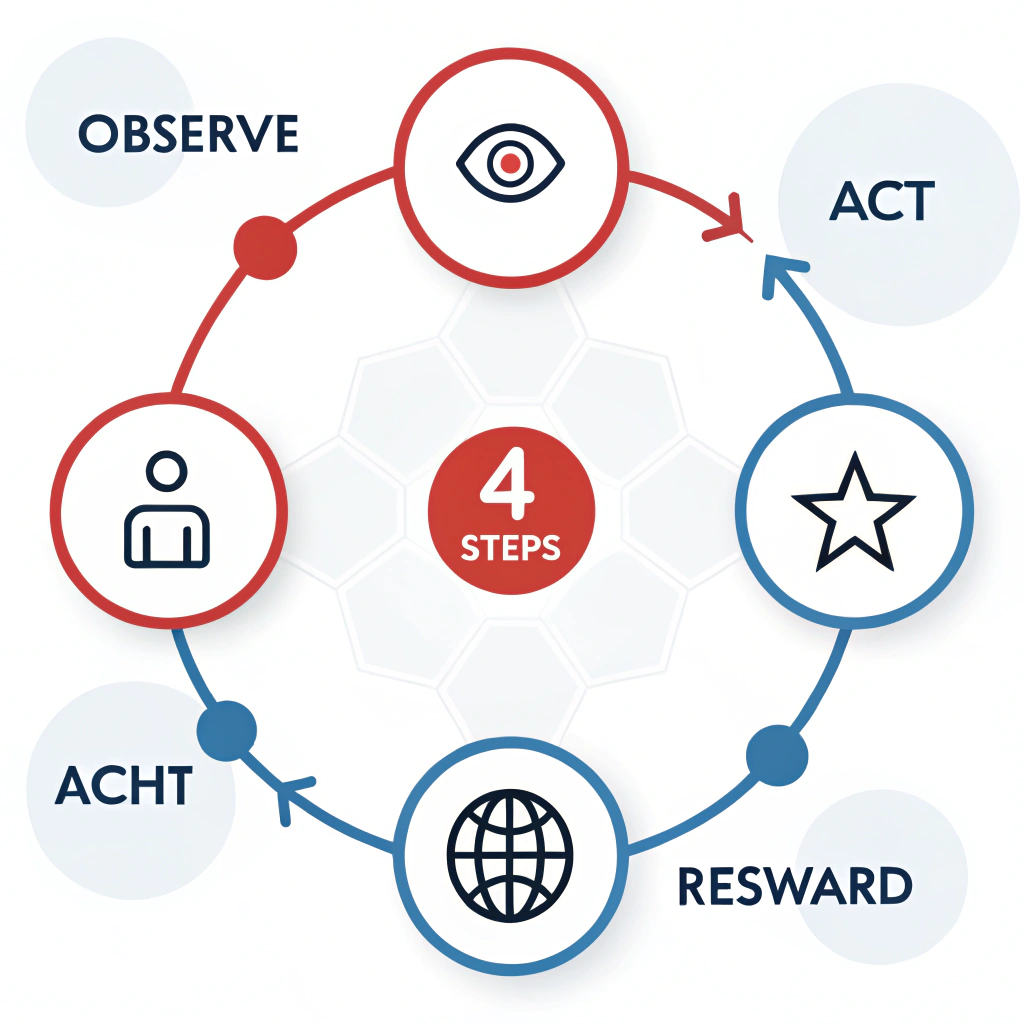

Anwendungsszenario: Infografik

Promptdesign

Eine der schwierigsten Herausforderungen für Bildmodelle ist die Generierung von Text. Die „Bauart“ der Modelle (besonders bei Diffusionsmodellen) ist nicht auf genaues Schreiben spezialisiert, sondern auf ansprechende Bilder. Dennoch ist eine häufige Anforderung in vielen Branchen, Informationen zugänglich zu präsentieren. Infografiken können im besten Fall schwer zu erklärende Konzepte einfach verständlich machen. Für unseren Test haben wir daher eine Grafik mit vier Prozessschritten, Icons und Beschriftungen erarbeitet, die für menschliche Grafiker ein eher geringes Schwierigkeitsniveau darstellt.

A simple, clean infographic showing the 4 steps of reinforcement learning as a circular diagram. Minimalist design with 4 connected circles containing simple icons: (1) an eye symbol for 'Observe', (2) an arrow for 'Act', (3) a world/globe symbol for 'Change', and (4) a star for 'Reward'. The circles are connected by curved arrows forming a cycle. Use a light background with bold, clear lines and a modern color scheme around HEX #3396ff . Flat design style, similar to educational infographics.

Testergebnisse

Alle reinen Diffusionsmodelle haben erwartungsgemäß Schwierigkeiten mit der Erzeugung von Text. Firefly v2, Midjourney v7 und Stable Diffusion 3.5 Large schneiden hier am schlechtesten ab. Meistens schaffen sie es erst gar nicht, lesbaren Text darzustellen. In einer zweiten Gruppe sammeln sich flux-1.1-pro, Recraft v3, Imagen 3 und Ideogram 3 mit mittelmäßigen Ergebnissen: Zwar sind einige der Texte lesbar, allerdings nicht in einer Zuverlässigkeit, dass die Modelle einen professionellen Einsatz erlauben. Wenn die Anfertigung einer Infografik zu einem Glücksspiel verkommt, muss man auf etablierte Werkzeuge – oder Dienstleister – zurückgreifen.

Wäre da nicht GPT-4o. Das Modell erledigt die Aufgabe mit Bravour und reiht sich an die Spitze dieses Tests. Der Text ist lesbar, die Icons fast exakt in der gewünschten Farbe. Der Stil ist ansprechend und die Anordnung der Symbole korrekt. Sogar das Nachbearbeiten mit kleineren Änderungen an der Grafik funktioniert. Was will man mehr? In einigen sehr langen Prompts abseits dieses Tests verlor sich das Modell etwas in Details und zu Tippfehlern kommt es auch noch gelegentlich, aber das kann bei so guten Ergebnissen im Schnitt verziehen werden. GPT-4o ist dennoch die klare Empfehlung in diesem Bereich.

Dennoch sind umfangreiche Infografiken zur Visualisierung derzeit noch eine Herausforderung. Je mehr Elemente verwendet werden müssen und je mehr Schrift enthalten ist und je korrekter all das sein muss, desto mehr Geduld ist aktuell noch erforderlich. Meist schleicht sich nämlich ein kleiner Fehler an einem anderen Ort ein. Bei der Nachbesserung ist GPT-4o zwar gut, aber verändert in der Regel ein weiteres Detail. Bis man gänzlich zufrieden ist, können mehrere zeitaufwendige Durchläufe vergehen. Da greifen Image-Profis derzeit eher noch zum herkömmlichen Bildbearbeitungsprogramm und verbessern dort schnell manuell.

Empfehlung: GPT-4o

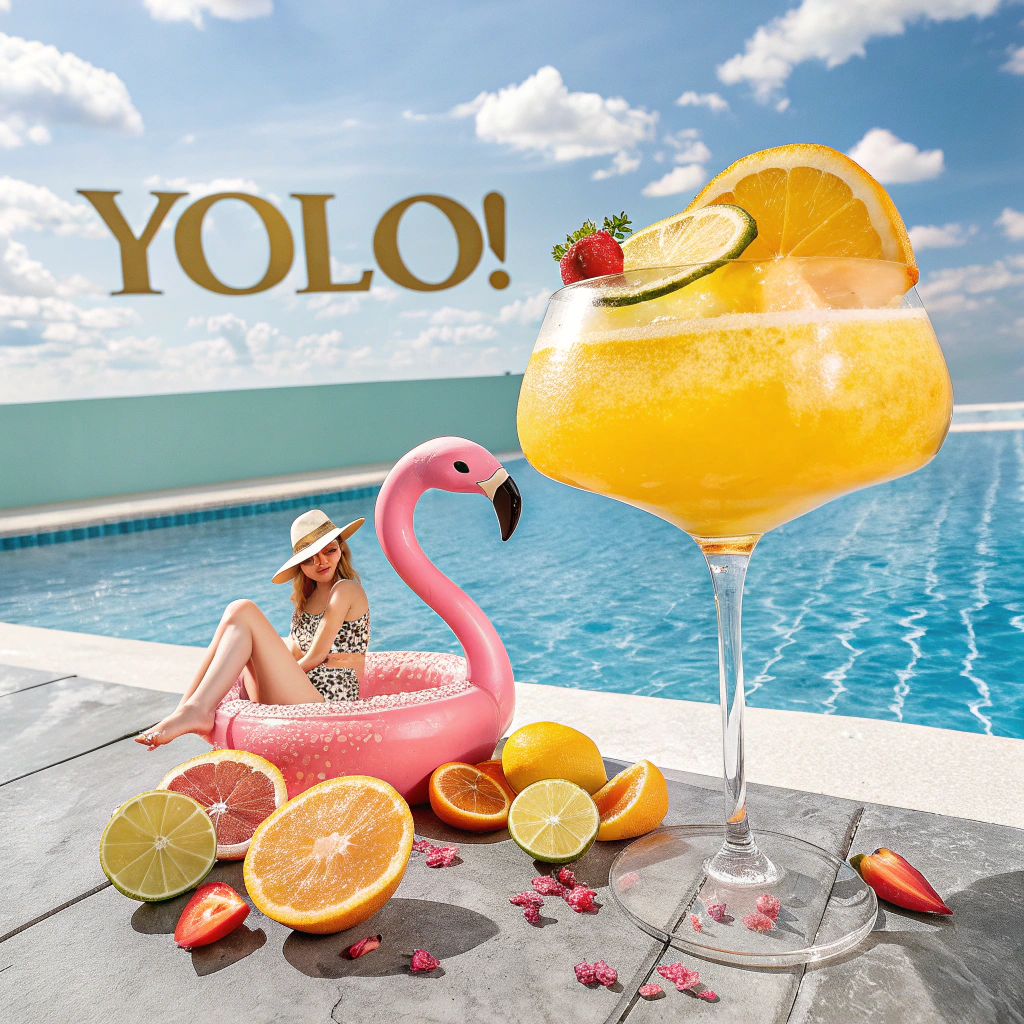

Anwendungsszenario: Illustration

Promptdesign

Durch die Flut an Stockfotos werden im Editorial-Bereich mittlerweile sowohl im Journalismus als auch von Unternehmen gerne gemalte oder gezeichnete Illustrationen als „Hingucker“ verwendet. Die Anforderungen an das Bildmodell sind dabei deutlich anders – es gibt eine gewisse „künstlerische Freiheit“, aber eine ästhetisch stimmige Komposition muss trotzdem entstehen. Für unseren Test haben wir uns an einem Motiv orientiert, das etwa zur Illustration eines Texts zum Thema Urlaub oder Reise benötigt werden könnte. Als zusätzliche Herausforderung haben wir einen Text („YOLO“) in den Prompt eingebaut.

Create a tall, modern summer-themed illustration (2:6 width-to-height ratio) suitable for a tabletop magazine article. Use vibrant, saturated colors that evoke the feeling of sunshine, vacation, and poolside relaxation.

The composition should feature the following elements:

– A large cocktail glass at the center, with a woman casually sitting inside the glass in a playful, relaxed pose.

– A pink flamingo, either near the glass or interacting with the scene.

– Citrus fruit slices (e.g. lemon, orange) as decorative elements, possibly inside or around the glass.

– A swimming pool element integrated into the scene (e.g. in the lower area).

– A dreamy background with stylized water or soft clouds.

– The word ‘YOLO!’ in bold, eye-catching text, integrated into the design as part of the composition.

Style: flat illustration or vector-like, magazine-appropriate, with clear shapes and strong contrast.

Testergebnisse

Erwartungsgemäß gelingt es vielen Modellen nicht, die verschiedenen Herausforderungen unseres Prompts zu meistern: Am bemerkenswertesten daneben liegt Recraft v3, das statt der geforderten Illustration ein Foto liefert – das außerdem nicht mal besonders ästhetisch gelungen ist. Bei einem Schulaufsatz hieße das „Thema verfehlt“.

An der Schrift scheitern Midjourney v7 und Firefly v2. Ebenfalls häufig nicht gelungen sind Pose und halbwegs realistische Figur der geforderten sitzenden Frau. Auch wenn man künstlerische Freiheit zubilligt, wirken die Ergebnisse von Stable Diffusion 3.5 Large und Imagen 3 nicht mehr stimmig.

Die Farbstimmungen sind interessanterweise bei den meisten dagegen gut getroffen.

Rundum überzeugen mit hoher Prompttreue und einem stimmigen Gesamtergebnis konnten uns flux-1.1-pro und GPT-4o.

Empfehlung: GPT-4o, flux-1.1-pro

Best Practices: Rechtliche Aspekte – Wie darf ich KI-Bildmodelle einsetzen?

Wie bei vielen Einsatzgebieten im Bereich KI hinkt die Rechtsprechung hinter der Realität her. Die rechtliche Lage heute lässt sich mit einem Satz zusammenfassen: Ja, Sie dürfen generierte Bilder verwenden, sie gehören aber nicht Ihnen. Die Auslegung wird sich vermutlich in den nächsten Jahren noch ändern. Das deutsche Recht sieht in der Formulierung von präzisen Prompts keine intellektuelle Leistung (waren Arbeitsaufträge mittelalterlicher Mäzene an ihre Künstler ein Beitrag zum Werk?). Ob sich diese Auslegung mit der stetig wachsenden Verwendung halten lässt, wird sich zeigen. Wenn jedoch mehr Menschen mit dieser Technik Werke erschaffen, muss sich vermutlich das Recht an die neue Realität anpassen.

Wir haben die wichtigsten Fragen im Folgenden für Sie zusammengefasst. Falls Sie tiefer in die Thematik einsteigen wollen, empfehlen wir unseren Deep Dive zum Thema KI-Urheberrecht.

F: Sind KI-generierte Bilder urheberrechtlich geschützt?

A: Im Normalfall sind KI-generierte Inhalte wie Texte und Bilder nicht urheberrechtlich geschützt. Ihnen fehlt die Voraussetzung einer schützbaren geistigen Schöpfung: das menschliche Schaffen. KI-Systeme können zwar beeindruckende Texte, Bilder und andere Inhalte erzeugen, die kreativ und neuartig wirken. Jedoch handelt es sich dabei eben nicht um persönliche Schöpfungen, sondern um das Ergebnis algorithmischer Berechnungen auf Basis der Trainingsdaten.

F: Was bedeutet es, dass KI-generierte Inhalte nicht urheberrechtlich geschützt sind?

A: Die fehlende Urheberschaft hat zur Folge, dass KI-generierte Inhalte gemeinfrei sind. Damit können sie von jedermann frei genutzt werden, ohne dass Lizenzen eingeholt oder Vergütungen gezahlt werden müssen. Wenn Sie also auf Social Media ein KI-Bild posten, dann ist das nicht urheberrechtlich geschützt.

F: Gibt es Ausnahmen vom fehlenden Urheberrechtsschutz für KI-Inhalte?

A: Grundsätzlich sind KI-generierte Inhalte nicht rechtlich geschützt. Es gibt jedoch einige Ausnahmen. Die wichtigste ist die Verwendung bekannter Persönlichkeiten, Comic-, Gaming- oder Filmfiguren. Hier können Persönlichkeits- und Urheberrechte verletzt werden. Manche KI-Bildmodelle setzen dies schon in ihren Content-Richtlinien um und verbieten die Generierung.

F: Darf man den Stil berühmter Künstler auf KI-Bildern imitieren?

A: Ein Bild im Stil von Dali oder Gerhard Richter generieren zu lassen, ist grundsätzlich erlaubt. Denn das Urheberrecht schützt nur konkrete Werke, nicht aber den grundsätzlichen Stil eines Künstlers, Texters oder Autors.

F: Müssen KI-generierte Inhalte als solche gekennzeichnet werden?

A: Derzeit besteht keine Verpflichtung zu einer solchen Kennzeichnung, auch wenn ein solcher Hinweis zur Schaffung von Transparenz beitragen könnte. Aber: Der AI Act führt solche Pflichten für KI-generierte Inhalte ein, um deren künstliche Herkunft transparent zu machen.

F: Dürfen fremde Inhalte zum Training der KI aus dem Internet ausgelesen werden?

A: Die Antwort wird für viele überraschend sein: Ein solches Auslesen ist nach dem deutschen Urheberrechtsgesetz, das hier auf europäischen Vorgaben basiert, grundsätzlich erlaubt. Der Paragraf 44b des Urheberrechtsgesetzes (UrhG) regelt das sogenannte Text- und Data-Mining und gestattet die Vervielfältigung von rechtmäßig zugänglichen Werken für diesen Zweck.

F: Kann ich die Verwendung meiner Inhalte für KI-Training untersagen?

A: Als Ausgleich für die weitreichenden Freiheiten bei der Sammlung von Inhalten für das KI-Training hat der Gesetzgeber tatsächlich eine solche Möglichkeit eines Opt-outs vorgesehen. Dieses regelt der nach Aussagen von Fachleuten wie Joerg Heidrich (Heise Justiziar) „reichlich missglückte“ Paragraf 44b Abs. 3 UrhG. Danach ist der Zugriff auf bereitgehaltene Inhalte nur zulässig, wenn sich der Rechtsinhaber das Recht zur Nutzung nicht vorbehalten hat.

F: Welche Haftungsrisiken bestehen bei der Veröffentlichung fragwürdiger Inhalte?

A: Wer KI-Inhalte veröffentlicht, die Urheber- oder Persönlichkeitsrechte verletzen, haftet dafür. Das bloße Argument, die Inhalte seien von einer KI erstellt worden und das Unternehmen habe nur begrenzten Einfluss darauf gehabt, entbindet in der Regel nicht von dieser Haftung.

F: Welche praktischen Tipps gibt es im Bereich Urheberrecht und KI?

A: Hier sind einige Vorsichtsmaßnahmen:

- Vermeidung der Nutzung geschützter Werke in Prompts für KI-Systeme, insbesondere keinen Upload von Bildern.

- Keine KI-Bilder von (bekannten) Personen, Film- oder Comicfiguren ohne Einverständnis der Personen/Urheber.

- Implementierung von Kennzeichnungspflichten für KI-generierte Inhalte, insbesondere von Bildern.

- Klare vertragliche Regelungen mit KI-Anbietern bezüglich der Nutzungsrechte und Haftung.

- Schulung von Mitarbeitern im Umgang mit KI-Tools und urheberrechtlichen Fragen.

- Regelmäßige Überprüfung und Anpassung der Compliance-Richtlinien in Bezug auf KI-Nutzung.

Best Practices: KI-Leitfaden für den Einsatz in Unternehmen

Wie Ihr Unternehmen den Umgang mit KI-Bildmodellen regeln sollte, hängt von Ihrer strategischen Ausrichtung im Bereich KI ab: Wollen Sie eine Vorreiterrolle spielen, oder auf etablierte Technologien setzen? Bei einem größeren kreativen Spielraum mit dem öffentlichen Bild der Firma (wie z. B. bei einer Werbeagentur) kann der Umgang mit KI-Bildmodellen freier gestaltet werden. In Branchen, in denen die Durchgängigkeit einer Markenbotschaft wichtig ist, könnten strengere Regeln von Vorteil sein.

Festzuhalten ist aber aus unserer Erfahrung eine goldene Regel (die sich nicht nur auf Bildmodelle beschränkt): Lassen Sie Ihre Mitarbeitenden nicht allein! Studien zeigen klar, dass Mitarbeitende KI am Arbeitsplatz einsetzen, ob erlaubt oder nicht.

Ein offener, nachvollziehbarer und einfach verständlicher KI-Leitfaden gibt Orientierung und verhindert PR-Debakel. Einen Muster-Leitfaden für den allgemeinen Einsatz von KI in Unternehmen finden Sie hier. Die Grundpfeiler eines ausgewogenen Leitfadens zwischen „Innovation möglich machen!“ und „Lasst uns die Rechtsabteilung möglichst in Ruhe lassen!“ haben wir für Sie zusammengefasst:

Prüfen Sie die Notwendigkeit

Ist eine Generierung der beste Weg zu Ihrem Ziel? Freie oder bezahlte Datenbanken für professionelle Bilder bieten qualitativ hochwertige Werke zu fairen Preisen. Die Generierung von Bildern – zumindest im großen Stil – ist teuer für Ihr Unternehmen und für die Umwelt. Die fehlende Kontrollierbarkeit der Modelle kann die Einhaltung von Stilprinzipien („brand/corporate guidelines“) ihres Unternehmens schwierig machen.

- Achten Sie auf Details

Selbst geübte Fotografen oder erfahrene digitale Künstlerinnen und Künstler übersehen kleine Fehler. Besonders bei Zahlen und Texten ist Vorsicht geboten, da sich viele Modelle noch schwer damit tun. Prüfen Sie KI-Bilder noch genauer als Fotos. - Generieren Sie keine echten Menschen oder Marken

Verwenden Sie keine Bilder als Referenzmaterial für die Bildgenerierung, die nicht ausdrücklich hierfür freigegeben sind. Selbst von Ihnen gekaufte Bilder sind vermutlich nicht von den Künstlern freigegeben, in das Trainingsmaterial von KI-Modellanbietern überzugehen. Generieren Sie keine Bilder, die echte Menschen (bekannte Persönlichkeiten oder real existierende Menschen ohne Einverständnis) zeigen. Geschütztes Material wie Markenlogos, Comicfiguren oder Filmcharaktere ist zwar bei einigen Modellen generierbar, kann aber rechtliche Konsequenzen für Sie haben, sollten Sie es kommerziell verwenden. - Kennzeichnen Sie Ihre KI-Bilder

Fügen Sie den Zusatz „Generiert von [Firma] mit [Modell]“ als Quellenangabe für Ihre Bilder hinzu. Das schafft Vertrauen und Transparenz. - Prüfen Sie die Konsequenzen für fehlende Urheberschaft

Da generierte Bilder grundsätzlich nicht urheberrechtlich geschützt sind, sollten Sie die Folgen prüfen, wenn sich andere Personen oder Unternehmen ihrer Bilder bedienen. Falls Sie sich das Urheberrecht an diesem Bild sichern wollen, verarbeiten oder verändern Sie Ihre Bilder manuell so weiter, dass eine gewisse Schöpfungshöhe erreicht wird. Damit schreiten Sie in den Graubereich des deutschen Urheberrechts. Ob Sie sich darin wohlfühlen, bleibt Ihnen überlassen.

Fazit

Der professionelle Einsatz von KI-Bildern ist heute praxistauglich und sollte von Unternehmen geprüft und getestet werden, um eine Urteilsfähigkeit zu erreichen. Allerdings gilt dies für verschiedene Arten von Bildern in sehr unterschiedlichem Maß: Fotos von Menschen sind mittlerweile mit etwas Geduld und guten Prompts so realistisch erzeugbar, dass nur sehr geübte Fotografen oder Bildredakteure noch erkennen, dass sie nicht mit einer realen Kamera und echten Menschen aufgenommen worden sind.

In etwas geringerem Maß gilt dies für die Aufnahme von Gegenständen. Komplexe Produkte wie das Fahrrad in unserem Test erfordern mehr Geduld für viele Fehlgenerierungen und sehr exaktes Prompting. Dennoch sind meist in kleinen Details (z. B. Speichen, Zahnkränze, Schaltung) Fehler zu erkennen. Wer reale eigene Produkte realistisch zeigen will, muss Finetuning-Methoden wie LoRA nutzen – ohne diese können nur sehr bekannte Produkte und Marken erzeugt werden (in unserem Test etwa ein Porsche Taycan, der kaum vom Product Shot der Website zu unterscheiden war).

Grafische Darstellungen wie eine Illustration sind mittlerweile ebenfalls bei einigen Modellen so erzeugbar, dass sie im Unternehmensalltag gut eingesetzt werden können. Auch hier wird dafür neben einem hervorragenden Prompt ein wenig Hirnschmalz notwendig, da die Bandbreite der Ergebnisse auch bei guten Modellen recht breit ist.

Ein Sonderfall sind Infografiken: Hier können mittlerweile durch multimodale Modelle die GPT-4o beeindruckende Ergebnisse erzielt werden. Einen echten Infografiker ersetzen sie aber bisher nicht.

Zwei Modelle setzen sich in unserem Text durch: GPT-4o und flux-1.1-pro. Beide überzeugen durch Verlässlichkeit und gute Ergebnisse. GPT-4o ist die beste kommerzielle Wahl, die flux-Modellreihe die beste Open-Source-Wahl. Wollen Sie Infografiken erstellen, ist die einzig sinnvolle Wahl GPT-4o.

Generell empfehlen wir, sich möglichst unabhängig von einzelnen Modellen zu machen, aufgrund der hohen Geschwindigkeit an Innovationen in diesem Feld. Die führenden Modelle von heute können innerhalb von wenigen Monaten überholt sein (wie z. B. Midjourney v6.1). Das ist jedoch leichter gesagt als getan. Im Umgang mit den zahlreichen Modellen und deren Weboberflächen oder Schnittstellen (APIs) ist uns die fragmentierte Marktsituation negativ aufgefallen. Eine einzelne Plattform für alle Modelle (und möglichst noch in Europa) gibt es heute nicht. Einzelne Plattformen wie AI/ML bieten auf amerikanischen Servern eine große Auswahl an KI-Bildmodellen, in Europa fehlt diese Option.

Zusammenfassend sind die Ergebnisse beeindruckend: KI-Bilder sind heute kaum von echten Fotos zu unterscheiden. Sie sind schnell zu erzeugen, nehmen Arbeit im Alltag ab und können echte Inspiration für Menschen sein. Fremde Welten und neue Ideen zu erzeugen, war noch nie so unterhaltsam und einfach. Dementsprechend positiv sind wir der Verwendung im Arbeitsalltag gegenüber eingestellt. Wenn Sie grundlegende rechtliche Regeln im Umgang beachten, Ihre Mitarbeitenden schulen und leicht verständliche Leitlinien aufstellen, steht dem Einsatz in Ihrem Unternehmen nichts entgegen.

Appendix

Testergebnisse im Detail

↔ Diese Tabelle ist horizontal scrollbar

| Bewertung | ||||||||||

|---|---|---|---|---|---|---|---|---|---|---|

| Use Case | Prompt | flux-1.1-pro | Recraft v3 | Imagen 3 | GPT-4o | Firefly V2 | Stable Diffusion 3.5 Large | Midjourney V6 | Midjourney v7 | Ideogram |

| Portrait | A portrait photo of a young woman with blonde hair, blue eyes and a traditional Celtic bracelet around her neck. She is standing in a forest. She is lit from the right side by the bright sun, creating realistic shadows and warm light accents on her face. Kodak film style, 85 mm lens. | 4 | 4 | 4 | 5 | 3 | 2 | 4 | 5 | 5 |

| Kriterien | Prompttreue | 3 | 5 | 4 | 5 | 3 | 2 | 5 | 5 | 4 |

| Fotorealismus | 4 | 4 | 4 | 5 | 2 | 2 | 3 | 4 | 5 | |

| Bildlogik/Fehler | 5 | 3 | 4 | 5 | 3 | 2 | 4 | 5 | 4 | |

| Ästhetik | 5 | 5 | 5 | 5 | 3 | 2 | 5 | 5 | 5 | |

| Infografik | A simple, clean infographic showing the 4 steps of reinforcement learning as a circular diagram. Minimalist design with 4 connected circles containing simple icons: (1) an eye symbol for 'Observe', (2) an arrow for ‚Act‘, (3) a world/globe symbol for 'Change', and (4) a star for 'Reward'. The circles are connected by curved arrows forming a cycle. Use a light background with bold, clear lines and a modern color scheme around HEX #3396ff. Flat design style, similar to educational infographics. | 3 | 3 | 3 | 5 | 1 | 2 | 2 | 2 | 3 |

| Kriterien | Prompttreue | 3 | 4 | 4 | 5 | 1 | 1 | 1 | 2 | 4 |

| Typografie | 3 | 2 | 3 | 5 | 1 | 3 | 3 | 1 | 4 | |

| Bildlogik/Fehler | 3 | 3 | 2 | 5 | 1 | 2 | 2 | 3 | 3 | |

| Ästhetik | 3 | 4 | 3 | 5 | 1 | 3 | 2 | 2 | 2 | |

| Magazin | Create a tall, modern summer-themed illustration (2:6 width-to-height ratio) suitable for a tabletop magazine article. Use vibrant, saturated colors that evoke the feeling of sunshine, vacation, and poolside relaxation. The composition should feature the following elements: A large cocktail glass at the center, with a woman casually sitting inside the glass in a playful, relaxed pose. A pink flamingo, either near the glass or interacting with the scene. Citrus fruit slices (e.g. lemon, orange) as decorative elements, possibly inside or around the glass. A swimming pool element integrated into the scene (e.g. in the lower area). A dreamy background with stylized water or soft clouds. The word 'YOLO!' in bold, eye-catching text, integrated into the design as part of the composition. Style: flat illustration or vector-like, magazine-appropriate, with clear shapes and strong contrast. | 2 | 3 | 3 | 5 | 2 | 3 | 2 | 2 | 4 |

| Kriterien | Prompttreue | 2 | 3 | 3 | 5 | 3 | 3 | 2 | 2 | 5 |

| Typografie | 1 | 2 | 2 | 5 | 1 | 3 | 1 | 1 | 4 | |

| Bildlogik/Fehler | 2 | 4 | 3 | 5 | 3 | 3 | 3 | 3 | 4 | |

| Ästhetik | 3 | 4 | 4 | 5 | 1 | 3 | 2 | 2 | 4 | |

| Produktbild | Create a high-quality, wide-angle product shot of a metallic light blue eBike. The image is taken in a controlled studio environment with a clean white background. Use soft yet sculpting studio lighting that emphasizes the curves and aerodynamic silhouette of the bike. The bike is positioned at a 3/4 front angle to showcase both front and side design lines. Reflections are minimal and controlled to highlight the surface quality.The image is captured through the visual characteristics of a Canon 18 mm wide-angle lens – subtle barrel distortion, dynamic perspective, and slight foreground emphasis. Final style: ultra-realistic, crisp, and suitable for a premium catalog or marketing campaign. | 4 | 2 | 5 | 3 | 1 | 2 | 3 | 3 | 3 |

| Kriterien | Prompttreue | 5 | 1 | 5 | 4 | 2 | 3 | 4 | 4 | 3 |

| Typografie | 3 | 2 | 3 | 3 | 1 | 1 | 2 | 1 | 2 | |

| Fotorealismus | 4 | 4 | 5 | 2 | 1 | 2 | 3 | 3 | 5 | |

| Bildlogik/Fehler | 4 | 2 | 5 | 2 | 1 | 2 | 3 | 2 | 3 | |

| Ästhetik | 5 | 3 | 5 | 4 | 1 | 3 | 4 | 4 | 3 | |

Prompts

A portrait photo of a young woman with blonde hair, blue eyes and a traditional celtic bracelet around her neck. She is standing in a forest. She is lit from the right side by a the bright sun, creating realistic shadows and warm light accents on her face. Kodak film style, 85 mm lens.A simple, clean infographic showing the 4 steps of reinforcement learning as a circular diagram. Minimalist design with 4 connected circles containing simple icons: (1) an eye symbol for 'Observe', (2) an arrow for 'Act', (3) a world/globe symbol for 'Change', and (4) a star for 'Reward'. The circles are connected by curved arrows forming a cycle. Use a light background with bold, clear lines and a modern color scheme around HEX #3396ff . Flat design style, similar to educational infographics.Create a tall, modern summer-themed illustration (2:6 width-to-height ratio) suitable for a tabletop magazine article. Use vibrant, saturated colors that evoke the feeling of sunshine, vacation, and poolside relaxation.

The composition should feature the following elements:

– A large cocktail glass at the center, with a woman casually sitting inside the glass in a playful, relaxed pose.

– A pink flamingo, either near the glass or interacting with the scene.

– Citrus fruit slices (e.g. lemon, orange) as decorative elements, possibly inside or around the glass.

– A swimming pool element integrated into the scene (e.g. in the lower area).

– A dreamy background with stylized water or soft clouds.

– The word 'YOLO!' in bold, eye-catching text, integrated into the design as part of the composition.

Style: flat illustration or vector-like, magazine-appropriate, with clear shapes and strong contrast.Create a high-quality, wide-angle product shot of a metallic light blue eBike. The image is taken in a controlled studio environment with a clean white background. Use soft yet sculpting studio lighting that emphasizes the curves and aerodynamic silhouette of the bike. The bike is positioned at a 3/4 front angle to showcase both front and side design lines. Reflections are minimal and controlled to highlight the surface quality.The image is captured through the visual characteristics of a Canon 18mm wide-angle lens – subtle barrel distortion, dynamic perspective, and slight foreground emphasis. Final style: ultra-realistic, crisp, and suitable for a premium catalog or marketing campaign.