OpenAI startet in den USA mit ChatGPT-Werbung. Der Test gilt für eingeloggte erwachsene Nutzer der kostenlosen und der "Go"-Stufe. Plus, Pro, Business, Enterprise und Education bleiben werbefrei. Alternativ kann man auch im Free-Tarif auf Werbung verzichten, erhält dann aber weniger tägliche Nachrichten.

OpenAI begründet den Schritt mit hohen Infrastrukturkosten. Werbung beeinflusse die Antworten nicht, Gespräche blieben privat. Welche Anzeige erscheint, hängt vom Gesprächsthema, früheren Chats und Interaktionen ab.

Unter-18-Jährige sehen keine Werbung, ebenso wenig werden Anzeigen bei sensiblen Themen wie Gesundheit oder Politik angezeigt. Nutzer können Anzeigen ausblenden, Werbedaten löschen und Personalisierung anpassen. Werbetreibende erhalten zusammengefasste Statistiken zu ihrer Werbung, keinen Zugang zu Chats oder persönlichen Daten.

Was immer gelten wird: Die Antworten von ChatGPT bleiben unabhängig und unvoreingenommen, Gespräche bleiben privat und die Nutzer behalten die volle Kontrolle über ihr Erlebnis.

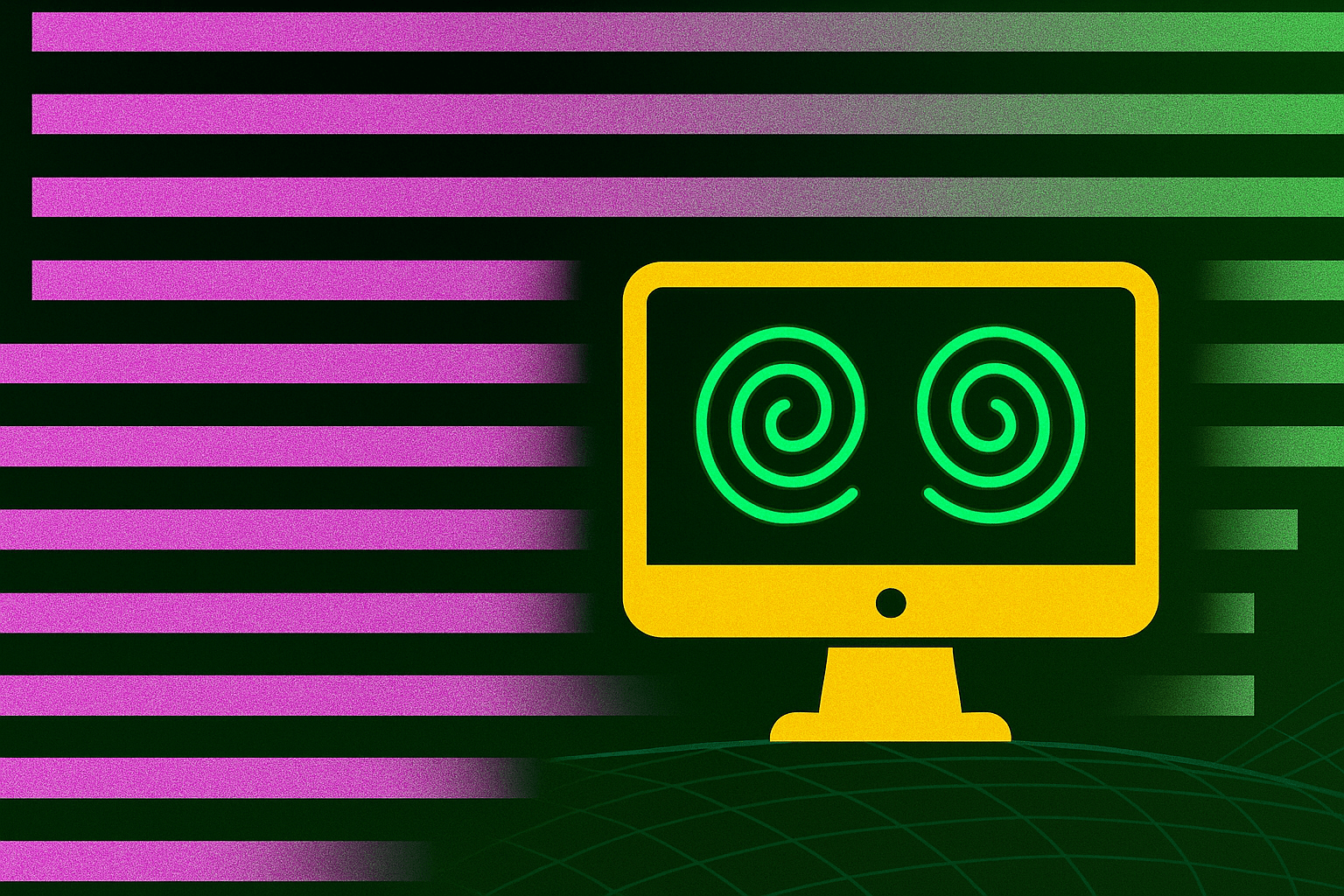

Werbung in Chatbots ist umstritten, da die Manipulationsgefahr höher ist als bei Suchmaschinen. OpenAI betont daher, Werbung klar getrennt vom Inhalt darzustellen. Langfristig plant das Unternehmen weitere Werbeformate.