Amazons Sprachassistent erkennt künftig latente Ziele seiner Nutzer und schlägt entsprechende Skills vor. Wie funktioniert das und wie sinnvoll sind die Vorschläge?

Im September präsentierte Amazon die neue Echo-Generation. Das kugelförmige Design stach zwar sofort ins Auge, das eigentliche Highlight sitzt allerdings im Inneren der Geräte: der KI-Sprachchip "AZ 1 Neural Edge".

Sprachbefehle werden damit direkt im Gerät verarbeitet und nicht wie bisher an eine Cloud geschickt. Alexa soll dadurch spürbar schneller und präziser antworten. Außerdem hilft Alexas neuer KI-Chip, Befehlsphrasen zu lernen und aktiv an Unterhaltungen teilzunehmen.

Damit will Amazon einer natürlichen Konversation zwischen Mensch und Sprach-KI einen Schritt näher kommen. Eines der neuen AZ1-Features ist jetzt aktiv.

Alexa erkennt latente Ziele

Amazon kündigte schon während des Echo-Reveal-Events an, dass Alexa mit AZ1 eine Reihe von neuen Fähigkeiten bekommen würde. Im Amazon Science Blog stellen die KI-Forscher Anjishnu Kumar und Anand Rathi jetzt ein Feature vor, durch das Alexa künftig besser mitdenken und zwischen den Zeilen lesen soll. Sie nennen es das "Erschließen von latenten Nutzer-Zielen".

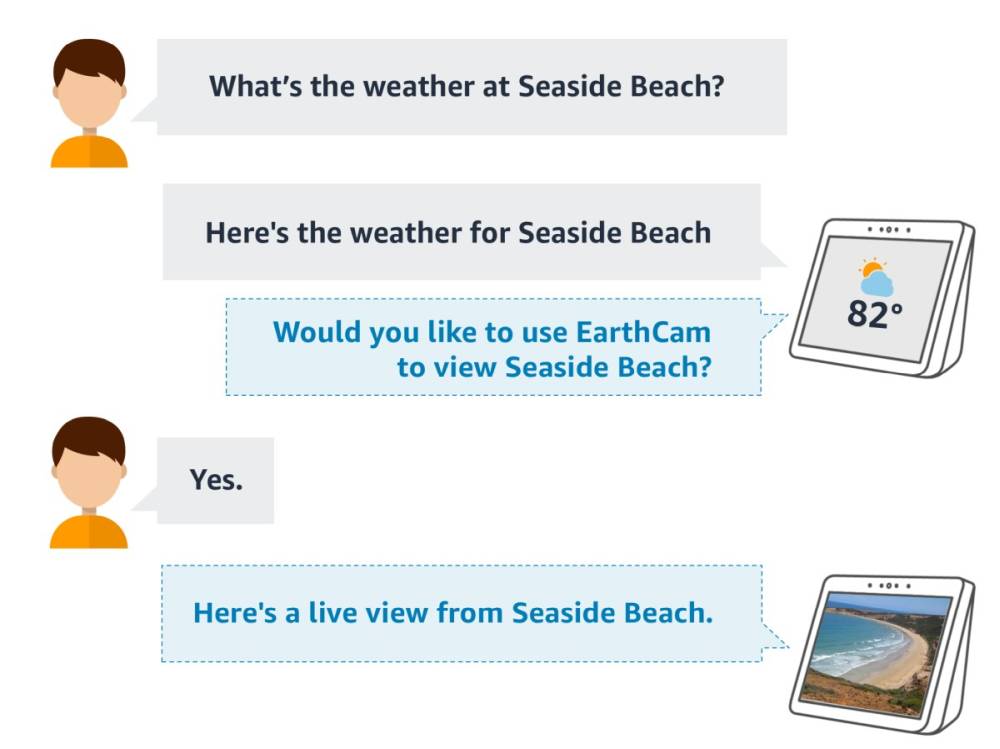

Alexa "ahnt" also, was ihr mit einer Frage bezweckt, ohne dass ihr es direkt aussprecht. Fragt ihr die Sprachassistentin beispielsweise nach der Ziehdauer eines Tees, könnte das latente Ziel sein, Alexa im Anschluss einen Timer stellen zu lassen.

Sie kommt also eurer Anschluss-Frage zuvor und schlägt einen entsprechend hilfreichen Skill vor:

Nutzer: „Alexa, wie lange muss Schwarztee ziehen?“

Alexa: „Schwarzer Tee sollte drei bis fünf Minuten ziehen.“

Alexa: „Soll ich einen Timer auf fünf Minuten stellen?

Der Vorgang mag einfach erscheinen, laut Amazon sind Alexas Lerneinheiten allerdings äußerst komplex. Erste Versuche hätten dazu geführt, dass Alexa auf die Frage nach Hühnchen-Rezepten entgegnete, ob sie Hühnergeräusche abspielen solle.

Alexa: Lernen ist komplizierter, als es aussieht

Amazon verwendet für die Bestimmung latenter Ziele ein auf Deep Learning basierendes Trigger-Modell. Dabei werden mehrere Aspekte des Dialogkontextes berücksichtigt. Zuerst muss Alexa entscheiden, ob sie sich überhaupt zu einem möglichen latenten Ziel äußern soll.

Sie untersucht den Inhalt des aktuellen Gesprächs und wie der Nutzer in der Vergangenheit auf ihre Vorschläge zum Aktivieren von Skills reagiert hat. Im nächsten Schritt entscheidet sie, welches latente Ziel vorliegt und wie sie es bedienen könnte.

Die Algorithmen der Ziel-Erkennung analysieren verschiedene Merkmale von Sprachbefehlen, beispielsweise kontextbezogene Aktionsketten. Wichtig ist dabei die Art und Häufigkeit von Folgefragen. Also beispielsweise wie oft nach der Ziehdauer von Schwarztee gefragt und im Anschluss nach einem Timer verlangt wird.

Eine Rolle spielt dabei auch, ob dafür eher Umformulierungen des ersten oder komplett neue Befehle verwendet werden. Gemeinsamkeiten von direktem und latentem Ziel, etwa der Zeitwert in der Frage nach der Ziehdauer, werden ebenfalls analysiert. Die Ergebnisse eines einzelnen Nutzers setzt Alexa dann ins Verhältnis zu den Befehlsketten aller anderen Nutzer.

Alexas Vorschläge: Nützliche Hilfe oder nerviges Gequassel?

Sieht sie den Kontext schließlich als geeignet an und glaubt, das richtige latente Ziel erkannt zu haben, schlägt Alexa einen entsprechenden Skill vor - in unserem Beispiel den Fünf-Minuten-Timer. Ein aktives Lernsystem soll dafür sorgen, dass die Vorschläge mit der Zeit immer präziser werden.

Ob das neue Feature wirklich hilfreich wird, hängt vor allem davon ab, ob und welche Entwickler es in ihre Skills implementieren werden. Alexa kann mittlerweile über 100.000 verschiedene Skills, von denen manche mehr, manche weniger nützlich sind.

Laut dem Online-Magazin The Verge wird das neue Feature derzeit von folgenden Skills unterstützt: Bark Like a Dog, Earth Cam, Harry Potter Trivia, Historical Voices, Slow Speller, Xbox, Zoo Keeper, CNBC, TED Talks und Ultimate History Quiz.

Alexa lernt nur in den USA

Die meisten neuen Features der Echo-Geräte, wie die lokale Verarbeitung von Sprachbefehlen und eben Alexas neue Vorschlags- und Lernfunktionen, sind in Deutschland noch nicht verfügbar. Derzeit profitieren ausschließlich englischsprachige Echo-Besitzer in den USA vom neuen AZ1-Chip.

Amazon verkündete bei der Vorstellung der neuen Echo-Geräte, die Unterstützung für weitere Sprachen und Länder solle bald folgen. Wann das Feature nach Deutschland kommt, ist noch offen.

Wer kommende Alexa-Features in vollem Umfang nutzen möchte, muss zudem bei der Auswahl der Geräte aufpassen: Zwar ist der KI-Chip in allen neuen Echo-Geräten verbaut, es verfügen aber nur Echo und Echo Show 10 über den nötigen Gerätespeicher, der beispielsweise für die lokale Befehlsverarbeitung nötig ist.

Titelbild & Quelle: Amazon