Ein Kopfhörer, der Gesichtsausdrücke tracken kann, sogar wenn der Nutzer eine Maske trägt - wie funktioniert das?

Forscher der Cornell Universität haben ein Kopfhörersystem entwickelt, das die Mimik seines Trägers liest. "C-Face" erfasst dazu Bewegungen der Wangenkonturen und wandelt so Gesichtsausdrücke in Emojis um oder nutzt sie, um die Musikwiedergabe in Apps zu steuern. Auch Virtual Reality (Guide) könnte von dem System profitieren.

C-Face: So erfasst der KI-Kopfhörer Mimik

Cheng Zhang, Chef des SciFi Labs an der Cornell Universität, beschreibt sein Gerät als einfacher, weniger aufdringlich und leistungsstärker als alle existierenden Systeme zur Erfassung von Gesichtsausdrücken. Frühere Lösungen hätten Sensoren im Gesicht vorausgesetzt und wären auf die Erkennung einer begrenzten Anzahl an eindeutigen Gesichtsausdrücken reduziert gewesen.

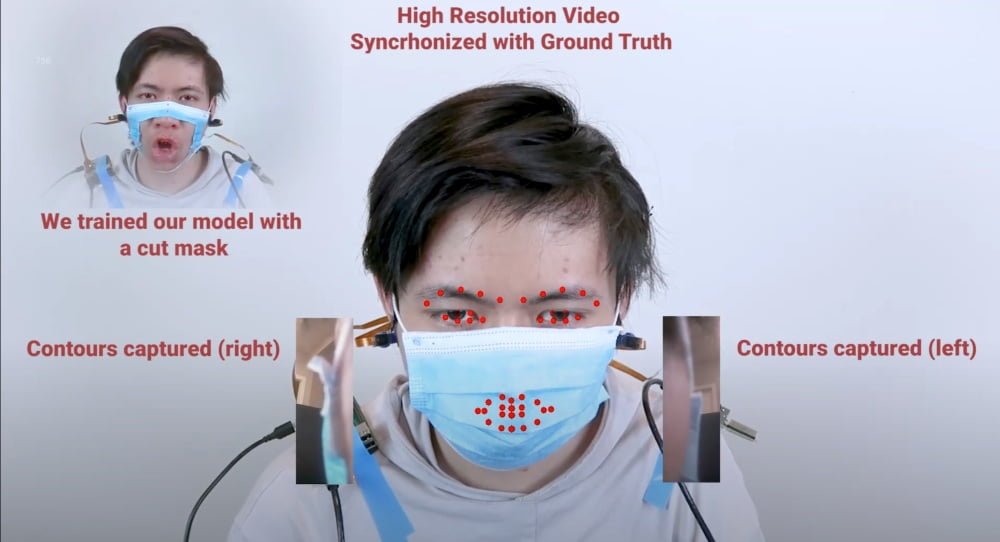

C-Face zeichnet Muskelbewegungen in der Wangenregion mit zwei RGB-Kameras auf. Die sind links und rechts unter den Ohrmuscheln angebracht. Bewegen sich die Muskeln, verändern sich die Gesichtskonturen. Ein per Deep Learning trainiertes KI-System erkennt, welche Bewegungen die entsprechenden Gesichtsausdrücke auslösen und bildet diese Regungen in Form von 42 Merkmalspunkten ab (siehe Bild oben).

Die repräsentieren die Formen und Positionen von Mund, Augen und Augenbrauen. Da das System die entsprechende Mimik nur anhand der Bewegungen im Wangen- und Kieferbereich berechnet, funktioniert es auch, während der Nutzer einen Mundschutz trägt.

Emojis, Apps und VR-Avatare: So kommt C-Face zum Einsatz

Das System kann Gesichtsausdrücke in acht Emojis übersetzen, die beispielsweise wütende, lachende oder neutrale Gesichter darstellen. Damit könnte bald ein Lächeln genügen, um einen Smiley in den WhatsApp-Chat zu bringen. Außerdem soll es möglich sein, die Wiedergabeoptionen einer Musik-App wie der des kürzlich von MelodyVR akquirierten Streaming-Dienstes Napster zu steuern.

Das funktioniert durch das lautlose Aussprechen von Wörtern wie "play" oder "stop". Eine Übertragung der Mimik auf einen virtuellen Avatar in Monitor- oder VR-Spielen (Übersicht) sei ebenfalls denkbar. Das würde beispielsweise die Kommunikation in Social-VR-Apps wie Facebooks Horizon (Tests) erleichtern. Die eigenen Emotionen würden sich direkt auf dem Gesicht des Avatars widerspiegeln.

Wegen der durch die Pandemie nötigen Einschränkungen konnte C-Face bisher nur an neun Probanden getestet werden. Die Umwandlung in Emojis klappte bei den Tests in 88 Prozent der Fälle. Die Erfolgsquote bei der Erkennung der Gesichtsausdrücke lag bei 85 Prozent. Die geringe Batterielaufzeit soll das System derzeit noch einschränken. Deshalb wollen die Forscher im nächsten Schritt die Energieeffizienz des Kopfhörersystems verbessern.

Titelbild & Quelle: SciFi Lab Cornell University