Google Assistant wird durch BERT-KI besser

Google stellt neue Features für den Google Assistant vor, die durch die Sprach-Technologie BERT ermöglicht werden. Was macht der smarte Assistent künftig besser?

Google will in den kommenden Tagen eine ganze Reihe neuer Features für den Google Assistant ausliefern. Im Mittelpunkt steht dabei das bessere Sprachverständnis durch KI. So soll der smarte Assistent künftig auch zwischen den Zeilen lesen können, Namen besser verstehen und fließend mit seinen Nutzern sprechen.

Google Assistant lernt Namen

Vor allem auf Smartphones wird der Google Assistant (Guide) gerne benutzt, um Anrufe zu starten oder Nachrichten zu versenden. Per Sprachbefehl wählt der Assistent den richtigen Kontakt aus oder lässt sich eine WhatsApp-Nachricht vorlesen.

Das eigentlich sehr praktische Feature kann aber schnell nerven, wenn es zu Missverständnissen bei der Kontaktauswahl kommt. Hier bessert Google jetzt nach. Künftig können Nutzer der Sprach-KI beibringen, wie man Namen aus der eigenen Kontaktliste buchstabiert und ausspricht.

Dadurch versteht der Google Assistant Befehle mit schwierigen Namen besser und spricht sie selbst auch korrekt aus. Während des Lernvorgangs werden keine Audio-Dateien gespeichert. Die Funktion wird vorerst nur auf Englisch verfügbar sein, weitere Sprachen sollen folgen.

Sprach-KI: Umgang mit Kontext verbessert

Ein deutlich größeres Upgrade soll künftig dafür sorgen, dass der Google Assistant Zusammenhänge besser versteht. Kommt es beispielsweise während des Setzens eines Timers zu kleinen Versprechern, bezog der Google Assistant diese bisher wortwörtlich in den Befehl mit ein:

- Sprachbefehl: „Hey Google, stell einen Timer für fünf, nein warte, neun Minuten.“

- Google Assistant: „Alles klar, ein Timer namens „fünf nein warte“ für neun Minuten. Es geht los.“

Künftig ignoriert der Google Assistant die für den eigentlichen Zweck nicht erforderlichen Wörter und bestätigt korrekt mit „9 Minuten. Los gehts.“ Ein weiteres Beispiel zeigt, wie der Google Assistant von jetzt an bei der Auswahl ähnlicher Timer vorgeht:

- Sprachbefehl Nummer 1: „Hey Google, stell einen Timer für 10 Minuten.“

- Sprachbefehl Nummer 2: „Hey Google, stell einen Timer für 20 Minuten.“

- Sprachbefehl Nummer 3: „Hey Google, beende meinen zweiten Timer.“

Bisher reagierte der Assistent folgendermaßen:

- „Es sieht aus, als hättest du zwei Timer. Welchen soll ich beenden?“ oder „Das kannst du in der App machen.“

In Zukunft soll der Assistent sofort verstehen, dass der Timer mit zwanzig Minuten Laufzeit gemeint war und ihn beenden. Weitere Beispiele seht ihr in obigem YouTube-Video.

Google will seine Sprach-KI damit flexibler machen. Sie soll sich an die Sprache der Nutzer anpassen, nicht andersherum. Deshalb komme es künftig bei Sprachbefehlen nicht mehr auf die richtige Aneinanderreihung korrekter Wörter an. Um das zu erreichen, überarbeitete Google die Lern-Modelle des Assistenten und stellt ihm eine weitere Künstliche Intelligenz zur Seite.

Google Assistant powered by BERT

Der Google Assistant verstehe nun Kontext besser und würde genauere Referenzlösungen anbieten, heißt es im dazugehörigen Blog-Artikel. Er weiß also, was Nutzer mit einem Befehl meinen, egal, wie sie sich ausdrücken.

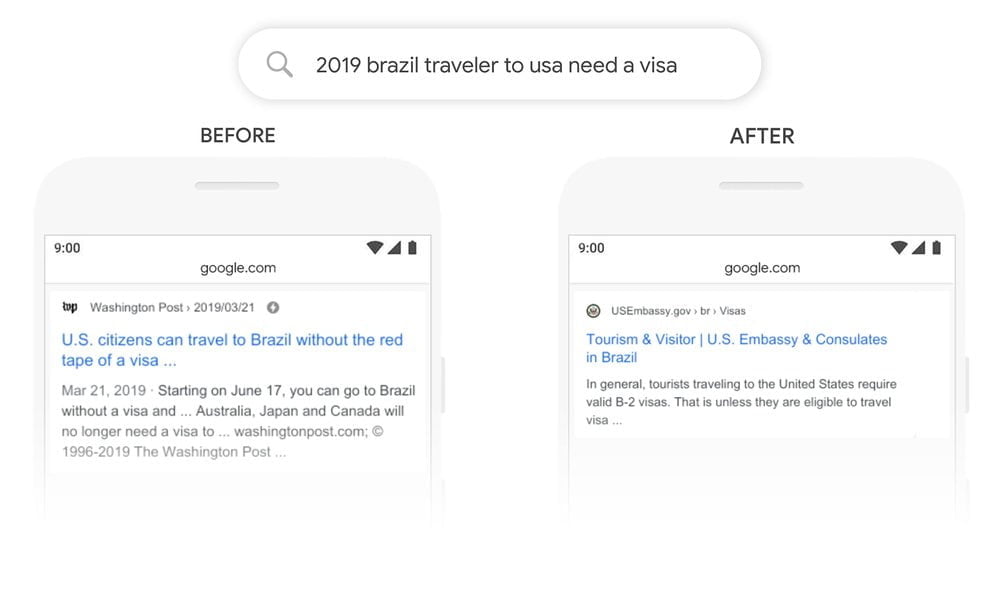

Für dieses Upgrade setzt Google maschinelles Lernen und sein leistungsstarkes KI-System BERT ein. Die vortrainierte Sprach-KI wird unter anderem für die Google-Suche verwendet. BERT ist in der Lage, wichtige Rollen einzelner Wörter innerhalb eines Satzes zu verstehen und sie so dem richtigen Kontext zuzuordnen.

Google gibt an, Assistant könne nun zu fast 100 Prozent genau auf Alarme und Timer-Aufgaben reagieren. Diese Fähigkeiten sollen künftig auf weitere Anwendungsfälle ausgeweitet werden. Ab sofort sollen die Timer-Updates auf allen Smart Speakern in den USA verfügbar sein. Smartphones und Smart-Displays wie Google Nest Hub 2 (Test) sollen folgen. Ob der Google Assistant künftig auch besser mit Kontext in deutschen Sätzen umgehen wird, ist noch nicht bekannt.

Konversationen mit dem Google Assistant werden natürlicher

Die bereits erwähnte Sprach-Technologie BERT wird auch eingesetzt, um Unterhaltungen flüssiger zu machen. Die Sprach-KI greift dazu auf frühere Interaktionen zurück, um Folgefragen besser beantworten zu können. Ein ähnliches Modell stellte Amazon Ende letzten Jahres vor. Durch das Erkennen latenter Nutzerziele sollte Alexa besser mitdenken.

Fragt ihr beispielsweise nach dem Wetter in Miami, zeigt euch der Google Assistant das entsprechende Ergebnis. Folgefragen setzt der Assistent nun in Bezug auf diese Stadt. Die müssen auch nicht mehr neu mit „Hey Google“ eingeleitet werden.

Eine fließende Konversation könnte also folgendermaßen aussehen:

- Nutzer: „Hey Google, wie ist das Wetter in Miami?“

- Google Assistant: „Hier ist das Wetter für das kommende Wochenende.“

- Nutzer: „Zeig mir die schönsten Strände.“

- Google Assistant: „Das sind die 15 besten Strände in Miami.“

- Nutzer: „Was sind die höchsten Gebäude dort?“

- Google Assistant: (zeigt Liste der höchsten Gebäude)

- Nutzer: „Wer hat das Erste gebaut?“

- Google Assistant: „Moshe Cosicher AIA baute den Panorama Tower.“

- Nutzer „Wann?“

- Google Assistant: „Januar 2014.“

- Nutzer: „Wie viele Stockwerke hat es?“

- Google Assistant: „Der Panorama Tower in Miami hat 85 Stockwerke.“

- Nutzer: „Zeig mir Bilder.“

- Google Assistant: „Ich habe folgende Bilder gefunden...“ (zeigt Bilder von Hochhäusern in Miami)

- Nutzer: „Während des Baus.“

- Google Assistant: (zeigt Bilder von Hochhäusern in Miami, während sie gebaut wurden)

Titelbild & Quelle: Google

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.