Künstliche Intelligenz lernt selbstständig Objekte zu identifizieren

Menschen sehen Stühle und verstehen, was einen Stuhl ausmacht. Sie erkennen einen Stuhl, auch wenn er umgefallen ist, eine andere Farbe oder Form hat. Dieses Abstraktionsvermögen geht Maschinen ab. KI-Forscher des MIT ist es gelungen, einer Künstlichen Intelligenz ähnliche Fähigkeiten beizubringen, sodass sie Gegenstände eigenständig klassifizieren kann.

Das von den Wissenschaftlern entwickelte Computer-Vision-System hört auf den Namen DON ("Dense Object Nets") und lernt dank eines künstlichen neuronalen Netzes.

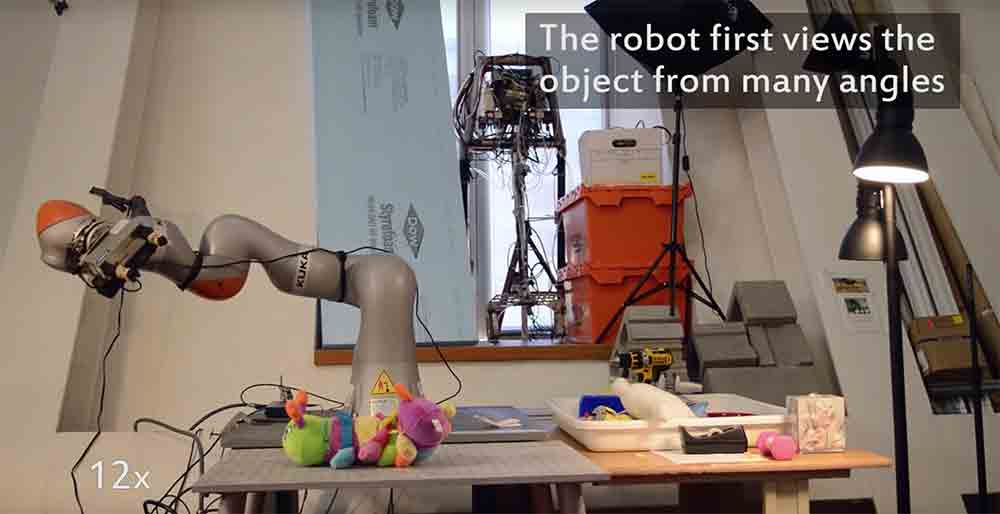

Ein Youtube-Video veranschaulicht, wie es funktioniert: Die Forscher legen ein Objekt auf eine Platte, worauf sich die KI das Objekt mittels eines beweglichen Roboterarms und einer integrierter Kamera von allen Seiten anschaut.

Aus den unterschiedlichen Perspektiven gewinnt die Künstliche eine räumliche Vorstellung des Gegenstands, indem es Eigenschaften des Objekts aus verschiedenen Blickwinkeln zueinander ins Verhältnis setzt.

Hat es seine Eigenschaften erfasst, kann es Gegenstände selbst dann identifizieren, wenn es nur Teile dessen aus einer unbekannten Perspektive erkennt. "Bisherige Algorithmen konnten beispielsweise eine Tasse nicht an ihrem Griff erkennen, inbesondere dann, wenn die Tasse steht oder seitlich liegt", sagt Doktorand Lucas Manuelli, der das KI-System mitentwickelte.

Könnte bei der Objekterkennung helfen

Der Roboter soll durchschnittlich 20 Minuten brauchen, um die Eigenschaften eines Gegenstands zu lernen. Dabei spielt es keine Rolle, ob das Objekt fest oder weich ist und welche Farben, Formen oder Oberflächen es hat. Das selbstlernende KI-System kann von diesen Abweichungen abstrahieren. Um zu lernen, was einen Hut ausmacht, brauchte es lediglich sechs unterschiedliche Exemplare.

In Tests markierten die Forscher Stellen eines Gegenstands auf einem Referenzbild, die die Maschine am realen Objekt identifizieren sollte.

Ein Beispiel: Das rechte Ohr einer Plüschraupe. Der Roboterarm konnte die Stelle unabhängig von der räumlichen Position des Gegenstands ausmachen, das Plüschtier am rechten Ohr greifen und aufheben.

Die Technologie könnte bei Fabrikrobotern zum Einsatz kommen, die Gegenstände manipulieren oder sortieren müssen. Im Kontext der Augmented Reality könnte sie bei der Objekterkennung helfen und AR-Brillen ermöglichen, Gegenstände in ihren zahlreichen Erscheinungsformen schnell und eindeutig zu identifizieren.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.