Ein Experiment, um herauszufinden, inwieweit NeRFs kurz davor stehen, bestimmte Arten der traditionellen Videoproduktion zu ersetzen. Ein sechsstelliges Budget, eine 30-tägige Produktion und der größte MoCo-Kran der Welt gegen einen Mann mit einem Smartphone, ein paar Open-Source-Bibliotheken und einer Consumer-GPU.

Vor ein paar Jahren war ich Creative Director für eine Reihe von Filmen zur Einführung des 2019er Acura RDX. Wir drehten eine Reihe von 360-Fly-Around-Videos des Autos in drei verschiedenen Umgebungen, und ich hatte das Vergnügen und die Erfahrung, die Filme mit dem Titan Motion Control-Rig zu drehen, einem Rig, das auch im Jahr 2023 noch den größten Bewegungsbereich aller MoCo-Rigs weltweit hat. Mit dem Rig konnten wir nicht nur die Fly-Around-Videos mit höchster Präzision aufnehmen, sondern auch die Kamera im Auto absenken - ein wichtiges Feature für den Film, da das Auto mit dem besten Schiebedach seiner Klasse auf den Markt kam.

Die Produktion war großartig, das Team am Set und in der Postproduktion hervorragend. Das Ergebnis war so gut, dass ein älterer Kunde vorschlug, wir sollten das für alle seine Autos ohne Schiebedach machen. Leider stellte sich heraus, dass dies nicht machbar war, da die Produktion ein sechsstelliges Budget für Produktion und Postproduktion hatte. Wir hatten einen 10-stündigen Drehtag pro Location und etwa 4 Wochen Postproduktion. Zugegebenermaßen war ein großer Teil davon der Komplexität des Moonroofs geschuldet, aber auch ohne Moonroof wäre die Produktion nicht realisierbar gewesen.

NeRF versus Motion Control Rig

Aber 2023 sind wir an einem Punkt angelangt, an dem wir in der Lage sein könnten, dies zu viel geringeren Kosten und in viel kürzerer Zeit zu tun, dank moderner Implementierungen von NeRFs, einem Framework für maschinelles Lernen zur Darstellung realer Szenen als Neural Radiance Fields, das erstmals von Matthew Tancik et. al. im Jahr 2020 als Forschungsprojekt vorgestellt wurde. Im Kern sind NeRFs virtuelle 3D-Darstellungen realer Szenen. Sie werden erstellt, indem man eine Reihe von Fotos einer realen Szene macht und diese Fotos dann durch eine Reihe von Algorithmen laufen lässt, die berechnen, wo sie sich in einem 3D-Raum befinden. Die Fotos und die Positionsdaten werden dann verwendet, um das NeRF zu trainieren. Sobald das NeRF trainiert ist, kann es in einer 3D-Umgebung visualisiert werden, die das Licht (oder die Strahlung) in der Szene aus jedem erdenklichen Winkel simuliert.

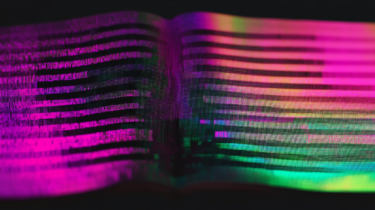

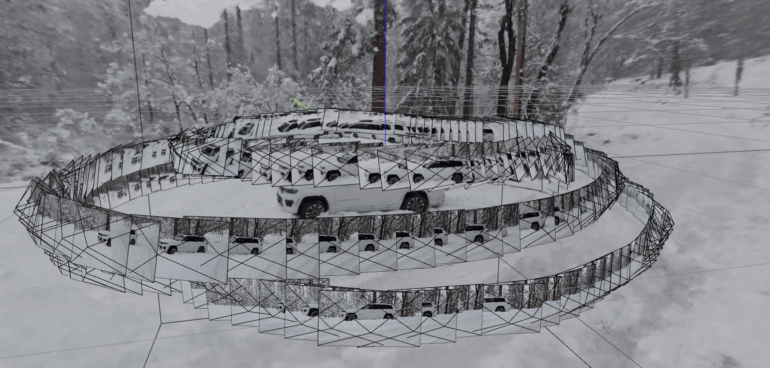

Der Screenshot unten zeigt dies in Aktion mit ca. 300 Fotos aus einem kurzen Video, das zeigt, wie ich dreimal um mein Auto gehe und dabei meine Handykamera in drei verschiedenen Höhen halte. In dieser Szene kann ich mein Ansichtsfenster überall hin bewegen, solange es Pixel in den ~300 Fotos gibt, die diesen Bereich abdecken.

Wie immer dauert es eine Weile, bis sich die Forschung in der realen Welt niederschlägt, und die verfügbaren Tools sind noch nicht für die Produktion gedacht, aber die Ergebnisse sind bereits sehr vielversprechend. Ich habe für dieses Projekt Nerfstudio verwendet, von dem auch der Screenshot stammt. Es ist ein ausgezeichnetes Open-Source-Projekt, aber es gibt auch andere Implementierungen, darunter Instant-NGP von NVidia Labs.

Video: Martin Pagh Ludvigsen

Links ist eines der drei fertigen Videos, die wir 2018 produziert haben. Rechts ist ein Video, das ich aus einem NeRF gerendert habe, das ich in den letzten Wochen erstellt habe. Ich habe bereits erwähnt, wie viel Zeit und Geld das linke Video gekostet hat. Das rechte Video wurde in 2,5 Stunden mit einem Team produziert, das aus mir bestand: Ungefähr 1,5 Stunden davon verbrachte ich damit, von meinem Haus zu einem verschneiten Ort zu fahren und wieder zurück, 30 Minuten damit, den Inhalt für das NeRF einzurichten und aufzunehmen, und 30 Minuten damit, mein Auto aus den 15 cm Schnee auszugraben, in dem ich stecken geblieben war, um die Aufnahmen zu machen.

Aber die bei weitem größte Zeitersparnis liegt in der Postproduktion. Es gibt keinen riesigen Motion-Control-Kran, den wir übermalen müssen, keine Lichtveränderungen, die wir anpassen müssen, weil sich die Sonne während der Dreharbeiten über den Himmel bewegt hat, und keine Schatten auf dem Boden, die wir nachbilden müssen. Das Training des NeRF-Modells auf meinem Consumer-Grafikprozessor dauerte etwa eine Stunde. Für das Rigging der Szene brauchte ich 45 Minuten und für das Rendering der Videos eine weitere Stunde. Die gesamte Produktion und Nachbearbeitung dauerte weniger als einen Tag, einschließlich Transport und Schneeschaufeln.

NeRFs ermöglichen eine perfekte Schleife

Das Video auf der rechten Seite ist bei weitem nicht perfekt: Man kann die Nummernschilder kaum erkennen, es fehlen viele Details im vorderen Kühlergrill und es gibt viele Kompressionsartefakte und fehlende Linien auf dem Blech. Aber man muss bedenken, dass ich diese Aufnahmen mit meinem Smartphone bei Schneefall gemacht habe, dass ich mein Auto für die Aufnahmen nicht einmal geputzt habe und dass ich weder eine Vorbearbeitung der Quellbilder noch eine Nachbearbeitung des Videos vorgenommen habe. Außerdem "fehlen" Teile des Bodens und des Himmels, weil ich diese Bereiche bei meinem Rundgang um das Auto nicht erfasst habe.

Während das Auto auf der linken Seite wirklich gut aussieht, hat das Video noch viele kleine und zwei große Probleme:

1) Es gibt keinen perfekten Loop. Der Grund dafür ist, dass es zu schwierig wäre, einen Kamerabewegungspfad zu erstellen, der sowohl eine perfekte Schleife bildet als auch die vielen verschiedenen Versionen des Videos erzeugt, die wir benötigen. Bei NeRFs ist das kein Problem, da die Kamera mathematisch erstellt, platziert und in der Postproduktion gesteuert wird. Deshalb ist der Loop rechts so perfekt. Selbst mit der besten Motion-Control-Ausrüstung ist es schwierig, einen so perfekten Loop zu bekommen.

2) Es hat den gleichen Soap-Opera-Look mit wenig Bewegung, die man aus dem Fernsehen seiner Eltern kennen. Das liegt daran, dass wir in der Postproduktion eine Frame-Interpolation durchführen mussten, um die Videos auf die richtige Länge zu bringen. In der Praxis bekommt man nur die Bilder, die man aufnimmt und in der Postproduktion fertigstellt, die durch die zur Verfügung stehende Zeit und das Budget begrenzt ist. Dies ist bei NeRFs nicht der Fall, da das Ausgabevideo aus einer virtuellen Szene gerendert wird und die Länge des Videos nicht durch die Anzahl der verfügbaren Bilder begrenzt ist.

Video: Martin Pagh Ludvigsen

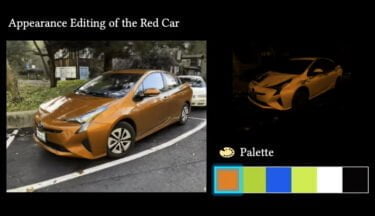

Das bedeutet, dass es fast trivial ist, mehrere verschiedene Versionen des Videos mit unterschiedlichen Seitenverhältnissen zu erstellen, und die Ergebnisse werden nie unter den gleichen Problemen leiden wie das klassische Video. Das habe ich in der obigen Collage deutlich gemacht, die auch zwei der notorisch schwierigen 9:16-Videos enthält - ich habe der Kamera ein etwas größeres Sichtfeld gegeben und einen viel dynamischeren Pfad erstellt, anstatt mich um die üblichen Probleme bei der Konvertierung eines 16:9-Videos in 9:16 zu kümmern. Und ich habe das eine genau 15 Sekunden und das andere 7,5 Sekunden lang gemacht, weil ich dafür einfach nur eine Zahl eingeben und auf "Render" zu drücken muss. Zu sehen sind 1:1 (oder 4:5) für einen Feed, 9:16 für Story-Formate und 16:9 für ein Portfolio. Da es für das Portfolio ist, könnte ich genauso gut eine noch nutzlosere, aber sehr hübsche anamorphe 2,4:1-Version erstellen.

Video: Martin Pagh Ludvigsen

NeRFs sind unglaublich leistungsfähig

Ich bin sicher, dass sich die visuelle Qualität verbessern wird, und in meinen nächsten Experimenten möchte ich bessere Kameras und Objektive ausprobieren, die Bilder vorbearbeiten, um eventuelle Fehler zu beseitigen, vielleicht mein Auto waschen und die Auflösung des Ausgangsmaterials erhöhen, indem ich in 8k aufnehme.

Der größte Nachteil ist jedoch, dass es in der Szene keine Action gibt - ein NeRF ist ein eingefrorener Moment in der Zeit, man muss also sicherstellen, dass sich die Szene während der Aufnahme nicht verändert, sonst ist das NeRF nicht perfekt. Wenn man Action aufnehmen will, braucht man ein Vollfeld-Kamerasystem, wie das inzwischen nicht mehr produzierte Lytro-System, das dafür bekannt ist, 400 GB Daten für jede Sekunde der Aufnahme zu speichern. Aber Action kann natürlich auch als CGI hinzugefügt werden, und es wird bereits daran geforscht, wie man Action in NeRFs bringen kann.

NeRFs können in Formaten wie Punktwolken exportiert werden, die in 3D-CGI-Software wie Blender oder Maya oder in Echtzeit-3D-Plattformen wie Unreal Engine oder Unity3D importiert werden können, wo sie wahrscheinlich die Photogrammetrie als bevorzugte Methode für den Import von realen Objekten und Szenen in 3D-Software ergänzen oder sogar ersetzen werden.

Aber auch für sich genommen sind NeRFs unglaublich leistungsfähig, und ich glaube, dass diese Experimente zeigen, dass sie kurz davor stehen, für die Produktion einfacher Videos von realen Objekten und Szenen für soziale Medien bereit zu sein.

Mehr über Martin erfahrt ihr auf seiner Website.