Auf der ISMAR-Konferenz in München gab es Einblicke in aktuelle Forschungsthemen, die die Mixed-Reality-Gemeinschaft umtreiben. Mein Highlight war das "Mask Fusion"-Verfahren, mit dem Augmented Reality die Welt verstehen lernt.

Augmented Reality-Technologie ist noch zu dumm

Die Technik und Algorithmen, die Augmented Reality zum Laufen bringen, sind schon smart. Aber viele Lösungen stürzen sich nur auf ein Teilproblem: Es existieren unzählige Entwicklerwerkzeuge für die Raumerfassung und das Tracking.

Diese Werkzeuge gehen davon aus, dass die Welt statisch ist. Sie liefern zudem nur eine geometrische Beschreibung der Umgebung. Das reicht aus, um zum Beispiel einen digitalen Blumentopf auf einem Tisch zu verankern.

Schiebt jedoch jemand einen Servierwagen durch die Szene, gerät die AR-Software durcheinander. Sie kann weder den Servierwagen als solchen erkennen, noch könnte sie den digitalen Blumentopf auf den sich bewegenden Wagen projizieren. Ihr fehlt ein grundlegendes Verständnis für die Welt und die Objekte darin.

Semantische Objekterkennung für das Weltwissen

Entscheidend für eine futuristische Augmented Reality ist daher eine KI-gestützte Objekterkennung, wie man sie zum Beispiel von Google Lens kennt: Sobald ein Objekt vor die Kameralinse gerät, durchläuft es eine Text- und Bildanalyse und wird mit einer Datenbank abgeglichen.

Die Datenbank meldet zurück, um welches Objekt es sich handelt: einen Teddybär, eine Banane, welche Automarke, welche Sehenswürdigkeit, was steht auf dem WiFi-Login-Schild. Das klappt bei Google schon recht verlässlich und in Sekundenschnelle. Allerdings wird diese Objekterkennung noch nicht für AR-Zwecke eingesetzt.

Mask Fusion kombiniert Tracking und Objekterkennung

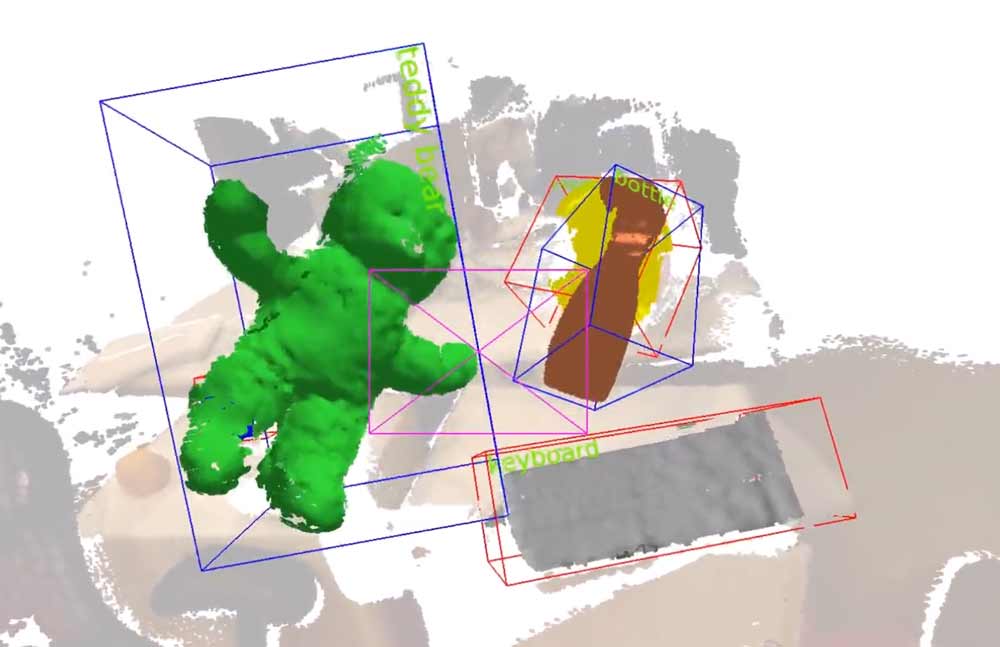

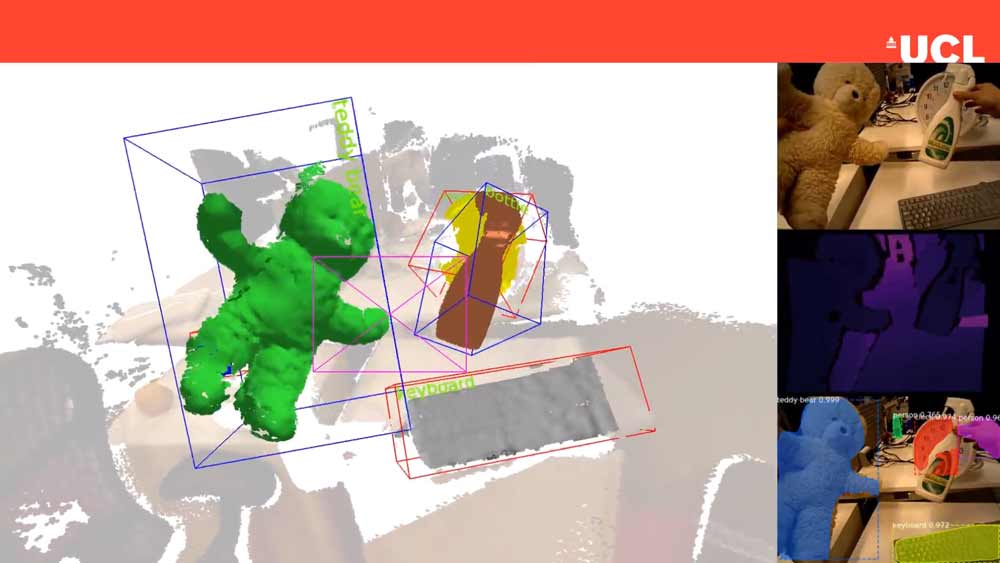

Das Mask-Fusion-Verfahren von Lourdes Agapito und Martin Rünz vom University College in London verbindet Trackingtechnologie und semantische Objekterkennung.

Und das ziemlich clever: Zunächst wird mit einer RGBD-Kamera, die Farb- und Tiefeninformationen liefert, die Umgebung gescannt und die Kameraposition berechnet.

Dann werden Bild für Bild die Objekte in der Szene erkannt, indem sie mit einer Objektdatenbank abgeglichen werden. Danach werden die Objekte mit dem dreidimensionalen Raumbild fusioniert. Das System kann so die Kameraposition in Echtzeit bestimmen und mehrere Objekte gleichzeitig identifizieren und in 3D verfolgen.

Spannend ist, dass vorab keine 3D-Modelle zu den Objekten hinterlegt werden müssen und dass nicht nur ein Objekttyp erkannt wird, sondern das tatsächliche Objekt im Raum. Selbst dann, wenn sich mehrere, gleich aussehende Objekte im selben Raum befinden. Darüber hinaus können Menschen und Körperteile wie Hände erfasst werden.

Anwendungsszenarien für eine echte erweiterte Realität

Die AR-Forscher wollen ihr Verfahren für sehende Roboter einsetzen, die so ein besseres Verständnis für ihre Umgebung entwickeln können. Beispielsweise könnten etwa bewegliche Objekte (wie Menschen) bei der Raumvermessung ausgeblendet werden. Der Roboter könnte außerdem Objekte besser greifen, wenn er vor dem Griff schon eine Vorstellung von der Beschaffenheit des Objekts hat.

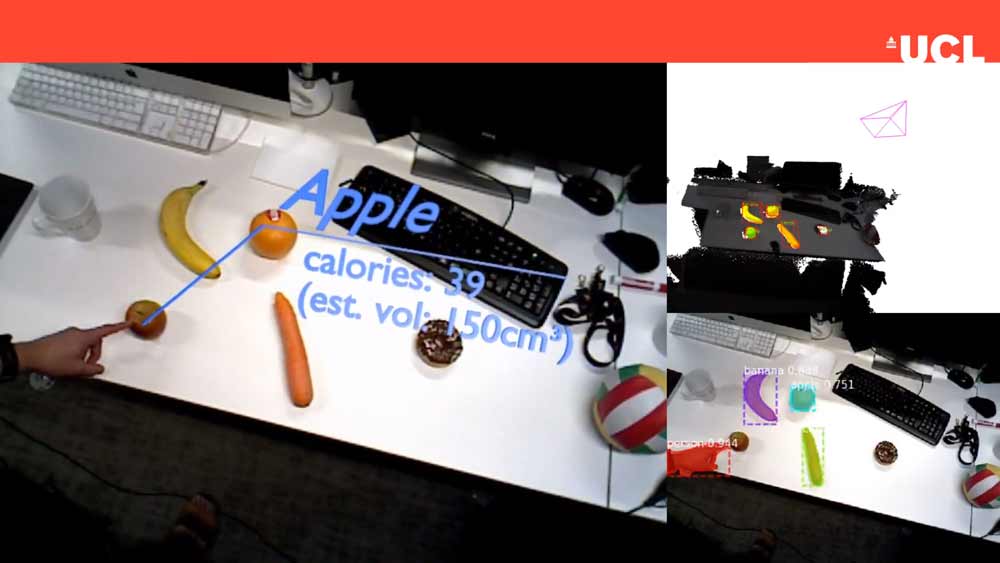

In einem weiteren Beispiel zeigten die Forscher eine AR-Kalorienerkennung (Apfel, Torte, Banane …), die dank Handtracking bereits einen Ausblick auf Gesteninteraktion und neue AR-Interfaces bietet.

Reale und virtuelle Objekte können voll integriert koexistieren, auch auf beweglichen Flächen. In der Demo (siehe Video unten) springt eine digitale Figur auf ein echtes Skateboard. Das Skateboard rollt los, die digitale Figur rollt mit. Sogar die reale Umgebungsbeleuchtung wird korrekt auf die Figur umgelegt.

Das klingt vielleicht banal, ist aber wichtige Grundlagenforschung und ein essenzieller Baustein für eine mögliche Sci-Fi-AR, bei der die digitale Ebene visuell völlig glaubhaft mit der Realität verschmilzt.

Die Technik und die Marktreife

Das Team nutzt einen gängigen Kameratrackingansatz über einen SLAM-Algorithmus (Simultaneous Localisation and Mapping). Hierbei wird eine 3D-Karte der Umgebung erstellt und in dieser synchron die Kameraposition bestimmt.

Eine 2D-Segmentierung mithilfe der Farb- und Tiefenkamera füttert den frei verfügbaren MS-COCO-Datensatz mit Objektinfos. Die Datenbank enthält 1,5 Millionen Objekte in 80 Kategorien.

Aktuell arbeitet das System asynchron für die unterschiedlichen Teilaufgaben: die Objektmaskierung erfolgt bei 5 Hz, SLAM mit 30 Hz bei einem und 20 Hz bei drei dynamischen Objekten im Bild.

Die benötigte Rechenpower überfordert leider noch jedes Smartphone oder gar eine schlanke Brille: Die Demo wird mit einer Nvidia GTX Titan X und einem Intel Core i7 3.5 GHz Prozessor gerendert. In den meisten Smartphones fehlt zudem die Tiefenkamera, aber das könnte sich mit der nächsten iPhone-Generation ändern.

Die Forscher wollen ihr System weiter optimieren. Das vollständige Paper ist hier einsehbar.

Über den Autor:

Tobias Kammann ist AR-Fan seit dem ersten AR-Toolkit und arbeitet seit mehr als zehn Jahren in der Industrie, um die Mixed Reality Wirklichkeit werden zu lassen. Zurzeit bastelt er im Metaverso an seiner Vision, betreibt den Augmented-Blog und möchte am liebsten morgen schon alle Handys und Bildschirme aus dem Fenster werfen und durch eine AR-Brille ersetzen.