2.5D Visual Sound: KI macht aus Mono-Ton Raumklang

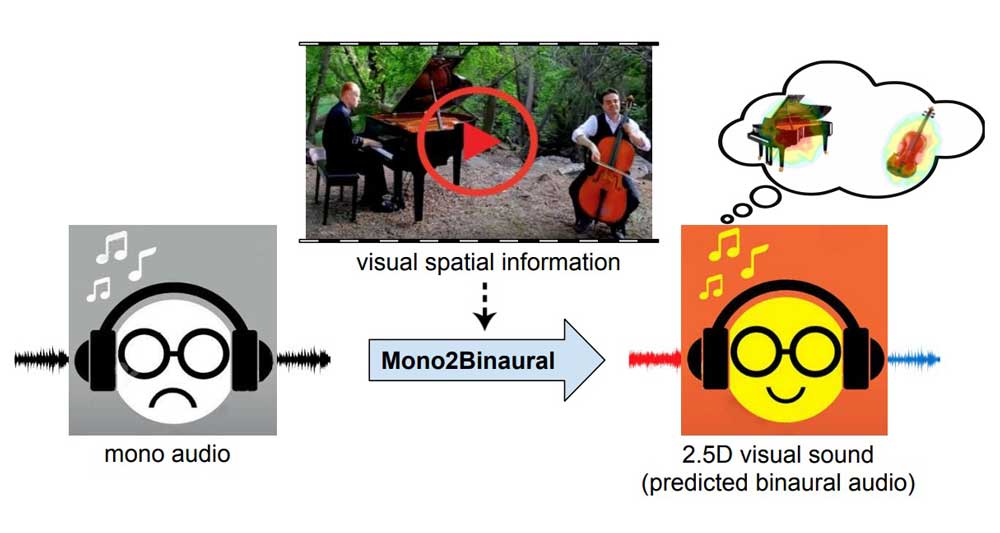

Eine KI erzeugt binauralen Raumklang basierend auf visuellen Eindrücken.

KI-Forscher der Universität Texas und von Facebook arbeiten am KI-System "2.5D Visual Sound": Es erkennt Schallquellen in einem Video und kann aus dem begleitenden Mono-Ton binauralen Raumklang erzeugen.

Beispiel: Ein Klavierspieler ist rechts im Bild, der Schlagzeuger links. Bei herkömmlichem Mono-Ton kommt der Klang beider Instrumente gefühlt aus der Bildmitte. Das KI-System rechnet den Mono-Ton so in Raumklang um, dass sich der Klang der jeweiligen Instrumente korrekt auf die linke und rechte Bühne verteilt.

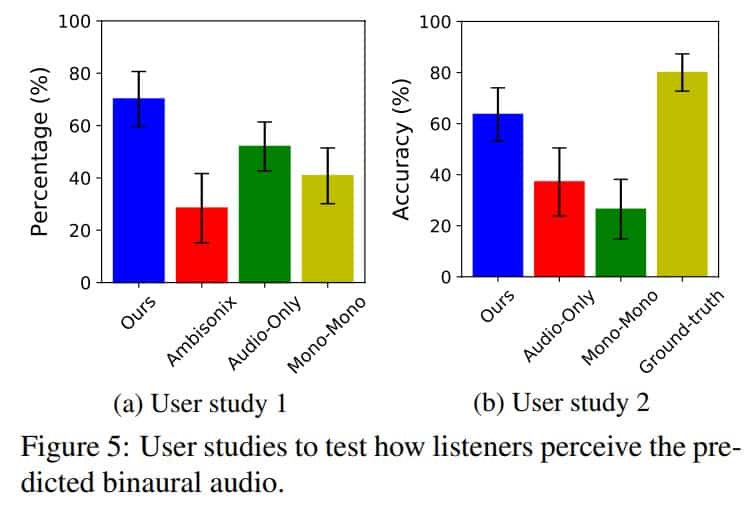

Der 2.5D Visual Sound soll gängige Raumklang-Algorithmen schlagen, bietet aber weniger Differenzierung als native binaurale Aufnahmen.

Binaurale Aufnahmen, so merken die Forscher an, können aber nur mit beträchtlichem Aufwand aufgezeichnet werden. Benötigt werden Spezialmikrofone, die die Physik des menschlichen Ohres simulieren.

Die Schallquelle muss im Bild sein

Überfordert ist das System von zu vielen Schallquellen, wenn eine Schallquelle hörbar aber nicht im Video sichtbar ist oder wenn es ähnlich aussehende Schallquellen gibt (beispielsweise ein Chor). Das Ergebnis ist verzerrter oder schwacher Sound.

Wie so häufig bei KI-Projekten, steckt der größte Aufwand im Datensatz: Die beiden Forscher zeichneten 2.265 Musikvideos gleichzeitig als Video mit binauralem Klang und in Stereo auf - mehr als sechs Stunden Videomaterial fürs KI-Training kamen so zustande.

Die Forscher sehen ihr KI-System insbesondere bei VR und AR im Einsatz und um herkömmliche Videos auf einfache Art mit überzeugendem Raumklang zu verbessern. Es soll im nächsten Schritt unter anderem mit Unterstützung für Objektlokalisierung und Bewegung erweitert werden.

Die vollständige wissenschaftliche Veröffentlichung ist hier einsehbar. Die Tonbeispiele im folgenden Video bitte mit Kopfhörern anhören:

Via: MIT

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.