4DHumans bringt Menschen aus Videos in 3D-Umgebungen

4DHumans trackt menschliche Körper in Videos und kann sie in 3D rekonstruieren. Das Team sieht zahlreiche Anwendungsgebiete und veröffentlicht das Modell.

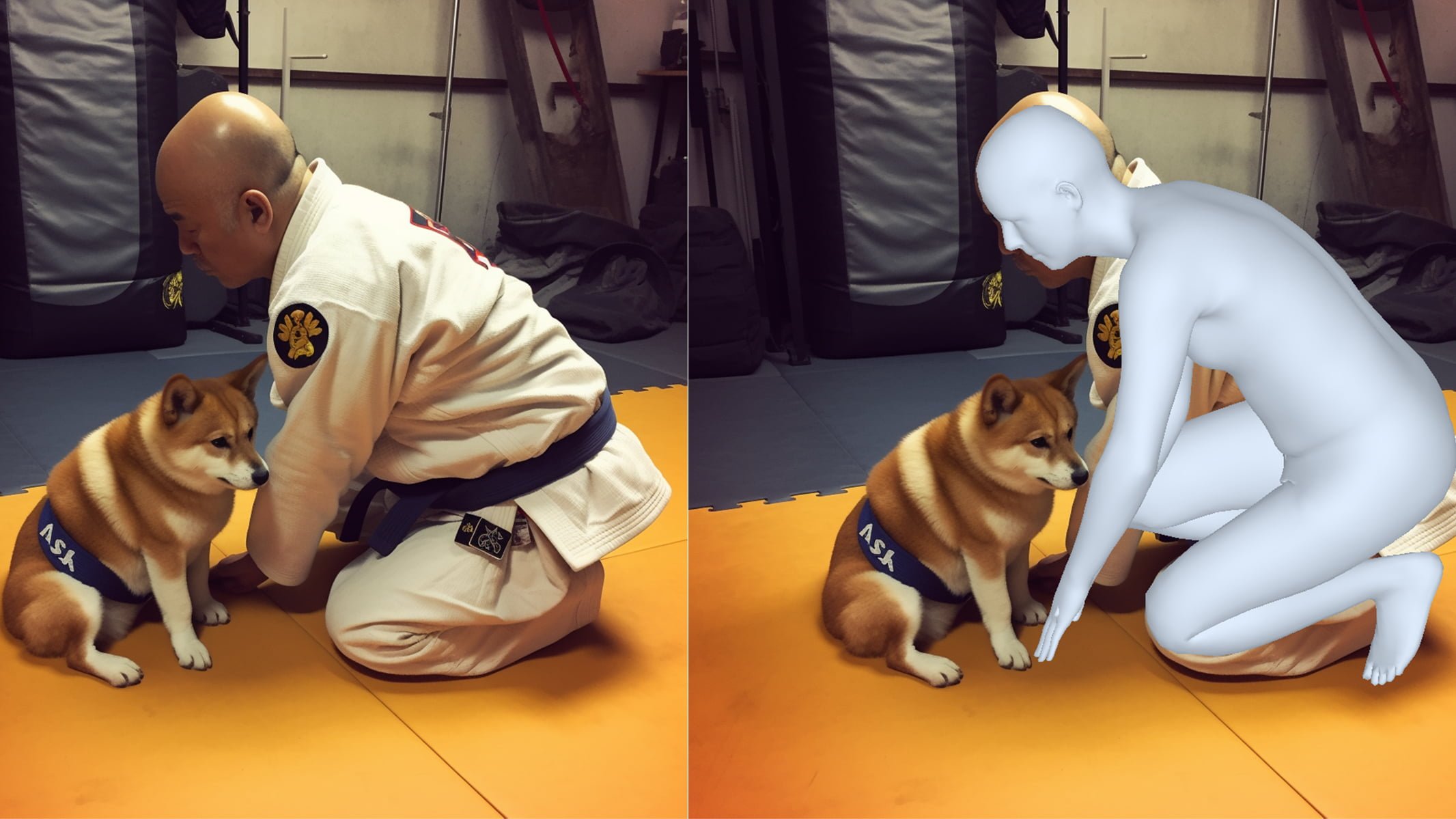

Das Herzstück von 4DHumans ist HMR 2.0, eine Weiterentwicklung einer älteren Methode (HMR / Human Mesh Recovery), die dem Trend zur Verwendung von Transformer-Architekturen für Computer Vision folgt. HMR 2.0 verwendet Vision Transformer und MLPs, um menschliche Posen in Bildern zu verfolgen, und bildet damit die Grundlage für das gesamte 4DHumans-System, das diese Informationen nutzt, um 3D-Figuren über die verfolgten Personen zu speichern.

Video: Goel et al.

Nach Angaben des Berkeley-Teams erreicht die Methode neue Bestwerte im Videotracking im Vergleich zu älteren Ansätzen und zeigt eine beeindruckende Leistung insbesondere bei der Rekonstruktion ungewöhnlicher Positionen, die bisher nur schwer zu rekonstruieren waren, wie etwa im Sport. 4DHumans ist auch in der Lage, mehrere Personen zu verfolgen, selbst wenn diese sich wie beim olympischen Ringen überlagern.

Team sieht Anwendungen in der Robotik und Biomechanik

Das Team trainierte zwei Varianten von HMR 2.0, wobei HMR 2.0b länger und mit mehr Daten trainiert wurde. Diese Variante lieferte die besten Ergebnisse und das Team plant, die Modelle in Kürze zu veröffentlichen.

"Sowohl in der maschinellen Bildverarbeitung als auch in der Verarbeitung natürlicher Sprache gibt es einen Trend hin zu großen vortrainierten Modellen (manchmal auch als "Basismodelle" bezeichnet), die weit verbreitete nachgelagerte Anwendungen finden und somit den Aufwand der Skalierung rechtfertigen. HMR 2.0 ist ein solches großes vortrainiertes Modell."

Aus dem Paper.

Als mögliche Anwendungen nennt das Team neben dem Tracking von Personen in Videos die Erkennung von Handlungen, aber auch Anwendungen in der Robotik, Computergrafik, Biomechanik und anderen Bereichen, in denen "die Analyse der menschlichen Figur und ihrer Bewegung aus Bildern und Videos benötigt wird".

Details über die Größe oder die eingesetzte Rechenleistung liegen noch nicht vor, ein Teil der Finanzierung des Projekts kam von StablityAI, die in etwa hinter Stable Diffusion steht.

Mehr Details gibt es auf der 4DHumans-Projektseite. Den Code und - sobald verfügbar - die Modelle gibt es auf GitHub.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.