Riffusion: KI-Musik aus Bildern von Stable Diffusion

Forscher erzeugen Musik aus Text über den Umweg Stable Diffusion.

Die Musiklandschaft hat sich bislang durch die jüngsten Fortschritte generativer KI-Modelle nicht so drastisch verändert wie die Text- oder Bild-Industrie - und es gibt gute Gründe für den langsameren Fortschritt. Doch auch im Audio-Bereich gibt es vermehrt Beispiele für den Einsatz generativer KI-Modelle.

Eines davon ist Riffusion, ein KI-Generator des Unternehmers Seth Forsgren und des Ingenieurs Hayk Martiros. Der Generator baut auf dem eigentlich für Bilder gedachten Open-Source-Modell Stable Diffusion auf.

Stable Diffusion generiert Spektrogramme, die dann zu Musik werden

Der Ansatz von Riffusion ist recht einfach: Stable Diffusion v1.5 generiert Bilder von Soundwellen, die anschließend in hörbare Musik umgewandelt werden. Das Modell sei lediglich mit Bildern von Spektrogrammen feinjustiert, statt neu programmiert, schreiben die Entwickler.

Ein Spektrogramm ist eine visuelle Darstellung des Frequenzinhalts eines Soundabschnitts. Die x-Achse repräsentiert die Zeit, die y-Achse die Frequenz. Die Farbe jedes Pixels gibt die Amplitude des Tons an der jeweiligen Stelle an.

Video: Riffusion

Riffusion könne unendlich viele Variationen eines Prompts erzeugen, indem es den Seed variiert. Alle aus Stable Diffusion bekannten Techniken wie img2img, Inpainting oder negative Prompts seien außerdem sofort einsatzbereit.

Werdet kreativ beim Schreiben von Prompts! Versucht es mit euren Lieblingsstilen, Instrumenten wie Saxophon oder Geige, Modifikatoren wie arabisch oder jamaikanisch, Genres wie Jazz oder Rock, Klängen wie Kirchenglocken oder Regen oder einer beliebigen Kombination. Viele Wörter, die in den Trainingsdaten nicht vorkommen, funktionieren trotzdem, weil der Text-Encoder Wörter mit ähnlicher Semantik assoziieren kann.

Je näher ein Prompt dem Seed-Image und BPM ist, desto besser sind die Ergebnisse. Ein Prompt für ein Genre, dessen BPM sehr viel schneller ist als die des Ausgangsbildes, führt beispielsweise zu einem schlechten, generischen Audio.

Riffusion

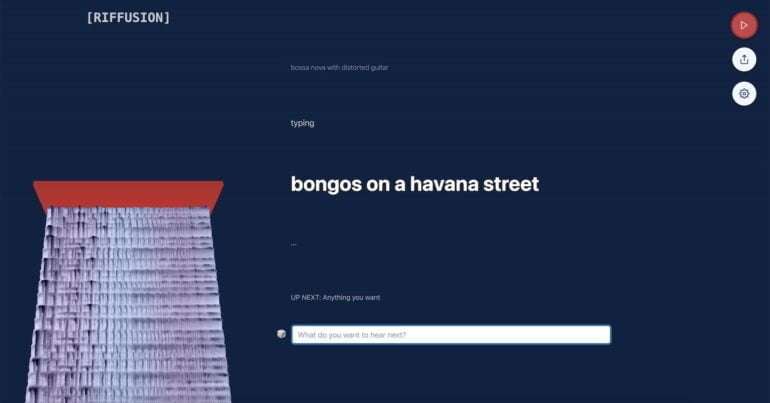

Riffusion kostenlos ausprobieren

Riffusion könnt ihr auf der offiziellen Webseite ohne Registrierung direkt ausprobieren. Einstellungsmöglichkeiten beschränken sich auf fünf verschiedene Seed Images, die sich auf melodische Muster auswirken, sowie vier Stufen von Denoising. Je größer ihr den Faktor des Denoisings wählt, desto kreativer wird zwar das Ergebnis, desto weniger trifft es allerdings auch den Takt.

Riffusion Demo - Prompt: "A robotic skull with a neural net half seen in the brain and a violin on the shoulder"

Den erstellten Beat könnt ihr über einen Link direkt mit anderen teilen oder als fünfsekündigen Ausschnitt im MP3-Format herunterladen und anschließend in entsprechender Audio-Software weiterverarbeiten. Werke von Nutzer:innen finden sich im Riffusion Subreddit.

Zudem erstellen Nutzer:innen erste Custom-Riffusion-Modelle, die auf einzelne Künstler oder Bands trainiert sind - hier etwa ein Modell für die Band "Rammstein" (Sound-Beispiele). Der generierte Sound hat zwar eine bescheidene Qualität, der Stil der Band ist allerdings unverkennbar. Eine Anleitung gibt es hier.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.