Propaganda mit KI: OpenAI stellt Risiken großer Sprachmodelle vor

Ein von OpenAI publizierter Report beschreibt die gesellschaftlichen Risiken großer Sprachmodelle im Kontext von Desinformationen und Propaganda.

Schon zur Vorstellung von GPT-2 machte OpenAI die Risiken und Nachteile großer Sprachmodelle zum Thema: Das KI-Modell, hieß es damals, sei zu gefährlich für die unbedachte Veröffentlichung, weil sich damit etwa massenhaft Fake-News generieren ließen.

Freilich wurde GPT-2 dann doch relativ schnell veröffentlicht und es erschienen leistungsfähigere Nachfolgemodelle, teils auch als Open Source. Mit ChatGPT hat OpenAI nun das für Menschen bislang zugänglichste leistungsfähige Sprachmodell kostenlos auf den Markt gebracht.

Das ist zwar heftig moderiert, dürfte aber dennoch Missbrauch nicht verhindern, etwa im Bildungskontext, für rein maschinell erstellte Pseudo-Blogs oder Spam in Kommentaren. Zudem generiert ChatGPT Fake News ungewollt selbst, indem es bei manchen Antworten Informationen erfindet.

Kurz gesagt: Die KI-Welt hat sich seit GPT-2 massiv verändert, und wohl auch OpenAI, das spätestens seit Microsofts Einstieg als Großinvestor kommerzieller denken und agieren muss.

OpenAI sucht nach Möglichkeiten gegen Sprachmodell-Propaganda

Natürlich muss sich OpenAI als führender Anbieter kommerzieller Sprachmodelle dennoch weiter mit deren Sicherheit und Moderation befassen. Im Interesse der Gesellschaft, aber auch zum Schutz des eigenen Geschäftsmodells. Ansonsten könnten etwa zu harte staatliche Eingriffe drohen, die die Entwicklung beeinträchtigen.

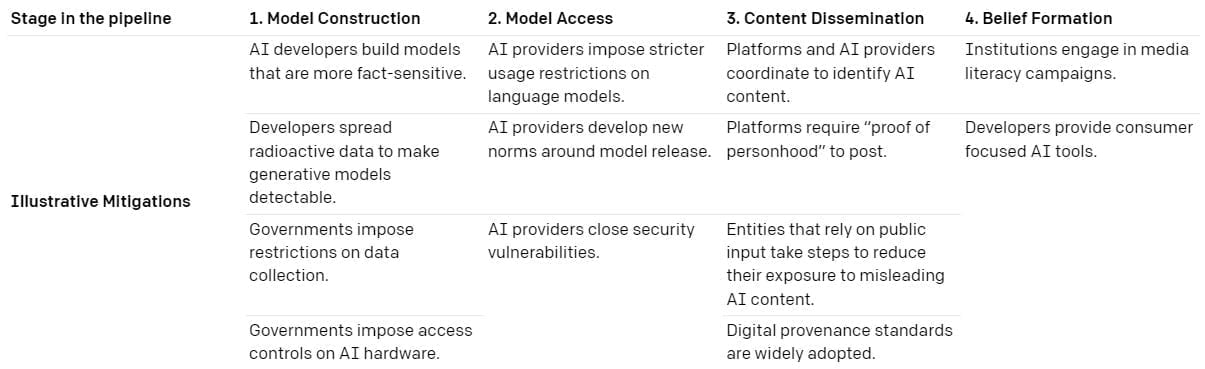

In einem neuen Papier, das OpenAI gemeinsam mit der Georgetown University’s Center for Security and Emerging Technology und dem Stanford Internet Observatory entwickelt hat, stellt OpenAI einen Rahmen für präventive Möglichkeiten gegen KI-gestützte Desinformationskampagnen vor.

Das Framework berücksichtigt Einflussnahme auf Entwicklung und Nutzung von Sprachmodellen in verschiedenen Stufen (Modellentwicklung, Zugriff auf das Modell, Verbreitung der Inhalte, Wahrnehmung durch Endnutzer) durch unterschiedliche Akteure.

Nur weil Möglichkeiten zum Eingriff bestünden, seien diese jedoch nicht per se erstrebenswert oder umsetzbar. Das Papier bewertet einzelne Maßnahmen nicht, gibt aber Gesetzgebern vier Leitfragen an die Hand:

- Technische Durchführbarkeit: Ist die vorgeschlagene Abhilfemaßnahme technisch durchführbar? Erfordert sie wesentliche Änderungen an der technischen Infrastruktur?

- Soziale Durchführbarkeit: Ist die Abschwächung aus politischer, rechtlicher und institutioneller Sicht machbar? Erfordert sie eine kostspielige Koordination, gibt es Anreize für die Hauptakteure, sie umzusetzen, und ist sie im Rahmen bestehender Gesetze, Vorschriften und Industriestandards durchführbar?

- Negativszenarien: Was sind die potenziellen negativen Auswirkungen der Abhilfemaßnahmen und wie groß sind sie?

- Auswirkung: Wie wirksam wäre die vorgeschlagene Abhilfemaßnahme bei der Reduzierung der Bedrohung?

Content-Kosten gehen gegen null

Als Risiken sieht das Forschungsteam, dass weitverbreitete Sprachmodelle Desinformation automatisieren und die Kosten deutlich senken könnten. Entsprechende Kampagnen seien mit Sprachmodellen leichter zu skalieren und ermöglichten neue Taktiken, etwa die Echtzeit-Generierung propagandistischer Inhalte mit Chatbots.

Zudem könnte die KI womöglich der bessere Propagandist sein und "wirkungsvollere oder überzeugendere Botschaften erstellen". Sie könnte propagandistische Botschaften darüber hinaus abwechslungsreicher gestalten und so dafür sorgen, dass Propaganda schwerer zu entlarven sei im Vergleich zu Copy-Spam in sozialen Netzwerken.

Unser Fazit lautet, dass Sprachmodelle für Propagandisten nützlich sein und die Online-Einflussnahme wahrscheinlich verändern werden. Selbst wenn die fortschrittlichsten Modelle privat bleiben oder über eine Programmierschnittstelle (API) kontrolliert werden, werden Propagandisten wahrscheinlich zu Open-Source-Alternativen tendieren und Nationalstaaten könnten selbst in diese Technologie investieren.

OpenAI

Laut des Forschungsteams existieren zudem zahlreiche unbekannte Variablen: Wer investiert wo, welche emergenten Fähigkeiten stecken noch in Sprachmodellen, wie einfach und öffentlich wird die Nutzung der Modelle und entstehen neue Normen, die KI-Propagandisten abschrecken könnten?

Die Arbeit sei daher "weit entfernt" von einer finalen Bestandsaufnahme und diene viel mehr als Grundlage für weitere Diskussionen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.