ControlNet gibt euch mehr Kontrolle über Stable Diffusions Kreativität

ControlNet ist eine simple Finetuning-Methode, die Stable Diffusions Image-to-Image-Fähigkeiten erheblich verbessert.

Stable Diffusion kann Bilder aus Text generieren, aber auch Bilder als Vorlage für weitere Generierungen verwenden. Diese Bild-zu-Bild-Pipeline wird häufig verwendet, um generierte Bilder zu verbessern oder neue Bilder auf der Grundlage der Vorlage zu erstellen.

Die Kontrolle über diesen Prozess war bisher jedoch recht begrenzt, auch wenn mit Stable Diffusion 2.0 die Möglichkeit eingeführt wurde, Tiefeninformationen aus einem Bild als Vorlage zu verwenden. Die ältere Version 1.5, die immer noch weit verbreitet ist und vor allem wegen der großen Anzahl an benutzerdefinierten Modellen verwendet wird, unterstützt diese Methode jedoch nicht.

ControlNet bringt Finetuning für kleine GPUs

Forscherinnen und Forscher der Stanford University haben nun ControlNet vorgestellt, eine "neuronale Netzstruktur zur Steuerung von Diffusionsmodellen durch Hinzufügen zusätzlicher Bedingungen".

ControlNet kopiert die Gewichte der einzelnen Blöcke von Stable Diffusion in eine trainierbare und eine blockierte Variante. Die trainierbare Variante kann durch Feintuning mit kleinen Datensätzen neue Bedingungen für die Bildsynthese lernen, während die gesperrte Variante die Fähigkeiten des fertigen Diffusionsmodells beibehält.

"Keine Schicht wird von Grund auf neu trainiert. Man nimmt nur eine Feinabstimmung vor. Ihr ursprüngliches Modell ist sicher", schreiben die Forscher. Dies ermögliche das Training sogar auf privaten Computern mit einer GPU ab acht Gigabyte Grafikspeicher.

Forschende veröffentlichen zahlreiche ControlNet-Modelle für Stable Diffusion

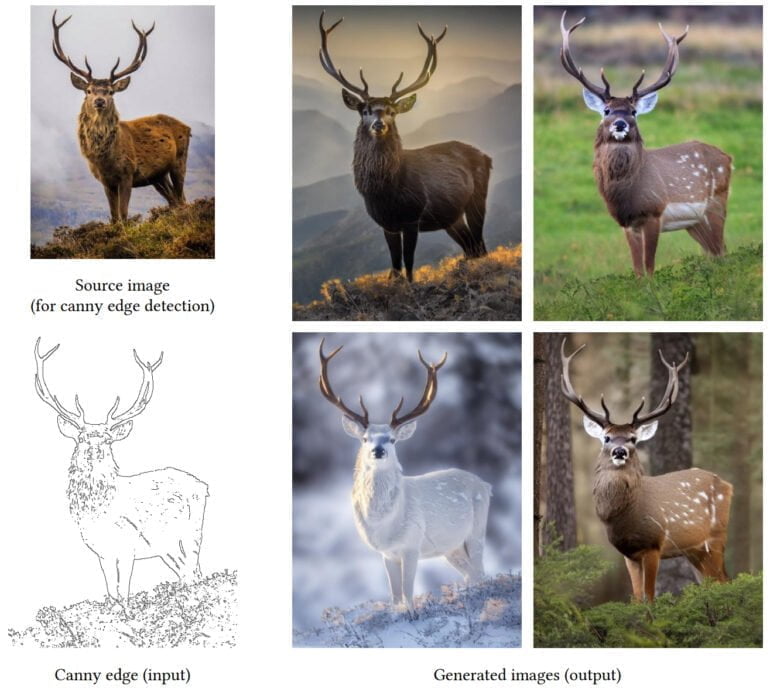

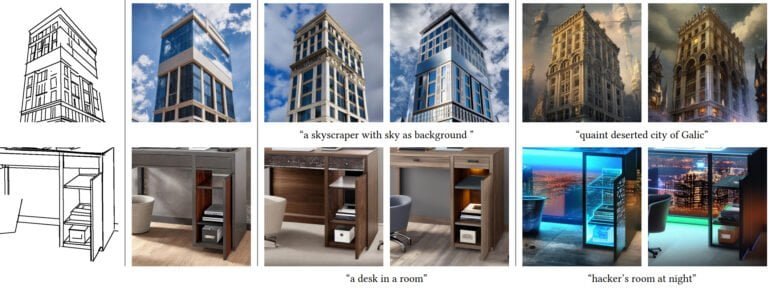

Das Team nutzt ControlNet, um eine Reihe von vortrainierten Modellen zu veröffentlichen, die eine bessere Kontrolle über die Bild-zu-Bild-Pipeline ermöglichen. Zu den Modellen gehören solche für die Kanten- oder Linienerkennung, Grenzdetektion, Tiefeninformation, Skizzenverarbeitung und die Erkennung menschlicher Posen oder semantischer Maps.

Alle ControlNet-Modelle können mit Stable Diffusion verwendet werden und ermöglichen eine wesentlich bessere Kontrolle der generativen KI. Das Team zeigt Beispiele für Varianten von Personen mit konstanter Pose, verschiedene Bilder von Inneneinrichtungen, die sich an der räumlichen Struktur des Modells orientieren, oder Varianten eines Vogelbildes.

Ähnliche Steuerungswerkzeuge gibt es für GANs, mit ControlNet kommen die Werkzeuge nun in die derzeit deutlich mächtigeren Diffusionsmodelle. Weitere Beispiele, den Code und die Modelle gibt es im ControlNet-Github.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.