Deepmind: Mit Perceiver IO auf dem Weg zur Multi-KI

Deepmind stellt Perceiver IO vor, ein echtes Multitalent unter den neuronalen Netzen. Es könnte die weit verbreitete Transformer-Architektur ablösen.

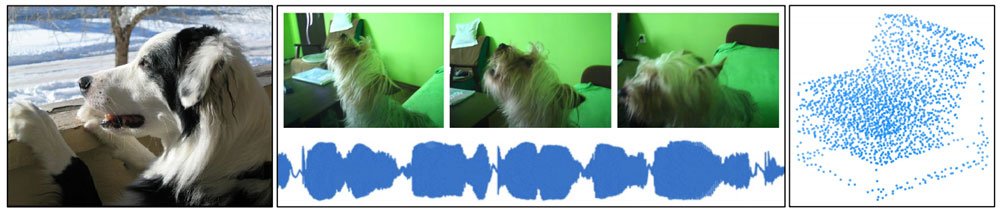

Im März stellte Deepmind eine neue generalisierte Architektur für neuronale Netze vor, die verschiedene Modalitäten wie Bilder, Audio, Text oder Point-Cloud-Daten verarbeiten kann, ohne extra für die jeweiligen Aufgaben angepasst werden zu müssen.

Die "Perceiver"-Architektur ist eine Weiterentwicklung der in der Textverarbeitung und Bildanalyse eingesetzten Transformer-Module und erreichte etwa im ImageNet-Test das Niveau der weit verbreiteten ResNet-50-Architektur, schlug im AudioSet-Test alle vergleichbaren Modelle und war mit einer Genauigkeit von 85,7 der Cloud-Point-KI PointNet++ (91,9) auf der Spur.

Die Vielseitigkeit von Perceiver bei der Verarbeitung von Inputs aus verschiedenen Quellen ist durch einen "Cross-Attention" genannten Mechanismus möglich. Die normale Transformer-Architektur verrechnet während des Trainings sogenannte Token, etwa einen Teil eines Wortes, mit allen anderen Token, etwa alle Wörter innerhalb eines Paragrafen. Dadurch entsteht ein quadratischer Prozess: Bei 500 Token werden so schon 250.000 Rechenoperationen durchgeführt.

Was bei der Verarbeitung von Texten noch möglich ist, scheitert spätestens bei der Bildanalyse: Schon ein gering aufgelöstes Bild mit nur 250 x 250 Pixeln führt zu 62.500² (3.906.250.000) Rechenoperationen. Auf die Bildanalyse spezialisierte Transformer-Systeme wie Googles Vision Transformer umgehen dieses Problem, indem sie statt einzelne Pixel einige wenige Bildabschnitte verarbeiten.

Perceiver verpackt die Eingangsdaten erst in ein Vektor-Paket

Perceiver kann dagegen knapp 50.000 Pixel große Bilder problemlos verarbeiten, da die in den Daten enthaltenen Informationen zuerst in eine Matrix kodiert werden. Das Netz stellt dann eine fixe Anzahl Anfragen an die Matrix. Die Informationen aus diesen Anfragen werden anschließend verarbeitet und informieren erneute Anfragen an die Matrix.

Dieser Prozess wiederholt sich mit jeder Schicht von Perceiver. Mit jeder Anfrage bekommt das Netz so mehr Einblicke in die Struktur der Eingangsdaten. Dieser Cross-Attention genannte Prozess ist ein rechnerischer Flaschenhals, da die Anzahl der Anfragen in Perceiver auf knapp 1.000 begrenzt ist.

Für 50.000 Pixel muss Perceiver so 50.000 x 1.000 Rechenoperationen durchführen. Ohne Cross-Attention wären es 50.000². Statt Pixel können in der Matrix auch andere Daten wie Audio- oder Point-Cloud-Daten repräsentiert werden.

Perceiver IO bringt Verbesserungen beim Output

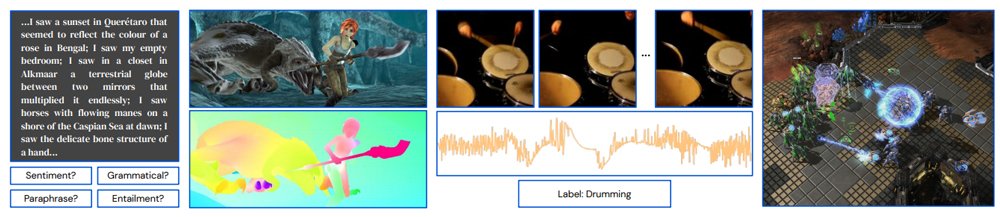

Während Perceiver zahlreiche verschiedene Typen von Eingangsdaten verarbeitet, ist seine Fähigkeit zur Ausgabe beschränkt: Das Netz eignet sich lediglich für simple Aufgaben wie die Klassifizierung von Bildern. Deepminds KI-Forscher stellen daher jetzt die nächste Entwicklung des Netzes vor: Perceiver IO kann aus verschiedenen Eingangsdaten eine Vielzahl von Ergebnissen erzeugen und eignet sich so für den Einsatz in der Sprachverarbeitung, der Bildanalyse oder dem Verstehen multimodaler Daten wie Videos.

Dafür haben die Forscher von Deepmind Perceiver IO neben der Fähigkeit, die in Daten enthaltenen Informationen über Cross-Attention in eine Matrix zu kodieren, auch die Fähigkeit gegeben, diese Information per Cross-Attention wieder zu dekodieren. Diese Fähigkeit verschafft Perceiver IO große Flexiblität: Perceiver IO sei für große und vielfältige Eingabedaten und Ausgaben skalierbar und könne mit zahlreichen Aufgaben und Datentypen gleichzeitig umgehen, schreiben die Forscher.

Perceiver IO kann Bewegungen in Videos analysieren und über Optical Flow visualisieren. | Video: Deepmind

In ihren Tests lassen die Forscher das KI-System Texte im Stil von Googles BERT-Algorithmus analysieren, erstellen Optical-Flow-Maps, die die Bewegungen innerhalb eines Videos vorhersagen, rekonstruieren komprimierte Videos inklusive Audio ausgehend von Eingabevideos und lassen Perceiver IO innerhalb von AlphaStar Starcraft-2-Einheiten erkennen. In allen Aufgaben spielt Perceiver IO in der Liga vergleichbarer Systeme und skaliert, anders als Transformer, linear.

Originalvideo:

Rekonstruktion von Perceiver IO:

Laut Deepmind ist Perceiver IO ein guter Kandidat für eine Allzweck-Architektur für neuronale Netze. Weitere Forschung soll zeigen, wie gut sich das System für die Generierung etwa von Texten eignet und herausfinden, ob sich die Größe der eingesetzten Matrix automatisiert an die jeweilige Aufgabe anpassen lässt.

Deepmind stellt Perceiver IO kostenlos auf Github zur Verfügung.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.