KI erkennt Ethnizität in medizinischen Aufnahmen

KI-Systeme erkennen die ethnische Identität von Patienten in medizinischen Bildern und niemand versteht, weshalb. Das ist ein Problem.

Medizinische Bildanalyse-KIs sollen schnellere und bessere Diagnosen ermöglichen und so die Qualität der medizinischen Vorsorge und Versorgung steigern. Sie werden etwa für die Erkennung von Lungenerkrankungen oder Hauterkrankungen eingesetzt.

Eine Herausforderung beim Einsatz Künstlicher Intelligenz ist die Tendenz der Systeme, Unterscheidungen anhand von Merkmalen zu lernen, die nicht explizit Teil der Trainingsdaten sind - wie Geschlecht oder Ethnizität. Lernt eine KI etwa, Ärzte zu erkennen, kann ein Datensatz, der häufig Männer in weißen Kitteln und mit heller Hautfarbe zeigt, dazu führen, dass das KI-System in Zukunft Frauen mit anderen Hautfarben und weißen Kitteln nicht als Ärzte erkennt.

Auch bei Bildanalyse-KIs in der Medizin, die anhand medizinischer Bilder Krankheiten diagnostizieren sollen, zeigt sich immer wieder, dass diese Systeme je nach ethnischer Identität der Patienten unterschiedliche Leistungen erbringen.

KI-Diagnose erkennt Ethnizität

Die unterschiedliche Leistung der KI-Systeme je nach Ethnizität weisen jedoch laut einer Gruppe KI-Forscher und Mediziner auf ein noch tieferliegendes Problem hin: Die KI-Systeme erkennen die ethnischen Identitäten der Patienten auf den Bildern, ohne dass es für menschliche Experten eine bekannte Korrelation für Ethnizität auf medizinischen Bildern gibt.

Das stelle ein enormes Risiko für alle Modelleinsätze in der medizinischen Bildgebung dar: Wenn sich ein KI-Modell auf seine Fähigkeit zur Erkennung der Ethnizität verlässt, um medizinische Entscheidungen zu treffen, dabei aber alle schwarzen Patienten falsch klassifiziert, könnten klinische Radiologen, die üblicherweise keinen Zugriff auf ethnische und demografische Informationen haben, dies nicht erkennen. In der Konsequenz könnten KI-Modelle eine ganze Reihe von Fehldiagnosen für eine bestimmte Ethnizität auswerfen, ohne dass Menschen dies anhand der gleichen Daten erkennen können.

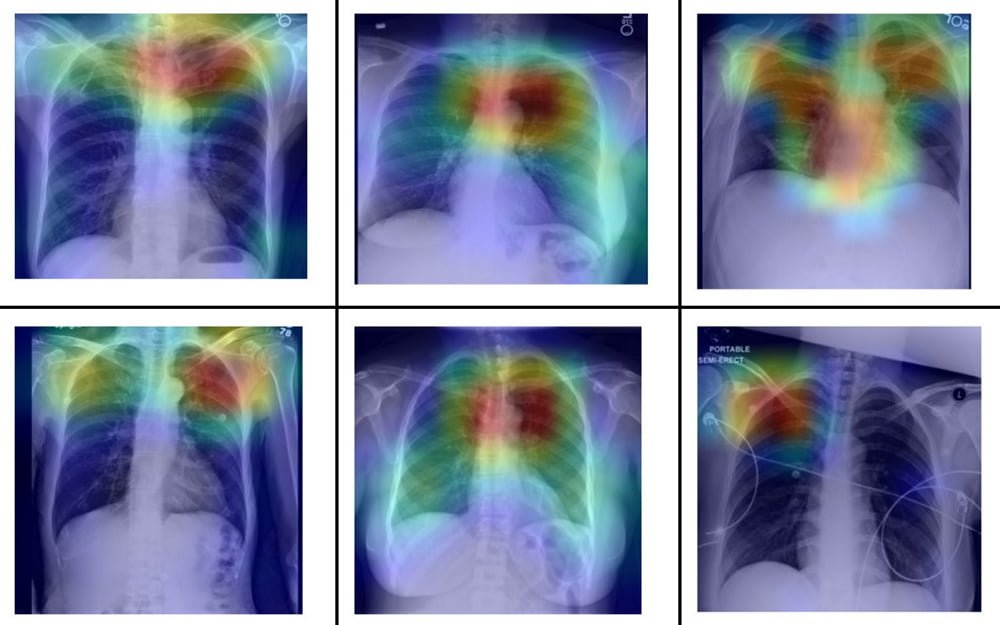

In ihrer systematischen Untersuchung zeigen die Forscher außerdem, dass das Problem deutlich größer als angenommen ist: Standard-KI-Systeme können die Ethnizität aus Röntgen- und CT-Bildern mit hoher Leistung vorhersagen und das sogar aus beschädigten, beschnittenen oder verrauschten Bildern und anhand verschiedener Körperregionen.

Medizinische KI-Bildanalyse: Forscher warnen vor unvorsichtigem Einsatz

Die Forscher fanden keine Methode, diese Fähigkeit zu unterbinden, die nicht gleichzeitig auch die Daten oder das KI-System unbrauchbar für die Diagnose machten.

"Unsere Ergebnisse deuten nicht nur darauf hin, dass KI-Modelle die Ethnizität auf triviale Weise erlernen können, sondern dass es wahrscheinlich extrem schwierig sein wird, diese Fähigkeit zu entfernen", schreiben die Forscher.

Es benötige daher Strategien zur Erkennung von möglichen Verzerrungen durch menschliche Experten und gezieltes Nachtraining, um für alle Ethnizitäten gleiche Ergebnisse zu erreichen.

Die Forscher rufen alle Entwickler, Regierungsbehörden und Anwender, die sich mit KI-Diagnosesystemen befassen, daher zu äußerster Vorsicht auf, um bestehende Ungleichheiten in der medizinischen Versorgung nicht weiter zu verstärken.

Zukünftige Systeme müssten auf ihre Leistung je nach Ethnizität, Geschlecht und Alter getestet werden. Die Forscher fordern außerdem, dass medizinische Datensätze immer Informationen zur Ethnizität enthalten, damit die Fähigkeit der KI-Modelle, diese Information aus Bildern abzuleiten, besser untersucht werden kann.

Titelbild: Banerjee et al. | Via: Arxiv

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar“‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.