OpenAI-Mitbegründer erklärt, warum ChatGPT funktioniert

Ilya Sutskever, Mitbegründer von OpenAI, erklärt, warum unüberwachtes Lernen funktioniert und wie es mit überwachtem Lernen zusammenhängt.

In einem Vortrag am Simons Institute for the Theory of Computing an der UC Berkeley erklärt Ilya Sutskever, Mitbegründer von OpenAI, unüberwachtes Lernen durch die Brille der Datenkompression. Die Kernidee: Gute Kompressoren können gute Vorhersagen machen.

Unüberwachtes oder selbst-überwachtes Lernen ist die Trainingsmethode, mit der das Unternehmen Foundation-Modelle wie GPT-3.5 und GPT-4, die ChatGPT zugrunde liegen, trainiert, bevor sie weiter angepasst werden, zum Beispiel durch Reinforcement Learning mit menschlichem Feedback.

Stärkere Kompressoren finden mehr gemeinsame Strukturen

Überwachtes Lernen ist mathematisch gut verstanden - wenn der Trainingsfehler klein ist und die Modellkapazität stimmt, sind Lernergebnisse garantiert. Dem unüberwachten Lernen fehlt dieses formale Verständnis.

Sutskever schlägt vor, unüberwachtes Lernen durch die Brille der Kompression zu betrachten: Ein guter Kompressor, der zwei Datensätze komprimiere, finde und nutze gemeinsame Muster, so wie das unüberwachte Lernen Strukturen in unmarkierten Daten finde und für Vorhersagen nutze.

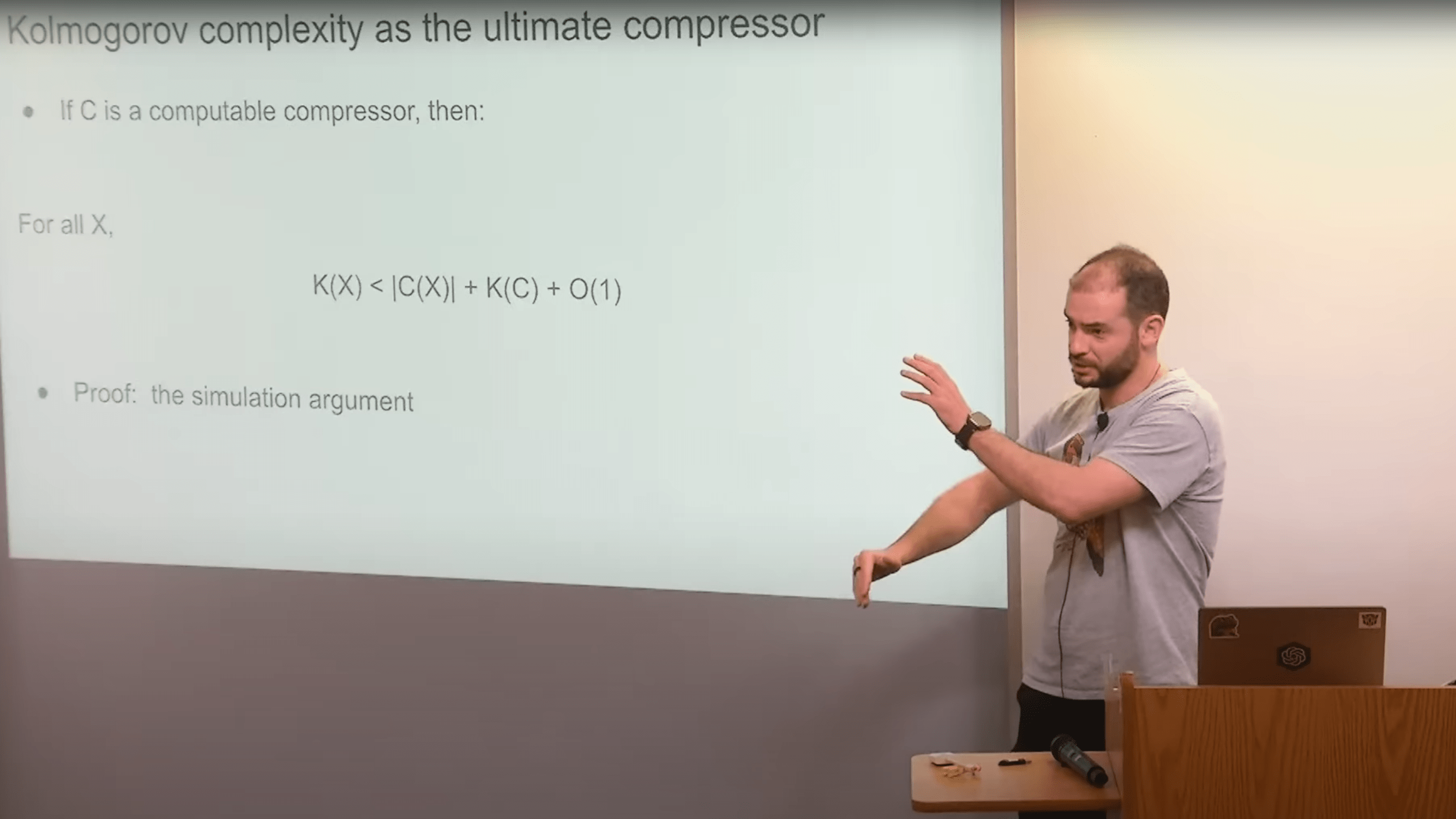

Stärkere Kompressoren fänden mehr gemeinsame Strukturen, und die Kolmogorov-Komplexität sei ein Maß für den theoretisch optimalen Kompressor, erklärte Sutskever dem Publikum. Die Kolmogorov-Komplexität kann als Maß für die Kompression verwendet werden und wird durch die Länge des kürzesten Programms bestimmt, das einen String erzeugt.

Er argumentierte, dass große neuronale Netze, die mit Gradient Descent trainiert werden, sich diesem optimalen Kompressor annähern und dass unüberwachtes Lernen daher als Annäherung an die optimale Datenkompression verstanden werden könne.

Pixel-Vorhersage: iGPT als Kompressor

Als Beispiel stellte er iGPT vor, ein OpenAI-Experiment aus dem Jahr 2020, bei dem das Team ein Transformer-Modell trainierte, um das nächste Pixel in Bildern vorherzusagen.

Diese Pixelprognose führte bei großen Bilddatensätzen Ergebnissen, die sich gut auf die Bildklassifikation und generative Fähigkeiten übertragen ließen.

Laut Sutskever unterstützen die Ergebnisse die Ansicht, dass die Vorhersage des nächsten Pixels, die er als Kompressionsaufgabe sieht, Regelmäßigkeiten in den Daten findet, daraus nützliche Repräsentationen für nachgelagerte Aufgaben lernt und damit über die bloße Abbildung der Datenverteilung hinausgeht. Denn für genaue Vorhersagen sei es sinnvoll, weitreichende Abhängigkeiten in den Bildern zu finden, um beispielsweise aus einigen Pixeln eines Bildes frühzeitig zu erkennen, dass das Gesamtbild eine Katze zeigt.

Diese Ideen bieten nicht nur einen besseren Rahmen für das Verständnis des unüberwachten Lernens, sondern können auch als grundlegend für die Art und Weise angesehen werden, wie OpenAI KI-Modelle konstruiert. Das Unternehmen sieht in diesen Techniken eine Möglichkeit, die Grenzen der KI-Fähigkeiten zu erweitern, und steht damit im Gegensatz zu Argumenten, wie sie beispielsweise in der Auffassung von GPT-Modellen als stochastische Papageien vorgebracht werden.

Der vollständige Vortrag ist auf YouTube verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.