Forscher testen GPT-4-Vision für autonomes Fahren

Kann OpenAIs GPT-4-Vision autonomes Fahren verbessern? Chinesische Forschende haben das Bild-Sprach-Modell auf die Straße geschickt.

Bild-Sprache-Modelle wie OpenAIs GPT-4 Vision (GPT-4V) könnten, wenn es nach Unternehmen wie Nvidia geht, in Zukunft ein zentraler Baustein für maschinelles Sehen in industriellen Anwendungen, in der Robotik und beim autonomen Fahren werden. In einer neuen Studie hat ein Team aus dem Shanghai Artificial Intelligence Laboratory, GigaAI, der East China Normal University, der Chinese University of Hong Kong und WeRide.ai GPT-4V für autonome Fahrszenarien getestet.

GPT-4V verfügt im Gegensatz zum reinen Sprachmodell GPT-4 über ausgeprägte Fähigkeiten im Bereich der Bilderkennung und kann beispielsweise Inhalte beschreiben oder Kontext liefern. Das Team hat GPT-4V in einer Reihe von Aufgaben getestet, von der einfachen Szenenerkennung bis hin zur komplexen Kausalanalyse und Echtzeit-Entscheidungsfindung unter verschiedenen Bedingungen.

GPT-4 Vision übertrifft bei einigen Anwendungen derzeitigen Systeme

Die Ergebnisse zeigen, so das Team, dass GPT-4V im Vergleich zu bestehenden autonomen Systemen eine teilweise überlegene Leistung beim Szenenverständnis und bei der Analyse von Grenzfällen - so genannten Corner Cases - aufweist. Das System hat auch gezeigt, dass es in der Lage ist, Szenarien außerhalb der Verteilung zu bewältigen, Absichten zu erkennen und informierte Entscheidungen in realen Fahrsituationen zu treffen.

Gleichzeitig zeigt das Modell Schwächen in Bereichen, die für das autonome Fahren besonders relevant sind, insbesondere in der räumlichen Wahrnehmung. So zeigt GPT-4V beispielsweise schwache Ergebnisse bei der Richtungsunterscheidung und erkennt nicht alle Ampeln.

Team testet GPT-4 Vision mit Straßenaufnahmen

Konkret wurden die Fähigkeiten des Modells in verschiedenen Aspekten des autonomen Fahrens getestet. Im Bereich des Szenenverständnisses war GPT-4V beispielsweise in der Lage, Wetter- und Lichtverhältnisse zu erkennen, Ampeln und Verkehrsschilder in verschiedenen Ländern zu identifizieren und die Positionen und Handlungen anderer Verkehrsteilnehmer auf Fotos, die von verschiedenen Kameratypen aufgenommen wurden, zu schätzen.

Grenzfälle, wie beispielsweise bei einem Bild eines notgelandeten Flugzeugs auf einer Straße oder einer komplexen Baustelle, sowie das Verstehen und Analysieren von Panoramabildern und zeitlich aufeinanderfolgenden Bildern konnte GPT-4V ebenfalls verarbeiten. Es war auch in der Lage, Straßenbilder mit Bildern eines Navigationssystems zu verknüpfen.

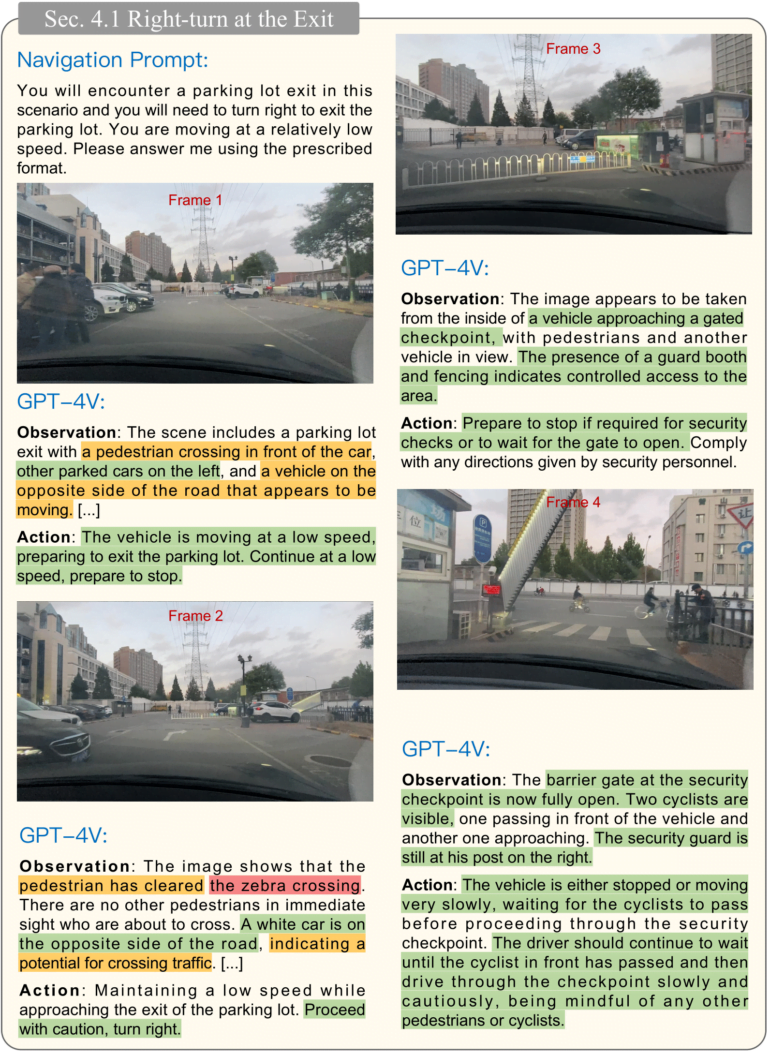

In einem abschließenden Test übertrug das Team dem GPT-4V die Aufgabe, als Fahrer zu agieren und Entscheidungen in realen Fahrsituationen auf der Grundlage der Umgebung zu treffen. Das Modell wurde Bild für Bild mit Fahrvideos, wichtigen Fahrzeuggeschwindigkeiten und anderen relevanten Informationen gefüttert und musste die erforderlichen Aktionen ausführen und seine Entscheidungen begründen. Das System bewältigte auch diese Aufgabe - mit einigen Fehlern.

GPT-4 Vision ist vielversprechend, zeigt aber gefährliche Schwächen

Das Team sieht in Systemen wie GPT-4V ein erhebliches Potenzial, bestehende autonome Fahrsysteme in Aspekten des Szenenverständnisses, der Intentionserkennung anderer Verkehrsteilnehmer und der Entscheidungsfindung zu übertreffen. Einschränkungen in der räumlichen Wahrnehmung und Fehler bei der Erkennung von Ampeln führen jedoch dazu, dass GPT-4V allein in einem solchen Szenario derzeit nicht geeignet ist.

Zusätzliche Forschung sei notwendig, um die Robustheit und Anwendbarkeit von GPT-4V und anderen Bild-Sprache-Modelle in verschiedenen Fahrsituationen und -bedingungen zu erhöhen. Weiter Informationen und alle Daten sind auf GitHub verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.