Med-Gemini und Meditron: Google und Meta stellen neue LLMs für Medizin vor

Google und Meta stellen Sprachmodelle vor, die für medizinische Aufgaben optimiert sind und auf den großen LLMs Gemini und Llama 3 basieren. Sie sollen Ärzte und medizinisches Personal bei verschiedenen Aufgaben unterstützen.

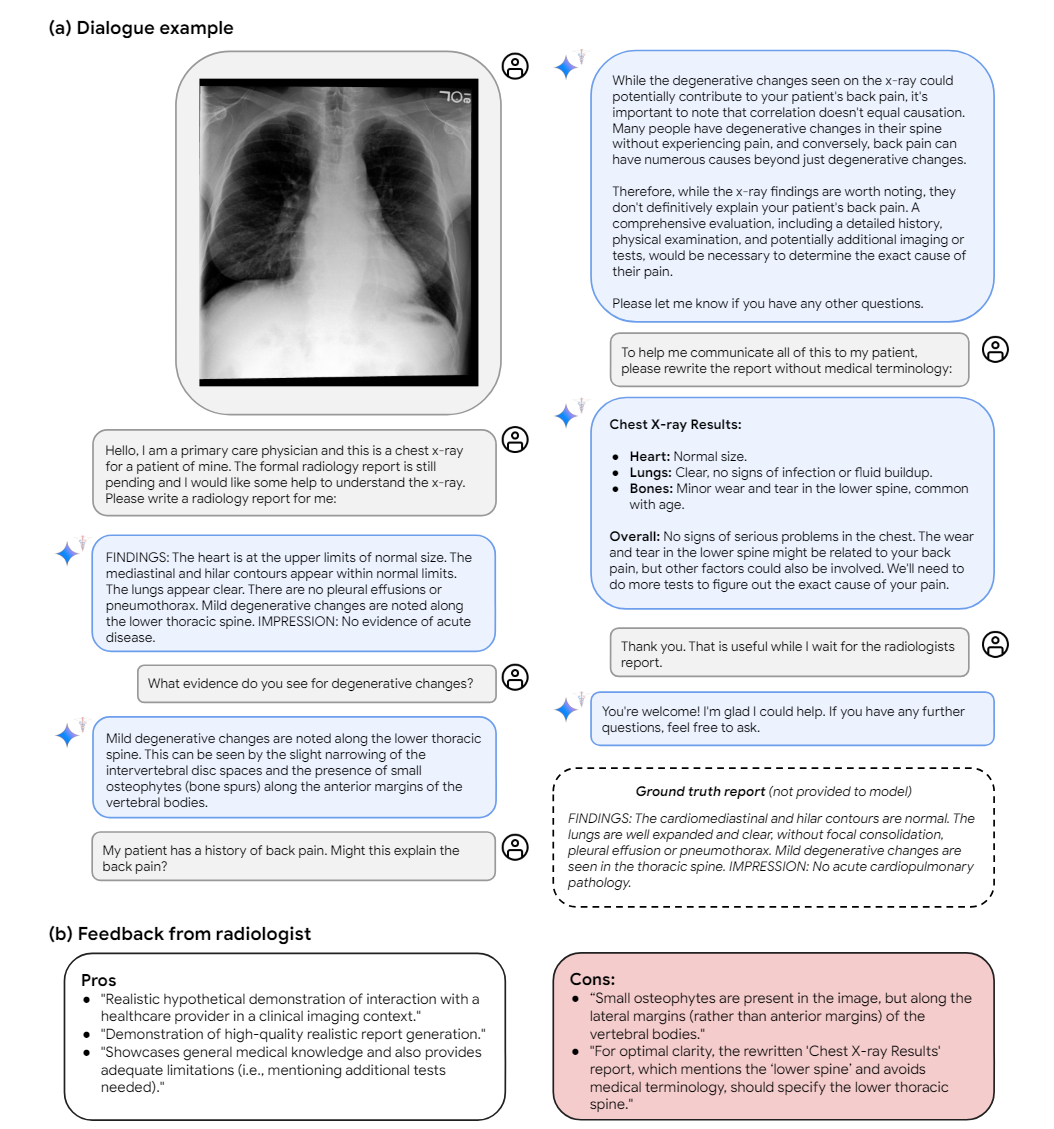

Googles Med-Gemini basiert auf der multimodalen Gemini-Modellfamilie. Es wurde mit medizinischen Daten weiter trainiert, um daraus logische Schlüsse zu ziehen, verschiedene Modalitäten wie Bilder und Text zu verstehen und lange Kontexte zu verarbeiten.

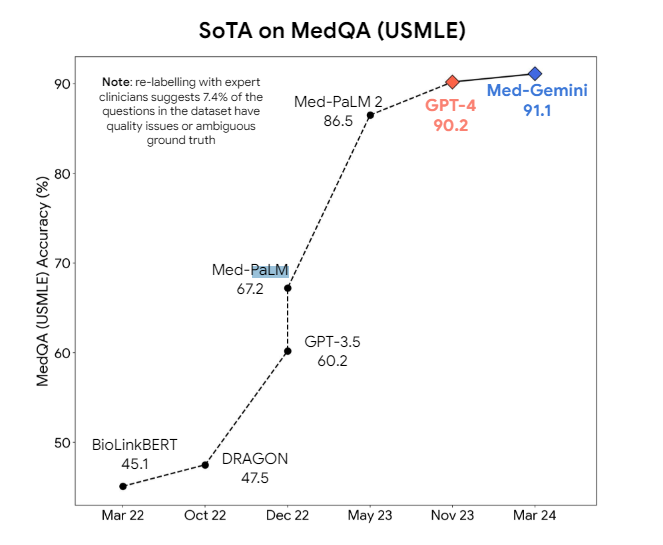

Laut Google erreicht Med-Gemini in 10 von 14 getesteten medizinischen Benchmarks neue Bestwerte, unter anderem bei der Beantwortung medizinischer Prüfungsfragen.

Med-Gemini verwendet zusätzlich eine unsicherheitsbasierte Websuche. Wenn das Modell bei einer Frage unsicher ist, führt es automatisch eine Websuche durch. Durch die zusätzlichen Informationen aus dem Web soll die Unsicherheit des Modells reduziert und die Antwortqualität verbessert werden.

Bei der Beantwortung medizinischer Fragen liegt Med-Gemini knapp vor dem Vorgängermodell Med-PaLM 2 und noch knapper vor dem nicht speziell für medizinische Fragen optimierten GPT-4.

Dies mag als kleine Verbesserung erscheinen, aber bei der Entwicklung eines zuverlässigen medizinischen Modells wird die Luft nach oben immer dünner und jeder Prozentpunkt zählt. Es zeigt aber einmal mehr, dass GPT-4 als generisches LLM in vielen Bereichen bereits sehr leistungsfähig ist.

Bei multimodalen Aufgaben wie der Auswertung medizinischer Bilder ist der Unterschied laut Google deutlicher. Hier übertrifft Med-Gemini GPT-4 um durchschnittlich 44,5 Prozent. Durch Feintuning und angepasste Encoder können auch Modalitäten wie EKG-Aufzeichnungen verarbeitet werden.

Die Verarbeitung langer Kontexte nutzt Google, um eine LLM-basierte Suche in langen pseudonymisierten Patientenakten durchzuführen. Ebenso kann Med-Gemini Fragen zu medizinischen Lehrvideos beantworten.

Meta entwickelt Open-Source Medizin-LLM

Meta hat zusammen mit der ETH Lausanne und der Yale University auf der Basis des Open-Source-Modells Llama 3 eine Suite namens Meditron entwickelt. Sie soll insbesondere in Entwicklungsländern und bei humanitären Einsätzen nützlich sein.

Durch kontinuierliches Vortraining auf sorgfältig zusammengestellten medizinischen Daten sollen Verzerrungen durch das ursprüngliche Webtraining von Llama 3 vermieden werden. Aus Kostengründen testete das Forscherteam den optimalen Datenmix zunächst am 7B-Modell und skalierte ihn dann auf das 70B-Modell.

Meditron ist laut Meta das leistungsfähigste Open-Source-LLM für Medizin in Benchmarks wie der Beantwortung biomedizinischer Prüfungsfragen. Es wird in einer "Massive Online Open Validation and Evaluation" (MOOVE) von Ärzten aus aller Welt, insbesondere aus Entwicklungsländern, getestet und weiterentwickelt. Meditron ist in der 7B- und 70B-Variante bei Hugging Face verfügbar.

Beide Modelle müssen sich noch in der Praxis bewähren. Insbesondere für den Einsatz in der Diagnostik sind noch viele Fragen zu Risiken, Nachvollziehbarkeit und Haftung zu klären. Auch Google und Meta betonen, dass weitere umfangreiche Forschung und Entwicklung notwendig ist, bevor ein Einsatz bei sicherheitskritischen medizinische Aufgaben möglich ist.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.