Deepmind-Analyse zeigt Missbrauch generativer KI zwischen 2023 und 2024

Eine neue Analyse von Google DeepMind kartiert die Taktiken und Motive hinter Missbräuchen von generativer KI zwischen Januar 2023 und März 2024 und liefert ein Lagebild der größten Bedrohungen.

Forscher von Google DeepMind, Jigsaw und Google.org haben eine qualitative Analyse von 200 Medienberichten über den Missbrauch von generativen KI-Modellen (GenAI) zwischen Januar 2023 und März 2024 veröffentlicht.

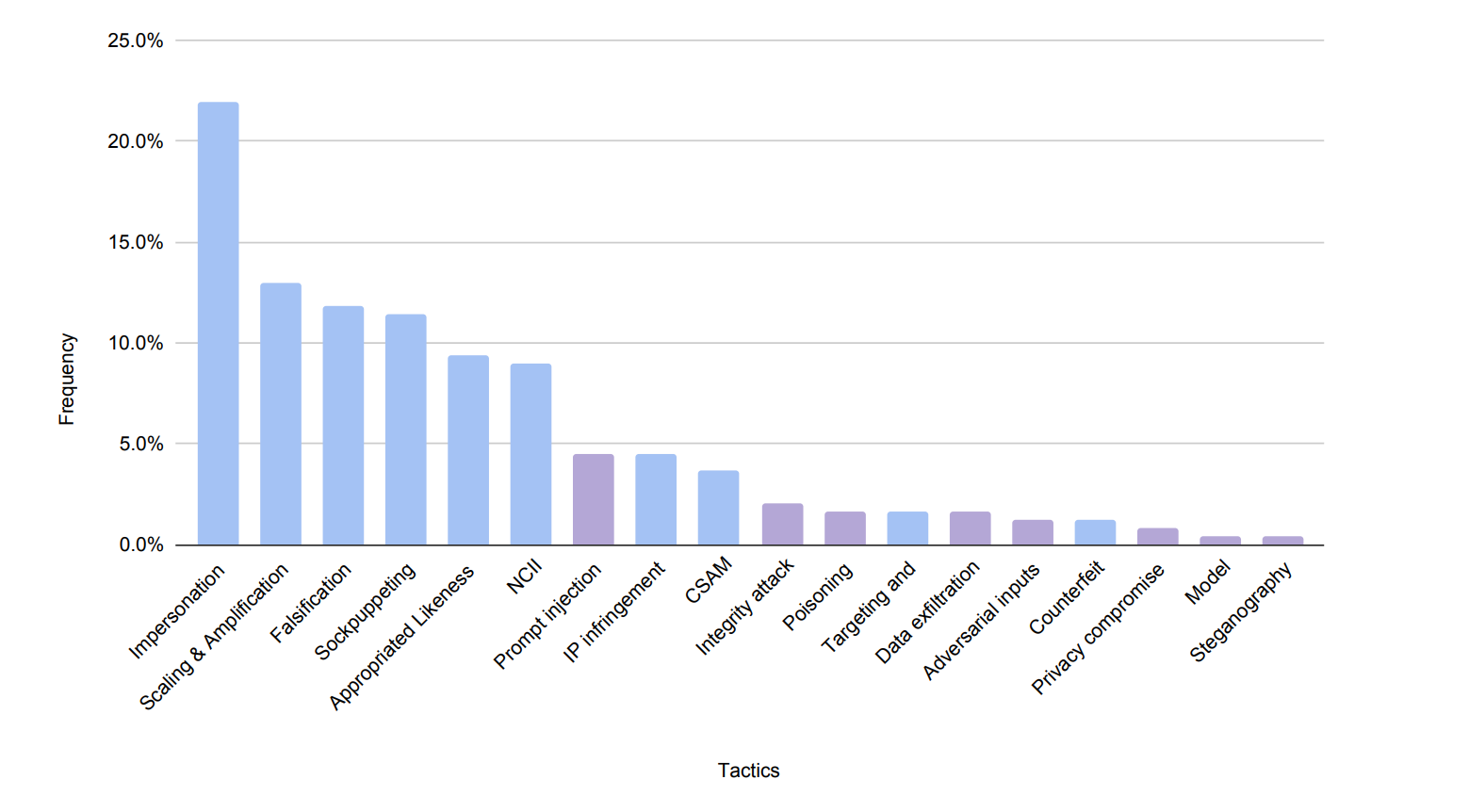

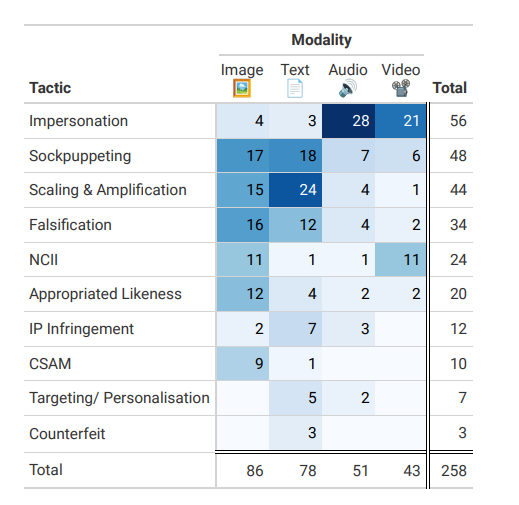

Wie die Studie zeigt, zielen die meisten beobachteten Fälle von GenAI-Missbrauch darauf ab, die Fähigkeiten dieser Systeme auszunutzen, anstatt die Modelle selbst direkt anzugreifen. Am häufigsten wird die Darstellung realer Personen manipuliert, z. B. durch Identitätsdiebstahl, Sockenpuppen-Taktiken oder die nicht einvernehmliche Generierung intimer Bilder.

Weitere verbreitete Taktiken sind laut der Analyse die Verbreitung von Falschinformationen sowie die Skalierung und Verstärkung von Inhalten durch GenAI-gestützte Bots und Fake-Profile.

Die Verfasser der Studie fanden heraus, dass die meisten Fälle von Missbrauch keine technologisch anspruchsvollen Angriffe auf KI-Systeme darstellen. Stattdessen werden vor allem leicht zugängliche GenAI-Fähigkeiten ausgenutzt, die nur minimales technisches Fachwissen erfordern.

"Die zunehmende Ausgereiftheit, Verfügbarkeit und Zugänglichkeit von GenAI-Tools führt offenbar zu neuen Formen des Missbrauchs auf niedrigerer Ebene", schreiben die Autoren.

Diese Missbräuche seien weder offen bösartig noch würden sie explizit gegen die Nutzungsbedingungen dieser Tools verstoßen. Sie hätten aber dennoch bedenkliche ethische Auswirkungen.

Als Beispiel nennen die Forscher neue Formen der politischen Kommunikation und Interessenvertretung, die zunehmend die Grenzen zwischen Authentizität und Täuschung verwischen.

Ziele des GenAI-Missbrauchs: Meinungsmanipulation und Profit

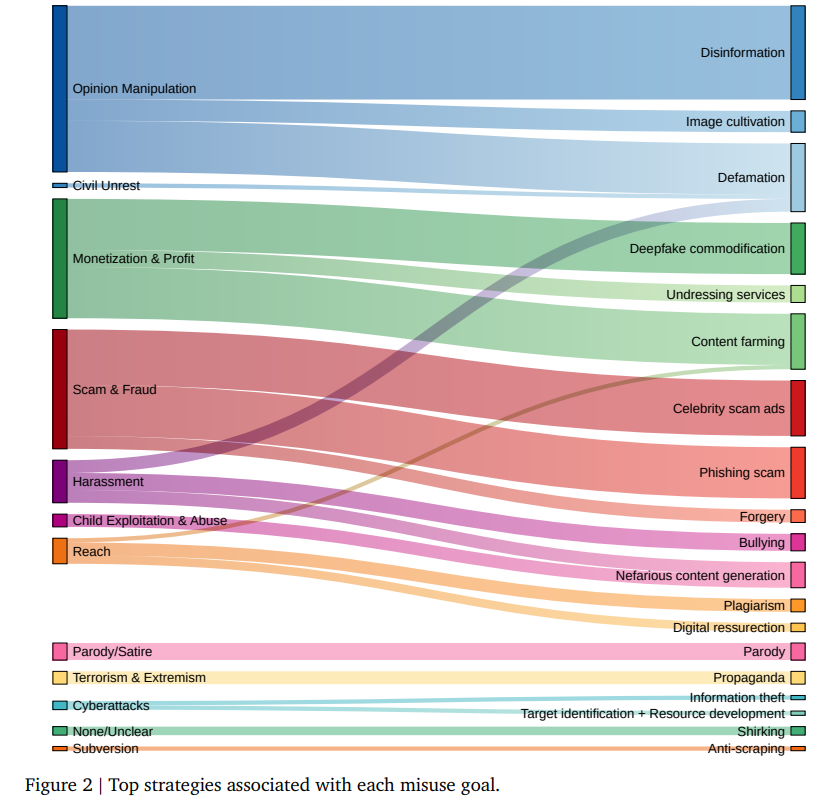

Die häufigsten Motive hinter dem Missbrauch von GenAI sind der Studie zufolge die Beeinflussung der öffentlichen Meinung (27 % der gemeldeten Fälle) und die Monetarisierung von Produkten und Dienstleistungen (21 %). An dritter Stelle stehen betrügerische Aktivitäten wie Informations-, Geld- oder Vermögensdiebstahl (18 %).

Zur Meinungsmanipulation setzten die Akteure eine Reihe von Taktiken ein. Dazu gehören die Nachahmung öffentlicher Personen, die Vortäuschung von Graswurzel-Unterstützung für oder gegen eine Sache durch synthetische digitale Persönlichkeiten ("Astroturfing") und die Erstellung gefälschter Medien.

Die meisten Fälle im Datensatz der Forscher betrafen die Generierung emotional aufgeladener synthetischer Bilder zu politisch umstrittenen Themen wie Krieg, gesellschaftliche Unruhen oder wirtschaftlicher Niedergang. Andere zielten durch gefälschte kompromittierende Darstellungen von Politikern auf Rufschädigung ab.

Auch die von Microsoft und OpenAI aufgedeckten Missbrauchsfälle ihrer KI-Systeme bewegten sich vornehmlich im politischen Spektrum, hatten aber offenbar nur geringe Auswirkungen. OpenAI verschärfte zuletzt die Zugangssperren für China, Russland und weitere Länder.

KI-generierte Inhalte werden auch in großem Umfang produziert, um Werbeeinnahmen zu erzielen. Betrügerische Aktivitäten wie gefälschte Promi-Werbung für Krypto-Systeme oder personalisierte Phishing-Kampagnen sind ebenfalls häufig.

Angriffe auf KI-Systeme selbst sind noch selten

Angriffe auf GenAI-Systeme selbst wurden laut der Studie zwischen 2023 und 2024 meist im Rahmen von Forschungsarbeiten durchgeführt, um Schwachstellen aufzudecken. Etwa ein Drittel dieser Angriffe nutzte "Prompt Injections", um Modelle zu manipulieren.

Echte Angriffe auf die eingesetzten GenAI-Systeme waren in diesem Zeitraum noch selten. Die Forscher dokumentierten nur zwei reale Fälle, in denen es darum ging, das unerlaubte Scraping von urheberrechtlich geschütztem Material zu verhindern und den Nutzern die Möglichkeit zu geben, unzensierte Inhalte zu generieren.

Die Ergebnisse liefern eine Beweisgrundlage für das Schadenspotenzial dieser Technologien, die Regulierer, Trust-and-Safety-Teams und Forscher bei der Entwicklung von KI-Richtlinien und Gegenmaßnahmen nutzen können. Mit multimodalen Möglichkeiten und neuen Fähigkeit würden wahrscheinlich neue Missbrauchsmethoden entstehen, so die Forscher.

Um effektiv auf die sich rasch verändernde Bedrohungslage reagieren zu können, brauche es aber vor allem einen umfassenderen Überblick durch den Austausch anonymisierter Daten zwischen den Akteuren, betonen die Autoren der Studie. Sie plädieren deshalb für ein branchenweites Informationsaustauschsystem nach dem Vorbild der Luftfahrtindustrie.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.