Google gibt Menschen ihre Stimme zurück, selbst wenn sie nie eine hatten

Das Stimmenklonen hat in jüngster Vergangenheit große Fortschritte gemacht. Mittlerweile reichen wenige Sekunden Quellmaterial, um Stimmen bestimmter Personen zu synthetisieren. Vor allem Menschen mit derartigen Einschränkungen können davon profitieren.

In einem aktuellen Blogbeitrag hat Google ein neues Zero-Shot-Sprachübertragungsmodul für Text-to-Speech-Systeme vorgestellt. Dieses soll die Stimmen von Menschen etwa mit Dysarthrie wiederherstellen können, die ihre typische Stimme verloren haben oder nie eine hatten.

"Bei Sprechern mit degenerativen Nervenkrankheiten wie amyotropher Lateralsklerose (ALS), Parkinson und Multipler Sklerose können sich im Laufe der Zeit einige der einzigartigen Merkmale ihrer Stimme verschlechtern", erklären die Autor:innen in dem Blogbeitrag. "Manche Menschen werden mit Krankheiten wie Muskeldystrophie geboren, die das artikulatorische System beeinträchtigen und ihre Fähigkeit darauf beschränken, bestimmte Laute zu produzieren."

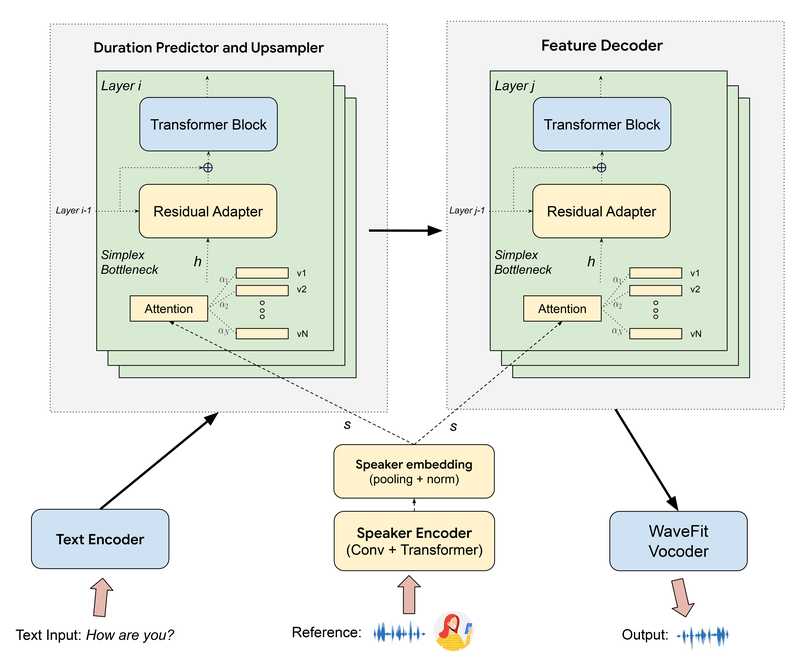

Während frühere Sprachübertragungstechnologien üblicherweise eine Sprachprobe der sprechenden Person erforderten, um ein vortrainiertes Modell anzupassen, entfällt bei Googles neuem Zero-Shot-Ansatz die Notwendigkeit eines Trainings.

Stattdessen verwendet es während der Generierung Audio-Referenzmuster eines Sprechers, um seine Stimme auf die synthetisierte Sprachausgabe zu übertragen. Dadurch eignet es sich beispielsweise auch für Menschen mit Dysarthrie, die nicht genügend Stimmproben gespeichert haben oder nie eine typische Stimme hatten.

Die Forschenden haben ihr Voice-Transfer-Modul in ein TTS-System integriert und dessen Wirksamkeit bei der Wiederherstellung der Stimmen von Sprecher:innen demonstriert, die ihre typische Sprache vor der Stimmverschlechterung gespeichert hatten. Beeindruckenderweise erzeugte das Modell eine qualitativ hochwertige Sprache mit hoher Stimmtreue, selbst wenn die Eingangsreferenz atypisch war.

Das Modul akzeptiert ein Spektrogramm mit einer Länge von zwei bis 14 Sekunden und extrahiert eine Repräsentation der akustisch-phonetischen sowie prosodischen Stimmeigenschaften, die als Embedding-Vektor in die weiteren Schichten weitergeleitet werden.

Stimmen-Ähnlichkeit zumindest eine 8/10

In einer Fallstudie stellte der taube Google-Forscher Dimitri Kanevsky zwölf Sekunden seiner atypischen Stimme als Referenz zur Verfügung. Das Modell synthetisierte ein Transkript von Kanevskys Originalvideo. Arbeitskolleg:innen bewerteten die Ähnlichkeit der Ausgabestimme mit seiner eigenen im Durchschnitt mit 8,1/10.

Eine weitere Untersuchung befasste sich mit Aubrie Lee, einer Google-Mitarbeiterin mit Muskeldystrophie, die nie eine typische Stimme hatte. Unter Verwendung von 14 Sekunden von Lees atypischer Referenzstimme synthetisierte das Modell die automatische Abschrift ihres Videos. Lee selbst bewertete die Ähnlichkeit der Ausgabestimme mit ihrer eigenen mit 8/10.

Die Forscher demonstrierten auch die Fähigkeiten des Modells, die Stimme in andere Sprachen wie Französisch, Spanisch, Italienisch, Arabisch, Deutsch, Russisch, Hindi und Norwegisch zu übertragen. Alle Stimmschnipsel finden sich auf dieser GitHub-Projektseite.

Wasserzeichen soll Missbrauch vorbeugen

Um Bedenken hinsichtlich eines möglichen Missbrauchs synthetisierter Sprache auszuräumen, verwendet Google sein Wasserzeichen-System SynthID, um nicht wahrnehmbare Informationen in die synthetisierte Audiowellenform einzubetten. Das soll die Identifizierung potenziell manipulierter oder missbräuchlich generierter Audioinhalte ermöglichen.

Laut Google sei das Missbrauchsrisiko bei Personen, die ohnehin nie typische Sprachmuster hatten, aber ohnehin deutlich geringer, da die synthetisierte Natur der Ausgabe hörbar wäre.

Der Mangel eines verlässlichen Systems zur Kennzeichnung hatte Microsoft kürzlich von der Veröffentlichung eines ähnlich mächtigen Modells zur Stimmsynthese abgehalten. Zu einer möglichen Veröffentlichung von Googles neuem System hat sich das Unternehmen bislang nicht geäußert.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.