Runway stellt neues KI-Modell für Gesichtsanimationen vor

RunwayMLs neues "Act-One"-Modell soll gängige Motion-Capture-Verfahren angreifen - und hat darüber hinausgehende Implikationen.

Traditionelle Methoden zur Gesichtsanimation erfordern oft komplexe, mehrstufige Arbeitsabläufe mit spezieller Motion-Capture-Ausrüstung, mehreren Referenzaufnahmen und manueller Nachbearbeitung. Act-One soll diesen Prozess stark vereinfachen, indem es die Performance eines Schauspielers direkt auf Basis von Video- und Sprachaufnahmen auf einen animierten Charakter überträgt.

Demo-Video für Act One. | Video: RunwayML

Laut RunwayML ist das Modell in der Lage, selbst feinste Details der Schauspielleistung zu erfassen und zu übertragen. Bemerkenswert ist, dass dafür laut Unternehmen bereits ein Smartphone ausreicht.

Vielseitige Anwendungsmöglichkeiten

RunwayML betont die Vielseitigkeit von Act-One. Das Modell lässt sich demnach auf eine Vielzahl von Referenzbildern anwenden und soll realistische Gesichtsausdrücke bewahren, selbst wenn die Proportionen des Zielcharakters von denen im ursprünglichen Quellvideo abweichen.

In einem Demovideo zeigt das Unternehmen, wie Act-One die Performance aus einem einzigen Eingabevideo auf verschiedene Charakterdesigns und in unterschiedliche Stile übertragen kann. Dabei soll das Modell laut RunwayML filmische und realistische Ergebnisse produzieren und robust bei verschiedenen Kamerawinkeln und Brennweiten funktionieren.

Das naheliegende Anwendungsszenario ist die Übertragung menschlicher Mimik und Stimme auf animierte Charaktere, ähnlich wie bei klassischen Motion-Capture-Projekten für Spiele und Filme.

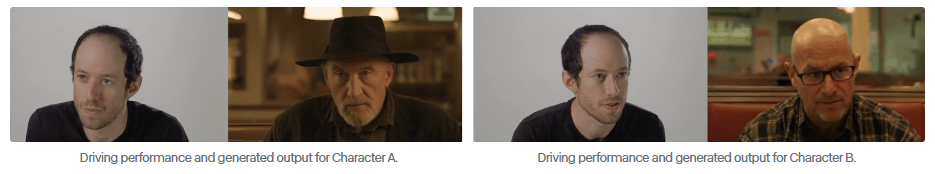

RunwayML stellt jedoch noch ein weiteres Szenario vor: die Übertragung der Schauspielleistung auf fotorealistische Avatare. In einer weiteren Demo zeigt das Unternehmen, wie ein einzelner Schauspieler in einer Szene zwei virtuelle Avatare spielen kann.

Video: RunwayML

"Sie können jetzt narrative Inhalte erstellen, indem Sie nichts weiter als eine handelsübliche Kamera und einen Schauspieler verwenden, der verschiedene Charaktere aus einem Skript liest und darstellt", erklärt RunwayML.

Der Zugang zu Act-One wird laut RunwayML ab sofort schrittweise für Nutzer freigeschaltet und soll bald allen zur Verfügung stehen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.