Apple entwickelt KI-System für plattformübergreifende App-Steuerung

Apple hat eine neue Version seiner KI für Benutzeroberflächen vorgestellt. Ferret-UI 2 versteht Bildschirminhalte auf verschiedenen Plattformen und kann mit ihnen interagieren.

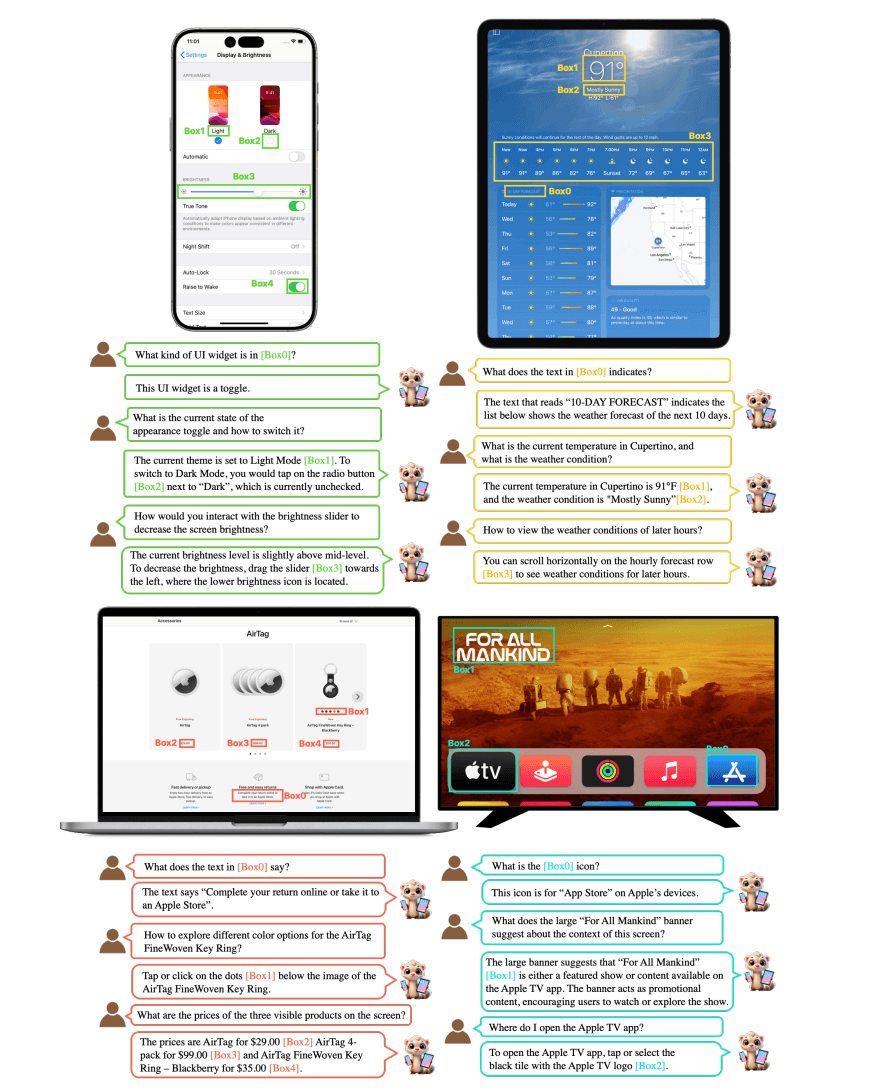

Laut der von Apple veröffentlichten Forschungsarbeit kann das System Bildschirminhalte auf iPhone, iPad, Android, Web und Apple TV plattformübergreifend verstehen und mit ihnen interagieren.

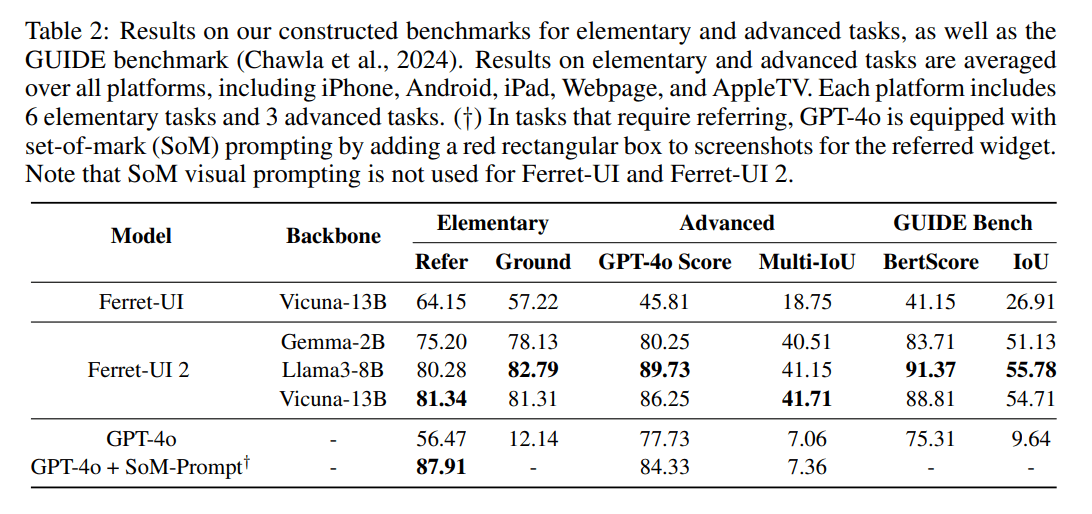

Das System wurde mit verschiedenen KI-Sprachmodellen getestet. Am besten schnitt Llama-3 ab, aber auch das kompakte Gemma-2B zeigte bereits gute Leistungen. Bei der Erkennung und Interpretation von UI-Elementen erreicht Ferret-UI 2 laut Apple einen Score von bis zu 89,73, während das größere Cloud-Modell GPT-4o nur 77,73 erreicht. Außerdem übertrifft es seinen Vorgänger bei allen elementaren Aufgaben wie der Erkennung von Texten und Schaltflächen und auch bei komplexeren Aufgaben deutlich.

Besseres Training durch KI-gestützte Datengenerierung

Eine wichtige Neuerung betrifft die Trainingsdaten: Die Apple-Forscher nutzten die visuellen Fähigkeiten von GPT-4o, um qualitativ hochwertige Trainingsdaten zu erzeugen. Dadurch kann das System laut des Teams die räumlichen Beziehungen zwischen den Elementen der Benutzeroberfläche besser verstehen.

Statt mechanischer Klickanweisungen mit X/Y-Koordinaten wolle man so ein System entwickeln, das die Intentionen des Nutzers versteht, erklärt das Forscherteam in der Veröffentlichung. Bei der Aufforderung "Bitte bestätigen Sie die Eingabe" soll das System beispielsweise in der Lage sein, selbstständig die richtige Schaltfläche zu identifizieren.

Darüber hinaus haben die Apple-Forscher das System mit einer flexiblen Architektur ausgestattet, die eine präzise und flexible Erkennung von UI-Elementen auf verschiedenen Plattformen ermöglicht.

Ein spezieller Algorithmus passt dabei die Bildauflösung automatisch an die jeweilige Plattform an und findet dabei die beste Balance zwischen Bildverzerrung und Rechenaufwand. Die Forscher geben an, dass diese Methode "sowohl informationserhaltend als auch effizient für die lokale Kodierung" sei.

Ein nur mit iPhone-Daten trainiertes Modell erreichte nach Angaben der Forscher auch auf iPad (68 Prozent) und Android (71 Prozent) gute Ergebnisse. Auch der umgekehrte Weg funktioniert. Zwischen Mobilgeräten und TV- und Web-Systemen funktioniert die Übertragung allerdings weniger gut. Die Apple-Forscher führen dies auf die unterschiedlichen Bildschirmformate und Inhalte zurück.

Zwei Ferret-UI-Modelle auf Llama- und Gemma-Basis stehen bei Hugging Face zur Verfügung, ebenso wie eine Demo.

Wettlauf um bessere KI-Agenten mit UI-Verständnis: Neues Open-Source-Modell von Microsoft

Apple steht im Wettbewerb um bessere UI-Agenten nicht allein: Anthropic hat kürzlich mit dem neuen Claude 3.5 Sonnet ein KI-Modell vorgestellt, das ebenfalls verbesserte Fähigkeiten zur Bildverarbeitung und UI-Interaktion bietet. Microsoft hat mit OmniParser ein Open-Source-Tool veröffentlicht, das Bildschirminhalte in strukturierte Daten umwandeln kann.

Die Verbesserung der UI-Erkennung gilt als wichtiger Schritt hin zu KI-Systemen, die selbstständig mit Benutzeroberflächen interagieren können. Solche Systeme könnten in Zukunft komplexe Aufgaben in Anwendungen übernehmen oder Nutzer bei der Navigation unterstützen.

Apples KI-Forschungsabteilung stellt kürzlich das Agenten-Framework CAMPHOR (Collaborative Agents for Multi-input Planning and High-Order Reasoning On Device) vor. CAMPHOR verwendet eine hierarchische Struktur mit spezialisierten Agenten, die von einem übergeordneten Reasoning-Agent koordiniert werden. Dieser zerlegt komplexe Aufgaben in Teilschritte und weist sie den Expertenagenten zu.

In Kombination mit einem System wie Ferret-UI 2 könnte Apple versuchen, ein Spracheingabesystem wie Siri auf Zuruf komplexe Aufgaben analysieren und allein durch einen Sprachbefehl ausführen zu lassen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.