Man hätte GPT-4 auf 2012er GPUs trainieren können - es wäre nur sehr teuer geworden

Ein neuer Simulator von Epoch AI zeigt, dass das Training von Modellen im GPT-4-Maßstab auch mit älterer Hardware möglich gewesen wäre – allerdings zu deutlich höheren Kosten.

Das KI-Forschungsunternehmen Epoch AI hat einen interaktiven Simulator für verteiltes Training veröffentlicht, mit dem sich die Rechenleistung für das Training großer Sprachmodelle simulieren lässt. Laut Epoch AI ermöglicht das Tool unter anderem die Beantwortung der Frage, ob man GPT-4 auch auf Grafikprozessoren (GPUs) aus dem Jahr 2012 hätte trainieren können.

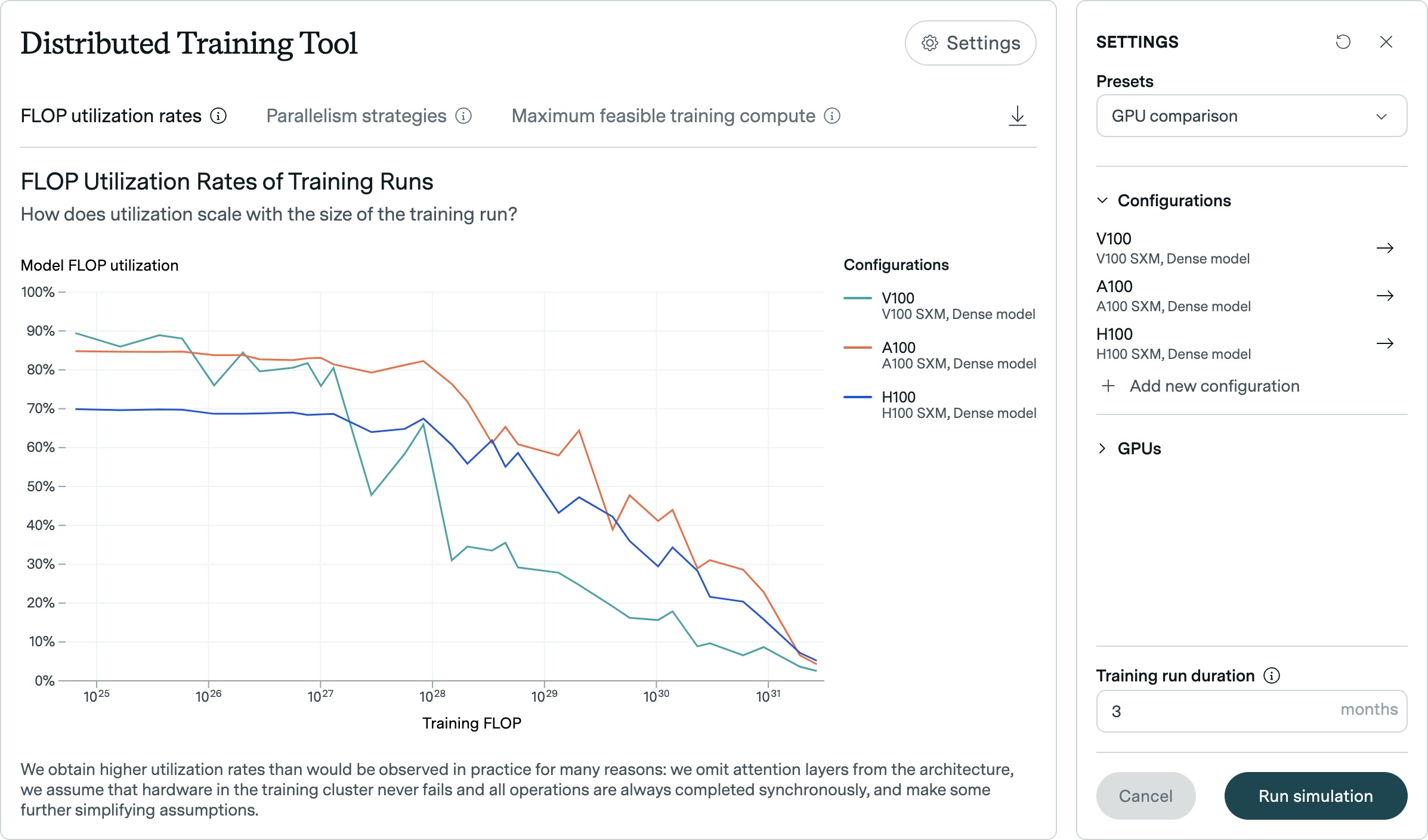

Der Simulator setzt die FLOP-Auslastung (Floating Point Operations Per Second) eines Modells mit der für das Training benötigten Rechenleistung in Beziehung. Dabei zeige sich, so Epoch AI, dass die bestmögliche Auslastung mit zunehmender Modellgröße auf gleicher Hardware abnimmt.

Zehnmal höhere Kosten mit alter Hardware

In einem Experiment simulierte Epoch AI das Training mit einer GPU vom Typ GTX 580 mit 3GB Speicher - jener Grafikkarte, die 2012 für das Training des berühmten AlexNet-Modells verwendet wurde.

Das überraschende Ergebnis: Selbst mit dieser alten Hardware wäre das Training eines GPT-4-ähnlichen Modells technisch machbar gewesen.

Da das Training von GPT-4 schätzungsweise zwischen 1e25 und 1e26 FLOP benötigt, deutet die Simulation laut Epoch AI darauf hin, dass Modelle dieser Größenordnung auch mit der Technologie von 2012 trainiert hätten werden können. Allerdings wären die Kosten im Vergleich zu heute etwa zehnmal höher gewesen.

Der Simulator erlaubt es Nutzern, eigene GPU-Konfigurationen zu definieren und verschiedene Modell-Skalierungsstrategien zu testen. So können etwa die Leistungsunterschiede zwischen modernen GPUs wie der H100 und A100 analysiert oder die Auswirkungen verschiedener Batch-Größen untersucht werden.

Auch die Parallelisierung des Trainings über mehrere GPUs hinweg kann simuliert werden. Nutzer können detaillierte Protokolldateien herunterladen, die die Ausgaben des Modells zeigen.

Tool soll Verständnis für Hardware-Anforderungen verbessern

Der Simulator ermöglicht auch komplexere Simulationen, beispielsweise für das Training in mehreren Rechenzentren. Durch die Angabe der Rechenzentrumsgröße, Latenz und Bandbreite der Verbindungen zwischen den Rechenzentren lässt sich simulieren, wie Trainingsläufe über mehrere Standorte verteilt werden könnten.

Epoch AI hofft, dass das Tool dazu beiträgt, die Bedeutung zukünftiger Fortschritte bei der Hardwareeffizienz und die Auswirkungen von Chip-Exportkontrollen besser zu verstehen. Es soll außerdem das öffentliche Verständnis dafür verbessern, welche Hardware für die großen Trainingsläufe benötigt wird, die in diesem Jahrzehnt zu erwarten sind.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.