In Facebooks Schattenkopie wüten fiese Bots

Facebook will sicherer werden und untersucht dafür in einer Schattenkopie des eigenen Netzwerks das Verhalten fieser Bots, die von Menschen lernen.

Ein komplexes Netzwerk wie Facebook hat viele Herausforderungen. Die größte Herausforderung sind die Nutzerinnen und Nutzer.

Jedes Update der Bedienoberfläche, der Empfehlungsalgorithmen oder neue Funktionen können unvorhergesehene Folgen haben, wenn sie auf Milliarden Menschen treffen. Es gibt außerdem zahlreiche Fälle von Belästigung, Hass und Betrug bei Facebook.

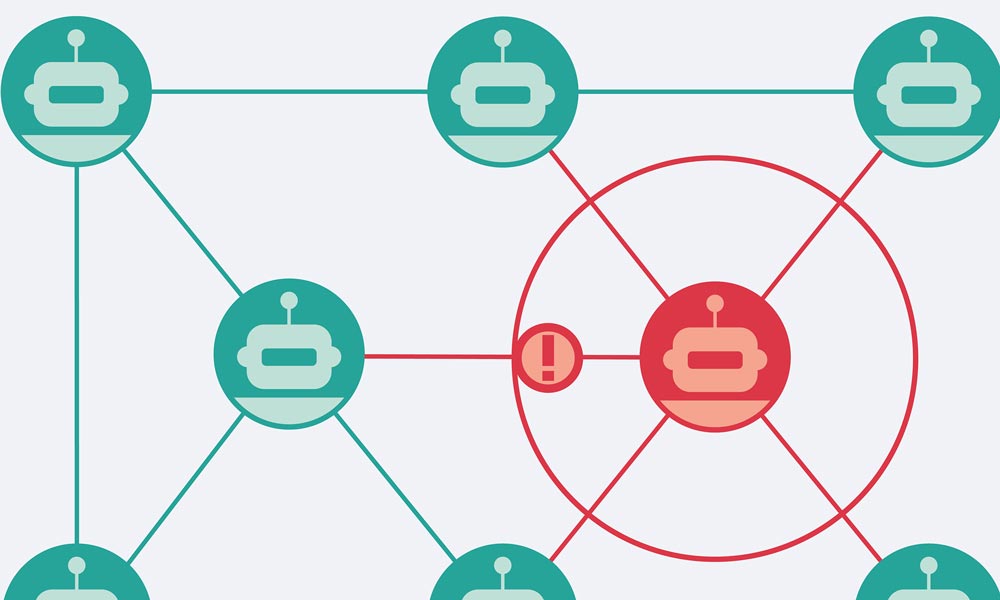

Um schädlichem Verhalten, das vorhandene Sicherheitsmechanismen aushebelt oder gegen Community-Richtlinien verstößt, zukünftig besser begegnen zu können, entwickelt Facebook jetzt die Schattenkopie "WW" des eigenen Netzwerks, in der Bots menschliches Verhalten imitieren. Der Name WW steht für eine "kleine Variante des World Wide Web", erklärt Facebook.

Menschen-Kopien in einer Facebook-Kopie

Durch maschinelles Lernen sollen die Bots bestimmte Verhaltensweisen menschlicher Facebook-Nutzer imitieren. Innerhalb des WW-Netzwerks können dann Millionen von Interaktionen simuliert werden. Die Testumgebung läuft mit dem echten Produkt-Code und tatsächlichen Facebook-Inhalten, ist aber getrennt vom echten Netzwerk.

Die Bots können in der Simulation alle üblichen Facebook-Aktionen ausführen, etwa Seiten besuchen, Nachrichten senden oder Suchen durchführen. Bestimmte Bots versuchen, Waffen oder Drogen zu verkaufen, andere verbreiten Spam und wieder andere wollen betrügen.

Facebook will mit der Bot-Simulation Sicherheitslücken und Datenschutzprobleme aufdecken. Konkrete Inhalte werden dabei nicht simuliert - schließlich ist niemand da, um sie zu lesen. Stattdessen simuliert Facebook das Verhalten.

Der verantwortliche Facebook-Ingenieur Mark Harman nennt als Beispiel einen Betrüger-Bot, der systematisch Kontakt zu den Freunden eines fiktiven Opfers aufnimmt.

Als mögliche Maßnahme gegen betrügende Roboter testet Facebook verschiedene Einschränkungen wie die Begrenzung der Anzahl privater Nachrichten und Beiträge, die pro Minute versendet werden können.

Die Bot-Simulation könnte Ende des Jahres erstmals Auswirkungen auf das echte Facebook haben

Noch hat die Arbeit der Forscher zu keinen Änderungen im echten Netzwerk geführt. Man wolle erst sichergehen, dass die Bot-Interaktionen die Vielfalt echter menschlicher Interaktion glaubhaft simulieren, sagt Harman. Er rechnet damit, dass es bis Ende des Jahres erste Änderungen am Facebook-Code geben könnte, die durch die Arbeit der Bot-Forscher motiviert ist.

Bis dahin liegt der Fokus auf möglichst realistischem Bot-Verhalten. In der Zukunft sei es möglich, die Bots auf unbekanntes Verhalten zu trainieren, das nicht von Menschen vorgelebt wurde.

„Das ist tatsächlich etwas, das wir uns wünschen, denn wir wollen letztlich negativem Verhalten vorgreifen, als ihm immer hinterherzulaufen“, so Harman.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.