Google stellt neue Gemini 2.0 KI-Modelle vor

Google erweitert seine KI-Modellfamilie um drei neue Gemini 2.0-Varianten. Die Modelle zielen auf unterschiedliche Anwendungsfälle ab und versprechen mehr Leistung bei geringeren Kosten.

Wie das Unternehmen mitteilt, ist das bereits im Dezember vorgestellte Basismodell Gemini 2.0 Flash ab sofort allgemein verfügbar und bietet höhere Rate-Limits sowie eine verbesserte Performance.

Überdies führt Google mit Gemini 2.0 Flash-Lite eine kostengünstige Variante für Entwickler ein, die sich derzeit in der öffentlichen Preview in der API befindet. Derzeit ist nur die Ausgabe von Text möglich, Bild- und Audioausgabe sowie Live-Video sollen in den nächsten Monaten für Flash und Pro folgen. Alle drei Modelle können Bild und Audio als Input verarbeiten.

Ergänzt wird das Angebot durch Gemini 2.0 Pro, eine laut Google noch experimentelle Version für komplexe Prompts und Coding-Aufgaben. Sie bietet ein erweitertes Kontextfenster von 2 Millionen Token - doppelt so viel wie die Flash-Varianten.

Darüber hinaus testet Google mit Gemini 2.0 Flash Thinking Modelle, die ähnlich wie OpenAI o3 und Deepseek-R1 als Reasoning-Modelle einen zusätzlichen Denkprozess vor der Antwortgenerierung durchlaufen. Flash Thinking kann zusätzlich YouTube, Maps und Google Search nutzen. Was noch fehlt und bisher nicht angekündigt wurde, ist das Flaggschiff-Modell "Gemini 2.0 Ultra".

Gemini Pro führt Benchmarks an

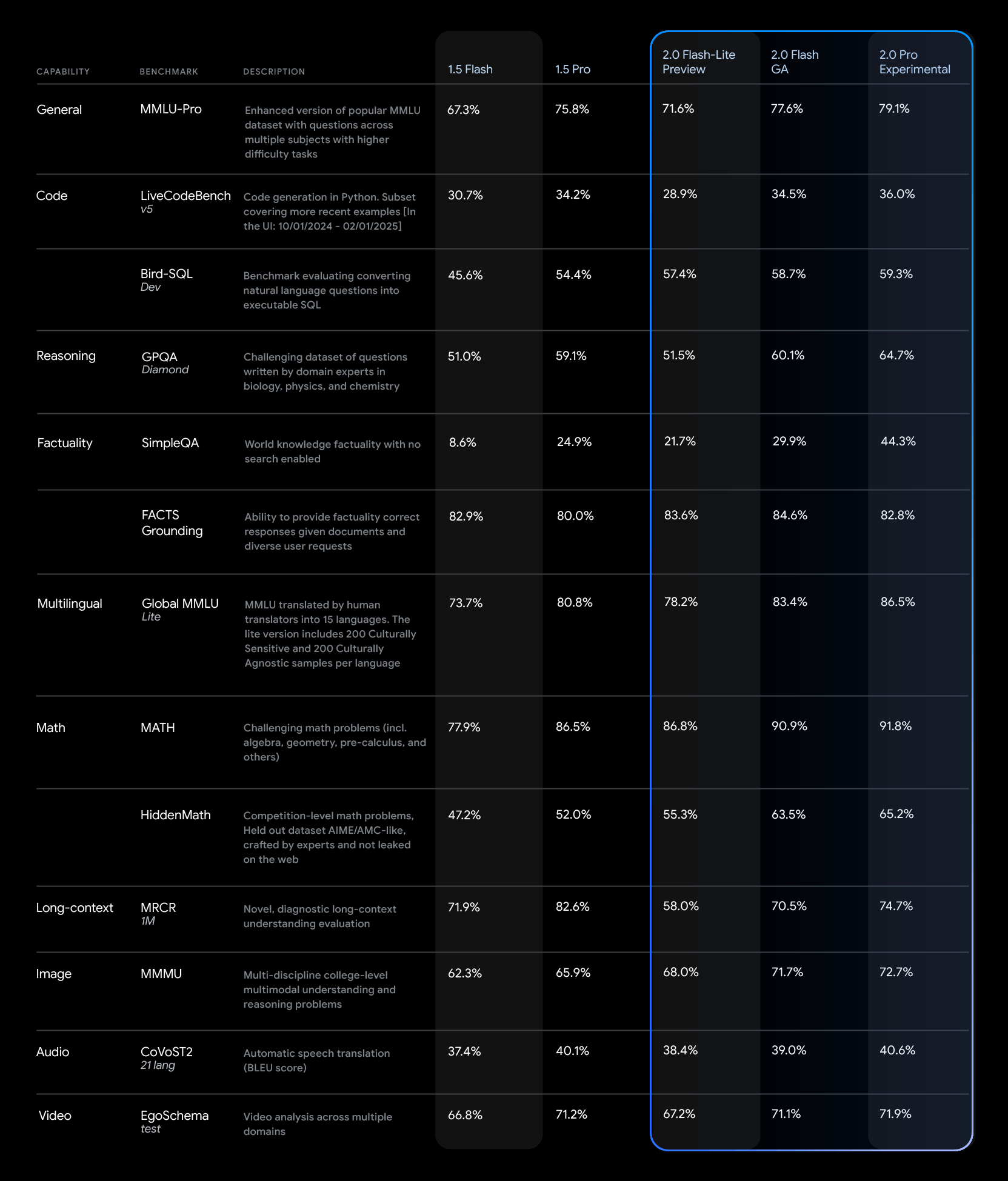

Wie die von Google veröffentlichten Benchmark-Daten zeigen, erzielt Gemini 2.0 Pro im internen Vergleich in fast allen Bereichen die besten Ergebnisse. Bei mathematischen Aufgaben erreicht es beispielsweise 91,8 Prozent im MATH-Benchmark und 65,2 Prozent bei HiddenMath, deutlich mehr als die Flash-Varianten. Das allgemein verfügbare Flash-Modell liegt leistungsmäßig zwischen Flash-Lite und Pro.

In OpenAIs SimpleQA-Test erreicht das Pro-Modell 44,3 Prozent, während Gemini 2.0 Flash nur auf 29,9 Prozent kommt. Deepseek-R1 (30,1 Prozent) und o3-mini-high (13,8 Prozent) liegen hier deutlich zurück, vermutlich, weil sie mit weniger Daten trainiert wurden. Der Test stellt besonders schwierige Sachfragen, die das Modell ohne Internetverbindung beantworten muss - in der Realität dürfte dies ein immer seltenerer Anwendungsfall sein.

Außerdem hebt Google beim API-Pricing die bisherige Unterscheidung zwischen kurzen und langen Kontextanfragen auf. Dadurch können die Kosten für gemischte Workloads (Text und Bild) trotz der Leistungsverbesserungen unter denen von Gemini 1.5 Flash liegen.

Allerdings ist das neue Flash 2.0-Modell über die API deutlich teurer als das alte Flash-Modell. Hier bietet Google mit Flash-Lite eine Alternative, die laut Benchmarks in vielen Aufgaben besser ist. Letztlich müssen Praxistests zeigen, ob die beiden Modelle tatäschlich qualitativ gleichwertig sind.

Alle Modelle sind über Google AI Studio und Vertex AI sowie über Googles Premium-Chatbot Gemini Advanvced auf Desktop- und Mobilgeräten verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.