Huginn: Neues KI-Modell "denkt" ohne Worte

Ein Forscherteam hat ein KI-Sprachmodell entwickelt, das durch eine rekursive Architektur seine Denkprozesse beliebig vertiefen kann.

Laut dem Forscherteam des ELLIS Institute Tübingen, der University of Maryland und des Lawrence Livermore National Laboratory kann das als "Huginn" bezeichnete Modell durch eine rekursive Struktur seine Berechnungstiefe während der Ausführung flexibel anpassen und so seine Leistung steigern.

Anders als gängige Reasoning-Modelle (LRMs) wie OpenAIs o3-mini, die Reasoning-Tokens - also Gedankenketten - generieren, benötigt Huginn kein spezielles Training und denkt im latenten Raum des neuronalen Netzes, bevor das erste Token ausgegeben wird.

Emergente Fähigkeiten im latenten Raum

Das Training erfolgte auf dem Frontier-Supercomputer mit 4.096 AMD MI250X GPUs - einer der größten Trainingsläufe auf einem AMD-Cluster. Das Trainingskonzept war neuartig, aber im Kern einfach: Anders als übliche Sprachmodelle wurde Huginn mit einer variablen Anzahl von Wiederholungen trainiert.

Bei jedem Durchgang wurde zufällig bestimmt, wie oft der zentrale Berechnungsblock wiederholt werden sollte - von einmal bis zu 64 Mal. Die spezielle Verteilung dieser Zufallszahl stellte sicher, dass das Modell überwiegend mit weniger Wiederholungen trainiert wurde, aber gelegentlich auch sehr viele Durchläufe machte.

Tests zeigen, dass das Modell bei mathematischen Aufgaben und Programmierung besonders gut abschneidet. Bei Benchmarks wie GSM8k und MATH übertrifft es einige getestete Open-Source-Modelle mit doppelt so vielen Parametern und mehr Trainingsdaten.

Die Forscher berichten auch von mehreren emergenten Fähigkeiten des Systems: Es kann ohne spezielles Training die Berechnungstiefe an die Komplexität der Aufgabe anpassen und Gedankenketten im latenten Raum entwickeln.

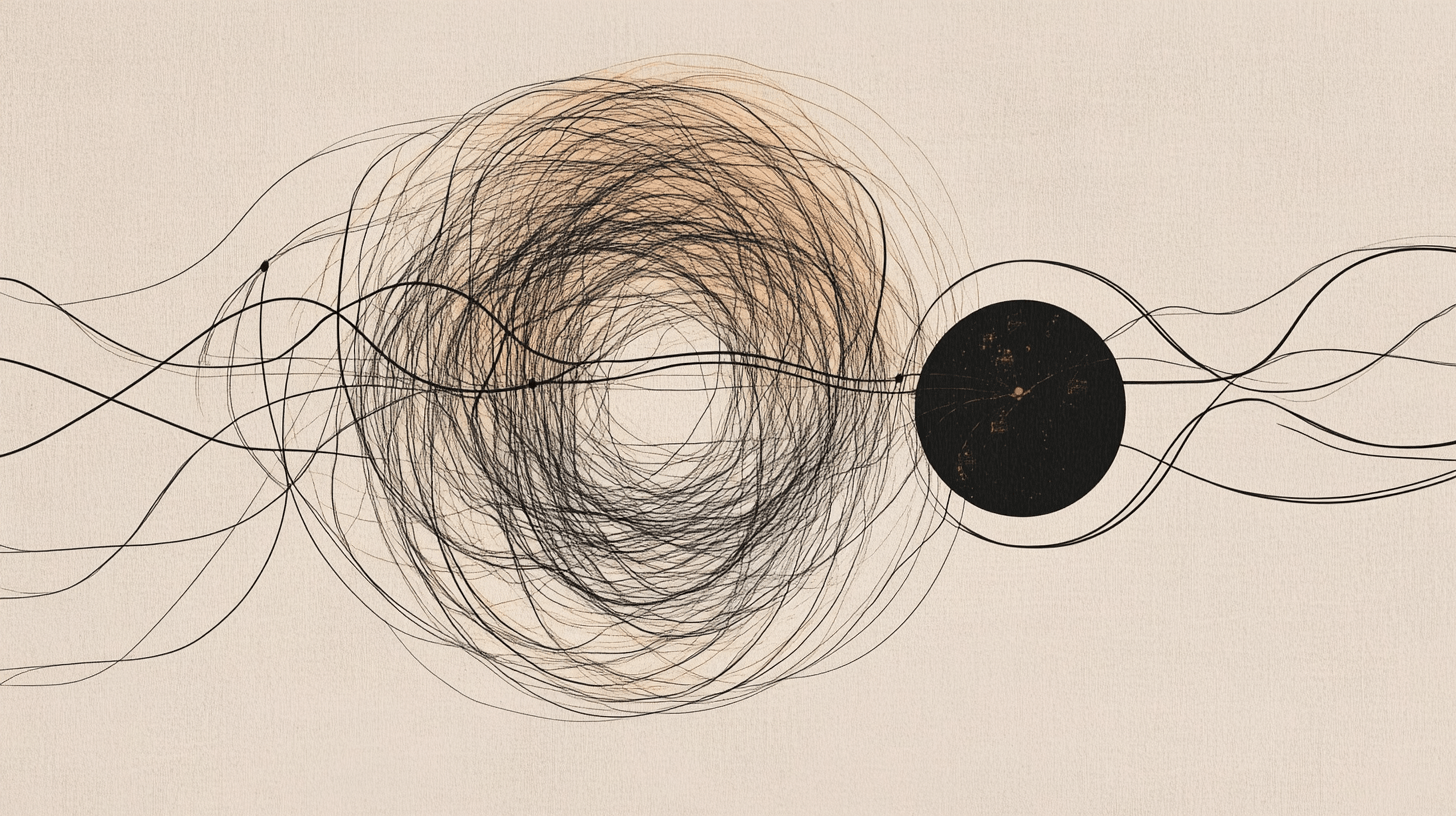

Analysen des Forscherteams zeigen auch, dass das Modell im latenten Raum komplexe Berechnungsmuster entwickelt, darunter kreisförmige Trajektorien bei mathematischen Aufgaben. Das Team sieht in den gefundenen Beispielen einen Hinweis, dass das Modell eigenständig lernt, "die hochdimensionale Natur seines latenten Raums zu nutzen, um auf neue Weise Schlussfolgerungen zu ziehen."

Vielversprechende Alternative zu klassischen Modellen

Auch wenn die absolute Leistung noch nicht bahnbrechend ist, sehen die Forscher großes Potenzial: Als Proof-of-Concept zeigt Huginn bereits beeindruckende Fähigkeiten bei geringer Größe und verhältnismäßig wenig Trainingsdaten. Die beobachtete Leistungssteigerung bei längerem Reasoning und die emergenten Fähigkeiten lassen vermuten, dass größere Modelle dieser Art eine vielversprechende Alternative zu klassischen Reasoning-Modellen sein könnten.

Das Team betont dabei besonders, dass ihre Methode Arten von Reasoning erfassen könnte, die sich nicht leicht in Worten (genauer Chain-of-Thoughts) ausdrücken lassen. Weitere Forschung - und damit weitere Leistungssprünge - sind zu erwarten. Als mögliche Erweiterung nennen die Forscher den Einsatz von Reinforcement Learning, wie es auch bei klassischen Reasoning-Modellen zum Einsatz kommt.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.