Microsoft stellt neue Phi-4-Modelle für multimodale KI-Anwendungen vor

Microsoft erweitert seine Phi-Familie um zwei neue KI-Modelle: Phi-4-multimodal verarbeitet Sprache, Bilder und Text gleichzeitig, während Phi-4-mini als kompaktes Textmodell überzeugen soll.

Die Besonderheit von Phi-4-multimodal liegt laut Microsoft in seinem "mixture-of-LoRAs"-Ansatz, der die gleichzeitige Verarbeitung von Text-, Audio- und visuellen Eingaben im selben Repräsentationsraum ermöglicht. Dadurch würden komplexe Pipelines oder separate Modelle für verschiedene Modalitäten überflüssig.

Microsoft gibt an, dass es bei der automatischen Spracherkennung (ASR) mit einer Wortfehlerrate von 6,14 Prozent an der Spitze des Huggingface OpenASR-Leaderboards steht und damit spezialisierte Modelle wie WhisperV3 und SeamlessM4T-v2-Large übertrifft. Auch bei der Sprachübersetzung und der Sprachzusammenfassung soll das Modell Spitzenleistungen erbringen.

Trotz seiner geringen Größe zeigt das Modell laut Microsoft zudem bei Vision-Aufgaben starke Leistungen, insbesondere beim mathematischen und wissenschaftlichen Schlussfolgern. Bei Dokumenten- und Diagrammverständnis, optischer Zeichenerkennung und visuellem wissenschaftlichem Schlussfolgern soll es mit größeren Modellen wie Gemini-2-Flash-lite-preview und Claude-3.5-Sonnet mithalten können.

Phi-4-mini: Effizientes Mini-LLM für Textaufgaben

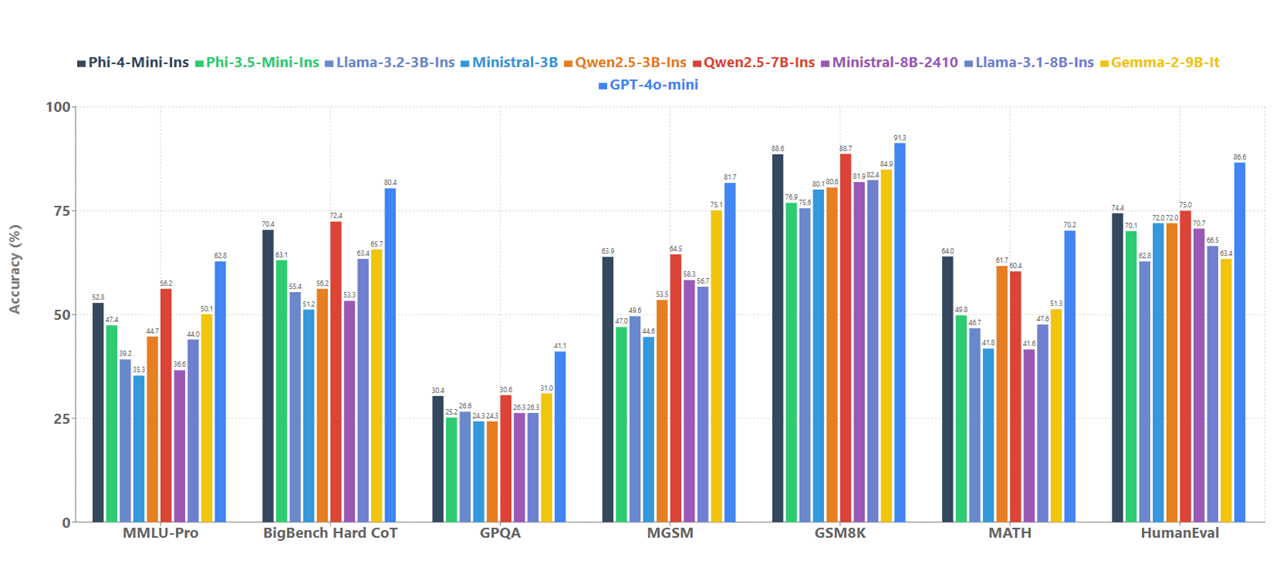

Das zweite vorgestellte Modell, Phi-4-mini, hat 3,8 Milliarden Parameter und ist als dichter Decoder-only-Transformer konzipiert mit einem 128K-Kontextfenster. Es ist laut Microsoft für Geschwindigkeit und Effizienz optimiert.

Eine besondere Stärke von Phi-4-mini ist laut Microsoft das sogenante Function Calling, also die automatische Verwendung externer Werkzeuge. Durch ein standardisiertes Protokoll kann das Modell Anfragen analysieren, relevante Funktionen mit passenden Parametern aufrufen, die Ergebnisse empfangen und in seine Antworten integrieren. Laut Microsoft eignet sich Phi-4 daher für agentenbasierten Systems, bei dem das Modell mit externen Tools, APIs und Datenquellen verbunden werden kann.

Microsoft sieht vielfältige Einsatzmöglichkeiten für die neuen Modelle. Phi-4-multimodal könnte in Smartphones integriert werden, um Sprachbefehle zu verarbeiten und Bilder zu analysieren. Im Automobilbereich könnte es Fahrerassistenzsysteme verbessern.

Phi-4-mini eignet sich laut Microsoft besonders für Finanzdienstleistungen, wo es bei komplexen Berechnungen, der Generierung von Berichten und der Übersetzung von Finanzdokumenten unterstützen kann.

Beide Modelle wurden vom Microsoft AI Red Team auf Sicherheit getestet und sind über Azure AI Foundry, Hugging Face und den NVIDIA API Catalog verfügbar.

Ebenfalls zur Phi-Familie gehört das Textmodell Phi-4-14B, das Microsoft bereits im Dezember vorstellte und im Januar mit Gewichten veröffentlichte.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.