Microsoft stellt neue offene Phi-4-Modelle mit Reasoning vor

Microsoft erweitert die Phi-Modellreihe um drei spezialisierte Reasoning-Modelle. Trotz geringer Größe übertreffen sie in Benchmarks deutlich größere Konkurrenten.

Microsoft hat mit Phi-4-reasoning, Phi-4-reasoning-plus und Phi-4-mini-reasoning drei neue Sprachmodelle veröffentlicht, die mittels Gedankenketten (Chain of Thought) in der Lage sein sollen, durch mehrstufige Denkprozesse und interne Reflexion komplexe Probleme zu zerlegen und zu lösen.

Die Modelle gehören zu Microsofts Small-Language-Modell-Familie Phi und sind so konzipiert, dass sie insbesondere auf Hardware mit geringerer Leistung, etwa mobilen Geräten, Reasoning-Fähigkeiten ermöglichen sollen.

Kleine Modelle mit großer Leistung

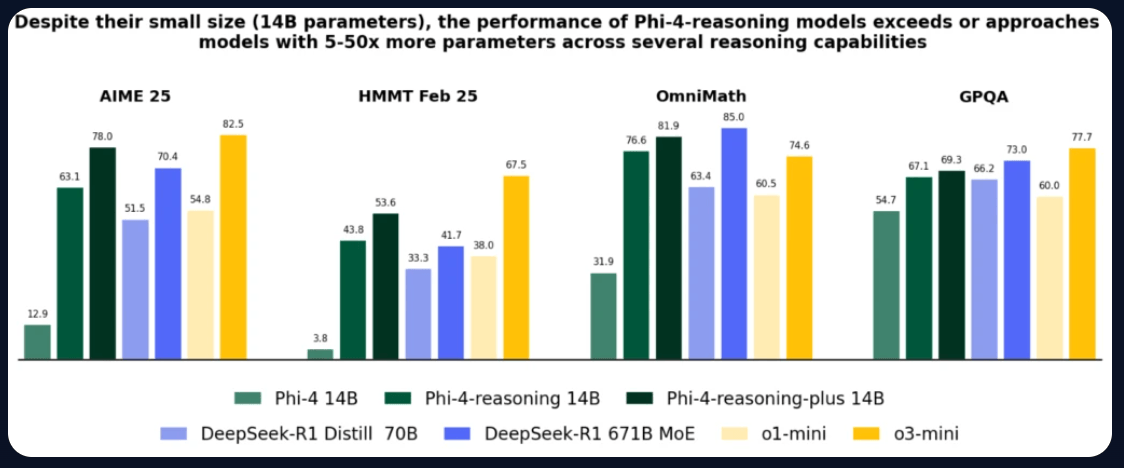

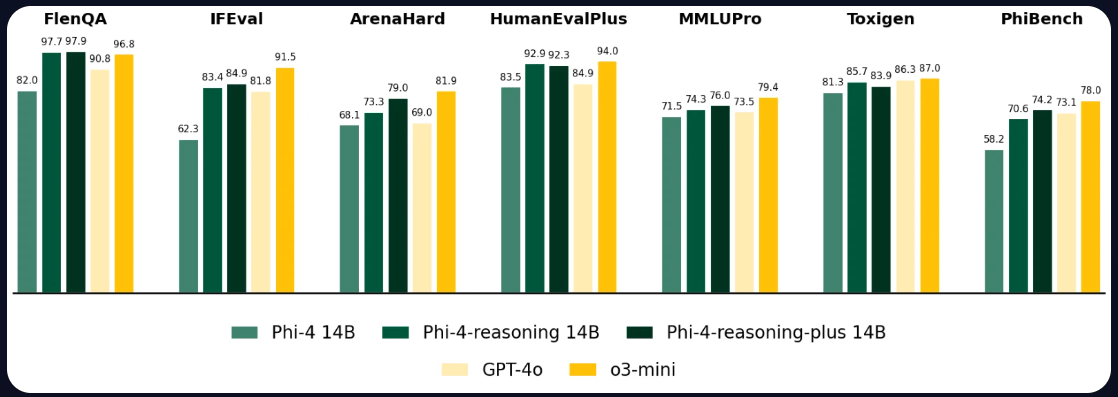

Das Modell Phi-4-reasoning hat 14 Milliarden Parameter und wurde mithilfe von Supervised Fine-Tuning auf ausgewählten Reasoning-Pfaden von OpenAIs o3-mini trainiert. Phi-4-reasoning-plus geht einen Schritt weiter: Es nutzt zusätzlich Reinforcement Learning, verarbeitet 1,5-mal mehr Tokens als das Basis-Modell und erzielt dadurch höhere Genauigkeit. Dafür dauert die Generierung der Antworten länger und die Kosten steigen.

Beide Modelle übertreffen laut Microsoft deutlich größere Sprachmodelle wie OpenAI o1-mini und DeepSeek-R1-Distill-Llama-70B – letzteres ist fünfmal größer. Selbst im Vergleich zum 671-Milliarden-Parameter-Modell DeepSeek-R1 schneiden die Phi-Modelle auf dem AIME-2025-Test, einer Qualifikation zur US-Mathematik-Olympiade, besser ab.

Die Leistungssteigerungen beschränken sich dabei nicht nur auf mathematische oder wissenschaftliche Aufgaben auf PhD-Niveau, sondern zeigen sich laut Microsoft auch in Bereichen wie Coding, algorithmischer Problemlösung und Planungsaufgaben. Die Verbesserungen im logischen Denken würden auch auf allgemeinere Fähigkeiten wie das Befolgen von Prompts oder die Beantwortung von Fragen in langen Texten positiv abstrahlen.

Phi-4-mini-reasoning für mobile Anwendungen

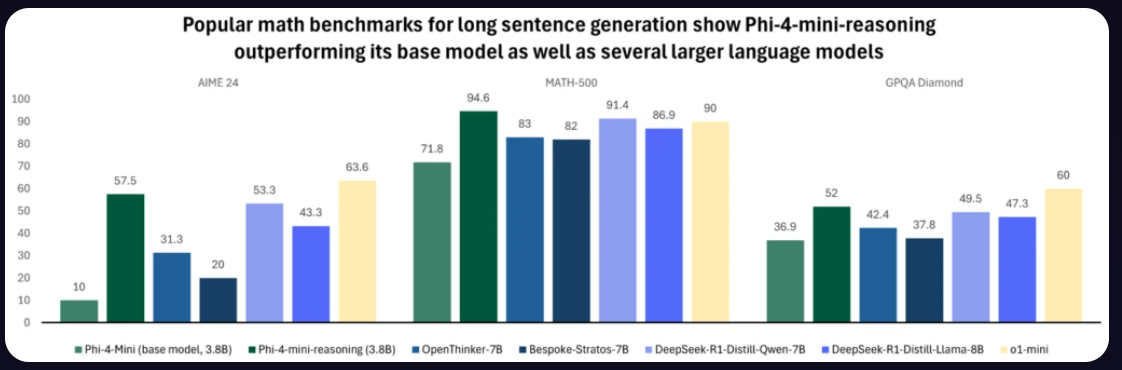

Mit Phi-4-mini-reasoning stellt Microsoft ein besonders kompaktes Modell vor, das für den Einsatz auf Mobilgeräten, in der Bildung oder eingebetteten Tutorensystemen gedacht ist. Das Modell basiert auf einer Architektur mit 3,8 Milliarden Parametern und wurde mit über einer Million mathematischer Aufgaben trainiert – von Mittelschulniveau bis zu Promotionsaufgaben.

Trotz seiner geringen Größe übertrifft Phi-4-mini-reasoning bei mehreren Benchmarks größere Modelle wie OpenThinker-7B oder DeepSeek-R1-Distill-Qwen-7B. Im Bereich der mathematischen Problemlösung erreicht es vergleichbare oder bessere Ergebnisse als OpenAIs o1-mini.

Integration in Windows-Systeme

Die Modelle sind laut Microsoft bereits für den Einsatz ins Windows-Ökosystem optimiert. Eine Variante namens Phi Silica wird in Copilot+ PCs eingesetzt. Sie läuft lokal auf NPUs und bietet schnellere Reaktionszeiten sowie geringeren Energieverbrauch. Nutzer finden sie unter anderem in Anwendungen wie Outlook (für Offline-Zusammenfassungen) oder in der Funktion „Click to Do“, die kontextbezogene Textfunktionen auf dem Bildschirm anbietet.

Alle drei Modelle – Phi-4-reasoning, Phi-4-reasoning-plus und Phi-4-mini-reasoning – sind mit offenen Gewichten auf Azure AI Foundry und Hugging Face verfügbar.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.