EmoNet: Open-Source-KI soll menschliche Emotionen verstehen

Das Forschungskollektiv LAION hat zusammen mit Intel eine umfassende Suite von Modellen und Datensätzen veröffentlicht, die KI-Systemen emotionale Intelligenz verleihen sollen.

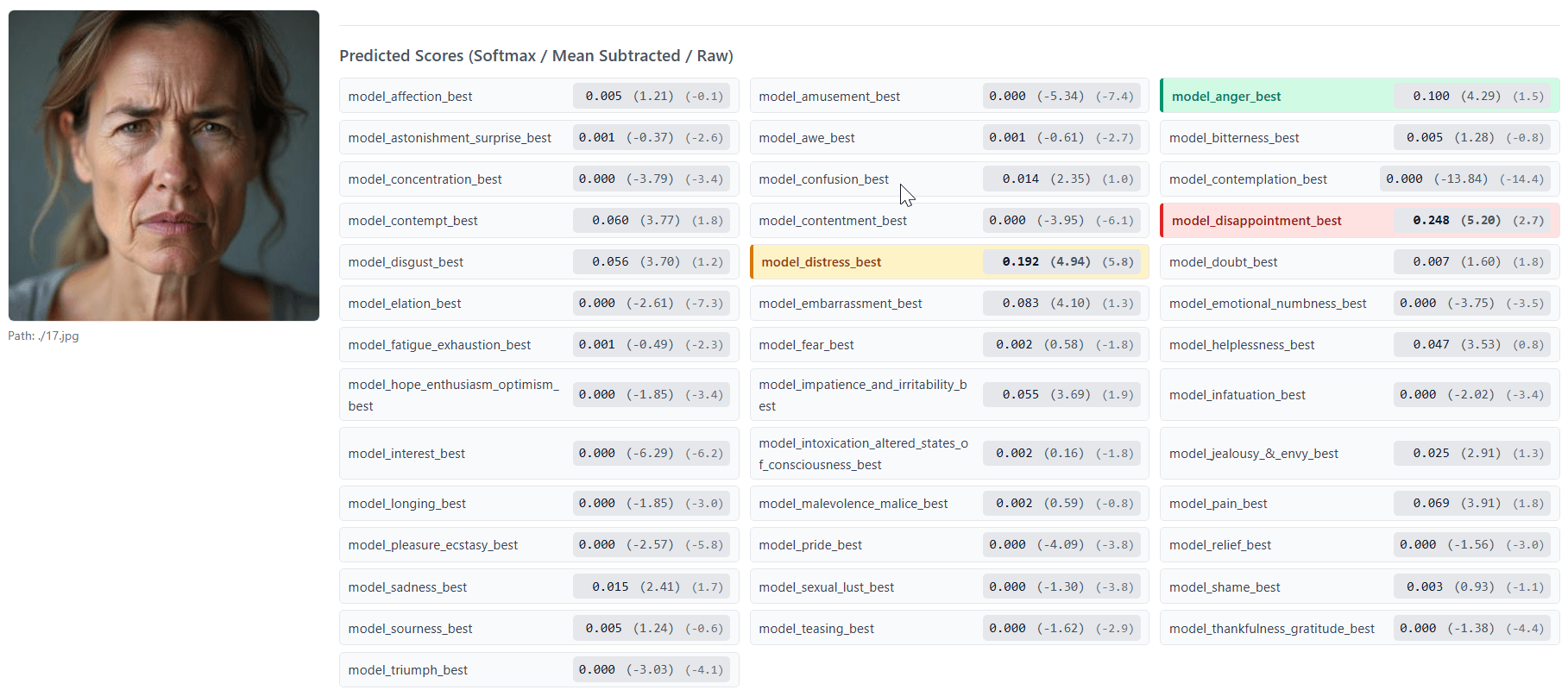

Die Empathic-Insight-Modelle analysieren Gesichtsbilder oder Audiodateien und geben für jede der 40 Emotionskategorien eine Intensitätsbewertung aus. Bei Gesichtern erfolgt die Bewertung auf einer Skala von 0 bis 7, bei Stimmen in drei Stufen: nicht vorhanden, leicht ausgeprägt oder stark ausgeprägt.

EmoNet basiert auf einer Taxonomie aus 40 Emotions-Kategorien, die aus dem "Handbook of Emotions" entwickelt wurde. Dieses Standardwerk der Psychologie gilt als umfassende wissenschaftliche Sammlung zur Emotionsforschung. Die Forschenden analysierten das Handbuch systematisch und erweiterten die üblichen Grundemotionen um kognitive Zustände wie Konzentration und Verwirrung, physische Zustände wie Schmerz und Müdigkeit sowie soziale Emotionen wie Scham und Stolz.

Die Wissenschaftler:innen begründen diesen Ansatz damit, dass Emotionen nicht universell erkennbar sind, sondern vom Gehirn aus verschiedenen Signalen konstruiert werden. Daher setzen ihre Modelle auf Wahrscheinlichkeits-Schätzungen statt eindeutige Zuordnungen.

Nur synthetische Gesichtsbilder

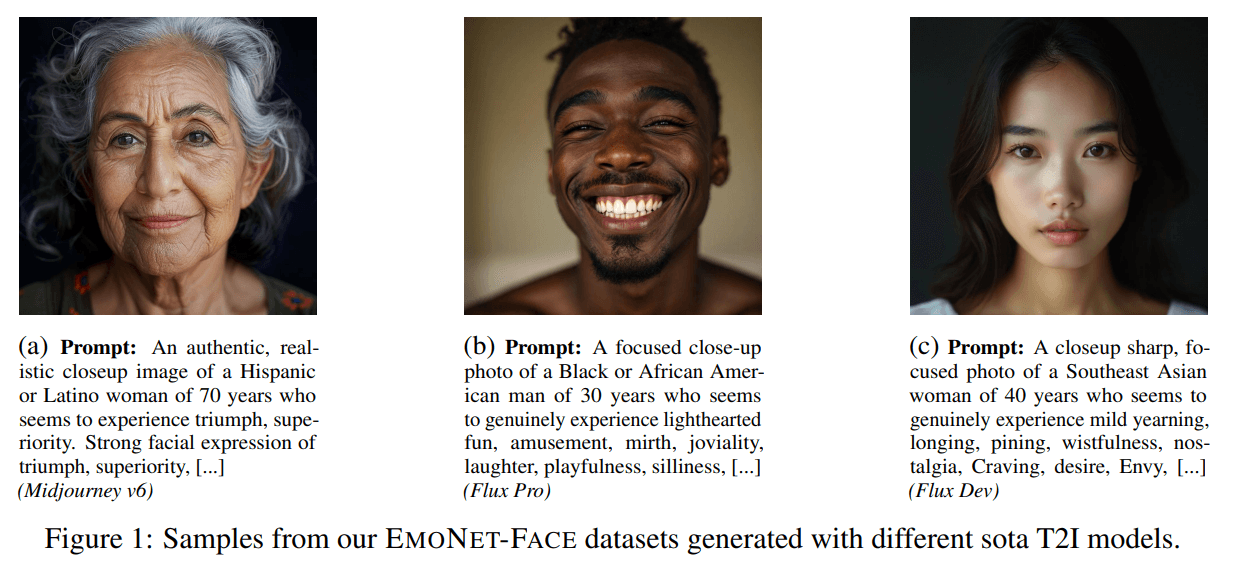

Für das Training verwendeten die Forschenden über 203.000 Gesichtsbilder und 4.692 Audio-Samples. Die Sprachdaten stammen aus dem Laion's Got Talent Dataset mit über 5.000 Stunden synthetischer Aufnahmen in vier Sprachen: Englisch, Deutsch, Spanisch und Französisch. Die Daten wurden mit OpenAIs GPT-4o-Audio-Modell generiert.

LAION verwendet ausschließlich synthetische Daten, um Privatsphäre-Probleme zu vermeiden und demografische Vielfalt zu gewährleisten. Die synthetischen Gesichtsbilder wurden mit verschiedenen Text-zu-Bild-Modellen wie Midjourney oder Flux erstellt und programmatisch auf Alter, Geschlecht und Ethnizität diversifiziert. Alle Audio-Samples wurden von Expert:innen mit Psychologie-Ausbildung validiert, wobei nur Bewertungen aufgenommen wurden, bei denen drei unabhängige Fachleute zur gleichen Einschätzung kamen.

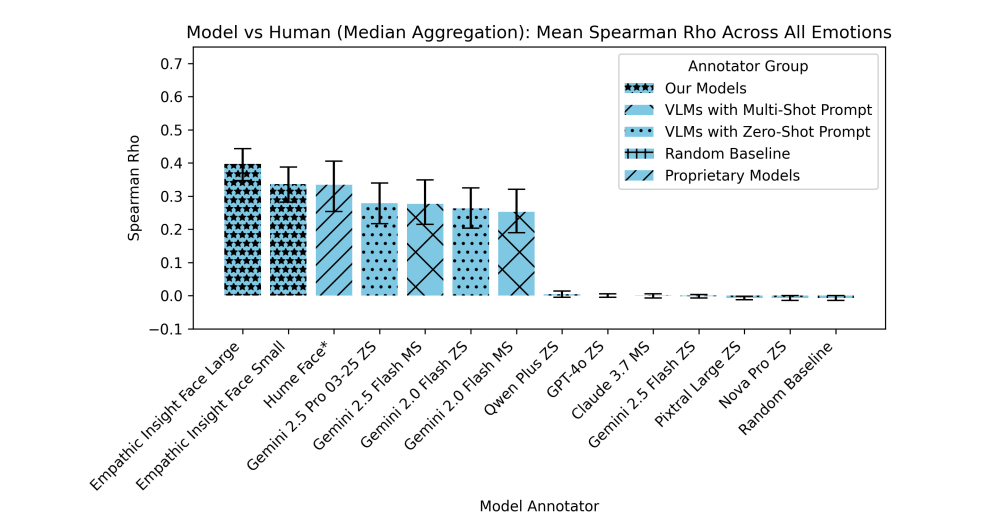

Höhere Übereinstimmung mit menschlichen Bewertungen als Konkurrenz

In Benchmarks sollen die Empathic-Insight-Modelle etablierte Konkurrenz übertreffen. Das Empathic-Insight-Face Modell erreiche laut LAION auf dem EmoNet-Face HQ Benchmark eine bessere Übereinstimmung mit menschlichen Bewertungen als Gemini 2.5 Pro und proprietäre APIs wie Hume AI. Die Forschenden maßen dabei, wie gut die KI-Bewertungen mit den Einschätzungen von Psychologie-Expert:innen korrelieren.

Auch bei der Sprach-Emotionserkennung zeigen die LAION-Modelle laut den Forschenden überlegene Leistung. Das Empathic-Insight-Voice-Modell soll auf dem EmoNet-Voice Benchmark bestehende Audio-Sprachmodelle bei der Erkennung aller 40 Emotionskategorien übertreffen. Die Wissenschaftler:innen verglichen dabei verschiedene Modellgrößen und Ansätze für die Verarbeitung von Audiodaten.

Whisper-Weiterentwicklung transkribiert Stimme und Emotionen

Zusätzlich zu den Empathic-Insight-Modellen haben die Forschenden BUD-E Whisper entwickelt, eine Weiterentwicklung von OpenAIs Whisper-Modell. Während das ursprüngliche Whisper nur gesprochene Sprache in Text umwandelt, erstellt BUD-E Whisper strukturierte Beschreibungen des emotionalen Tons, erkennt stimmliche Ausbrüche wie Lachen oder Seufzen und schätzt Sprecher-Eigenschaften wie Alter und Geschlecht ein.

Intel unterstützt das Projekt im Rahmen seiner Open-Source-Strategie für KI-Innovation. Die Partnerschaft zwischen LAION und Intel besteht seit 2021 zur Optimierung von KI-Modellen auf Intel-Hardware.

Alle EmoNet-Komponenten sind unter Creative Commons für die Modelle und Apache 2.0 für den Code verfügbar. Die Datensätze und Modelle können über Hugging Face heruntergeladen werden. Beide Empathic-Insight-Modelle sind auf Hugging Face als "Small" und "Large" Varianten verfügbar, um verschiedene Anwendungsfälle und Rechenkapazitäten zu unterstützen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.