Elevenlabs startet 11ai: Sprachassistent führt Aktionen in Arbeitstools aus

Mit 11ai erweitert Elevenlabs sein Portfolio um einen sprachgesteuerten KI-Assistenten, der direkt in digitale Arbeitsprozesse eingreift. Die Alpha-Version soll zeigen, was mit Voice-First-Technologie und API-Integrationen möglich wird.

Laut Elevenlabs liegt die Schwäche herkömmlicher Sprachassistenten darin, dass sie kaum über die reine Konversation hinauskommen und selten produktiv tätig werden. 11ai soll genau an diesem Punkt ansetzen: Die Nutzer:innen geben mündliche Anweisungen und das System führt Aktionen durch.

Video: Elevenlabs

Voice-First-Produktivität mit direkten Tool-Integrationen

Nutzer:innen können über die Weboberfläche unter 11.ai/app/eleven Anweisungen wie "Plane meinen Tag und füge meine wichtigsten Aufgaben zu Linear hinzu" oder "Nutze Perplexity, um unser heutiges Interessenten-Meeting zu recherchieren und deren kürzliche Finanzierung zusammenzufassen" geben.

In einem Werbevideo zeigt Elevenlabs eine Morgenroutine, in der 11ai in jedem Raum der Wohnung verfügbar ist – welche Hardware die Antworten gibt, lässt das Unternehmen aber offen.

Das System führt auch sequenzielle Aktionen aus und versteht Kontext zwischen verschiedenen Tools. Bei einer Kundenrecherche durchsucht 11ai verbundene Systeme, findet relevante Daten und verarbeitet diese Informationen durch CRM-Updates oder Team-Nachrichten weiter.

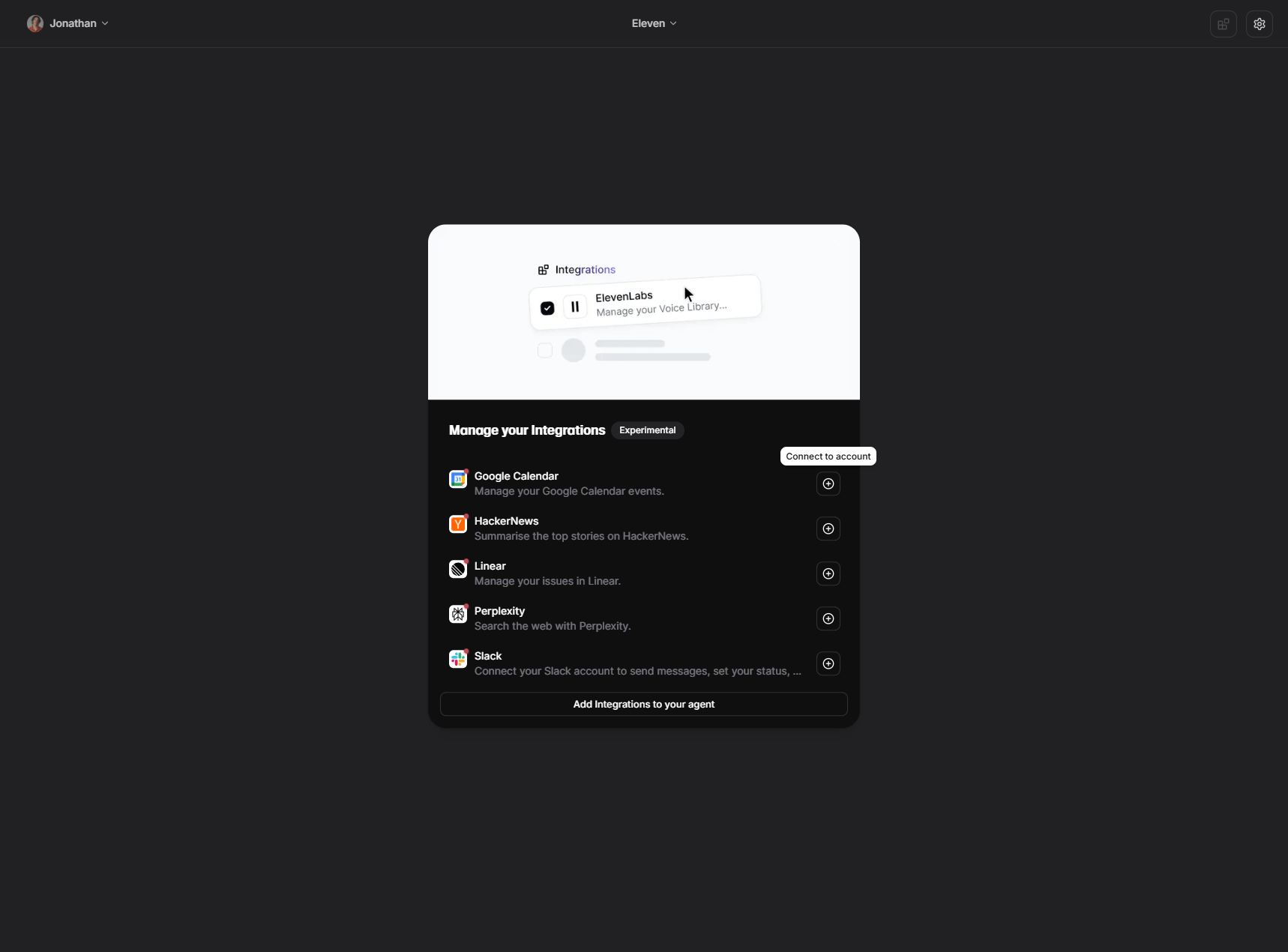

Vorgefertigte Integrationen und Custom-Server

Die Funktionalität basiert auf dem Model Context Protocol (MCP), das eine standardisierte API-Integration für AI-Assistenten ermöglicht. Die Conversational AI-Plattform von Elevenlabs unterstützt MCP nativ und verbindet sich dadurch mit Services wie Salesforce, HubSpot, Gmail und Zapier.

Elevenlabs bietet zum Start vorgefertigte Integrationen für Perplexity, Linear, Slack und HackerNews und Google Kalender. Weitere Integrationen sollen wöchentlich hinzukommen.

Die zugrundeliegende Elevenlabs-Conversational-AI-Plattform bietet nach Unternehmensangaben niedrige Latenz für Echtzeit-Konversationen und multimodalen Support für Voice- und Text-Interaktion.

Außerdem integriert die Plattform RAG-Funktionalität für den Zugriff auf externe Wissensdatenbanken und erkennt Sprachen automatisch für mehrsprachige Konversationen. Nutzer:innen können aus über 5.000 Stimmen wählen oder eigene Voice Clones erstellen, um die Interaktion zu personalisieren.

Zusätzlich unterstützt 11ai benutzerdefinierte MCP-Server. Teams verbinden ihre internen Tools oder spezialisierte Software über eigene MCP-Server mit 11ai und erweitern so die Funktionalität in ihre spezifischen Arbeitsabläufe.

Das System arbeitet laut Elevenlabs mit einem Berechtigungsmodell, bei dem Nutzer für jede Anwendung einzeln festlegen, welche Funktionen der Sprachassistent ausführen darf.

11ai läuft als experimenteller Proof-of-Concept zunächst kostenlos in der Alpha-Phase. In dieser sammelt Elevenlabs Feedback zu Integrationen, gewünschten MCP-Servern, der Voice-Interaktion im Vergleich zu traditionellen Interfaces und neuen Funktionalitäten für tägliche Routinen.

Agentische Assistenten sind kein Alleinstellungsmerkmal mehr

Mit dem Vorstoß in den Markt für handlungsfähige Sprachassistenten steht Elevenlabs in direkter Konkurrenz zu einer wachsenden Zahl ähnlicher Produkte. Perplexity hat kürzlich einen mobilen Assistant vorgestellt, der Aufgaben wie Tischreservierungen übernimmt. Amazon präsentierte mit Alexa+ ein weiterentwickeltes, agentisches Alexa, das auf Voice-First-Interaktionen setzt.

Auch Claude von Anthropic ist über das MCP-Protokoll anwendungsfähig, der Chatbot hat jedoch einen stärkeren B2B-Fokus. Erst vor kurzem erhielt Claude überhaupt einen Sprachmodus, der ebenfalls auf ElevenLabs setzt. Googles Gemini bietet zwar Sprachinteraktion, ist jedoch in puncto Handlungsfähigkeit und Toolintegration noch eingeschränkt – selbst innerhalb des eigenen Ökosystems.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.