Kimi K2: Das nächste Open-Model-Wunder nach Deepseek kommt wieder aus China

Update –

- Details zu Kimi-K2s agentischem Training und dem MuonClip-Optimizer hinzugefügt

Das chinesische KI-Unternehmen Moonshot AI hat mit Kimi-K2 ein neues LLM veröffentlicht, das selbst ohne Reasoning-Modul an führende Modelle anderer Hersteller heranreichen soll.

Das 2023 gegründete KI-Start-up Moonshot AI aus China hat mit Kimi-K2 ein Large Language Model mit offenen Gewichten vorgestellt. Das Mixture-of-Experts-Modell umfasst insgesamt eine Billion Parameter, von denen pro Inferenz 32 Milliarden aktiviert werden.

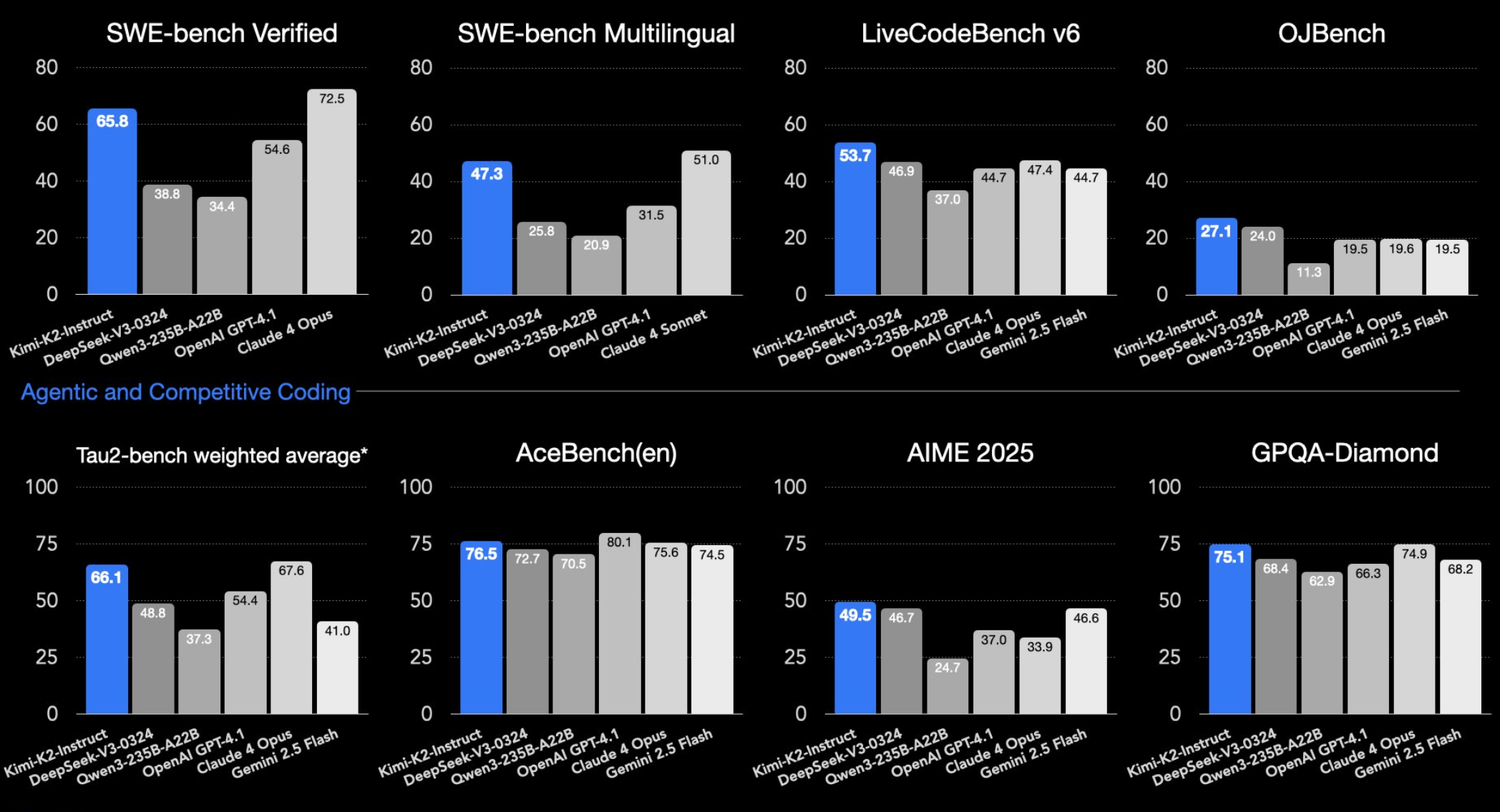

In gängigen LLM-Benchmarks erreicht Kimi-K2-Instruct, die für den Praxiseinsatz optimierte Version des Modells, Ergebnisse auf Augenhöhe mit führenden proprietären Modellen wie Claude Sonnet 4 oder GPT-4.1.

Bei SWE-bench Verified erzielt das Modell 65,8 Prozent Genauigkeit im agentischen Modus – ein Wert, der nur knapp hinter Claude Sonnet 4 und sogar deutlich vor GPT-4.1 (54,6 %) liegt. Der Test bewertet, ob ein Modell echte Codefehler in Open-Source-Projekten erkennt und mit einem funktionierenden Patch behebt.

Bei LiveCodeBench (53,7 Prozent) und OJBench (27,1 Prozent) liegt Kimi-K2 sogar vor allen Konkurrenten ohne Reasoning. Diese Benchmarks messen die Fähigkeit von Sprachmodellen, Programmieraufgaben direkt zu lösen – entweder interaktiv (LiveCodeBench) oder als klassische Wettbewerbsprobleme (OJBench).

Besonders stark schneidet das Modell bei Aufgaben in Mathematik und Naturwissenschaften ab. In Benchmarks wie AIME, GPQA-Diamond oder MATH-500 erreicht es bessere Werte als der gesamte Wettbewerb. Auch bei multilingualen Benchmarks wie MMLU-Pro liegt Kimi-K2 in der Spitzengruppe. Moonlight AI demonstriert die Coding-Fähigkeiten bei X.

2. A ball bouncing in hexagon pic.twitter.com/DhicknAtd7

— Kimi.ai (@Kimi_Moonshot) July 11, 2025

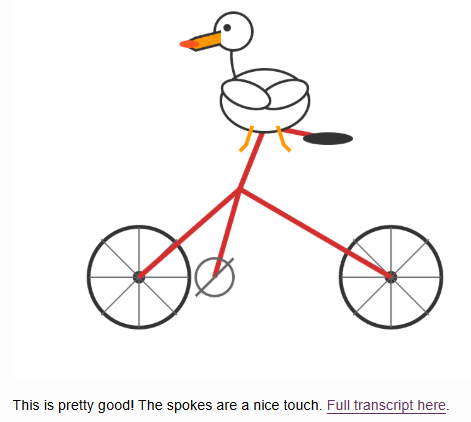

In einem inoffiziellen Test von Simon Willison, in dem das Modell ein SVG eines Pelikans auf einem Fahrrad generieren soll, lieferte Kimi-K2 ein überzeugendes Ergebnis. Viele Modelle scheitern an dieser Aufgabe und bringen nur abstrakte Zeichnungen hervor.

Optimiert für agentische Prozesse

Kimi-K2 wurde laut Moonshot AI speziell für agentische Anwendungen optimiert. Es kann Befehle ausführen, Tools aufrufen, Code generieren und debuggen sowie mehrstufige Aufgaben eigenständig organisieren.

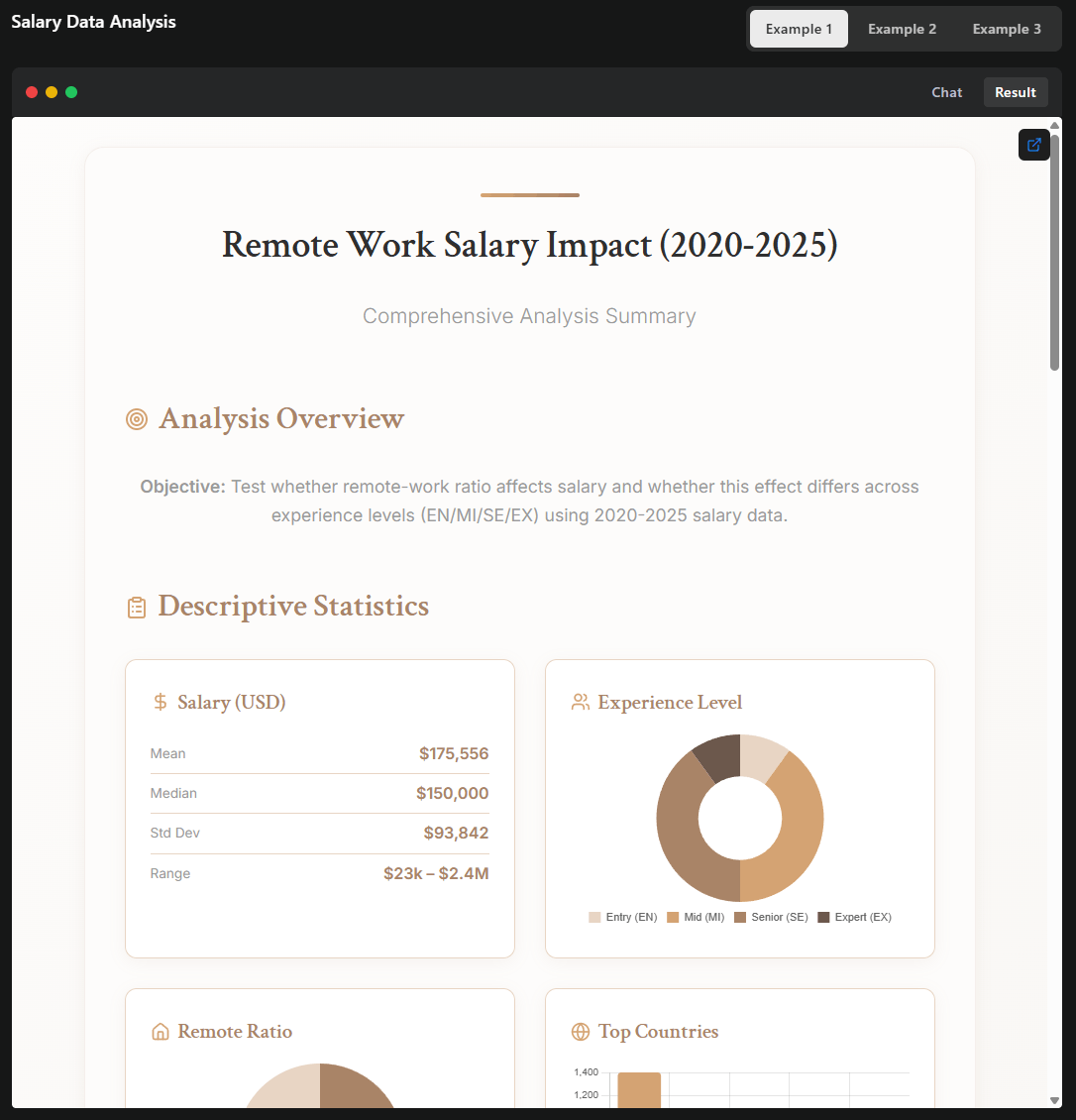

In einem Beispiel analysierte das Modell Gehaltsdaten im Zusammenhang mit Remote-Arbeit, führte eine statistische Auswertung durch und generierte eine interaktive HTML-Seite mit personalisierbarem Empfehlungstool – alles im Rahmen eines einzigen agentischen Ablaufs.

Bezüglich der agentischen Fähigkeiten ist bemerkenswert, dass Kimi-K2 – anders als Reasoning-Modelle – gezielt auf agentische Umgebungen und Tool-Nutzung per Reinforcement Learning trainiert wurde, ohne wahrscheinlich zuvor ein explizites Training für mathematische Aufgaben oder Coding mit einer umfangreichen Chain-of-Thought durchzuführen. Das deutet darauf hin, dass für praxisnahe Agenten-Anwendungen der Fokus auf Tool-Nutzung und Workflow-Orchestrierung wichtiger ist als das "Reasoning" an sich.

Laut Moonshot AI bestehen derzeit noch Einschränkungen: Bei Aufgaben mit hoher Komplexität oder unklarer Tooldefinition kann es zu überlangen Ausgaben und abgeschnittenen Ergebnissen kommen. Auch sei die Leistung bei sogenannten One-Shot-Prompts – also einmaligen Eingaben ohne Kontext – geringer als bei durchgängig agentischer Nutzung.

Kimi-K2 wurde mit 15,5 Billionen Tokens trainiert und verwendet einen neuen Trainingsalgorithmus namens MuonClip. Um Instabilitäten im Training zu vermeiden, setzt MuonClip eine Technik ein, die zentrale Komponenten der Aufmerksamkeit regelmäßig skaliert.

Nach Angaben von Moonshot AI verlief das Training dadurch stabil und ohne Zwischenfälle; das ist beim Training so großer Modelle keine Selbstverständlichkeit. Der MuonClip-Optimizer, der den weit verbreiteten AdamW-Optimizer ersetzt, gilt als wesentlicher Stützpfeiler der Performance des Modells. Laut des Teams performt er den bisherigen Industriestandard signifikant aus.

Die Optimierer berechnen nach jedem Trainingsschritt, wie die Modellparameter angepasst werden sollen, um Fehler zu minimieren. Das ist besonders wichtig beim Training sehr großer Modelle wie Kimi-K2, da hier Instabilitäten oder Überanpassungen ("Overfitting") schwerwiegende Folgen für die Leistungsfähigkeit des Modells haben können.

Moonshot AI stellte zuvor im Januar 2025 ein Reasoning-Modell vor, das es mit OpenAIs o1 aufnahmen kann, sowie im April ein leistungsfähiges Vision-Modell.

Flexible Nutzung und technische Einschränkungen

Kimi-K2 steht in zwei Varianten zur Verfügung: als Kimi-K2-Base, dem Basismodell für Forschung und individuelles Feintuning, sowie als Kimi-K2-Instruct, einer post-trainierten Version für allgemeine Chat- und Agentenanwendungen. Für eigene Anwendungen kann Kimi-K2 auch über eine OpenAI-kompatible API genutzt werden, die über die Plattform von Moonshot AI zugänglich ist.

Die Preisstruktur ist gestaffelt: 0,15 US-Dollar pro Million Eingabetokens bei Cache-Treffern, 0,60 US-Dollar bei Cache-Fehlschlägen und 2,50 US-Dollar pro Million Ausgabetokens.

Darüber hinaus lässt sich Kimi-K2 auch lokal betreiben, etwa mit Inferenz-Engines wie vLLM, SGLang, KTransformers oder TensorRT-LLM. Entsprechende Anleitungen finden sich im offiziellen GitHub-Repository von Moonshot AI.

Die Lizenz basiert auf der MIT-Lizenz, enthält jedoch eine Einschränkung: Wer das Modell in einem Produkt mit über 100 Millionen monatlich aktiven Nutzern oder einem monatlichen Umsatz von mehr als 20 Millionen US-Dollar einsetzt, muss den Namen "Kimi K2" sichtbar in der Benutzeroberfläche anzeigen. Diese Vorgabe dürfte für viele Unternehmen keine wesentliche Einschränkung darstellen.

Die enormen Modellgrößen und Speicheranforderungen von Kimi-K2 – insbesondere mit einer Billion Parametern und 32 Milliarden aktivierten Parametern pro Inferenz – bedeuten, dass für den produktiven Einsatz oder das lokale Hosting leistungsfähige Hardware benötigt wird. Für eine effiziente Ausführung des Modells empfiehlt sich wahrscheinlich der Einsatz von mehreren NVIDIA B200-GPUs oder ein Multinode-Setup auf Nvidias Hopper-Architektur. Eine quantisierte 4-Bit-Version läuft laut Entwicklerangaben auf zwei Apple M3 Ultra mit jeweils 512 GB RAM.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.