Tencents 3D-Generierungsmodell "Hunyuan World Model 1.0" ist jetzt als Lite-Variante verfügbar

Update –

- Lite-Version für Consumer-GPUs veröffentlicht

Update vom 15.08.2025:

Tencent hat eine abgespeckte Version seines "Hunyuan World Model 1.0" namens "1.0-Lite" veröffentlicht. Diese Lite-Variante soll vor allem auf Consumer-GPUs laufen und benötigt laut Angaben des Unternehmens rund 35 Prozent weniger VRAM als das Originalmodell. Dadurch funktioniert sie mit weniger als 17 Gigabyte Grafikspeicher. Außerdem läuft die Lite-Version schneller und verbraucht weniger Ressourcen.

Die Lite-Version ist wie das Originalmodell quelloffen verfügbar und kann über die interaktive Demo sceneTo3D, GitHub und Hugging Face. Den technischen Bericht gibt es auf arxiv.org.

Ursprünglicher Artikel vom 28. Juli 2025:

Hunyuan World Model 1.0: Tencent veröffentlicht offenes "Welt"modell für 3D-Generierung

Mit Hunyuan World Model 1.0 stellt Tencent ein Open-Source-Modell zur text- und bildbasierten Generierung immersiver 3D-Welten vor. Die Umsetzung hat jedoch noch Grenzen.

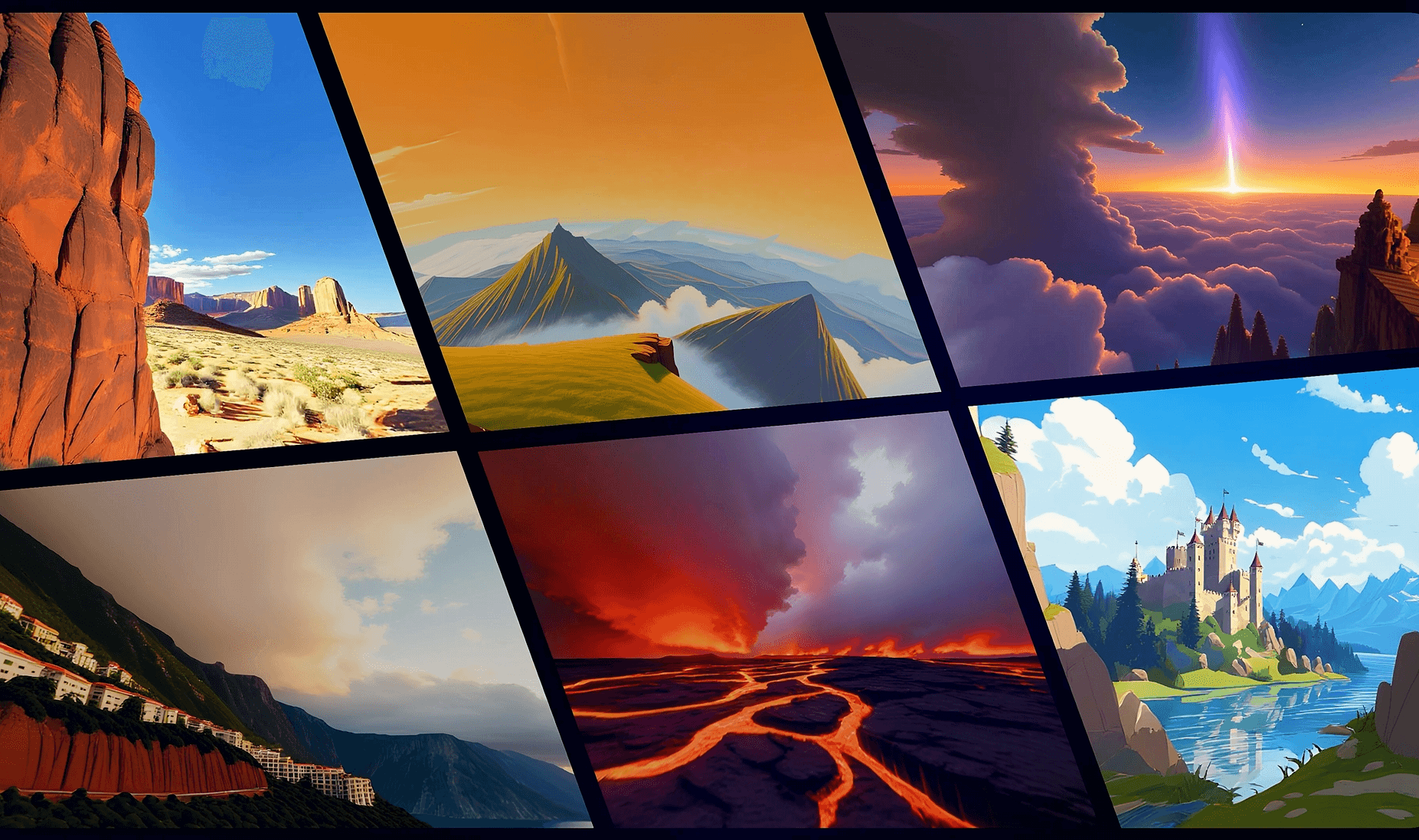

Tencent hat mit Hunyuan World Model 1.0 ein generatives KI-Modell veröffentlicht, das aus Text- oder Bildeingaben virtuelle 3D-Szenen erzeugt. Laut Tencent ist es das erste Open-Source-Modell dieser Art, das mit gängigen Grafikpipelines kompatibel ist und sich für Anwendungen in Game Engines, VR-Umgebungen und Simulationen eignet.

Ein zentrales Ziel sei es, den kreativen Übergang von Konzepten zu 3D-Inhalten zu beschleunigen – ohne proprietäre Hürden und mit maximaler Anschlussfähigkeit an bestehende Tools.

Eine Besonderheit des Modells ist, dass es erkennbare Objekte in einer Szene voneinander trennt. Diese lassen sich dann einzeln bewegen oder bearbeiten – etwa um sie in Simulationen zu verwenden oder für Interaktionen in Spielen. Dazu gehören etwa Autos, Bäume oder Möbelstücke. Auch der Himmel wird separat behandelt und kann realistisch als Umgebungslichtquelle genutzt werden.

Interaktive Panoramabilder mit Erweiterungspotenzial

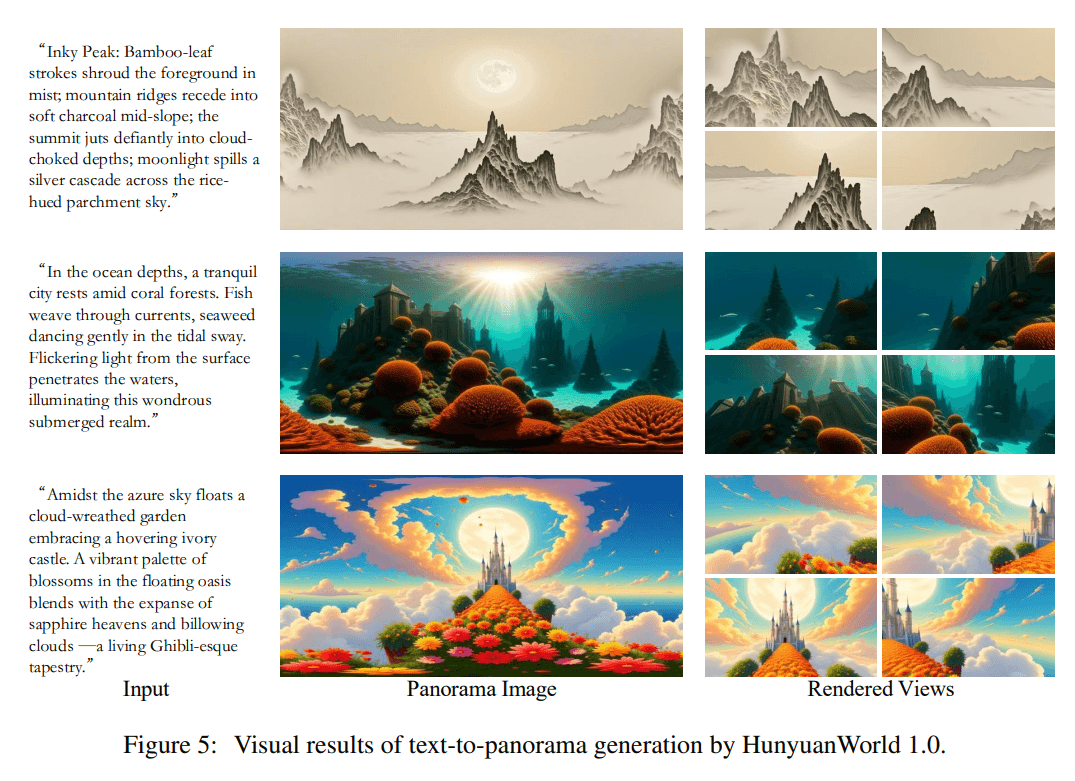

Das Modell kombiniert Panoramabild-Synthese mit hierarchischer 3D-Rekonstruktion. Es unterstützt zwei Eingabearten für die Szenengenerierung: textbasiert ("Text-to-World") und bildbasiert ("Image-to-World"). Die resultierenden Szenen können als Mesh-Dateien exportiert werden und sollen sich laut Tencent nahtlos in gängige 3D-Workflows integrieren lassen.

In den verfügbaren Demos erzeugt das Modell jedoch keine vollständig frei begehbaren 3D-Welten im Stil aktueller Videospiele. Die generierten Umgebungen ähneln eher interaktiven 360-Grad-Panoramen: Nutzer können sich im Bild umsehen und begrenzt navigieren, jedoch nicht uneingeschränkt durch eine 3D-Szene laufen. Für erweiterte Kamerafahrten und die Generierung von längeren, konsistenten 3D-Videosequenzen ist das Zusatzmodul Voyager erforderlich.

Video: Tencent

Dennoch sieht Tencent die erzeugten Visualisierungen als Ausgangspunkt für etwa VR-Anwendungen. Die semantische Interpretation von Texteingaben soll laut Unternehmen eine präzise Übertragung komplexer Szenenbeschreibungen in virtuelle Umgebungen ermöglichen. Für den Einsatz im Web oder in VR-Umgebungen unterstützt das Modell verschiedene Kompressions- und Beschleunigungstechniken.

Die Modellarchitektur basiert auf einem generativen Ansatz mit semantisch geschichteter Repräsentation. Die Ausgaben können in verschiedenen stilistischen Varianten erfolgen, was das Modell auch für kreative und gestalterische Anwendungsbereiche interessant machen soll.

Hunyuan World Model 1.0 ist auf GitHub unter einer Open-Source-Lizenz verfügbar und über Hugging Face abrufbar. Eine interaktive Demo steht unter sceneTo3D bereit, setzt aber einen China-kompatiblen Login voraus.

Die Veröffentlichung von Hunyuan World Model 1.0 reiht sich in Tencents breite Open-Source-Strategie im KI-Bereich ein. Neben dem 3D-Weltengenerator hat der chinesische Technologiekonzern bereits Hunyuan3D 2.0 für die Generierung texturierter 3D-Modelle aus Bildern, HunyuanVideo für KI-gestützte Videogenerierung und das Sprachmodell Hunyuan-A13B mit dynamischem Reasoning als offene Modelle veröffentlicht.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.