OpenAI will ChatGPT nicht zur Social-Media-Falle machen

OpenAI will ChatGPT so gestalten, dass es den Nutzer:innen bei der Lösung von Problemen hilft, anstatt sie möglichst lange im Gespräch zu halten.

Ziel sei es, den Chatbot nicht auf maximale Nutzungsdauer oder Klickzahlen zu optimieren, sondern auf tatsächliche Nützlichkeit, schreibt OpenAI in einem Blogbeitrag.

Entscheidend sei nicht, wie viel Zeit Menschen mit ChatGPT verbringen, sondern ob sie regelmäßig zurückkehren und das Gefühl haben, weitergekommen zu sein. Wenn das Modell hilfreich sei, würden Nutzer:innen von sich aus bereit sein, dafür zu zahlen.

Pausenfunktion und keine Entscheidungen bei Trennungsfragen

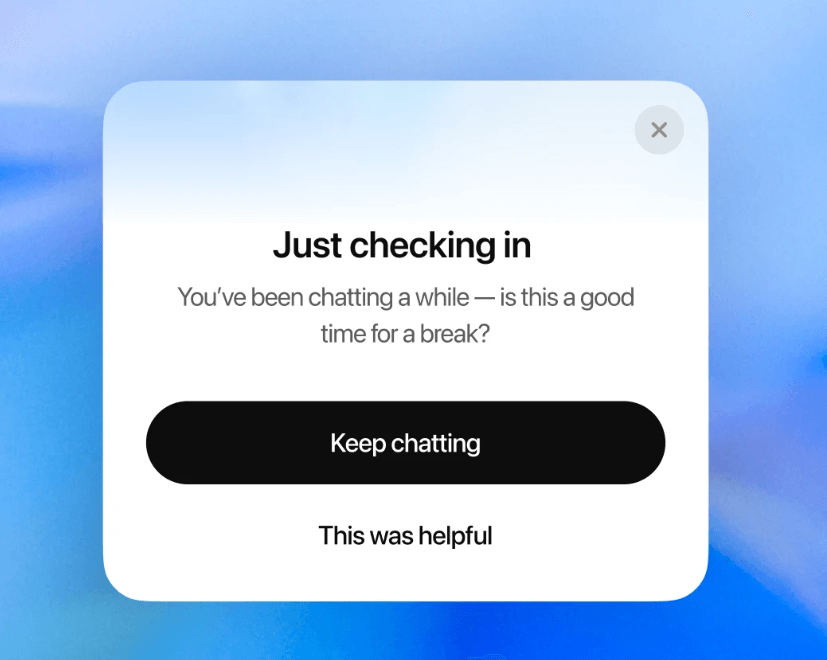

Bei der Gesprächsdauer will OpenAI daher gegensteuern: In langen Sitzungen erscheint künftig ein Hinweis, der zu einer Pause ermutigt. Diese Funktion soll dazu beitragen, dass Nutzer:innen die Kontrolle über ihre Zeit behalten.

Zudem will OpenAI den Umgang mit sensiblen persönlichen Fragen überarbeiten. Bei Fragen wie „Soll ich mich trennen?“ soll ChatGPT künftig keine direkte Antwort geben, sondern durch gezielte Rückfragen dabei helfen, Optionen abzuwägen. Das neue Verhalten soll laut OpenAI demnächst eingeführt werden.

Zwischen Hilfestellung und Risiko

Als Beispiele für sinnvolle Anwendungen nennt OpenAI unter anderem Unterstützung bei schwierigen Gesprächen im Beruf, die Erklärung medizinischer Laborwerte oder Hilfe bei der gedanklichen Orientierung in belastenden Situationen.

In solchen Fällen könne ChatGPT als neutraler Gesprächspartner agieren oder Informationen bereitstellen, die bei einer eigenständigen Entscheidungsfindung helfen.

Gerade in diesem Zusammenhang steht der Chatbot jedoch in der Kritik: ChatGPT neigt dazu, Aussagen der Nutzer:innen zu bestätigen, auch dann, wenn dies problematisch ist. Das kann zu schlechteren Entscheidungen führen oder bei psychisch belasteten Personen dazu beitragen, in gedanklichen Sackgassen zu verharren.

OpenAI räumt ein, dass GPT-4o in der Vergangenheit vereinzelt Wahnvorstellungen oder emotionale Abhängigkeit bestätigt habe. Um solchen Fällen besser zu begegnen, entwickelt das Unternehmen neue Mechanismen zur frühzeitigen Erkennung psychisch belastender Situationen, mit dem Ziel, Nutzer:innen gegebenenfalls auf geeignete Hilfsangebote zu verweisen. Dafür arbeite OpenAI mit mehr als 90 Ärzt:innen aus über 30 Ländern sowie mit Expert:innen aus Psychologie, Jugendentwicklung und Human-Computer-Interaktion zusammen.

OpenAI verweist zudem auf neue Agentenfunktionen, mit denen ChatGPT Aufgaben außerhalb der App übernehmen kann, etwa das Buchen von Arztterminen, das Zusammenfassen von E-Mails oder die Planung von Veranstaltungen. Diese Anwendungsbeispiele erfordern jedoch die Eingabe oder Übergabe sensibler persönlicher Daten. Angesichts anhaltender Sicherheitsbedenken erscheint das problematisch. Selbst OpenAI-CEO Sam Altman riet kürzlich davon ab, vertrauliche Informationen in ChatGPT einzugeben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.