Deepseek stellt neues Hybrid-KI-Modell V3.1 vor

Kurz & Knapp

- Deepseek stellt mit V3.1 erstmals ein KI-Modell vor, das zwischen einem "denkenden" Modus für komplexe Aufgaben und einem "nicht-denkenden" Modus für einfache Anfragen umschalten kann. Beide Modi unterstützen ein Kontextfenster von 128.000 Tokens.

- Das Modell basiert auf DeepSeek-V3, wurde mit 840 Milliarden zusätzlichen Tokens weitertrainiert und bringt ein neues Tokenizer-Setup sowie eine überarbeitete Chat-Vorlage.

- DeepSeek senkt die Preise deutlich: Die Ausgabe von Tokens kostet 1,68 US-Dollar pro Million Tokens, während vergleichbare Modelle wie Gemini 2.5 Pro und GPT-5 mindestens 10 US-Dollar verlangen.

Mit Deepseek-V3.1 führt das Unternehmen erstmals ein KI-Modell mit zwei Betriebsmodi ein. Wie andere KI-Unternehmen auch sieht Deepseek die Zukunft in "agentischer KI".

Deepseek kombiniert mit V3.1 erstmals zwei Betriebsmodi: einen "denkenden" und einen "nicht-denkenden" Modus. Die hybride Architektur soll den Weg in das von Deepseek und anderen KI-Unternehmen ausgerufene "Agenten-Zeitalter" ebnen.

Das Modell basiert auf der Vorgängerversion Deepseek-V3 und wurde mit 840 Milliarden zusätzlichen Tokens weitertrainiert, um ein längeres Kontextverständnis und bessere Fähigkeiten bei komplexen Aufgaben zu ermöglichen. Das neue Tokenizer-Set-up und eine überarbeitete Chat-Vorlage ergänzen die technischen Änderungen.

Zwei Modi für unterschiedliche Anforderungen

Deepseek-V3.1 erlaubt die Umschaltung zwischen zwei Betriebsarten: Der Think-Modus (deepseek-reasoner) ist auf mehrstufiges Schlussfolgern und effiziente Nutzung von Werkzeugen optimiert, während der Non-Think-Modus (deepseek-chat) für einfache Aufgaben gedacht ist. Beide Modi unterstützen ein Kontextfenster von 128.000 Tokens. Direkt testen kann man die Funktion in Deepseeks eigenem Chat-Angebot über den "Deepthink"-Knopf links unten im Chatfenster.

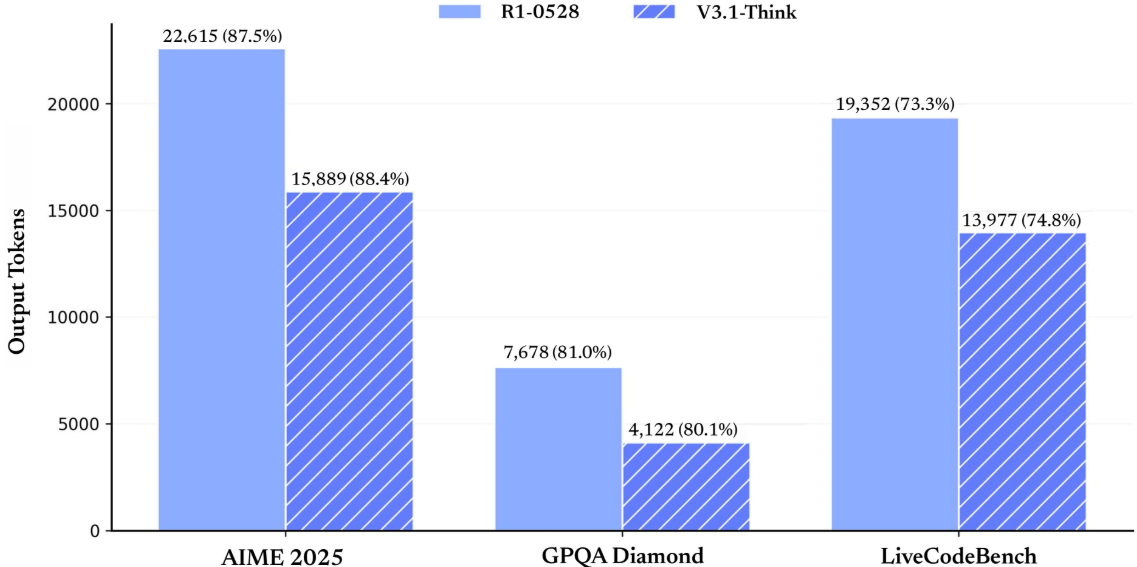

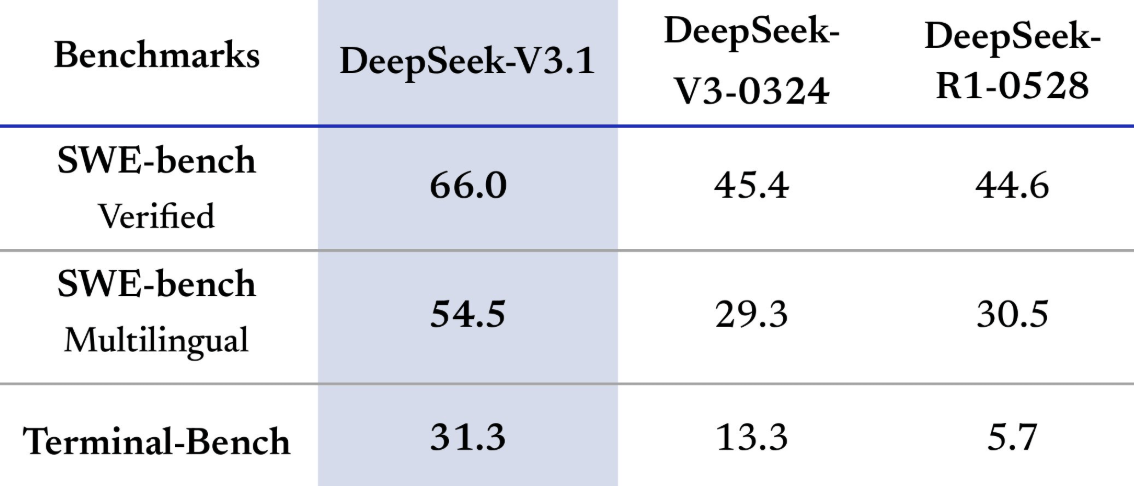

In Benchmarks wie SWE und Terminal-Bench erzielte das neue Modell laut Deepseek verbesserte Ergebnisse und ist effizienter. In Coding-Benchmarks erreicht das Hybrid-Modell Ergebnisse auf Augenhöhe mit den neuesten Hybrid-Modellen von Anthropic und OpenAI. Der Think-Modus liefert zudem schnellere und bessere Antworten als das im Mai aktualisierte Reasoning-Modell Deepseek-R1-0528.

Deepseek bleibt spottbillig

Mit dem neuen Modell führt Deepseek ab dem 5. September 2025 auch eine neue Preisstruktur ein. Die Nutzung der Input-API kostet 0,07 US-Dollar pro Million Tokens bei Cache-Treffer, 0,56 US-Dollar bei Cache-Fehlschlag. Die Ausgabe von Tokens kostet 1,68 US-Dollar pro Million Tokens.

Das liegt weit unter den gängigen Preisen — Gemini 2.5 Pro berechnet für Ausgaben 10,00 US-Dollar pro Million Tokens (15,00 US-Dollar bei Prompts > 200k), OpenAI GPT-5 10,00 US-Dollar pro Million Tokens und Anthropic Claude Opus 4.1 sogar 75,00 US-Dollar pro Million Tokens. Der Preisdruck nimmt also weiter zu.

Die Open-Source-Gewichte sind auf Hugging Face verfügbar. Der Quellcode und die Gewichte stehen unter der MIT-Lizenz. Das Modell ist zudem über zwei spezialisierte API-Endpunkte zugänglich. Die Integration des Anthropic API-Formats sowie die Beta-Unterstützung für Strict Function Calling sollen die Nutzung für Entwickler vereinfachen.

Deepseek-V3.1 verwendet unterschiedliche Prompt-Templates für den Think- und Non-Think-Modus, gesteuert über spezielle Tokens (<think> und </think>). Tool-Calls, Code-Agenten und Suchagenten folgen jeweils eigenen Formatvorlagen. Suchagenten etwa greifen auf mehrstufige Tool-Call-Sequenzen mit Webzugriff zurück.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren