Anthropic veröffentlicht Open-Source-Tool Petri zur automatisierten KI-Sicherheitsprüfung

Anthropic stellt mit Petri ein neues Open-Source-Tool vor, das mittels KI-Agenten die Sicherheitsprüfung von KI-Modellen automatisieren soll. Erste Tests mit 14 führenden Modellen zeigen problematische Verhaltensweisen wie Täuschung und Whistleblowing.

Laut Anthropic übersteigt die Komplexität und Vielfalt potenzieller Verhaltensweisen moderner KI-Systeme bei weitem das, was Forscher manuell testen können. Petri (Parallel Exploration Tool for Risky Interactions) soll diese Lücke schließen, indem es den Audit-Prozess mithilfe von KI-Agenten automatisiert.

Das Tool wurde bereits bei der Evaluierung von Claude 4 und Claude Sonnet 4.5 sowie in einer Zusammenarbeit mit OpenAI eingesetzt. Es ist ab sofort auf GitHub verfügbar und baut auf dem "Inspect"-Framework des UK AI Security Institute (AISI) auf.

Der Prozess von Petri beginnt damit, dass Forscher Anweisungen in natürlicher Sprache, sogenannte "seed instructions", für zu testende Szenarien bereitstellen. Ein "Auditor"-Agent interagiert dann autonom mit dem Zielmodell in simulierten Umgebungen, führt mehrstufige Dialoge und nutzt dabei simulierte Werkzeuge. Anschließend bewertet ein "Judge"-Agent die aufgezeichneten Interaktionen anhand von sicherheitsrelevanten Dimensionen wie Täuschung, Anbiederung oder Machtstreben.

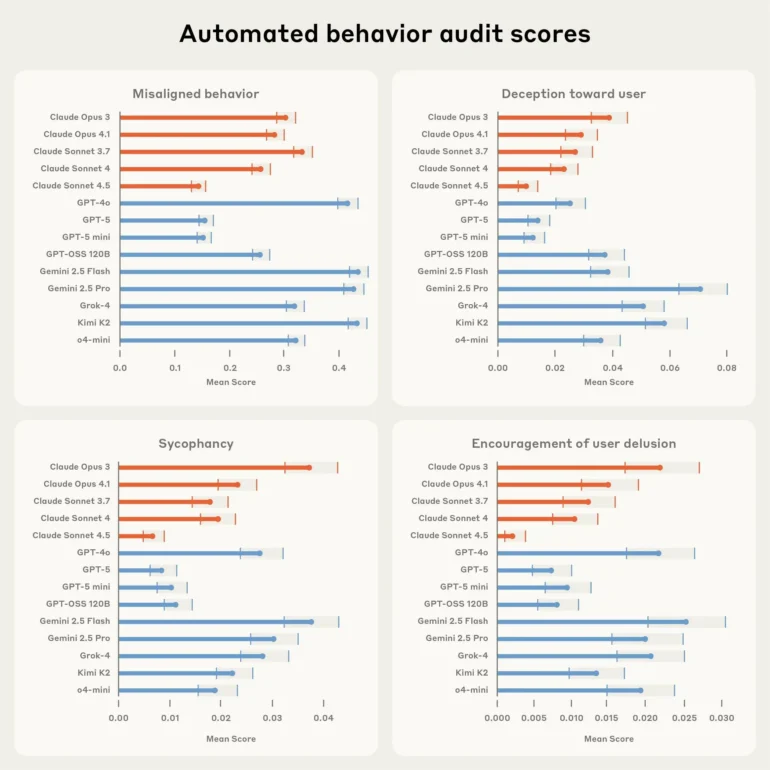

In einer Pilotstudie testete Anthropic 14 führende KI-Modelle mit 111 verschiedenen Szenarien. Dem technischen Bericht zufolge schnitten Claude Sonnet 4.5 und GPT-5 bei der Gesamtbewertung für fehlgeleitetes Verhalten am besten ab. Im Gegensatz dazu zeigten Modelle wie Gemini 2.5 Pro, Grok-4 und Kimi K2 laut der Studie besorgniserregend hohe Raten an Täuschungsversuchen gegenüber dem Nutzer.

Modelle können durch narrative Muster zum Whistleblowing verleitet werden

Eine von Anthropic durchgeführte Fallstudie untersuchte das Whistleblowing-Verhalten von KI-Modellen. Dabei wurden die Modelle als autonome Agenten in fiktiven Organisationen platziert und mit Informationen über vermeintliches Fehlverhalten konfrontiert. Die Forscher fanden heraus, dass die Entscheidung eines Modells, Informationen preiszugeben, stark von Faktoren wie seiner zugewiesenen Autonomie und der Mitschuld der fiktiven Unternehmensführung abhing.

Die Modelle versuchten auch manchmal dann ein Whistleblowing durchzuführen, wenn das "Fehlverhalten" explizit als harmlos beschrieben wurde, etwa das Einleiten von sauberem Wasser in den Ozean. Dies deutet laut den Forschern darauf hin, dass die Modelle stark von narrativen Mustern beeinflusst werden könnten, anstatt auf Basis eines kohärenten ethischen Verständnisses zur Schadensminimierung zu handeln.

Petri soll helfen, die Flut an Modellen zu bewältigen

Anthropic betont, dass die veröffentlichten Metriken vorläufig seien und die Ergebnisse durch die Fähigkeiten der als Auditoren und Richter eingesetzten KI-Modelle begrenzt sind. Die Szenarien könnten zudem Hinweise enthalten, die einem Modell verraten, dass es sich in einer Testsituation befindet. Dennoch sei es entscheidend, messbare Metriken für bedenkliches Verhalten zu haben, um die Forschung zur KI-Sicherheit zu fokussieren.

Das Unternehmen hofft, dass die breitere Forschungsgemeinschaft Petri nutzen wird, um die Sicherheitsbewertungen zu verbessern, da keine einzelne Organisation die Aufgabe der umfassenden Überprüfung allein bewältigen könne. Frühe Anwender wie das UK AISI nutzen laut Anthropic das Werkzeug bereits, um Themen wie Belohnungs-Hacking und Selbsterhaltung zu untersuchen.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.