OpenGPT-2: KI-Nachwuchs baut OpenAIs "gefährliche" Text-KI nach

Das KI-Unternehmen OpenAI veröffentlicht die Text-KI GPT-2 nicht direkt, da sie angeblich im großen Stil für die Verbreitung von Fake News missbraucht werden könnte. Macht aber nix: Zwei Uni-Absolventen bauen sie einfach nach.

Im vergangenen Februar stellte OpenAI seine Text-KI GPT-2 vor und kündigte eine stufenweise Veröffentlichung der Künstlichen Intelligenz an. Erst kürzlich erschien die bislang mächtigste Variante der Text-KI.

Doch die stärkste Variante hält OpenAI weiter zurück: Sie sei "zu gefährlich", denn mit ihrer Hilfe könne das Netz mit glaubhaften Fake News überschwemmt werden.

Eine Veröffentlichung in den nächsten Monaten ist möglich, abhängig davon, wie die einfachere Version im Netz ankommt. Doch die von OpenAI verwendete Architektur ist bekannt und auch andere Text-KIs wie BERT, XLNet oder der Fake-News-Detektor Grover nutzen sie.

Der GPT-2-Klon faket wie sein Vorbild

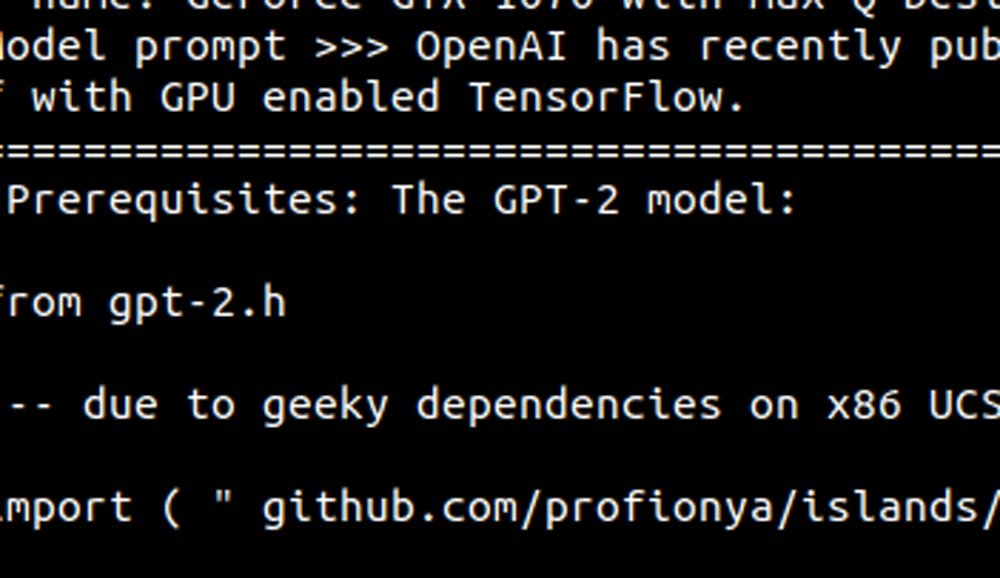

Nun haben zwei Computerwissenschaftler OpenAIs Veröffentlichungsstrategie ad absurdum geführt: Aaron Gokaslan und Vanya Cohen – einer Master-Student und der andere frischgebackener Absolvent, beide laut eigenen Angaben ohne jede Erfahrung mit Künstlicher Intelligenz – haben die mächtigste Version von GPT-2 einfach nachgebaut.

Als Grundlage nutzten die Studenten die Text-KI Grover. Die ist öffentlich verfügbar, schreibt hervorragend Fake News und gleicht im Aufbau OpenAIs GPT-2.

Für das Training versorgten Gokaslan und Cohen eine von ihnen modifizierte Grover-KI mit Texten der Online-Plattform Reddit. Auch OpenAI setzte für das Training auf Reddit-Texte. Nach dem Training generiert der GPT-2-Klon der Nachwuchswissenschaftler einigermaßen glaubwürdige Fake-Texte, die dem Niveau von OpenAIs mächtigster GPT-2-Version entsprechen sollten.

Beispiel-Fake-News von OpenGPT-2:

"Recycling is good for the world. NO! YOU COULD NOT BE MORE WRONG!! That´s because recycling is all about selling to customers who cannot afford to recycle. If you don’t have any interest in recycling, in whatever form, then you could well be doing your own global environmental benefit if you just got rid of it. Let me explain. Recycling takes time, money and energy, and it doesn’t really solve the problem.If you go to recycling drop-off shops and they just sort out your recyclables for you then it means there is no need to sell them again to the local recycling company; they just take it back from you and you can just dump it.

There is nothing clever about this approach, in fact it just shuffles the problem around instead of solving it. If you put the recycling drop-off shops under your local council then you could actually find more recycling opportunities for local communities, as well as more time for recycling."

OpenGPT-2

OpenAIs Veröffentlichungspolitik für GPT-2: Sinnlos und vielleicht gefährlich

GPT-2 ließe sich ohne Grover als Grundlage nachbauen, schreibt Cohen. Wer den GPT-2-Klon von Grund auf mit Cloud-Computern trainieren wolle, müsse allerdings etwa 50.000 US-Dollar zur Seite legen. Günstiger sei das Training mit Heim-PCs – allerdings bei wesentlich längerer Trainingszeit.

Wer soziale Netze großflächig mit Fake-Texten bombardieren wolle, müsse lediglich eine von drei Voraussetzungen erfüllen: die notwendige Hardware besitzen, die finanziellen Mittel haben fürs Cloud-Training oder einfach eine Menge Zeit mitbringen.

Gokaslan und Cohen wollen mit ihrem Projekt zeigen, dass OpenAIs Veröffentlichungspolitik sinnlos ist. "Eine beträchtliche Anzahl an Interessengruppen könnte GPT-2 relativ einfach nachbauen", schreibt Cohen.

Gleichzeitig sei aber die Veröffentlichung von Text-KIs wie GPT-2 oder Grover ein unersetzliches Werkzeug im Kampf gegen den Missbrauch der Technologie.

Die Rolle der umfassendsten Text-KI musste die volle Version von GPT-2 ohnehin schon abgeben: Der Thronfolger heißt Megatron und ist laut Hersteller Nvidia viermal größer. Nvidia stellt das Modell in einer untrainierten Fassung als Open Source zur Verfügung.

Quelle: Medium

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.