Moonshot AI stellt Kimi K2 Thinking als "bestes Open-Source-Thinking-Modell" vor

Update –

- Laut CNBC soll das Training des Modells Kimi K2 rund 4,6 Millionen US-Dollar gekostet haben, wie eine mit der Angelegenheit vertraute Quelle berichtet.

- Simon Willison wies darauf hin, dass die MIT-Lizenz des Modells eine kleine Änderung enthält: Unternehmen, die das Modell kommerziell nutzen, müssen den Namen Kimi K2 deutlich sichtbar anzeigen, wenn sie monatlich mehr als 20 Millionen US-Dollar Umsatz erzielen oder über 100 Millionen aktive Nutzer im Monat verfügen.

Diese Klausel könnte eine Reaktion darauf sein, dass US-Unternehmen zunehmend chinesische Open-Source-Modelle verwenden – die oft deutlich günstiger sind –, ohne dies in ihren kommerziellen Produkten offenzulegen.

Das chinesische KI-Unternehmen Moonshot AI hat mit Kimi K2 Thinking ein neues Open-Source-Sprachmodell vorgestellt, das nach eigenen Angaben das „beste Open-Source-Thinking-Modell“ sein soll. Das System arbeitet als sogenannter „Thinking Agent“, der schrittweise Schlussfolgerungen zieht und dabei verschiedene Tools einsetzt.

Das Modell repräsentiert die neuesten Entwicklungen im Bereich des sogenannten „Test-Time Scalings“. Dabei werden sowohl Thinking-Tokens als auch Tool-Calling-Schritte skaliert, um die Leistungsfähigkeit von Sprachmodellen während der Laufzeit zu erhöhen. Laut Moonshot AI kann K2 Thinking 200 bis 300 sequenzielle Tool-Aufrufe ohne menschliche Eingriffe ausführen und dabei über Hunderte von Schritten hinweg kohärent argumentieren, um komplexe Probleme zu lösen.

Das Modell verfügt über insgesamt eine Billion Parameter und nutzt eine Mixture-of-Experts-Architektur, bei der während der Inferenz lediglich 32 Milliarden Parameter aktiv sind. Das Kontextfenster umfasst 256.000 Tokens.

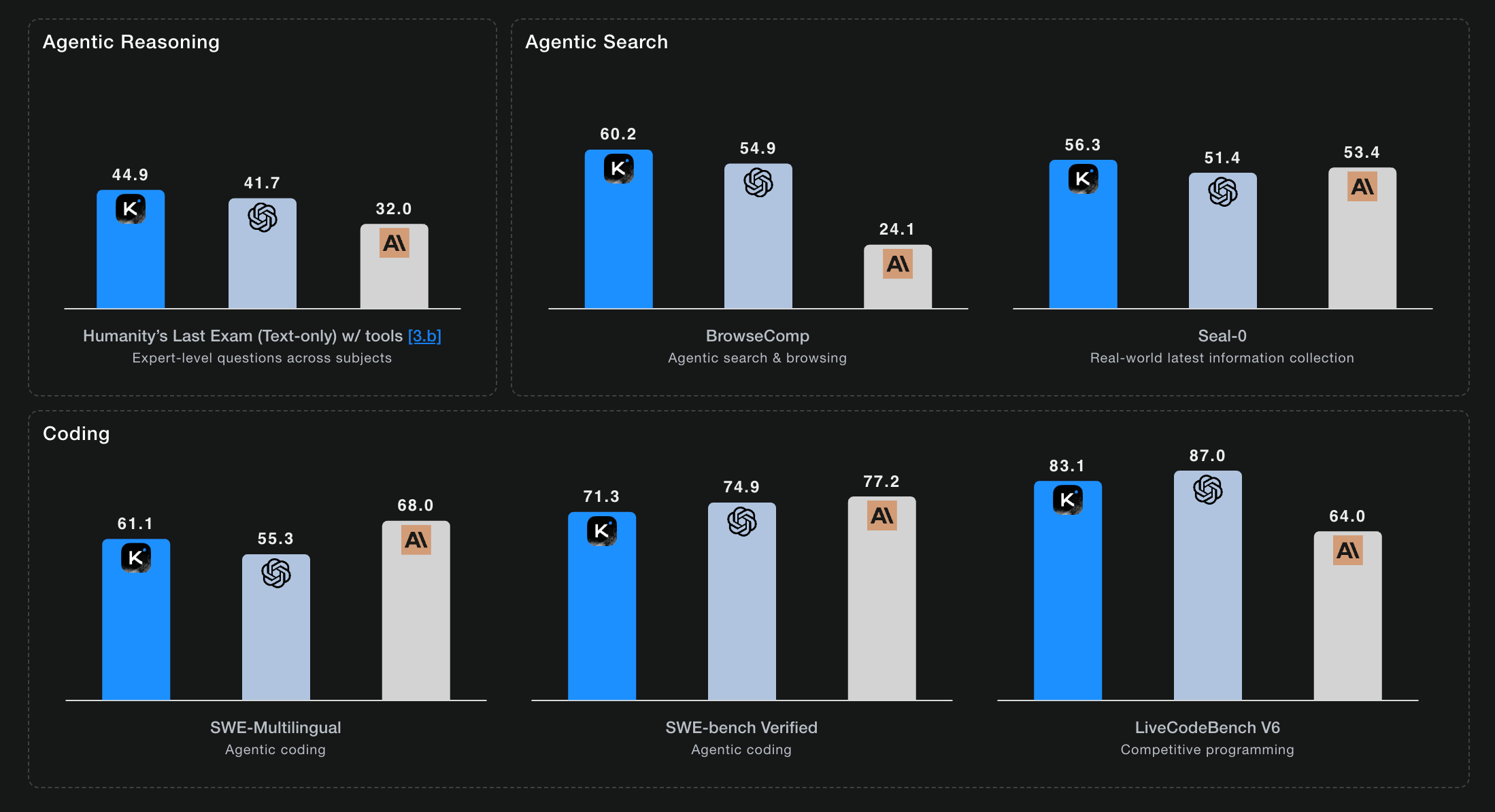

Überdurchschnittliche Benchmark-Ergebnisse

K2 Thinking soll neue Rekorde in verschiedenen Benchmarks aufgestellt haben, die Reasoning-, Coding- und Agenten-Fähigkeiten bewerten. Auf Humanity’s Last Exam (HLE) mit Tools erreichte das Modell 44,9 Prozent. Dies stellt laut Moonshot AI einen neuen Bestwert für diese Kategorie dar. Auf BrowseComp, einem Benchmark für agentenbasierte Suche und Browsing, erzielte es 60,2 Prozent und übertraf damit die menschliche Baseline von 29,2 Prozent deutlich.

Im Bereich Coding erreichte das Modell 71,3 Prozent auf SWE-Bench Verified und 61,1 Prozent auf SWE-Multilingual. Diese Ergebnisse positionieren K2 Thinking laut der Vergleichstabelle des Unternehmens teilweise über etablierten, kommerziellen US-Modellen wie GPT-5, Claude Sonnet 4.5, aber auch chinesischen Konkurrenten wie Deepseek-V3.2.

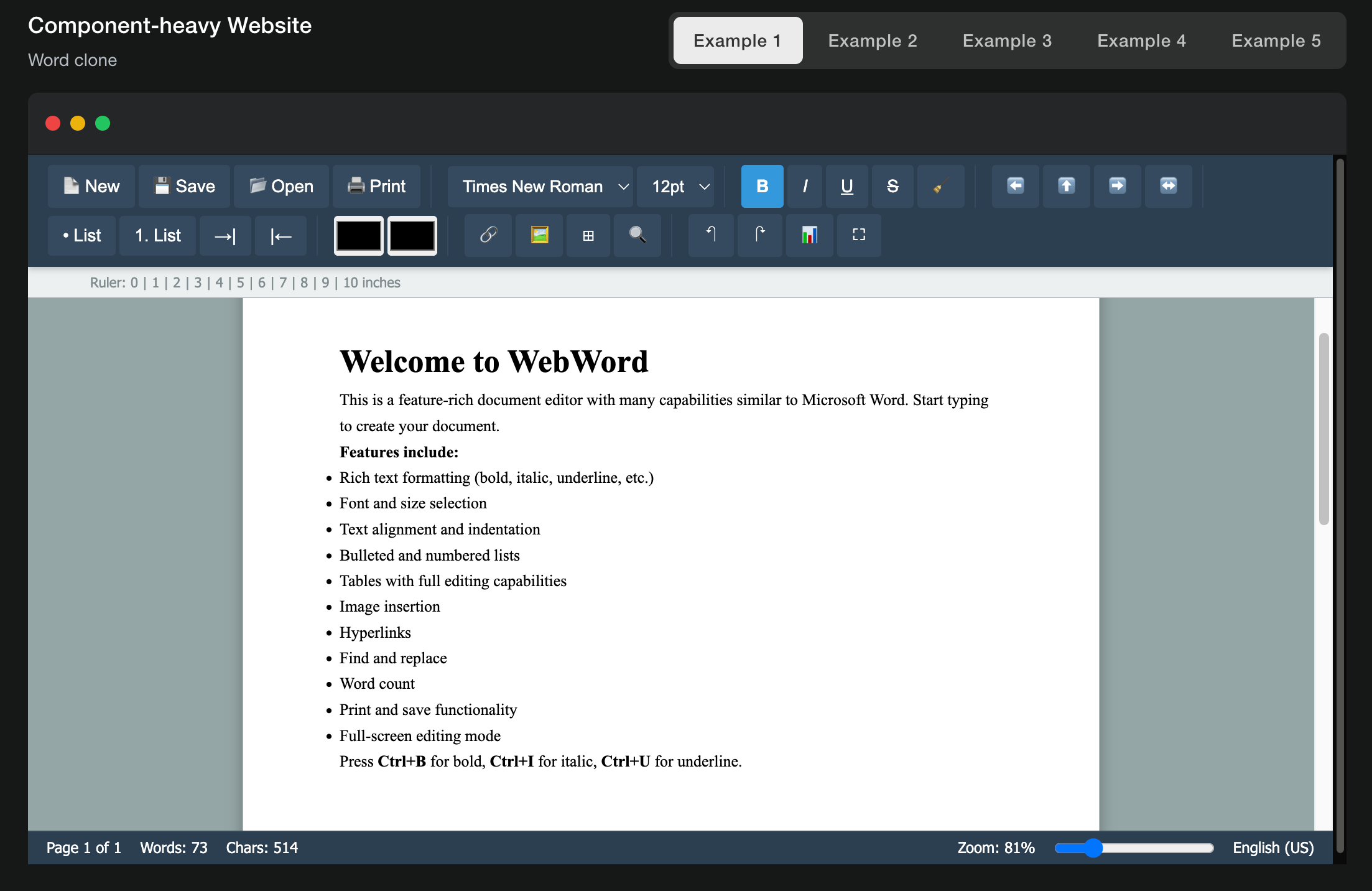

Die Coding-Fähigkeiten unterstreicht Moonshot unter anderem mit dieser Demo eines voll funktionsfähigen Word-Klons, der aus nur einem einzigen Prompt entstanden sein soll. Laut Moonshot biete Kimi-K2 Thinking merkliche Verbesserungen bei HTML-, React- und komponentenintensiven Frontend-Aufgaben und setze Ideen in voll funktionsfähige, responsive Produkte um.

Als Beispiel für die Reasoning-Fähigkeiten führt Moonshot AI die Lösung eines PhD-Level-Mathematikproblems an, bei dem das Modell 23 verschachtelte Reasoning- und Tool-Aufrufe durchführte. Das Modell soll dabei eigenständig relevante Literatur recherchiert, mathematische Berechnungen durchgeführt und schrittweise zur korrekten Lösung gefunden haben. Laut Moonshot AI demonstriere dies die Fähigkeit zu strukturiertem Reasoning und langfristiger Problemlösung.

Agentenbasierte Suche mit hunderten Tool-Aufrufen

Bei agentenbasierten Such- und Browsing-Aufgaben führt K2 Thinking laut den Entwicklern dynamische Zyklen aus. Das Modell folgt dabei einem wiederkehrenden Schema: denken, suchen, Browser verwenden, erneut denken und programmieren. Das System soll kontinuierlich Hypothesen generieren und verfeinern, Beweise verifizieren und kohärente Antworten konstruieren.

Als Beispiel zeigt Moonshot AI eine komplexe Recherche-Aufgabe, bei der das Modell eine Person anhand mehrerer verschachtelter Kriterien identifizieren sollte. Die Aufgabe umfasste Universitätsabschluss, NFL-Karriere sowie spezifische Film- und TV-Rollen. Das System durchsuchte systematisch verschiedene Quellen und identifizierte schließlich den ehemaligen NFL-Spieler Jimmy Gary Jr. als gesuchte Person.

Optimierungen für schnellere Verarbeitung

Moonshot AI hat K2 Thinking technisch weiterentwickelt, um das Modell praxistauglicher zu machen. Zum Einsatz kommt dabei eine spezielle Trainingsmethode namens Quantization-Aware Training, bei der Teile des Modells in komprimierter Form gespeichert werden. Diese Komprimierung senkt den Speicherbedarf und beschleunigt die Textgenerierung laut dem Unternehmen etwa um den Faktor zwei im Vergleich zur unkomprimierten Version.

Trotz dieser Optimierung soll die Leistungsfähigkeit unverändert bleiben: Nach Angaben von Moonshot AI wurden alle veröffentlichten Benchmarks bereits mit der optimierten Variante des Modells durchgeführt.

K2 Thinking ist bereits auf kimi.com verfügbar und per API zugänglich. Der vollständige "Agentic Mode" soll bald verfügbar sein, während der aktuelle Chat-Modus eine reduzierte Tool-Auswahl für schnellere Antworten verwendet. Die Gewichte finden sich auf Hugging Face.

Bereits im Juli hatte Moonshot AI mit der Standardversion von Kimi K2 für Aufmerksamkeit gesorgt. In Benchmarks konnte das Modell mit führenden Systemen wie Claude Sonnet 4 und GPT-4.1 konkurrieren; bemerkenswert, da Kimi K2 kein spezielles Reasoning-Training erhalten hatte. Stattdessen wurde es gezielt für agentische Anwendungen und den Einsatz von Tools optimiert. Das Mixture-of-Experts-Modell mit einer Billion Parametern zeigte schon damals starke Leistungen in Mathematik, Naturwissenschaften und bei multilingualen Aufgaben.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.