Anthropic bringt Chatbot Claude mehr konservative Sichtweisen bei

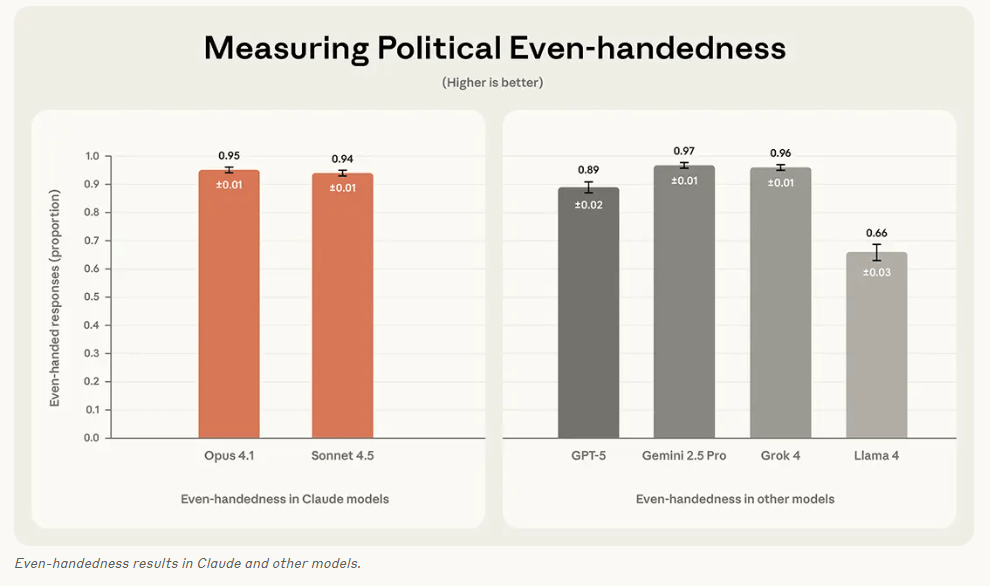

Anthropic hat ein Werkzeug veröffentlicht, um politische Ausgewogenheit im KI-Chatbot Claude zu messen. Claude soll keine unbegründeten politischen Meinungen äußern und so gestaltet sein, dass Nutzer ihn weder als liberal noch als konservativ einordnen können. Gesteuert werden die Antworten über System-Prompts und Verstärkungslernen, das vermeintlich neutrale Reaktionen belohnt. Teil dieser Reaktionen ist etwa, traditionelle Werte und Institutionen zu respektieren. Bias wird hier also nicht aufgelöst, nur verschoben, passend zum aktuellen US-Zeitgeist.

Anthropic erwähnt das zwar nicht explizit im eigenen Blog, aber die Messung dürfte eine Reaktion auf eine Anordnung der Trump-Regierung sein, dass Chatbots nicht mehr "woke" sein dürfen. Auch OpenAI steuert GPT-5 in diese Richtung, und entspricht damit Vorgaben der US-Regierung. Anthropics Bewertungsmethode ist Open Source.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.