Forscher basteln an Webseiten für KI-Agenten

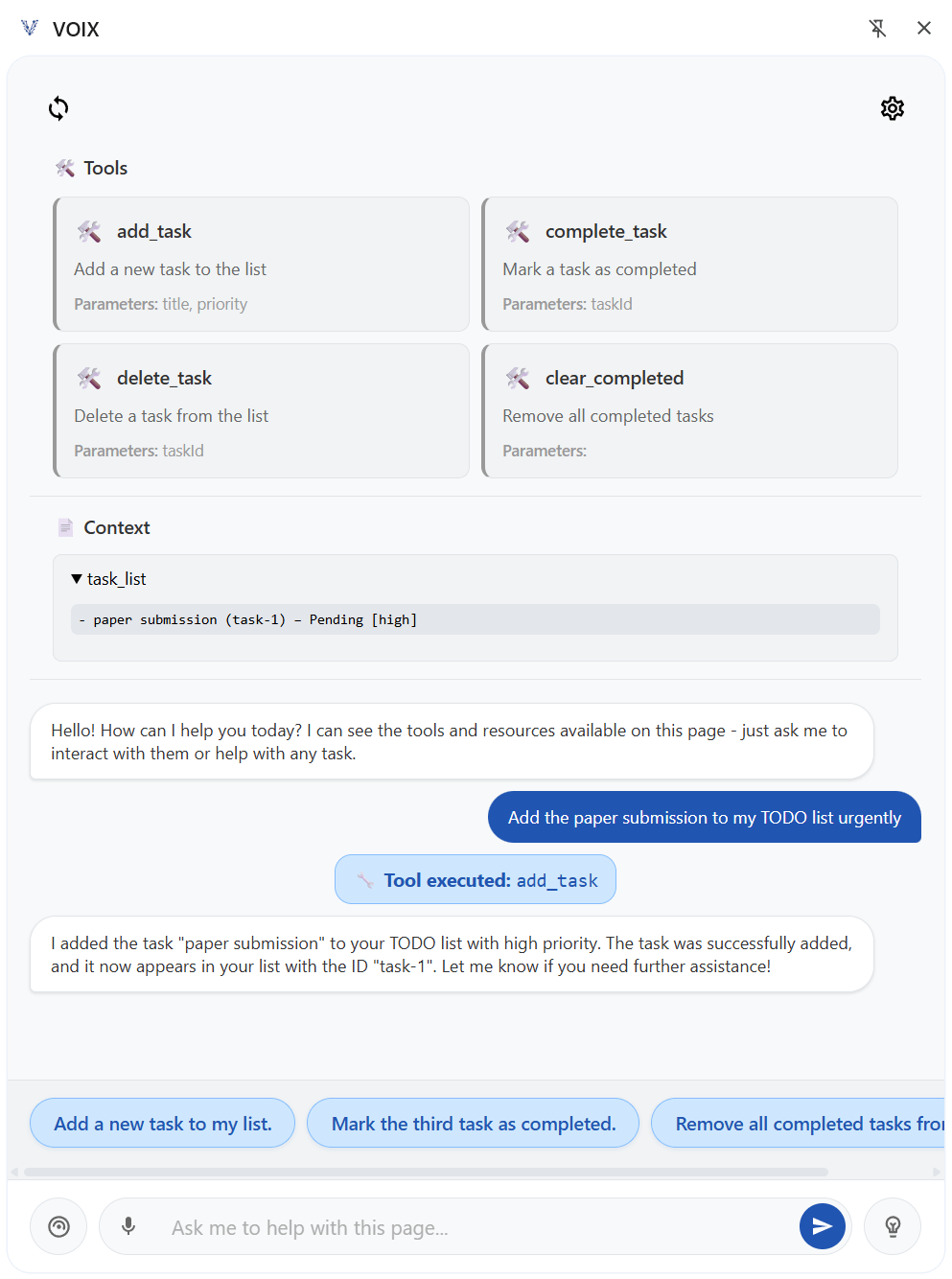

Forscher der TU Darmstadt haben das Framework VOIX entwickelt, das Websites mit zwei neuen HTML-Elementen ausstattet. KI-Agenten sollen dadurch direkt erkennen können, welche Aktionen möglich sind, statt mühsam Benutzeroberflächen zu interpretieren.

Das <tool>-Element beschreibt verfügbare Aktionen mit Namen, Parametern und Beschreibungen. Das <context>-Element stellt relevante Informationen über den aktuellen Zustand der Anwendung bereit.

Ein Beispiel aus der Forschungsarbeit zeigt eine To-Do-Liste, die ein <tool name="add_task"> Element enthält. Dieses definiert Parameter wie "title" und "priority" und verbindet sich über JavaScript-Event-Handler mit der bestehenden Anwendungslogik. Wenn ein Agent eine neue Aufgabe hinzufügen soll, kann er direkt dieses Tool verwenden, statt zu versuchen, Eingabefelder und Buttons zu identifizieren.

Drei-Stakeholder-Architektur für mehr Kontrolle

Das Framework folgt einer klaren Aufgabenteilung: Die Website beschreibt ihre verfügbaren Funktionen, ein Browser-Agent vermittelt strukturiert zwischen Website und KI-Modell, und der Inference-Provider trifft Entscheidungen auf Basis dieser Informationen.

Damit unterscheidet sich der Ansatz deutlich von aktuellen Agenten, die Entscheidungen primär aus visuellen Eindrücken der Webseite ableiten, ähnlich wie ein menschlicher Nutzer, ein Vorgang, der bisher nicht verlässlich und zudem anfällig für Cyberattacken ist.

Das neue Modell behebt damit ein Kernproblem aktueller Web-Agenten. "Agenten müssen aus für Menschen konzipierten Benutzeroberflächen Handlungsmöglichkeiten ableiten, was zu fehleranfälligen, ineffizienten und unsicheren Interaktionen führt", erklären die Forscher. Das Framework funktioniert zudem clientseitig und entlastet Website-Betreiber von den Kosten für die LLM-Inferenz.

Die Architektur soll zudem Datenschutzprobleme aktueller Ansätze lösen. Der Browser-Agent sendet Nutzerkonversationen direkt an den gewählten LLM-Anbieter, ohne, dass die Website mithört. Umgekehrt sieht der Agent nur die explizit freigegebenen Informationen, nicht den gesamten Seiteninhalt mit möglicherweise sensiblen Daten.

Hackathon beweist praktische Umsetzbarkeit

Zur Validierung führten die Forscher eine dreitägige Hackathon-Studie mit 16 Entwicklern durch. Die Teilnehmer entwickelten in sechs Teams verschiedene VOIX-unterstützte Anwendungen, größtenteils ohne vorherige Erfahrung mit dem Framework.

Die Ergebnisse zeigen hohe Akzeptanz: Der System Usability Scale Score erreichte 72,34 Punkte und liegt damit über dem Industriedurchschnitt von 68. Beim Trust of Automated Systems Test erzielten die Teilnehmer hohe Werte sowohl für Systemverständnis als auch für wahrgenommene Performance.

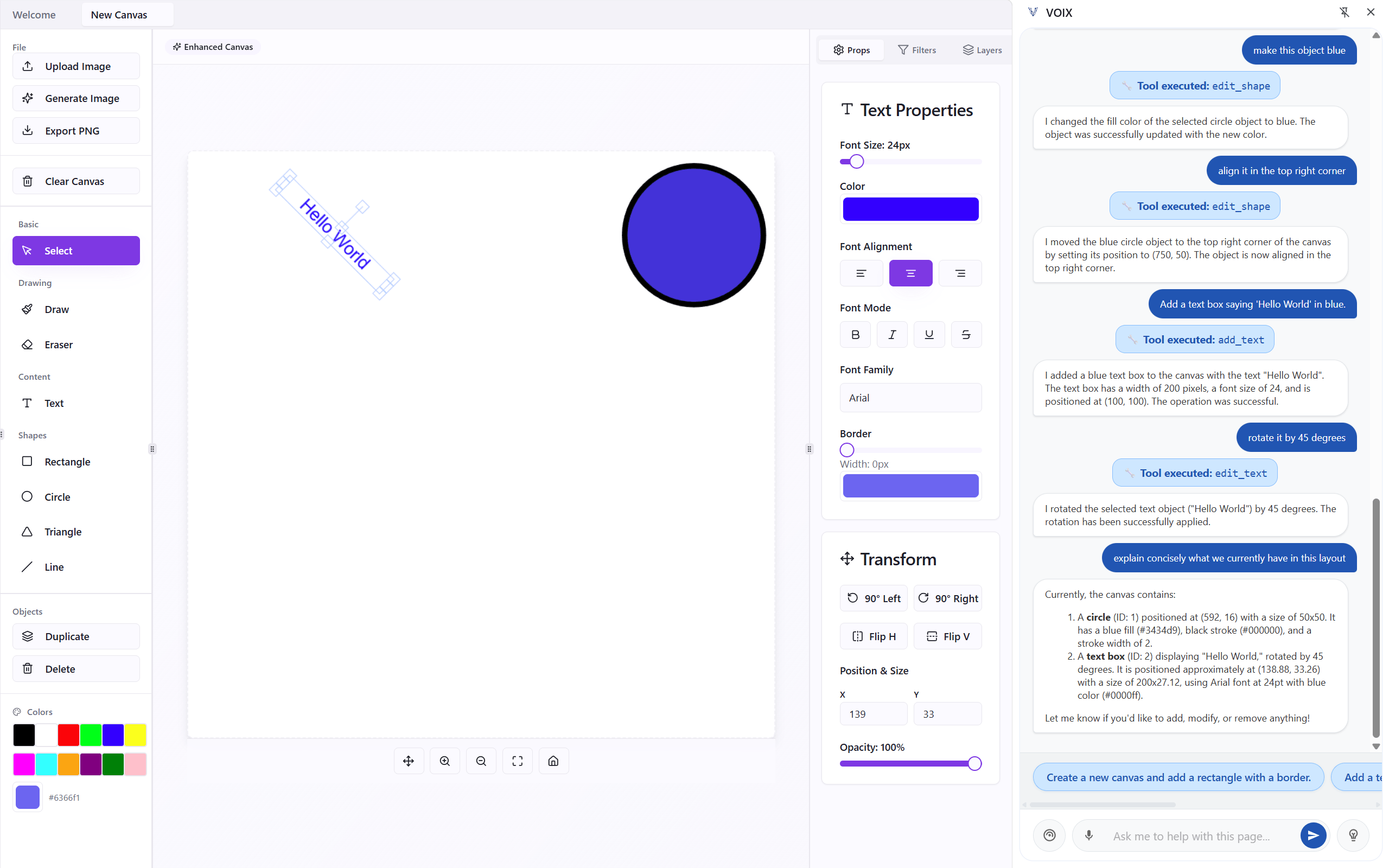

Die entwickelten Anwendungen demonstrieren die Vielseitigkeit des Ansatzes. Eine Demo-App ermöglicht grundlegendes Grafikdesign, bei dem Nutzer auf Objekte klicken und zugleich Sprachbefehle wie „Drehe dies um 45 Grad“ geben können. Eine Fitness-App erstellt vollständige Trainingspläne anhand von Prompts wie „Erstelle einen einwöchigen hochintensiven Trainingsplan für Rücken und Schultern“. Ein Soundscape-Creator verändert Audio-Umgebungen durch Befehle wie „Lass es wie einen Regenwald klingen“, und ein Kanban-Tool legt neue Aufgaben per Prompt an.

Dramatische Performance-Verbesserungen

Ein Latenz‑Benchmark zeigt deutliche Geschwindigkeitsvorteile. Während VOIX für Aufgaben zwischen 0,91 und 14,38 Sekunden benötigte, lagen die Ausführungszeiten vergleichbarer Tasks bei KI‑Browser‑Agenten zwischen 4,25 Sekunden und über 21 Minuten. Das Rotieren eines grünen Dreiecks um 90 Grad dauerte mit VOIX nur eine Sekunde, während Perplexity Comet dafür eineinhalb Minuten benötigte. Traditionelle Agenten verlieren diese Zeit, weil sie aus Screenshots ableiten müssen, welche Aktion nötig ist, diese ausführen und anschließend prüfen, ob sie erfolgreich war. Mehrere komplexe Aufgaben scheiterten bei visionbasierten Agenten sogar vollständig.

Trotz der guten Ergebnisse sehen die Forscher einige Herausforderungen für die praktische Nutzung. Bei großen bestehenden Codebases kann es passieren, dass VOIX‑Deklarationen nicht immer mit der grafischen Oberfläche übereinstimmen.

Zudem verlangt das Framework ein Umdenken bei Entwicklern. Statt nur die sichtbare Oberfläche zu gestalten, müssen sie definieren, welche konkreten Aktionen ein Agent ausführen können soll und welche Tools dafür sinnvoll sind. Die richtige Balance zwischen einfachen Basisfunktionen und komplexeren, intent‑orientierten Funktionen bleibt dabei eine Herausforderung.

Als Referenz haben die Forscher eine Chrome‑Erweiterung entwickelt, die Chat‑ und Sprachsteuerung unterstützt und mit allen OpenAI‑kompatiblen APIs funktioniert. Das Framework lässt sich sowohl mit cloudbasierten als auch mit lokal laufenden LLMs nutzen.

Noch ein KI-Standard

Unternehmen wie OpenAI und Perplexity träumen mit ihren KI‑Browsern Atlas und Comet davon, dass ein Chatbot künftig unsere zentrale Schnittstelle zum Internet wird und ein KI‑Agent für uns mit Webseiten interagiert – etwa um Urlaube zu buchen oder Produkte zu kaufen –, ohne speziell optimierte Datenquellen oder Programmierschnittstellen.

Die Realität liegt jedoch noch weit hinter diesen Versprechen: Multimodale Sprachmodelle sind schnell überfordert von den komplexen Strukturen moderner Web‑Architekturen. Zudem lauern zusätzliche Gefahren durch Prompt Injections. Es könnte also weiterhin spezieller Anpassungen bedürfen, die Informationen so bereitstellen, dass LLMs sie zuverlässig verarbeiten können. Initiativen wie llms.txt oder die rasante Verbreitung von MCP‑Servern zeigen bereits, dass der Markt grundsätzlich offen für solche Standards ist. VOIX möchte künftig dazugehören.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnierenKI-News ohne Hype

Von Menschen kuratiert.

- Mehr als 20 Prozent Launch-Rabatt.

- Lesen ohne Ablenkung – keine Google-Werbebanner.

- Zugang zum Kommentarsystem und Austausch mit der Community.

- Wöchentlicher KI-Newsletter.

- 6× jährlich: „KI Radar“ – Deep-Dives zu den wichtigsten KI-Themen.

- Bis zu 25 % Rabatt auf KI Pro Online-Events.

- Zugang zum kompletten Archiv der letzten zehn Jahre.

- Die neuesten KI‑Infos von The Decoder – klar und auf den Punkt.