KI-Modelle knacken Smart Contracts und erzielen simulierte Millionen-Gewinne

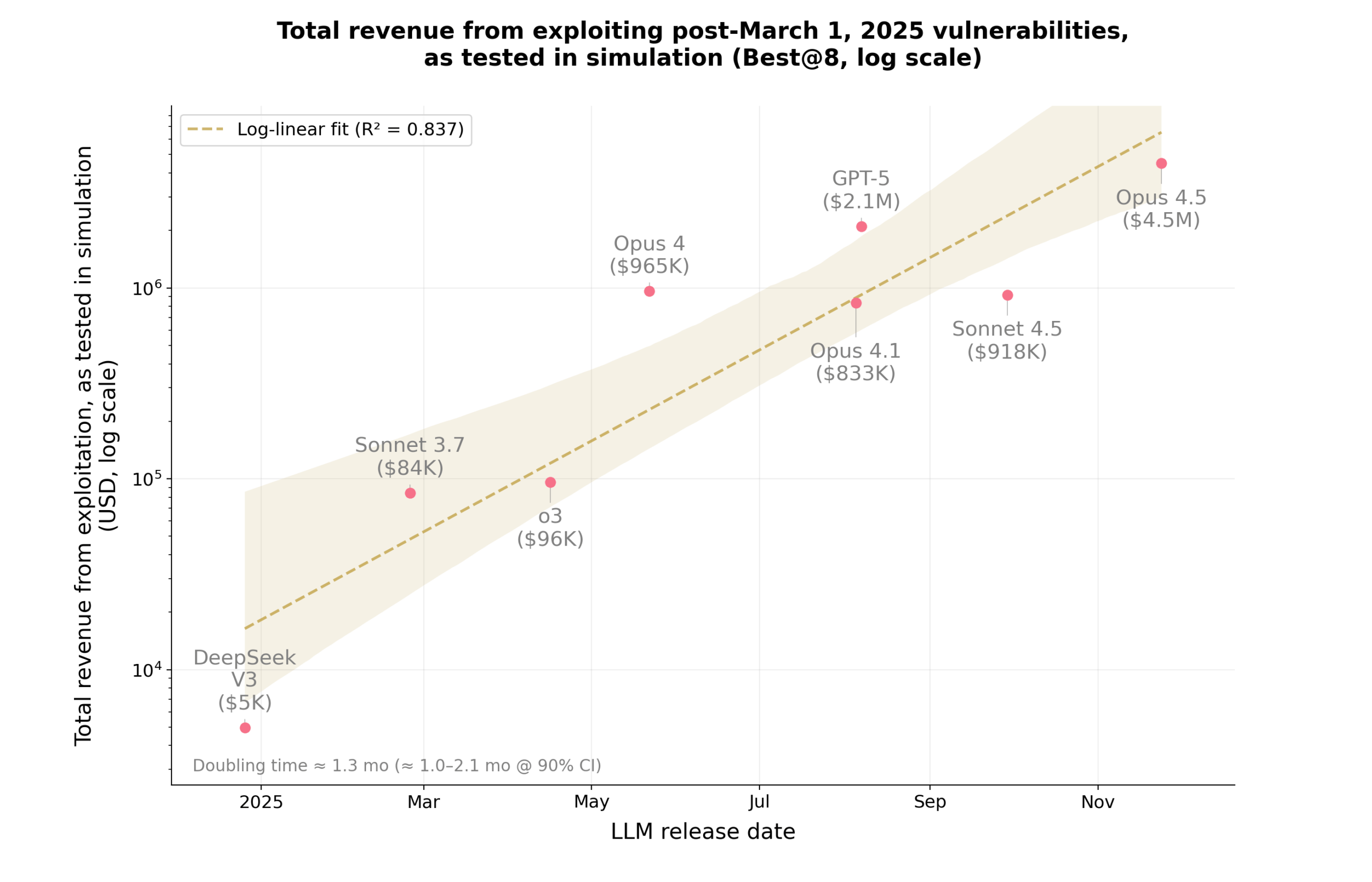

Eine neue Untersuchung von MATS und Anthropic zeigt, dass KI-Modelle wie Claude Opus 4.5, Sonnet 4.5 und GPT-5 in simulierten Tests Smart-Contract-Schwachstellen erkennen und ausnutzen können. Auf dem Benchmark SCONE-bench wurden 405 reale Angriffe zwischen 2020 und 2025 analysiert. Dabei entwickelten die Modelle Exploits mit einem simulierten Schaden von bis zu 4,6 Millionen US-Dollar.

In einem weiteren Versuch analysierten die KI-Agenten 2849 neue Verträge und entdeckten zwei bislang unbekannte Schwachstellen. GPT‑5 erzielte bei rund 3.476 Dollar API‑Kosten simulierte Einnahmen (‘exploits worth’) von 3.694 Dollar. Der durchschnittliche Nettogewinn lag bei 109 Dollar pro Exploit. Alle Tests fanden in isolierten Umgebungen statt.

Die Forscher sehen in den Ergebnissen einen Hinweis auf reale Risiken, aber auch Potenzial für Verteidigungstools. Anthropic hatte vor Kurzem eine Studie veröffentlicht, die zeigte, dass KI-Modelle die Cybersecurity stärken können.

KI-News ohne Hype – von Menschen kuratiert

Mit dem THE‑DECODER‑Abo liest du werbefrei und wirst Teil unserer Community: Diskutiere im Kommentarsystem, erhalte unseren wöchentlichen KI‑Newsletter, 6× im Jahr den „KI Radar"‑Frontier‑Newsletter mit den neuesten Entwicklungen aus der Spitze der KI‑Forschung, bis zu 25 % Rabatt auf KI Pro‑Events und Zugriff auf das komplette Archiv der letzten zehn Jahre.

Jetzt abonnieren